1.flink介绍、反压原理、内存管理、对比spark、flink的生态和应用场景以及未来

1.为什么要学习Flink

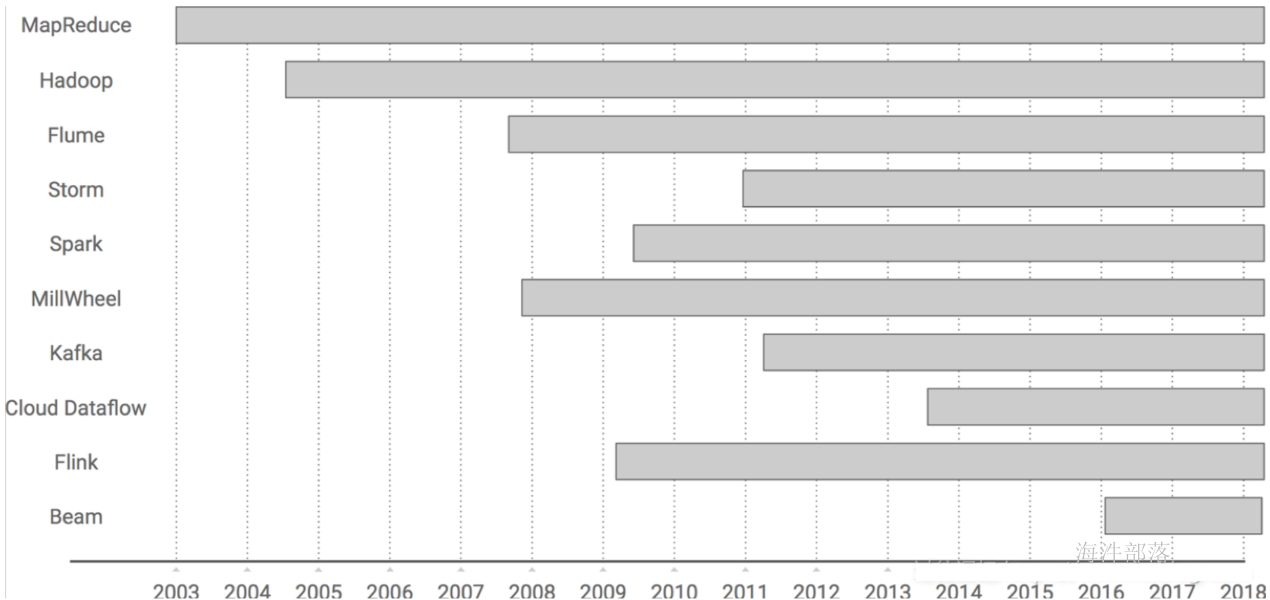

这几年大数据的飞速发展,出现了很多热门的开源社区,其中著名的有 Hadoop、Storm,以及后来的 Spark,他们都有着各自专注的应用场景。Spark 掀开了内存计算的先河,也以内存为赌注,赢得了内存计算的飞速发展。Spark 的火热或多或少的掩盖了其他分布式计算的系统身影。就像 Flink,也就在这个时候默默的发展着。

在国外一些社区,有很多人将大数据的计算引擎分成了 4 代,当然,也有很多人不会认同。我们先姑且这么认为和讨论。

首先第一代的计算引擎,无疑就是 Hadoop 承载的 MapReduce。这里大家应该都不会对 MapReduce 陌生,它将计算分为两个阶段,分别为 Map 和 Reduce。对于上层应用来说,就不得不想方设法去拆分算法,甚至于不得不在上层应用实现多个 Job 的串联,以完成一个完整的算法,例如迭代计算。

由于这样的弊端,催生了支持 DAG 框架的产生。因此,支持 DAG 的框架被划分为第二代计算引擎。如 Tez 以及更上层的 Oozie。这里我们不去细究各种 DAG 实现之间的区别,不过对于当时的 Tez 和 Oozie 来说,大多还是批处理的任务。

接下来就是以 Spark 为代表的第三代的计算引擎。第三代计算引擎的特点主要是 Job 内部的 DAG 支持(不跨越 Job),以及强调的实时计算。在这里,很多人也会认为第三代计算引擎也能够很好的运行批处理的 Job。

随着第三代计算引擎的出现,促进了上层应用快速发展,例如各种迭代计算的性能以及对流计算和 SQL 等的支持。Flink 的诞生就被归在了第四代。这应该主要表现在 Flink 对流计算的支持,以及更一步的实时性。当然 Flink 也可以支持 Batch 的任务,以及 DAG 的运算。

2.什么是Flink

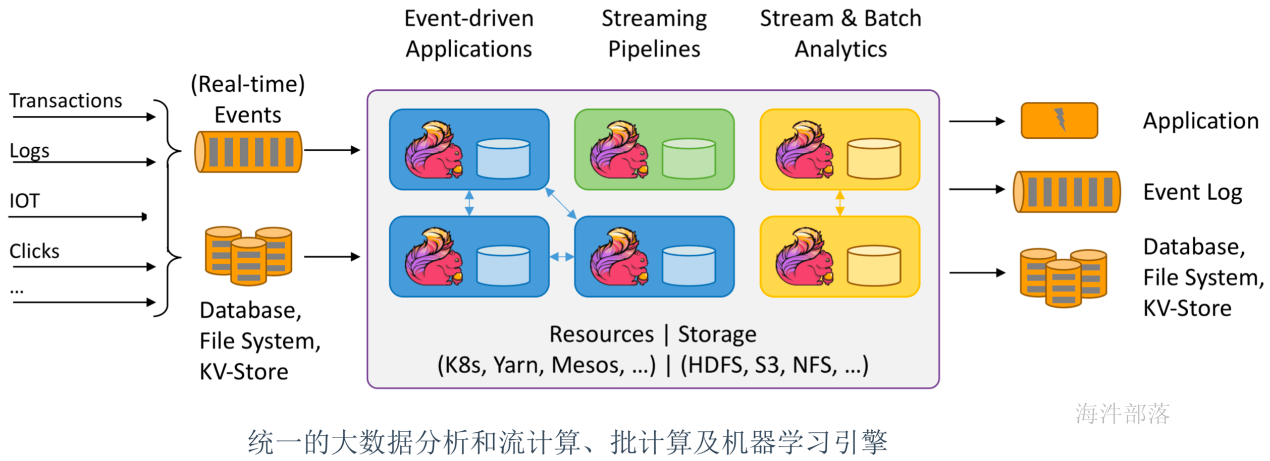

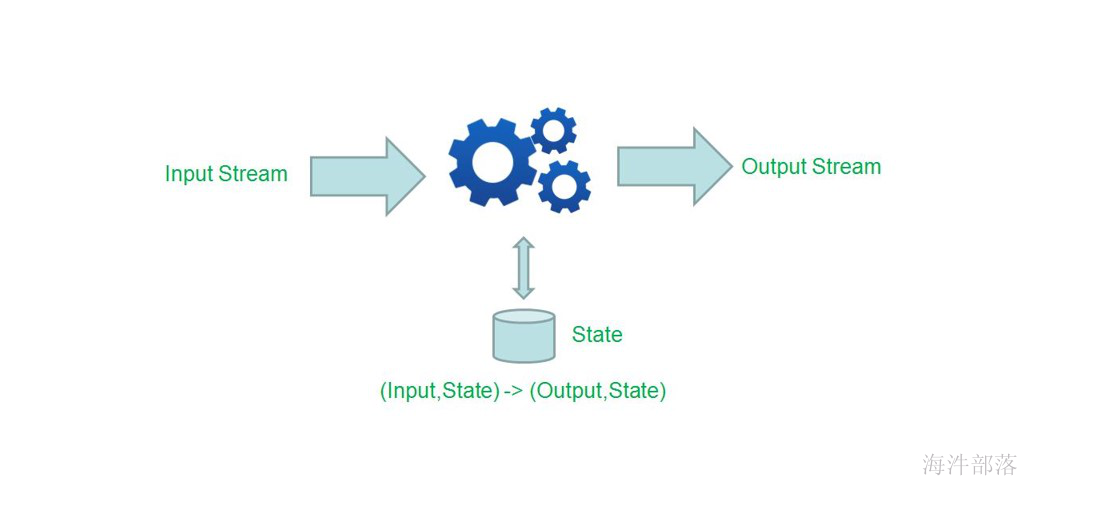

Apache Flink是一个分布式大数据处理引擎,可对有界数据流和无界数据流进行有状态计算。 可部署在各种集群环境,对各种大小的数据规模进行快速计算。

什么是有界数据流和无界数据流?

- 无界流有一个开始但没有定义的结束。它们不会在生成时终止并提供数据。必须持续处理无界流,即必须在摄取事件后立即处理事件。无法等待所有输入数据到达,因为输入是无界的,并且在任何时间点都不会完成。处理无界数据通常要求以特定顺序(例如事件发生的顺序)摄取事件。

- 有界流具有定义的开始和结束。可以在执行任何计算之前通过摄取所有数据来处理有界流。处理有界流不需要有序摄取,因为可以始终对有界数据集进行排序。有界流的处理也称为批处理。

Apache Flink擅长处理无界和有界数据集。精确控制时间和状态使Flink的运行时能够在无界流上运行任何类型的应用程序。有界流由算法和数据结构内部处理,这些算法和数据结构专门针对固定大小的数据集而设计,从而产生出色的性能。

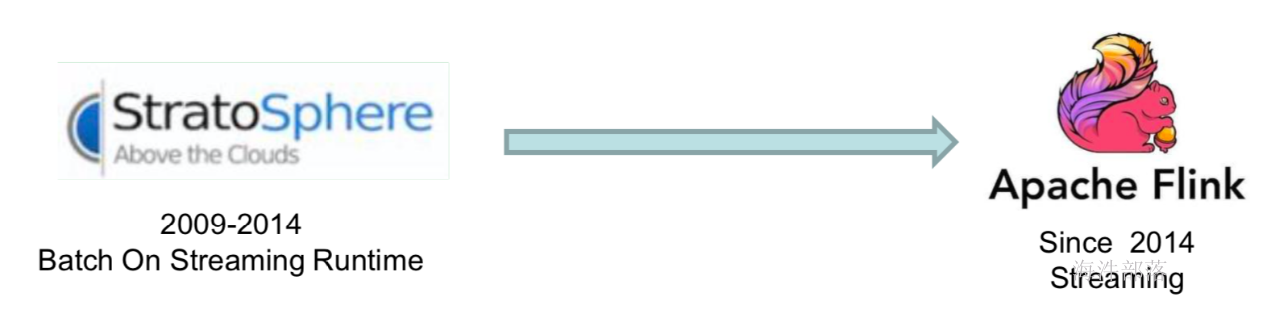

3.Flink历史

Flink诞生于欧洲的一个大数据研究项目,原名 StratoSphere。该项目是柏林工业大学的一个研究性项目,早期专注于批计算。2014 年,StratoSphere 项目中的核心成员孵化出 Flink,并在同年将 Flink 捐赠 Apache,后来 Flink 顺利成为 Apache 的顶级大数据项目。同时 Flink 计算的主流方向被定位为流计算,即用流式计算来做所有大数据 的计算工作,这就是 Flink 技术诞生的背景。

Apache Flink起了个大早,赶了个晚集,在 2015 年突然出现在大数据舞台,然后似乎在一夜之间从一个无人所知的系统迅速转变为人人皆知的流式处理引擎。

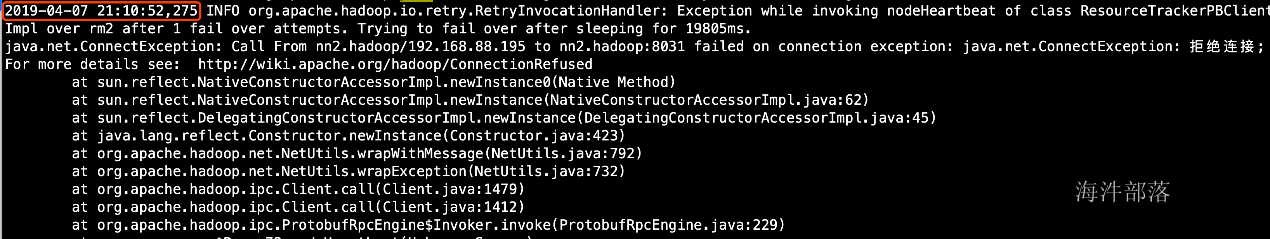

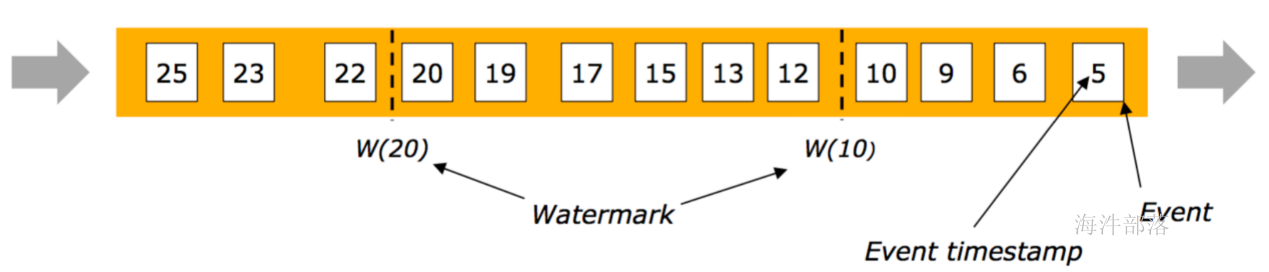

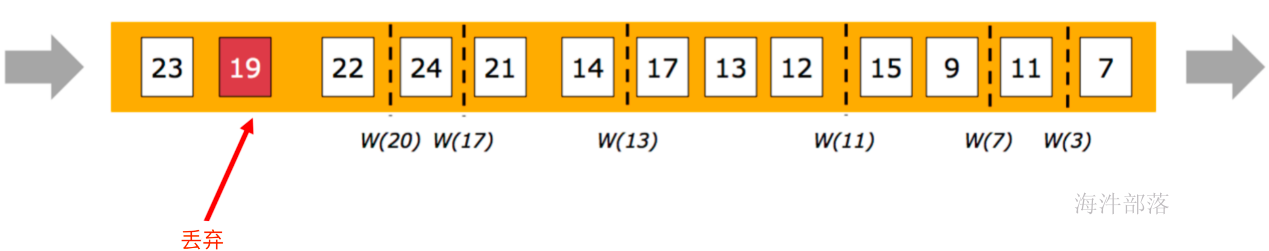

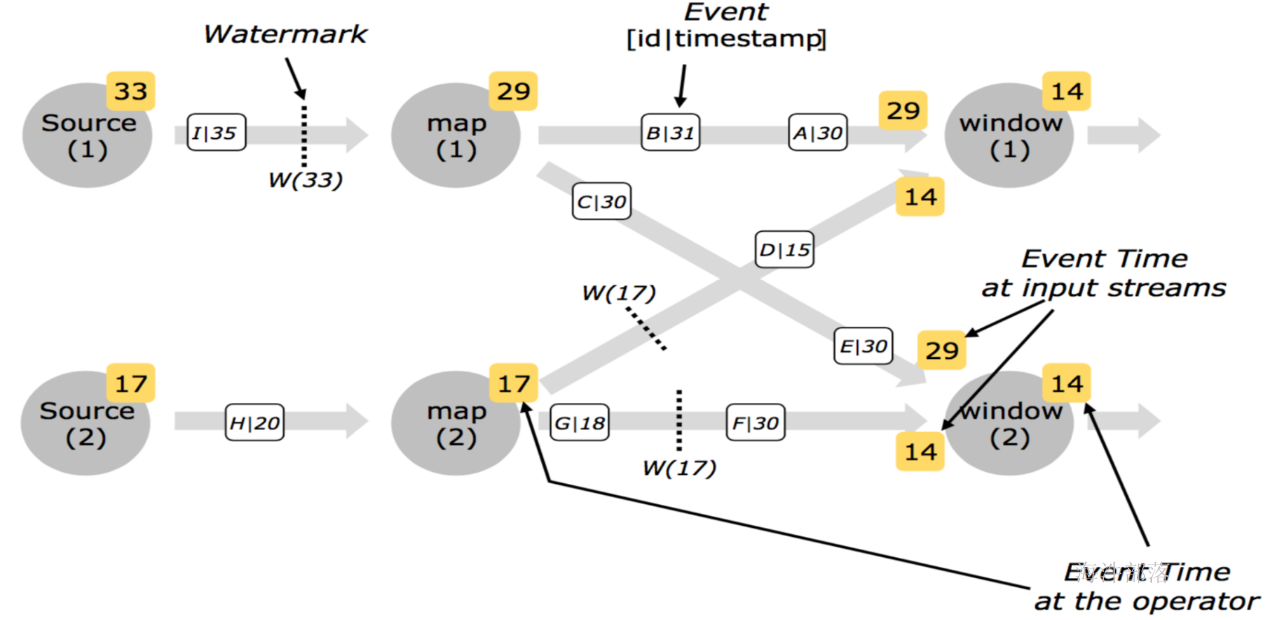

2014 年 Flink 作为主攻流计算的大数据引擎开始在开源大数据行业内崭露头角。区别于 Storm、Spark Streaming 以及其他流式计算引擎的是:它不仅是一个高吞吐、低延迟的 计算引擎,同时还提供很多高级功能。比如它提供有状态的计算,支持状态管理,支持强一致性的数据语义以及支持 Event Time,WaterMark 对消息乱序的处理等

2015 年是流计算百花齐放的时代,各个流计算框架层出不穷。Storm, JStorm, Heron, Flink, Spark Streaming, Google Dataflow (后来的 Beam) 等等。其中 Flink 的一致性语义和最接近 Dataflow 模型的开源实现,使其成为流计算框架中最耀眼的一颗。也许这也 是阿里看中 Flink的原因,并决心投入重金去研究基于 Flink的 Blink框架。

然后就有了阿里爸爸买买买

4.Flink的特点

- 支持java(主)和 scala api(真香)

- 流(dataStream)批(dataSet)一体化

- 支持事件处理和无序处理通过DataStream API,基于DataFlow数据流模型

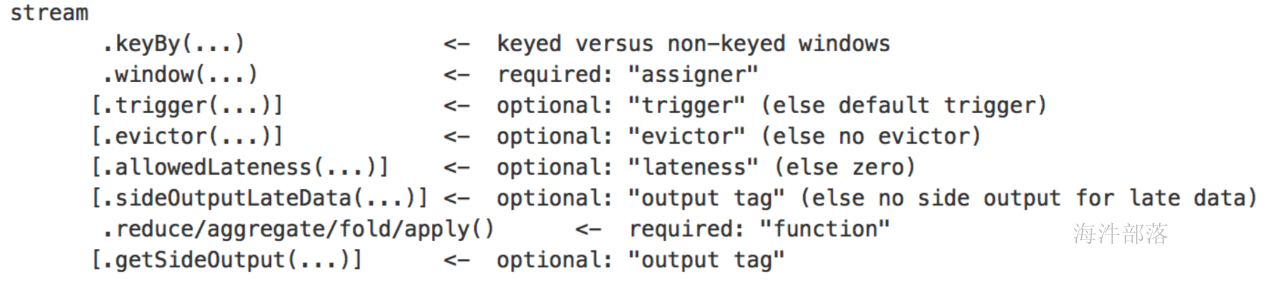

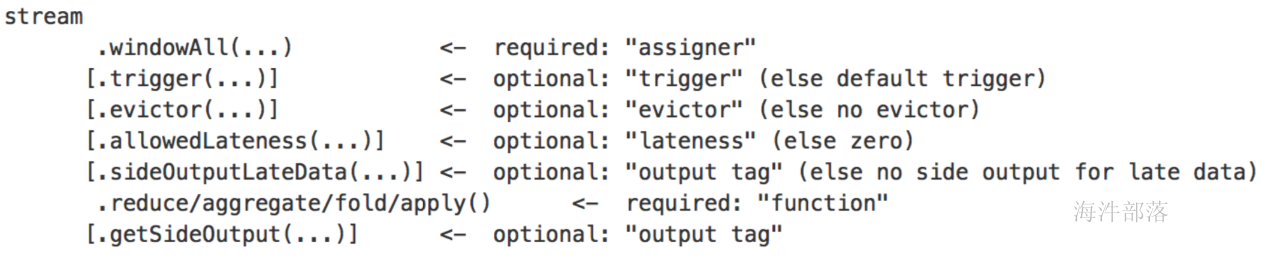

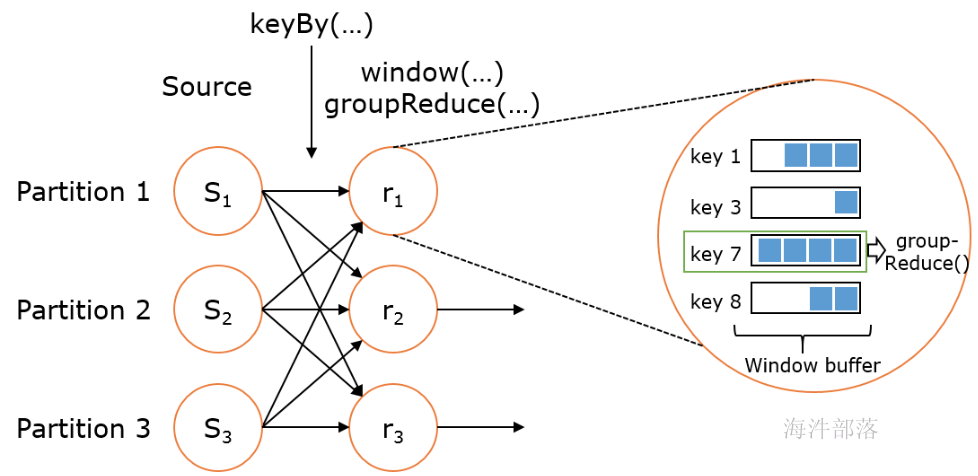

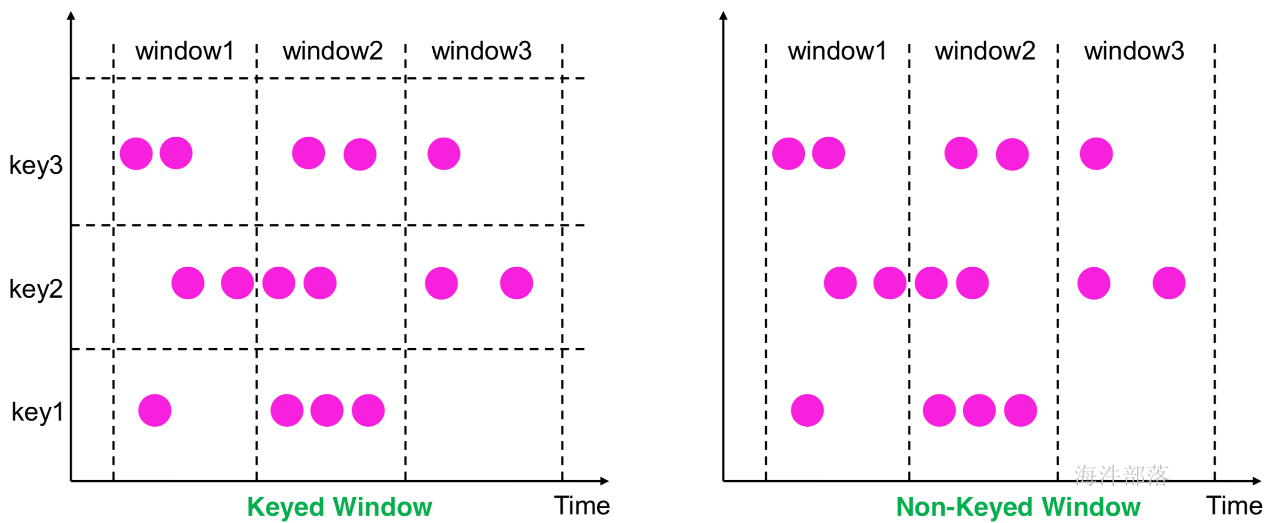

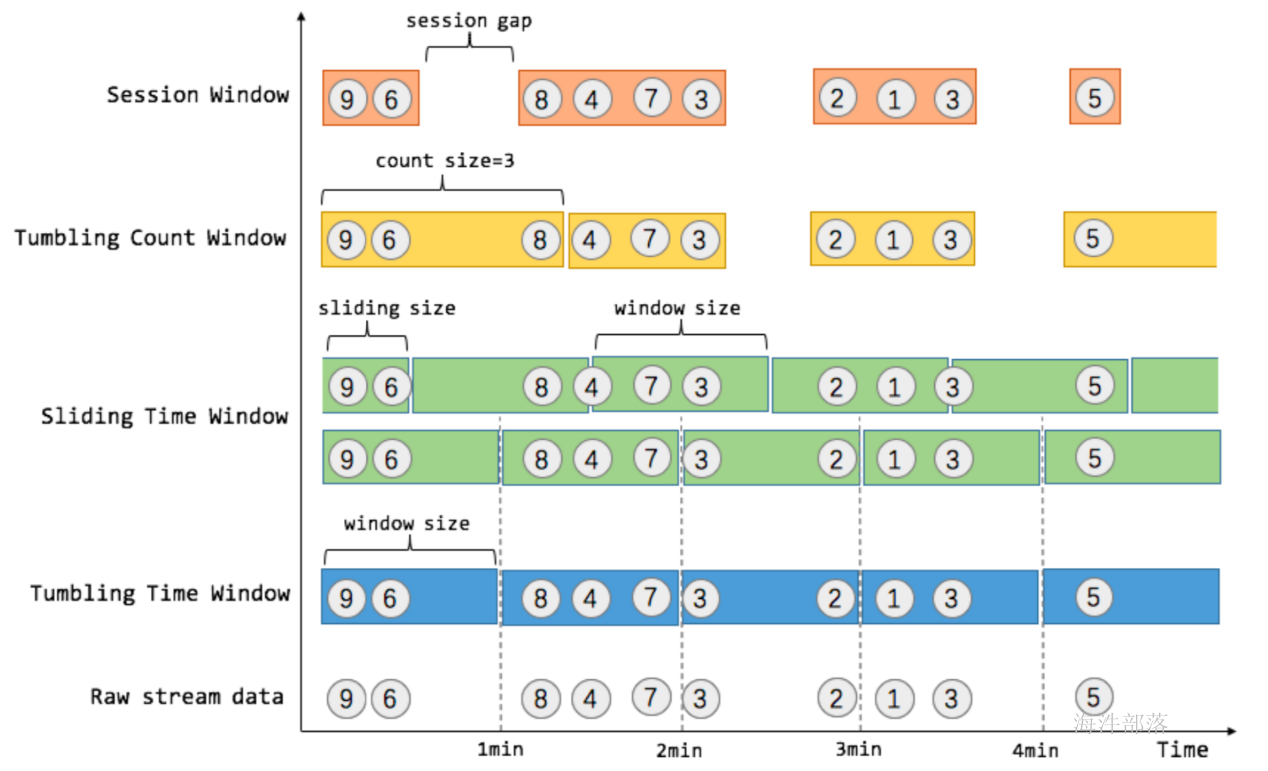

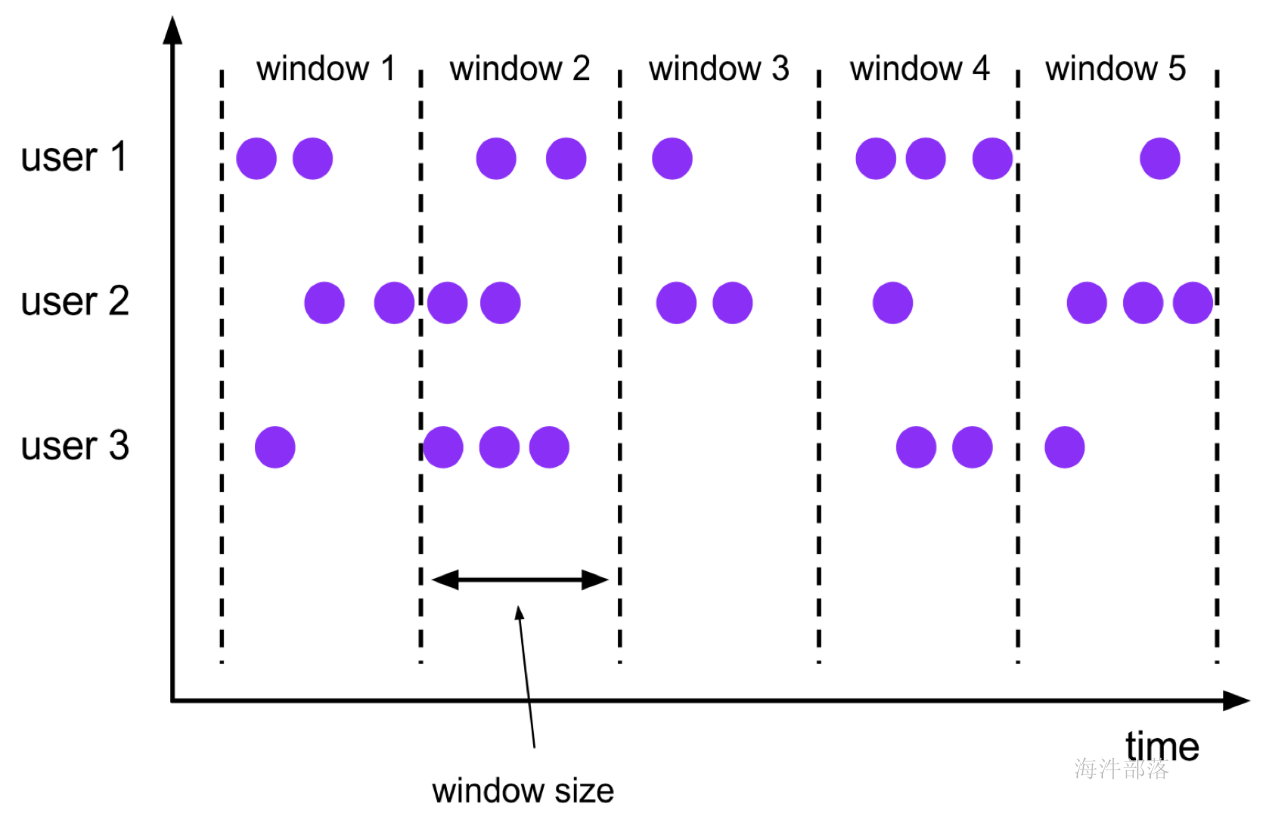

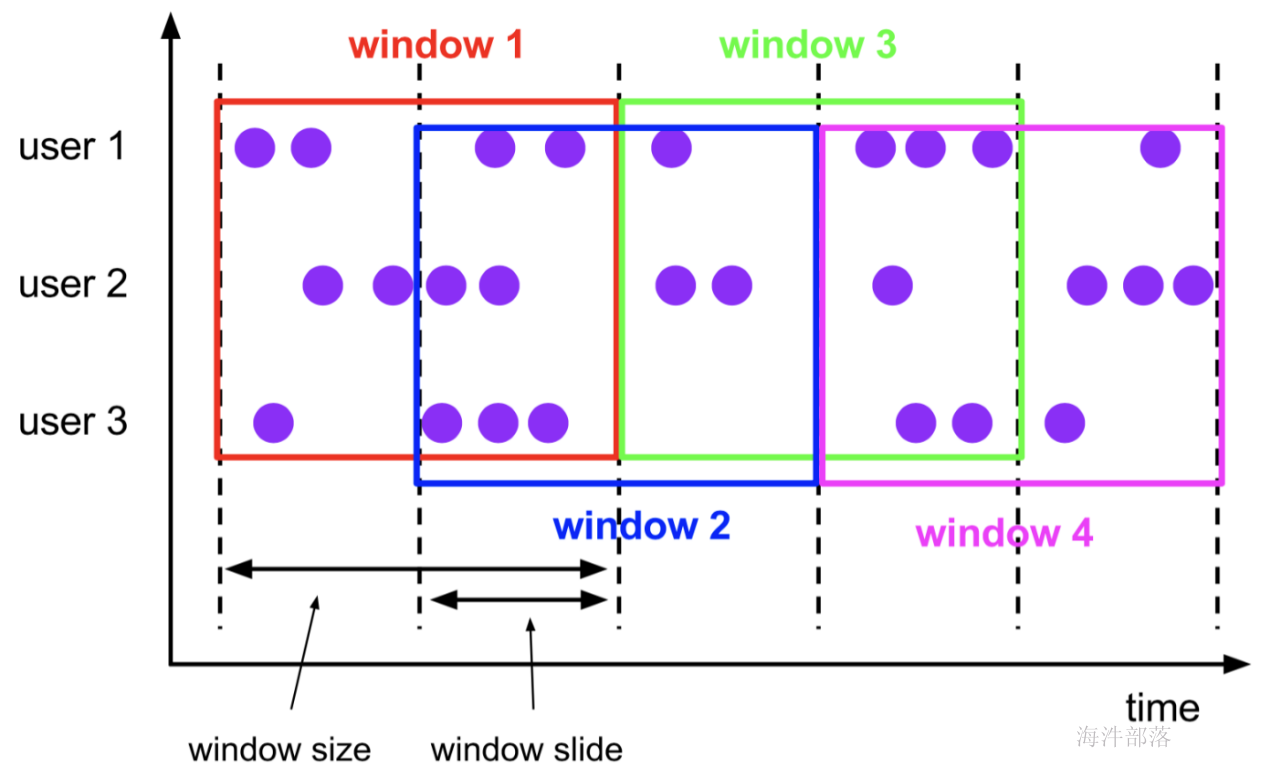

- 在不同的时间语义(事件时间,摄取时间、处理时间)下支持灵活的窗口(时间,滑动、翻滚,会话,自定义触发器)

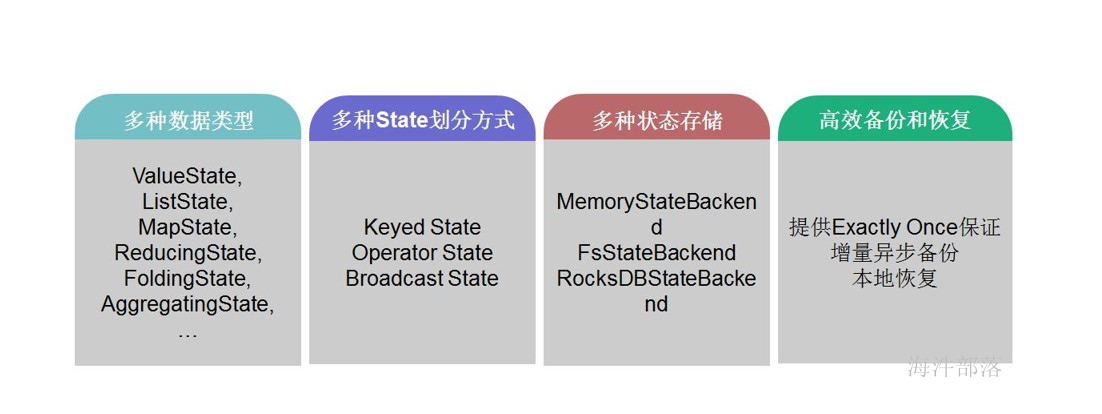

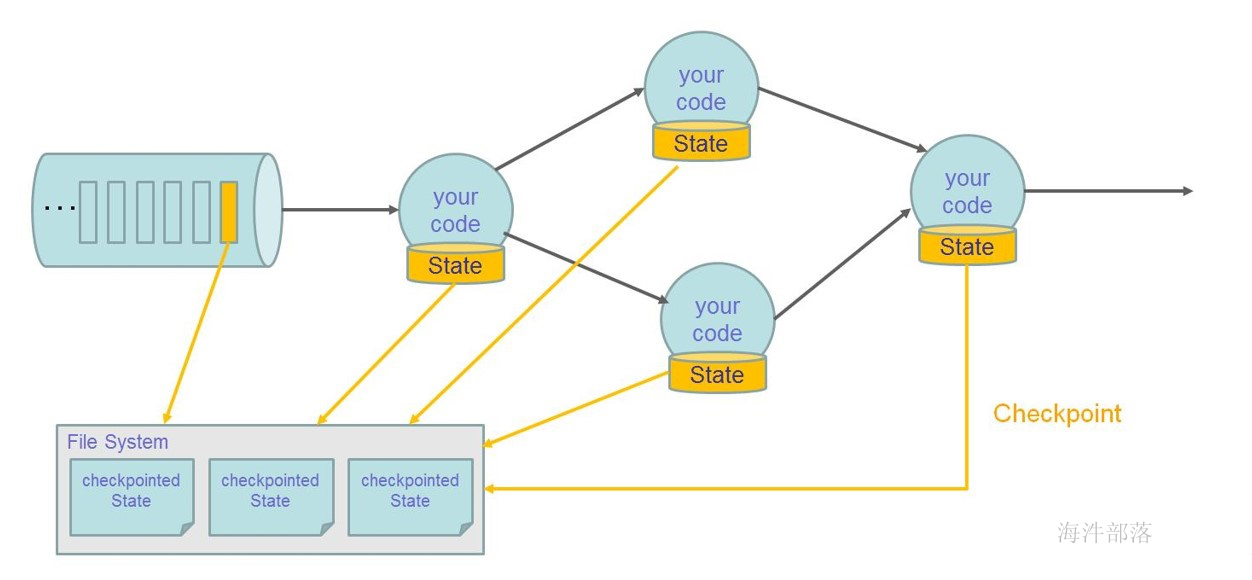

- 支持有状态计算的Exactly-once(仅处理一次)容错保证

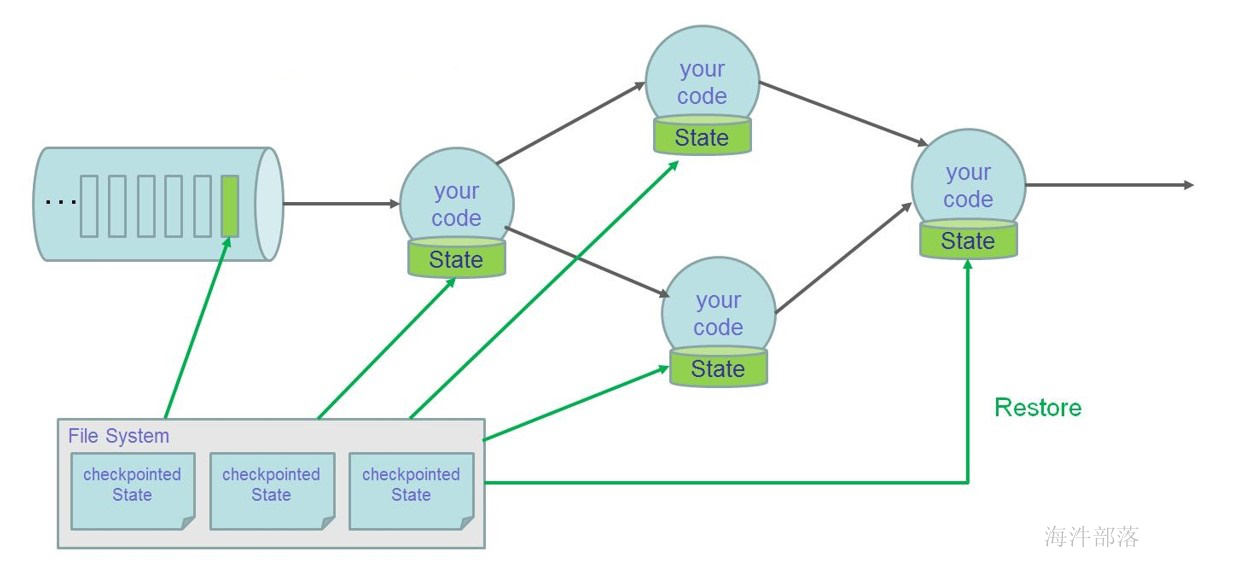

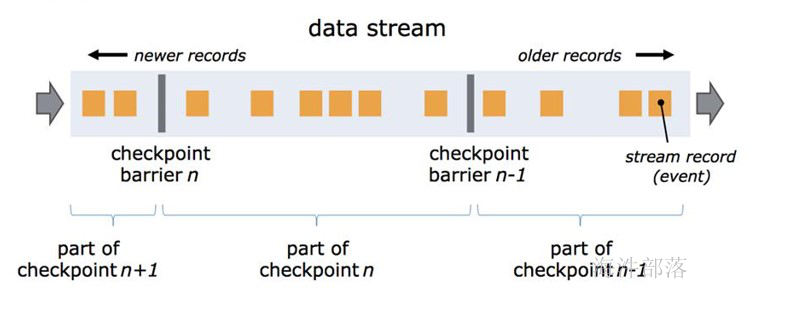

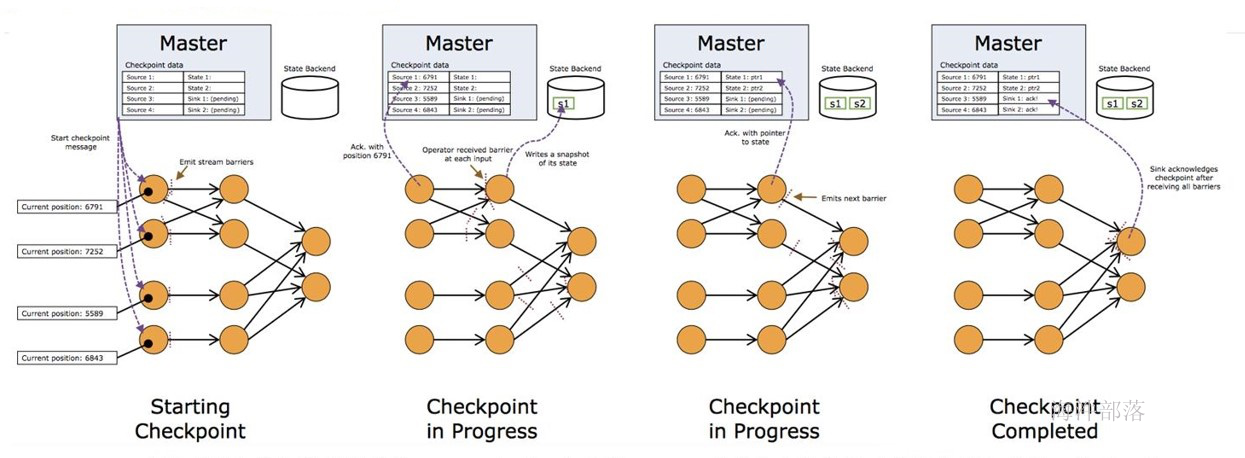

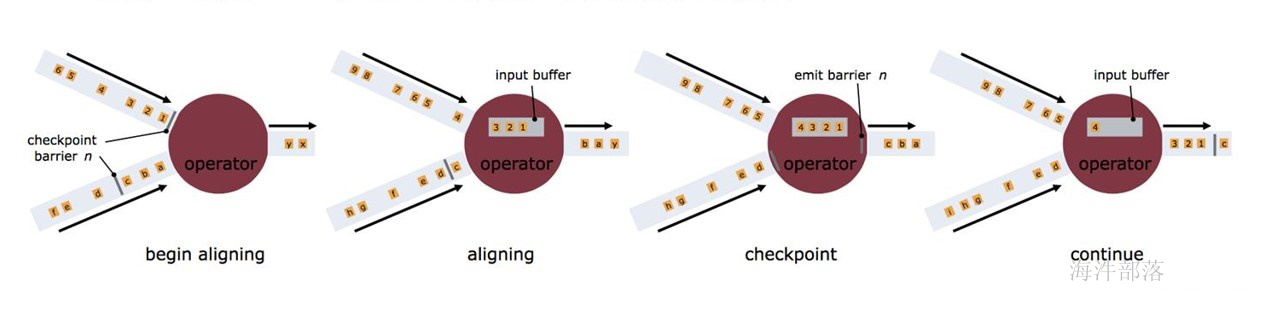

- 支持基于轻量级分布式快照checkpoint机制实现的容错

- 支持savepoints 机制,一般手动触发,在升级应用或者处理历史数据是能够做到无状态丢失和最小停机时间

- 兼容hadoop的mapreduce,集成YARN,HDFS,Hbase 和其它hadoop生态系统的组件

- 支持大规模的集群模式,支持yarn、Mesos。可运行在成千上万的节点上

- 在dataSet(批处理)API中内置支持迭代程序

- 图处理(批) 机器学习(批) 复杂事件处理(流)

- 自动反压机制

- 高效的自定义内存管理

- 健壮的切换能力在in-memory和out-of-core中

5.flink的反压原理

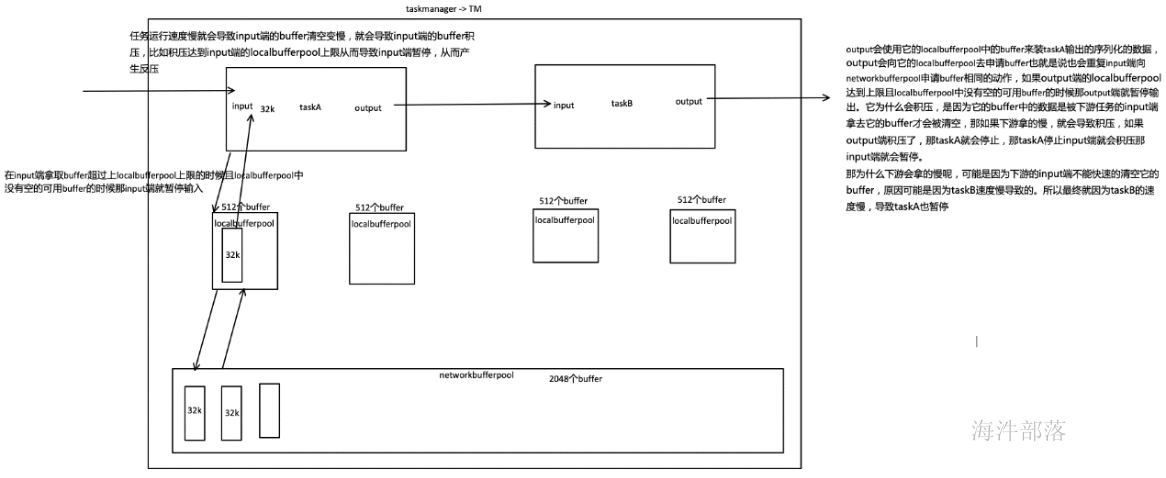

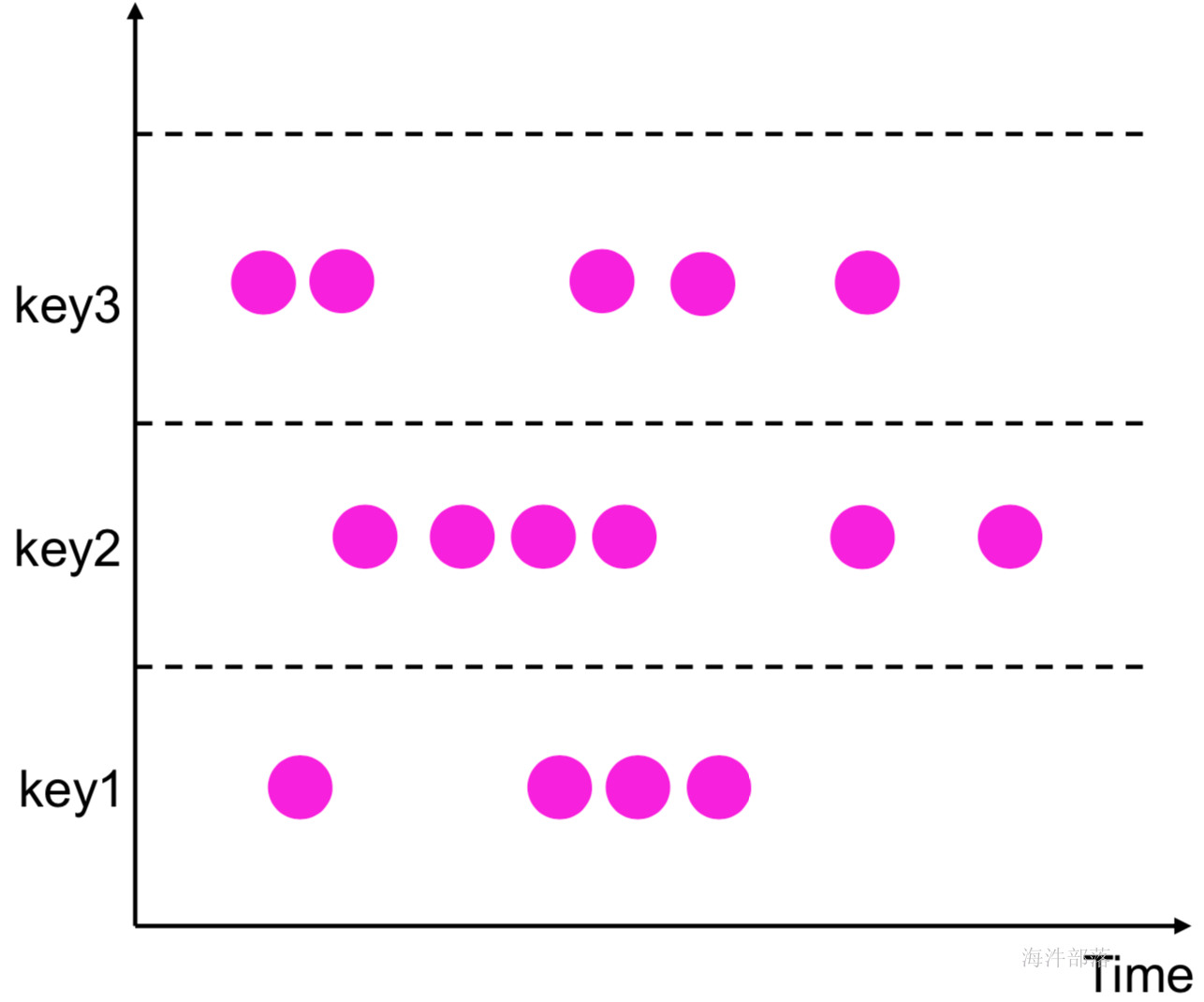

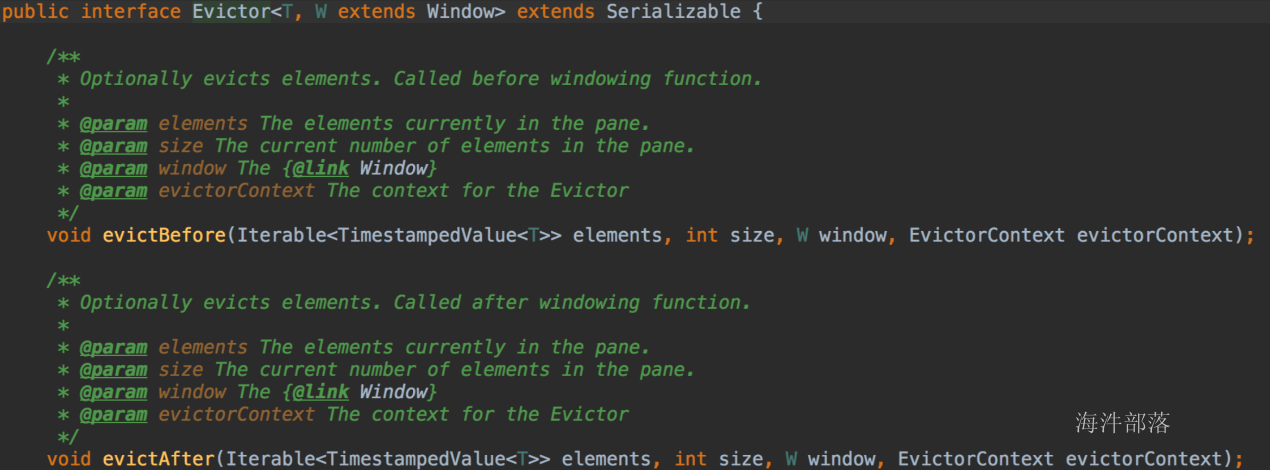

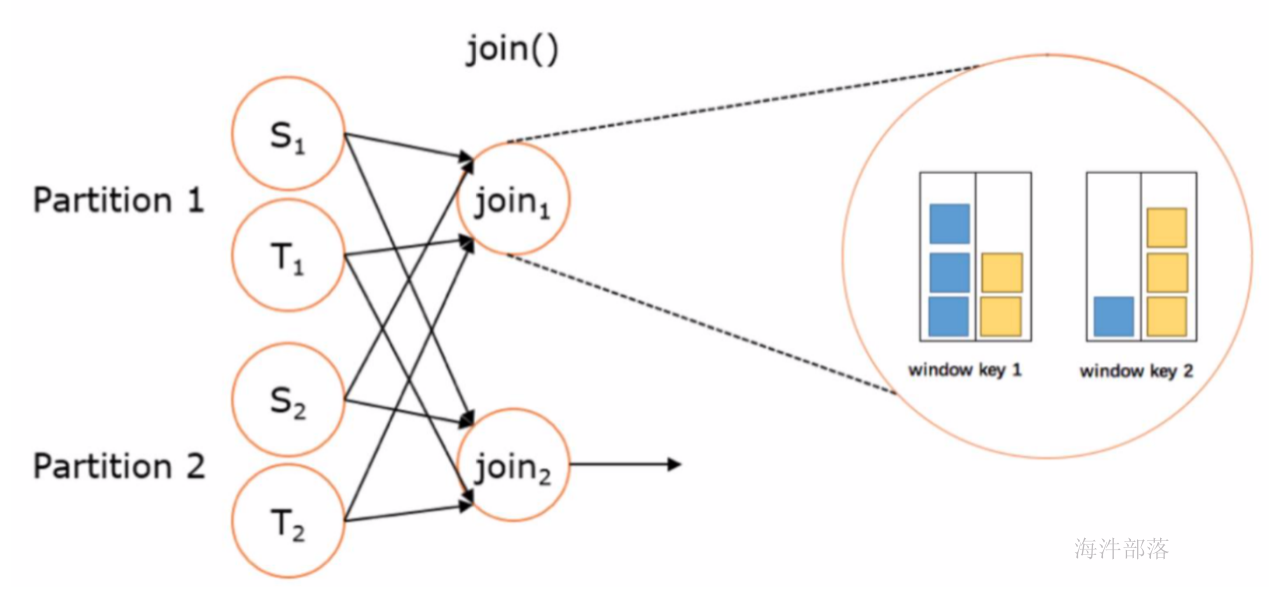

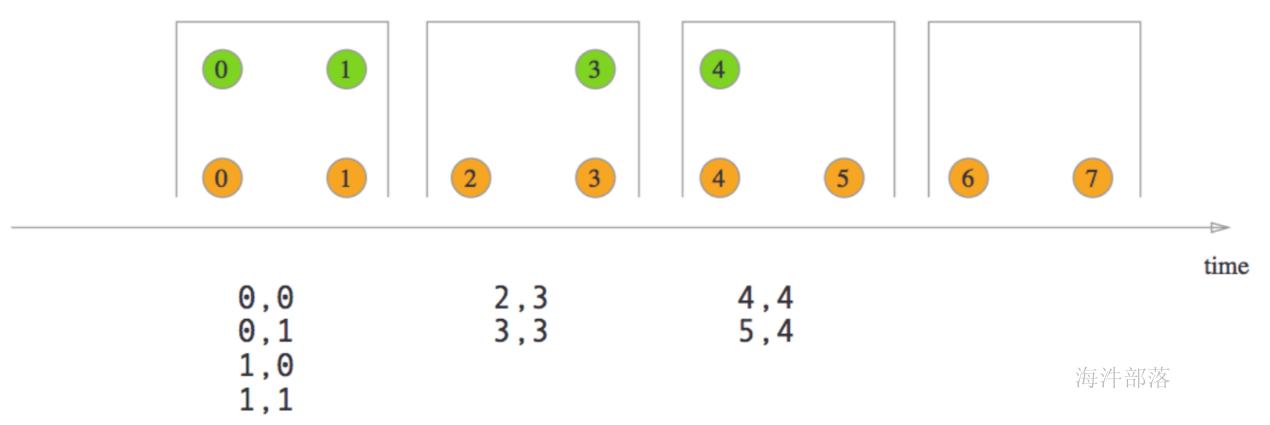

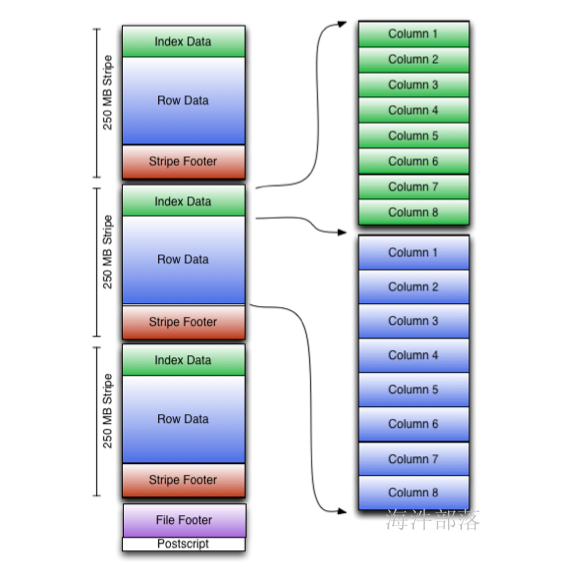

如下图所示展示了 Flink 在网络传输场景下的内存管理。网络上传输的数据会写到 Task 的 InputGate(IG) 中,经过 Task 的处理后,再由 Task 写到 ResultPartition(RS) 中。每个 Task 都包括了输入和输入,输入和输出的数据存在 Buffer 中(都是字节数据)。Buffer 是 MemorySegment 的包装类。

- 根据配置,Flink 会在 NetworkBufferPool 中生成一定数量(默认2048)的内存块 MemorySegment,内存块的总数量就代表了网络传输中所有可用的内存。NetworkEnvironment 和 NetworkBufferPool 是 Task 之间共享的,每个节点(TaskManager)只会实例化一个。

- Task 线程启动时,会向 NetworkEnvironment 注册,NetworkEnvironment 会为 Task 的 InputGate(IG)和 ResultPartition(RP) 分别创建一个 LocalBufferPool(缓冲池)并设置可申请的 MemorySegment(内存块)数量。IG 对应的缓冲池初始的内存块数量与 IG 中 InputChannel 数量一致,RP 对应的缓冲池初始的内存块数量与 RP 中的 ResultSubpartition 数量一致。不过,每当创建或销毁缓冲池时,NetworkBufferPool 会计算剩余空闲的内存块数量,并平均分配给已创建的缓冲池。注意,这个过程只是指定了缓冲池所能使用的内存块数量,并没有真正分配内存块,只有当需要时才分配。为什么要动态地为缓冲池扩容呢?因为内存越多,意味着系统可以更轻松地应对瞬时压力(如GC),不会频繁地进入反压状态,所以我们要利用起那部分闲置的内存块。

- 在 Task 线程执行过程中,当 Netty 接收端收到数据时,为了将 Netty 中的数据拷贝到 Task 中,InputChannel(实际是 RemoteInputChannel)会向其对应的缓冲池申请内存块(上图中的①)。如果缓冲池中也没有可用的内存块且已申请的数量还没到池子上限,则会向 NetworkBufferPool 申请内存块(上图中的②)并交给 InputChannel 填上数据(上图中的③和④)。如果缓冲池已申请的数量达到上限了呢?或者 NetworkBufferPool 也没有可用内存块了呢?这时候,Task 的 Netty Channel 会暂停读取,上游的发送端会立即响应停止发送,拓扑会进入反压状态。当 Task 线程写数据到 ResultPartition 时,也会向缓冲池请求内存块,如果没有可用内存块时,会阻塞在请求内存块的地方,达到暂停写入的目的。

- 当一个内存块被消费完成之后(在输入端是指内存块中的字节被反序列化成对象了,在输出端是指内存块中的字节写入到 Netty Channel 了),会调用 Buffer.recycle() 方法,会将内存块还给 LocalBufferPool (上图中的⑤)。如果LocalBufferPool中当前申请的数量超过了池子容量(由于上文提到的动态容量,由于新注册的 Task 导致该池子容量变小),则LocalBufferPool会将该内存块回收给 NetworkBufferPool(上图中的⑥)。如果没超过池子容量,则会继续留在池子中,减少反复申请的开销。

反压的过程

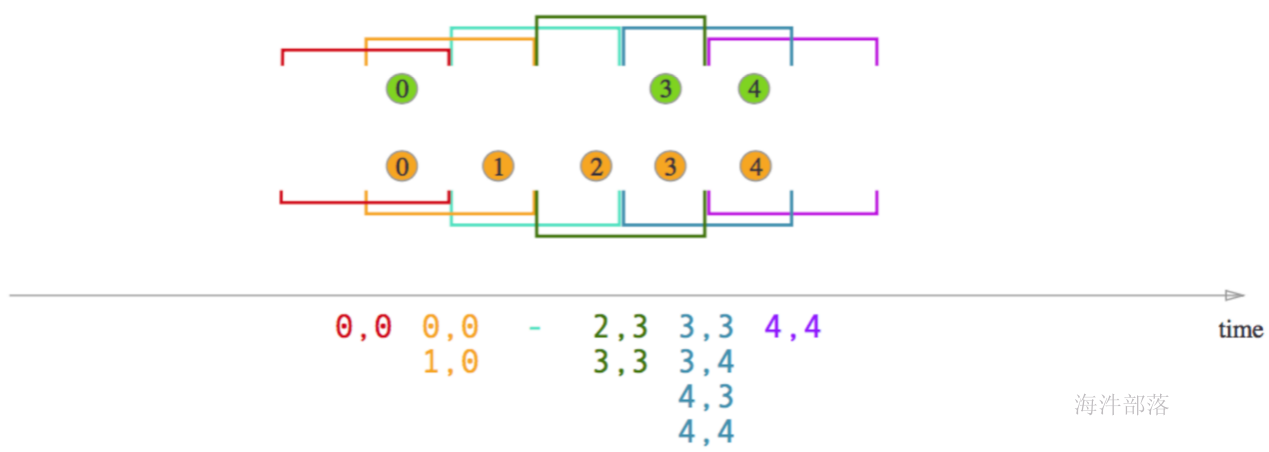

下面这张图简单展示了两个 Task 之间的数据传输以及 Flink 如何感知到反压的:

- 记录“A”进入了 Flink 并且被 Task 1 处理。(这里省略了 Netty 接收、反序列化等过程)

- 记录被序列化到 buffer 中。

- 该 buffer 被发送到 Task 2,然后 Task 2 从这个 buffer 中读出记录。

不要忘了:记录能被 Flink 处理的前提是,必须有空闲可用的 Buffer

结合上面两张图看:Task 1 在输出端有一个相关联的 LocalBufferPool(称缓冲池1),Task 2 在输入端也有一个相关联的 LocalBufferPool(称缓冲池2)。如果缓冲池1中有空闲可用的 buffer 来序列化记录 “A”,我们就序列化并发送该 buffer。

这里我们需要注意两个场景:

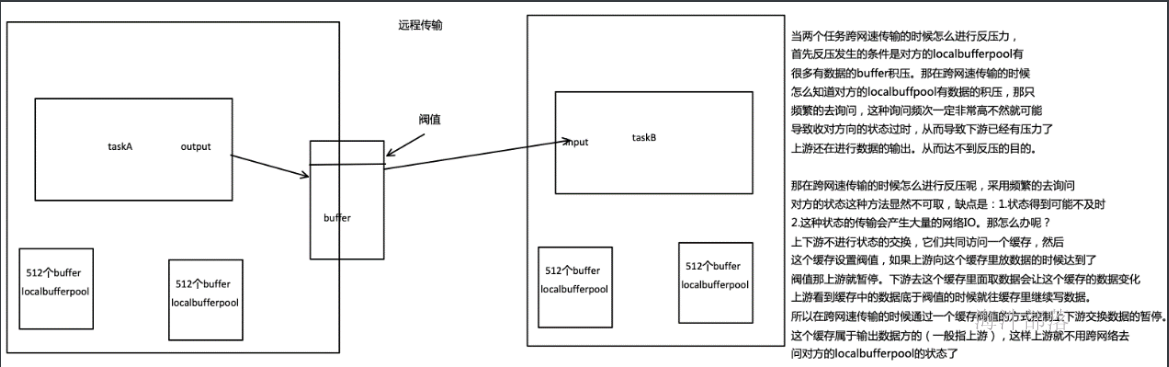

- 本地传输:如果 Task 1 和 Task 2 运行在同一个 worker 节点(TaskManager),该 buffer 可以直接交给下一个 Task。一旦 Task 2 消费了该 buffer,则该 buffer 会被缓冲池1回收。如果 Task 2 的速度比 1 慢,那么 buffer 回收的速度就会赶不上 Task 1 取 buffer 的速度,导致缓冲池1无可用的 buffer,Task 1 等待在可用的 buffer 上。最终形成 Task 1 的降速。

- 远程传输:如果 Task 1 和 Task 2 运行在不同的 worker 节点上,那么 buffer 会在发送到网络(TCP Channel)后被回收。在接收端,会从 LocalBufferPool 中申请 buffer,然后拷贝网络中的数据到 buffer 中。如果没有可用的 buffer,会停止从 TCP 连接中读取数据。在输出端,通过 Netty 的水位值机制(可配置)来保证不往网络中写入太多数据。如果网络中的数据(Netty输出缓冲中的字节数)超过了高水位值,我们会等到其降到低水位值以下才继续写入数据。这保证了网络中不会有太多的数据。如果接收端停止消费网络中的数据(由于接收端缓冲池没有可用 buffer),网络中的缓冲数据就会堆积,那么发送端也会暂停发送。另外,这会使得发送端的缓冲池得不到回收,writer 阻塞在向 LocalBufferPool 请求 buffer,阻塞了 writer 往 ResultSubPartition 写数据。

这种固定大小缓冲池就像阻塞队列一样,保证了 Flink 有一套健壮的反压机制,使得 Task 生产数据的速度不会快于消费的速度。我们上面描述的这个方案可以从两个 Task 之间的数据传输自然地扩展到更复杂的 pipeline 中,保证反压机制可以扩散到整个 pipeline。

反压监控

Flink 的实现中,只有当 Web 页面切换到某个 Job 的 Backpressure 页面,才会对这个 Job 触发反压检测,因为反压检测还是挺昂贵的。JobManager 会通过 Akka 给每个 TaskManager 发送TriggerStackTraceSample消息。默认情况下,TaskManager 会触发100次 stack trace 采样,每次间隔 50ms(也就是说一次反压检测至少要等待5秒钟)。并将这 100 次采样的结果返回给 JobManager,由 JobManager 来计算反压比率(反压出现的次数/采样的次数),最终展现在 UI 上。UI 刷新的默认周期是一分钟,目的是不对 TaskManager 造成太大的负担。

6.flink的内存管理

基于 JVM 的数据分析引擎都需要面对将大量数据存到内存中,这就不得不面对 JVM 存在的几个问题:(java对象对其的方式是8byte为一个单位hotspot虚拟机,32为系统的对象头为8byte 64位系统为16byte)

boolean 1 byte 1 short 2 char 2 int 4 float 4 long 8 double 8

- Java 对象存储密度低。一个只包含 boolean 属性的对象占用了16个字节内存:对象头占了8个,boolean 属性占了1个,对齐填充占了7个。而实际上只需要一个bit(1/8字节)就够了。

- Full GC 会极大地影响性能,尤其是为了处理更大数据而开了很大内存空间的JVM来说,GC 会达到秒级甚至分钟级。

- OOM 问题影响稳定性。OutOfMemoryError是分布式计算框架经常会遇到的问题,当JVM中所有对象大小超过分配给JVM的内存大小时,就会发生OutOfMemoryError错误,导致JVM崩溃,分布式框架的健壮性和性能都会受到影响。

所以目前,越来越多的大数据项目开始自己管理JVM内存了,为的就是获得像 C 一样的性能以及避免 OOM 的发生,Flink 是如何解决上面的问题的,主要内容包括内存管理、定制的序列化工具、缓存友好的数据结构和算法、堆外内存、JIT编译优化等。

积极的内存管理

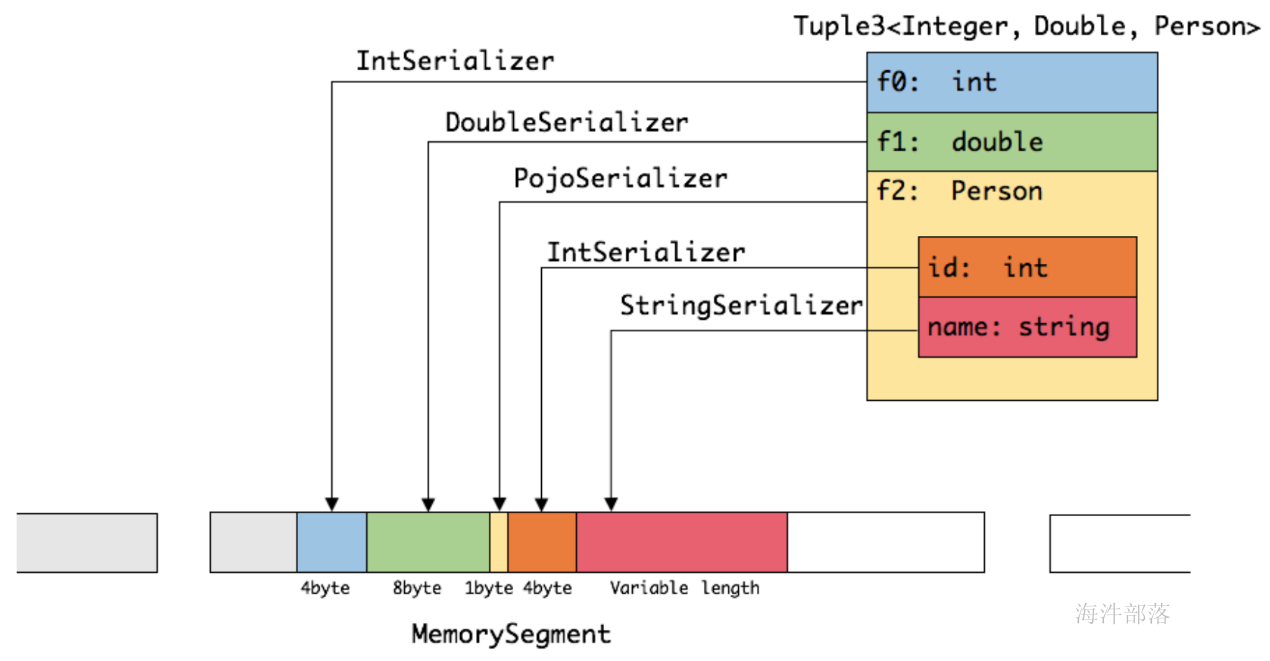

Flink 并不是将大量对象存在堆上,而是将对象都序列化到一个预分配的内存块上,这个内存块叫做 MemorySegment,它代表了一段固定长度的内存(默认大小为 32KB),也是 Flink 中最小的内存分配单元,并且提供了非常高效的读写方法。你可以把 MemorySegment 想象成是为 Flink 定制的 java.nio.ByteBuffer。它的底层可以是一个普通的 Java 字节数组(byte[]),也可以是一个申请在堆外的 ByteBuffer。每条记录都会以序列化的形式存储在一个或多个MemorySegment中。

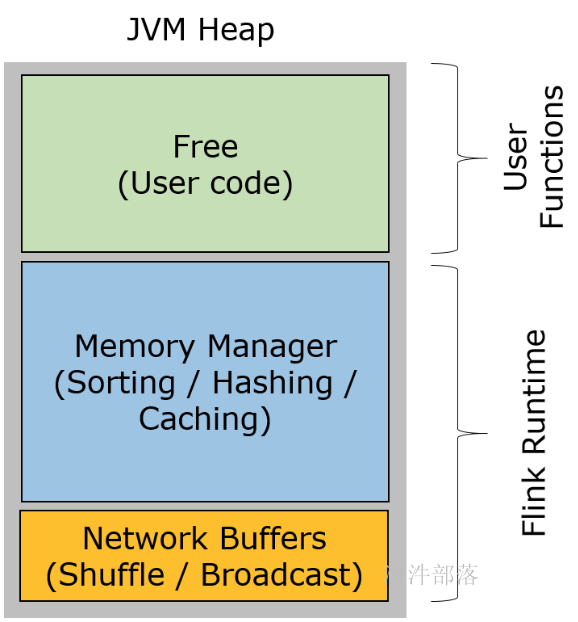

Flink 中的 Worker 名叫 TaskManager,是用来运行用户代码的 JVM 进程。TaskManager 的堆内存主要被分成了三个部分

- Network Buffers: 一定数量的32KB大小的 buffer,主要用于数据的网络传输。在 TaskManager 启动的时候就会分配。默认数量是 2048 个,可以通过 taskmanager.network.numberOfBuffers 来配置。

- Memory Manager Pool: 这是一个由 MemoryManager 管理的,由众多MemorySegment组成的超大集合。Flink 中的算法(如 sort/shuffle/join)会向这个内存池申请 MemorySegment,将序列化后的数据存于其中,使用完后释放回内存池。默认情况下,池子占了堆内存的 70% 的大小。

- Remaining (Free) Heap: 这部分的内存是留给用户代码以及 TaskManager 的数据结构使用的。因为这些数据结构一般都很小,所以基本上这些内存都是给用户代码使用的。从GC的角度来看,可以把这里看成的新生代,也就是说这里主要都是由用户代码生成的短期对象。

注意:Memory Manager Pool 主要在Batch模式下使用。在Steaming模式下,该池子不会预分配内存,也不会向该池子请求内存块。也就是说该部分的内存都是可以给用户代码使用的。不过社区是打算在 Streaming 模式下也能将该池子利用起来。

序列化方法

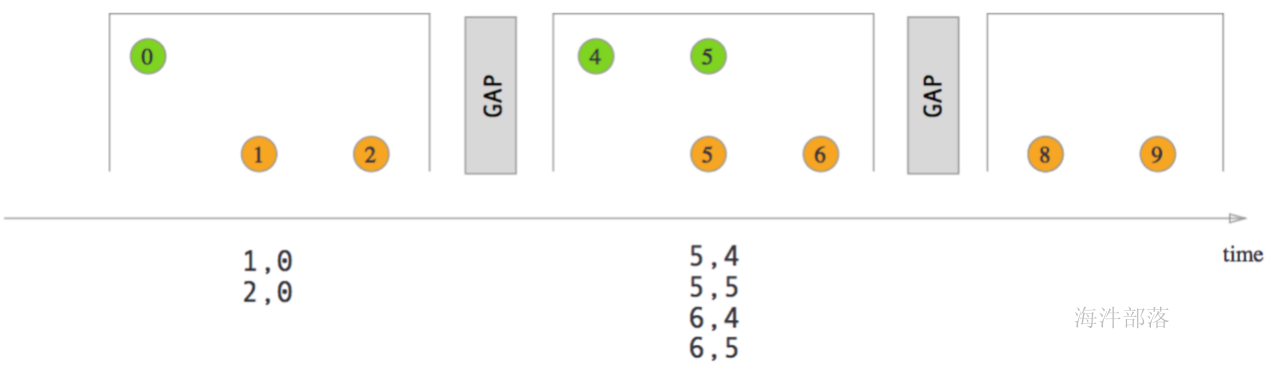

Flink 采用类似 DBMS 的 sort 和 join 算法,直接操作二进制数据,从而使序列化/反序列化带来的开销达到最小。如果需要处理的数据超出了内存限制,则会将部分数据存储到硬盘上。下图描述了 Flink 如何存储序列化后的数据到内存块中,以及在需要的时候如何将数据存储到磁盘上。

从上面我们能够得出 Flink 积极的内存管理以及直接操作二进制数据有以下几点好处:

- 减少GC压力。显而易见,因为所有常驻型数据都以二进制的形式存在 Flink 的MemoryManager中,这些MemorySegment一直呆在老年代而不会被GC回收。其他的数据对象基本上是由用户代码生成的短生命周期对象,这部分对象可以被 Minor GC 快速回收。只要用户不去创建大量类似缓存的常驻型对象,那么老年代的大小是不会变的,Major GC也就永远不会发生。从而有效地降低了垃圾回收的压力。另外,这里的内存块还可以是堆外内存,这可以使得 JVM 内存更小,从而加速垃圾回收。

- 避免了OOM。所有的运行时数据结构和算法只能通过内存池申请内存,保证了其使用的内存大小是固定的,不会因为运行时数据结构和算法而发生OOM。在内存吃紧的情况下,算法(sort/join等)会高效地将一大批内存块写到磁盘,之后再读回来。因此,OutOfMemoryErrors可以有效地被避免。

- 节省内存空间。Java 对象在存储上有很多额外的消耗(如上一节所谈)。如果只存储实际数据的二进制内容,就可以避免这部分消耗。

- 高效的二进制操作 & 缓存友好的计算。二进制数据以定义好的格式存储,可以高效地比较与操作。另外,该二进制形式可以把相关的值,以及hash值,键值和指针等相邻地放进内存中。这使得数据结构可以对高速缓存更友好,可以从 L1/L2/L3 缓存获得性能的提升。

为 Flink 量身定制的序列化框架

目前 Java 生态圈提供了众多的序列化框架:Java serialization, Kryo, Apache Avro 等等。但是 Flink 实现了自己的序列化框架。因为在 Flink 中处理的数据流通常是同一类型,由于数据集对象的类型固定,对于数据集可以只保存一份对象Schema信息,节省大量的存储空间。同时,对于固定大小的类型,也可通过固定的偏移位置存取。当我们需要访问某个对象成员变量的时候,通过定制的序列化工具,并不需要反序列化整个Java对象,而是可以直接通过偏移量,只是反序列化特定的对象成员变量。如果对象的成员变量较多时,能够大大减少Java对象的创建开销,以及内存数据的拷贝大小。

Flink支持的数据类型

Flink支持任意的Java或是Scala类型。Flink 在数据类型上有很大的进步,不需要实现一个特定的接口(像Hadoop中的org.apache.hadoop.io.Writable),Flink 能够自动识别数据类型。Flink 通过 Java Reflection 框架分析。基于 Java 的 Flink 程序 UDF (User Define Function)的返回类型的类型信息,通过 Scala Compiler 分析基于 Scala 的 Flink 程序 UDF 的返回类型的类型信息。类型信息由 TypeInformation 类表示,TypeInformation 支持以下几种类型:

- BasicTypeInfo: 任意Java 基本类型(装箱的)或 String 类型。

- BasicArrayTypeInfo: 任意Java基本类型数组(装箱的)或 String 数组。

- WritableTypeInfo: 任意 Hadoop Writable 接口的实现类。

- TupleTypeInfo: 任意的 Flink Tuple 类型(支持Tuple1 to Tuple25)。Flink tuples 是固定长度固定类型的Java Tuple实现。

- CaseClassTypeInfo: 任意的 Scala CaseClass(包括 Scala tuples)。

- PojoTypeInfo: 任意的 POJO (Java or Scala),例如,Java对象的所有成员变量,要么是 public 修饰符定义,要么有 getter/setter 方法。

- GenericTypeInfo: 任意无法匹配之前几种类型的类。

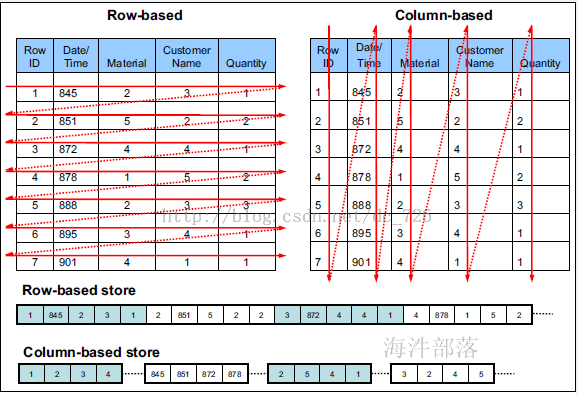

前六种数据类型基本上可以满足绝大部分的Flink程序,针对前六种类型数据集,Flink皆可以自动生成对应的TypeSerializer,能非常高效地对数据集进行序列化和反序列化。对于最后一种数据类型,Flink会使用Kryo进行序列化和反序列化。每个TypeInformation中,都包含了serializer,类型会自动通过serializer进行序列化,然后用Java Unsafe接口写入MemorySegments。对于可以用作key的数据类型,Flink还同时自动生成TypeComparator,用来辅助直接对序列化后的二进制数据进行compare、hash等操作。对于 Tuple、CaseClass、POJO 等组合类型,其TypeSerializer和TypeComparator也是组合的,序列化和比较时会委托给对应的serializers和comparators。如下图展示 一个内嵌型的Tuple3\<Integer,Double,Person> 对象的序列化过程。

可以看出这种序列化方式存储密度是相当紧凑的。其中 int 占4字节,double 占8字节,POJO多个一个字节的header,PojoSerializer只负责将header序列化进去,并委托每个字段对应的serializer对字段进行序列化。

Flink 的类型系统可以很轻松地扩展出自定义的TypeInformation、Serializer以及Comparator,来提升数据类型在序列化和比较时的性能。

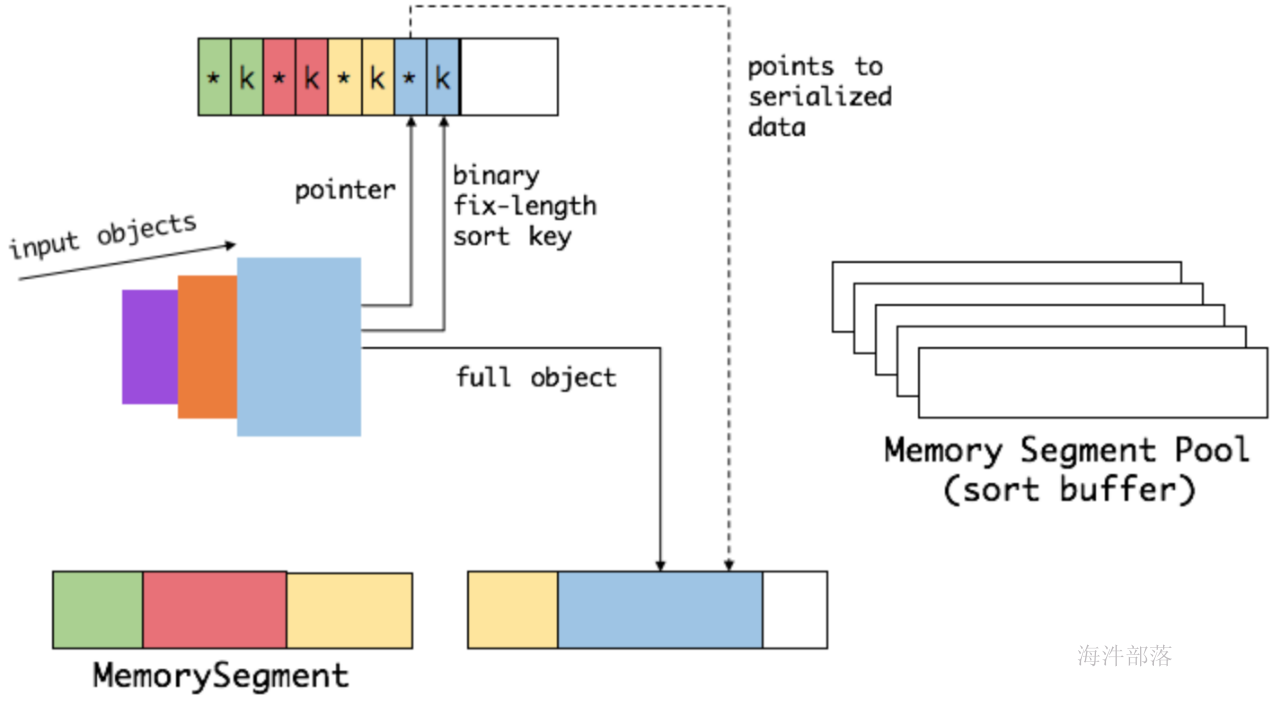

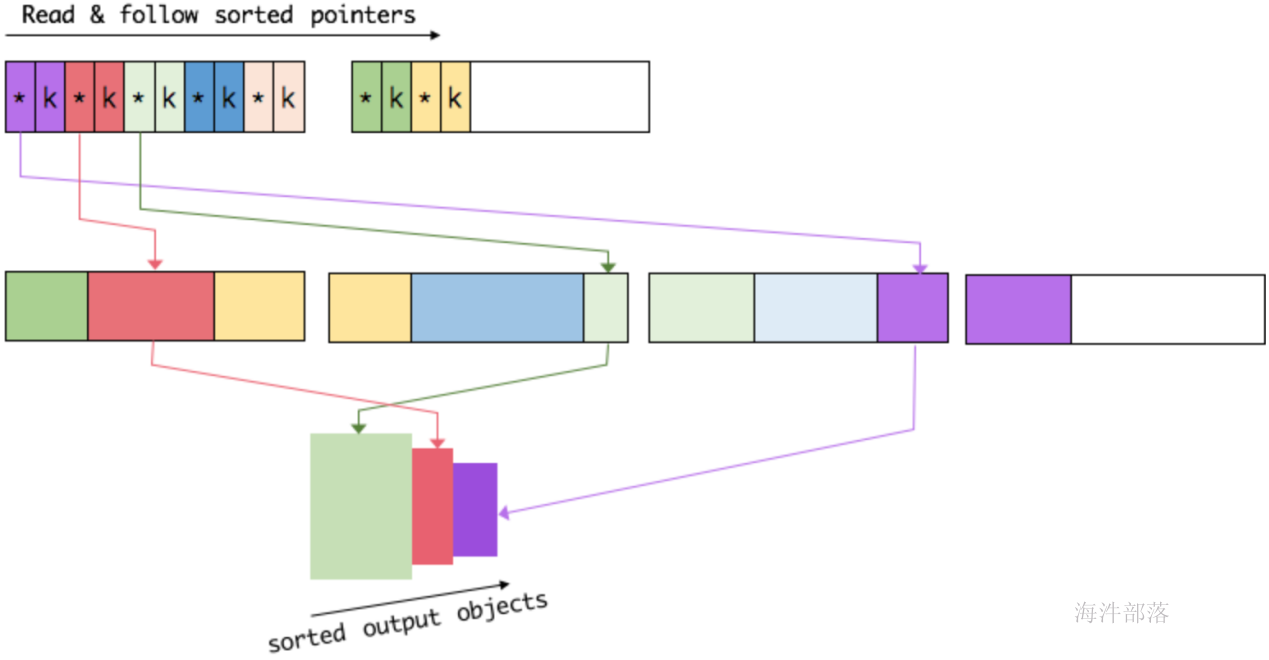

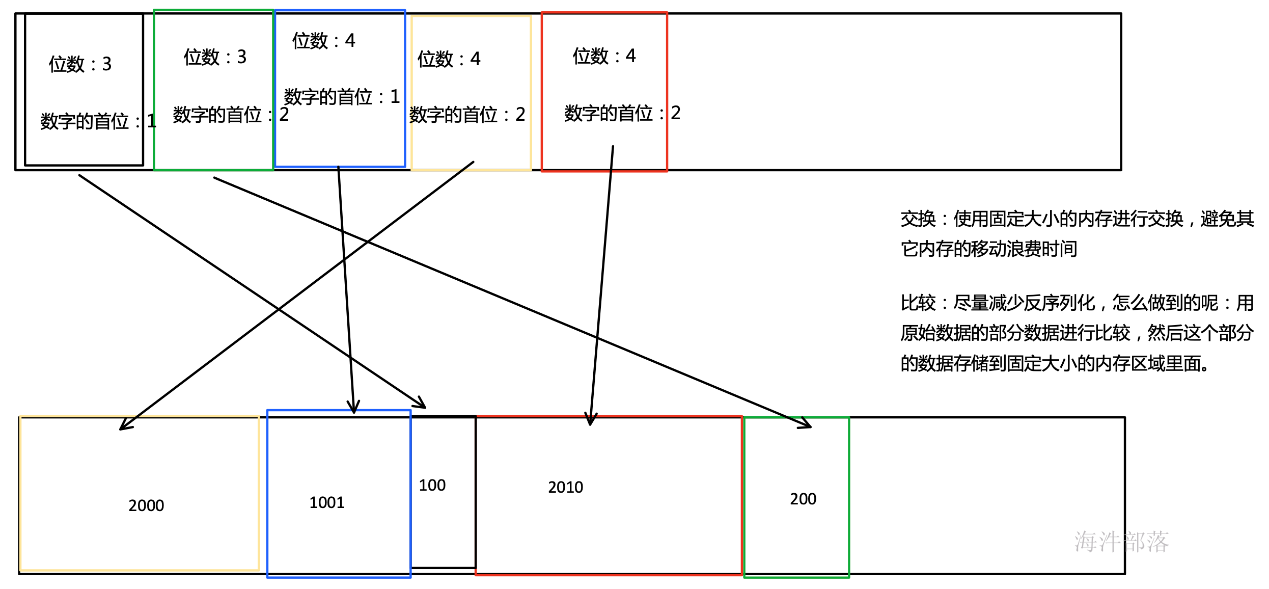

排序

我们会把 sort buffer 分成两块区域。一个区域是用来存放所有对象完整的二进制数据。另一个区域用来存放指向完整二进制数据的指针以及定长的序列化后的key(key+pointer)。如果需要序列化的key是个变长类型,如String,则会取其前缀序列化。当一个对象要加到 sort buffer 中时,它的二进制数据会被加到第一个区域,指针(可能还有key)会被加到第二个区域。

将实际的数据和指针加定长key分开存放有两个目的。第一,交换定长块(key+pointer)更高效,不用交换真实的数据也不用移动其他key和pointer。第二,这样做是缓存友好的,因为key都是连续存储在内存中的,这大大提高了缓存命中率。

排序的关键是比大小和交换。Flink 中,会先用 key 比大小,这样就可以直接用二进制的key比较而不需要反序列化出整个对象。因为key是定长的,所以如果key相同(或者没有提供二进制key),那就必须将真实的二进制数据反序列化出来,然后再做比较。之后,只需要交换key+pointer就可以达到排序的效果,真实的数据不用移动。

最后,访问排序后的数据,可以沿着排好序的key+pointer区域顺序访问,通过pointer找到对应的真实数据,并写到内存或外部

缓存友好的数据结构和算法

随着磁盘IO和网络IO越来越快,CPU逐渐成为了大数据领域的瓶颈。从 L1/L2/L3 缓存读取数据的速度比从主内存读取数据的速度快好几个量级。通过性能分析可以发现,CPU时间中的很大一部分都是浪费在等待数据从主内存过来上。如果这些数据可以从 L1/L2/L3 缓存过来,那么这些等待时间可以极大地降低,并且所有的算法会因此而受益。

在上面讨论中我们谈到的,Flink 通过定制的序列化框架将算法中需要操作的数据(如sort中的key)连续存储,而完整数据存储在其他地方。因为对于完整的数据来说,key+pointer更容易装进缓存,从而提高了基础算法的效率。这对于上层应用是完全透明的,可以充分享受缓存友好带来的性能提升。

走向堆外内存

Flink 基于堆内存的内存管理机制已经可以解决很多JVM现存问题了,为什么还要引入堆外内存?

- 启动超大内存(上百GB)的JVM需要很长时间,GC停留时间也会很长(分钟级)。使用堆外内存的话,可以极大地减小堆内存(只需要分配Remaining Heap那一块),使得 TaskManager 扩展到上百GB内存不是问题。

- 高效的 IO 操作。堆外内存在写磁盘或网络传输时是 zero-copy,而堆内存的话,至少需要 copy 一次。

- 堆外内存是进程间共享的。也就是说,即使JVM进程崩溃也不会丢失数据。这可以用来做故障恢复(Flink暂时没有利用起这个,不过未来很可能会去做)。

但是强大的东西总是会有其负面的一面,不然为何大家不都用堆外内存呢。

- 堆内存的使用、监控、调试都要简单很多。堆外内存意味着更复杂更麻烦。

- Flink 有时需要分配短生命周期的 MemorySegment,这个申请在堆上会更廉价。

- 有些操作在堆内存上会快一点点。

Flink用通过ByteBuffer.allocateDirect(numBytes)来申请堆外内存,用 sun.misc.Unsafe 来操作堆外内存。在flink的源码中大量的 getXXX/putXXX 方法都是调用了 unsafe 方法去操作内存(这个内存包括堆外内存与堆内内存)。

另外,Flink的源码中,许多方法都被标记成了 final,两个子类也是 final 类型,为的也是优化JIT 编译器(java及时编译器),会提醒 JIT 这个方法是可以被去虚化和内联的。

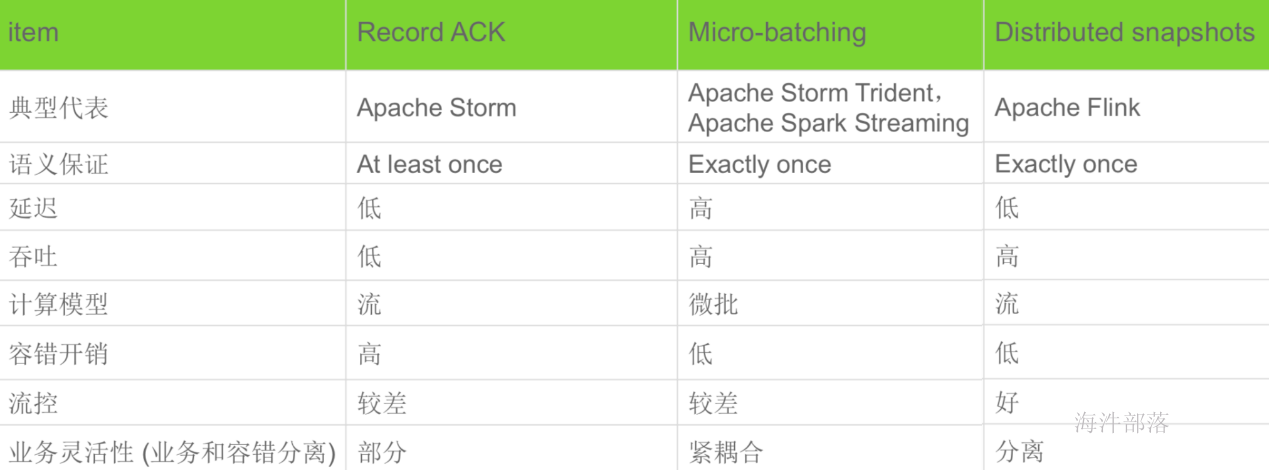

7.对比Spark

流式计算框架对比

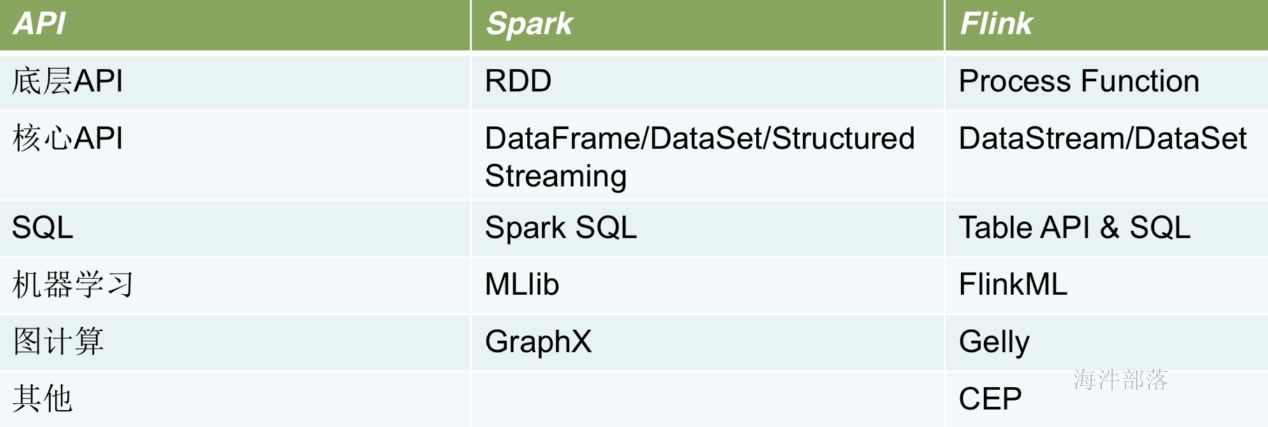

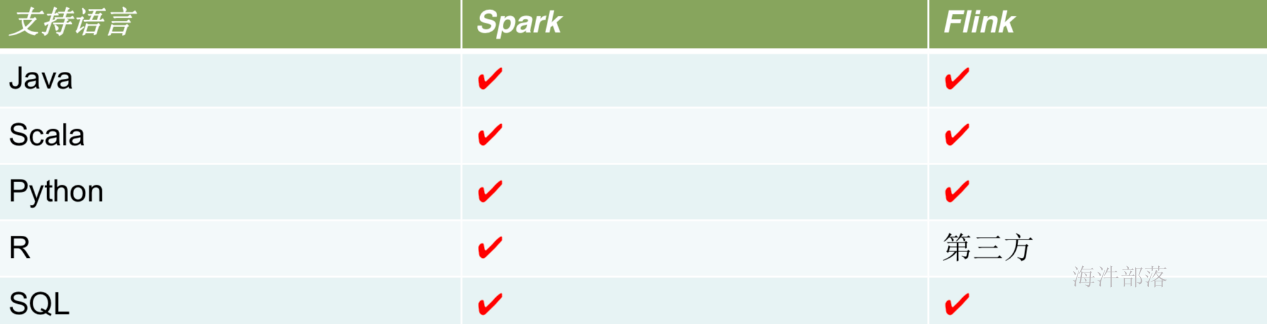

API对比

数据源对比

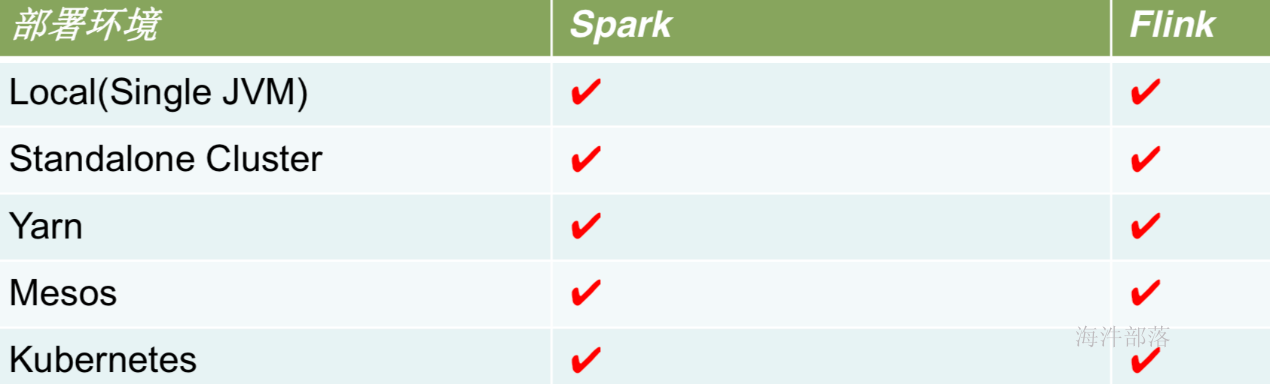

运行环境对比

社区对比

Spark 社区在规模和活跃程度上都是领先的,毕竟多了几年发展时间,同时背后的商业公司Databricks 由于本土优势使得Spark在美国的影响力明显优于Flink

而且作为一个德国公司,Data Artisans 想在美国扩大影响力要更难一些。不过 Flink 社区也有一批 稳定的支持者,达到了可持续发展的规模。

Spark社区活跃度比Flink高很多。

Flink 的中文社区在

目前spark和flink各有所长,spark基于内存的批量运算,flink高可靠的exactly-once的流式运算

还是那句话看你的应用场景是什么,从而选择哪个更适合

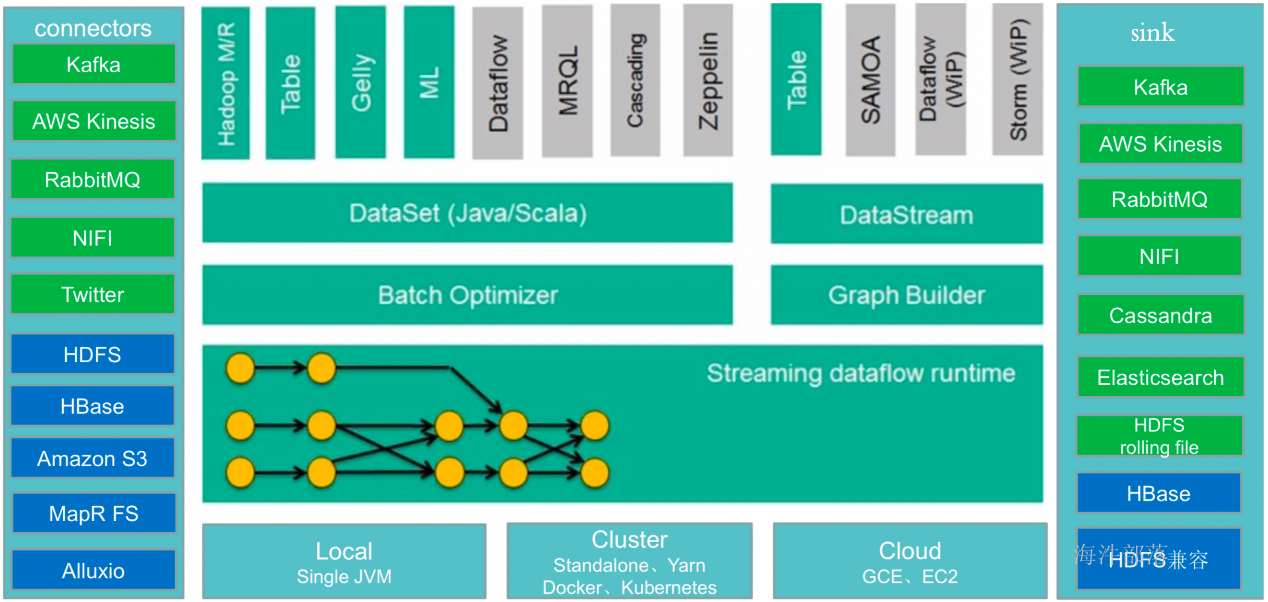

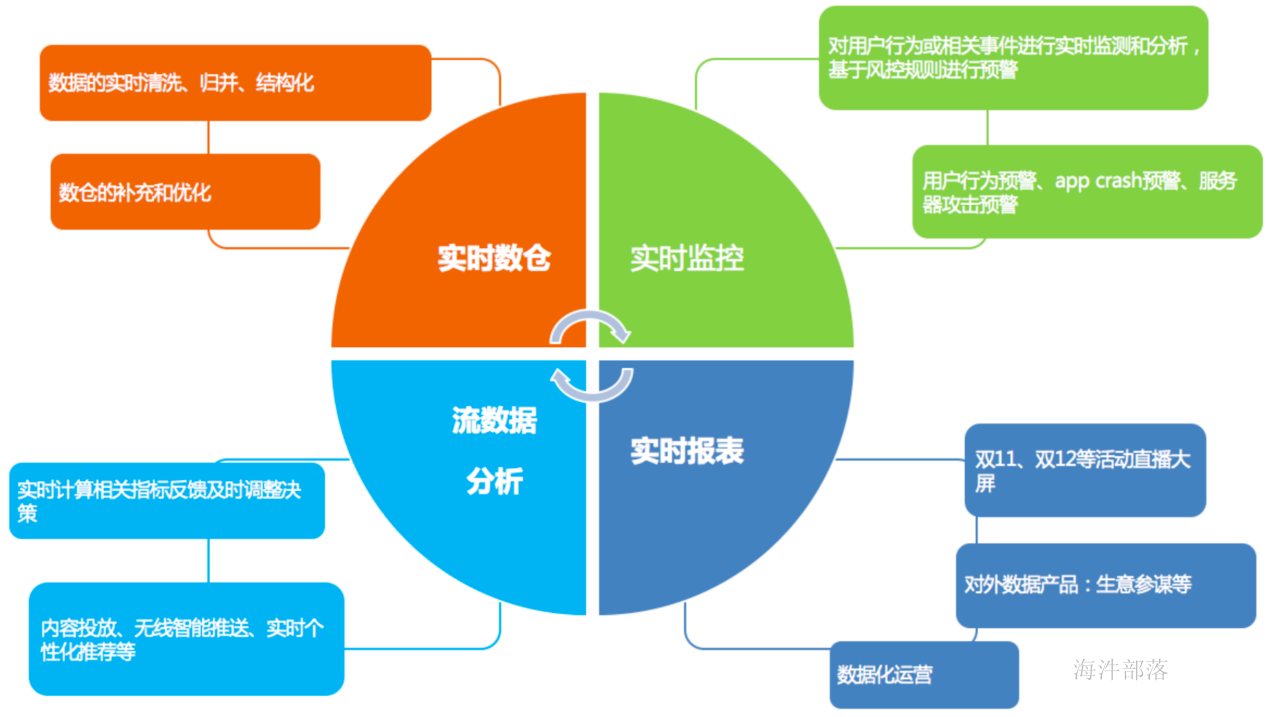

8.Flink生态

9.Flink应用场景

10.Flink的未来

- 批计算的突破、流处理和批处理无缝切换、界限越来越模糊、甚至混合

- Flink-SQL

- 完善Machine Learning 算法库,同时 Flink 也会向更成熟的机器学习、深度学习去集成(比如Tensorflow On Flink)

2.Flink的Standalone和YARN模式安装、Standalone和YARN模式的HA

1.Flink生态之核心组件

2.flink的主要运行方式有

- Local:适用于开发

- Standalone:分布式,适用于生产环境

- On YARN:分布式,适用于生产环境(推荐)

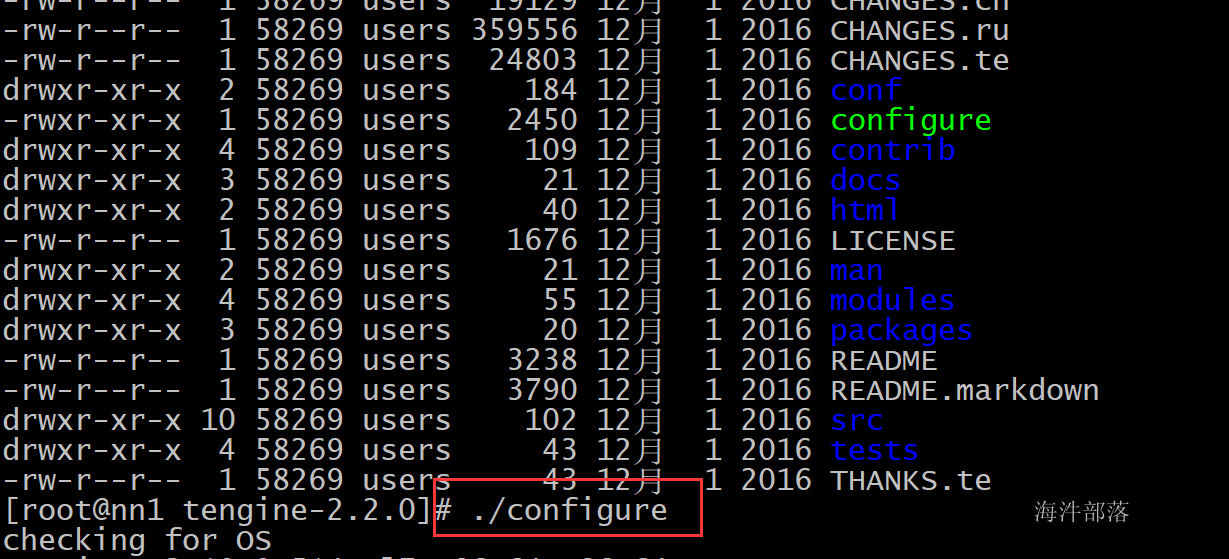

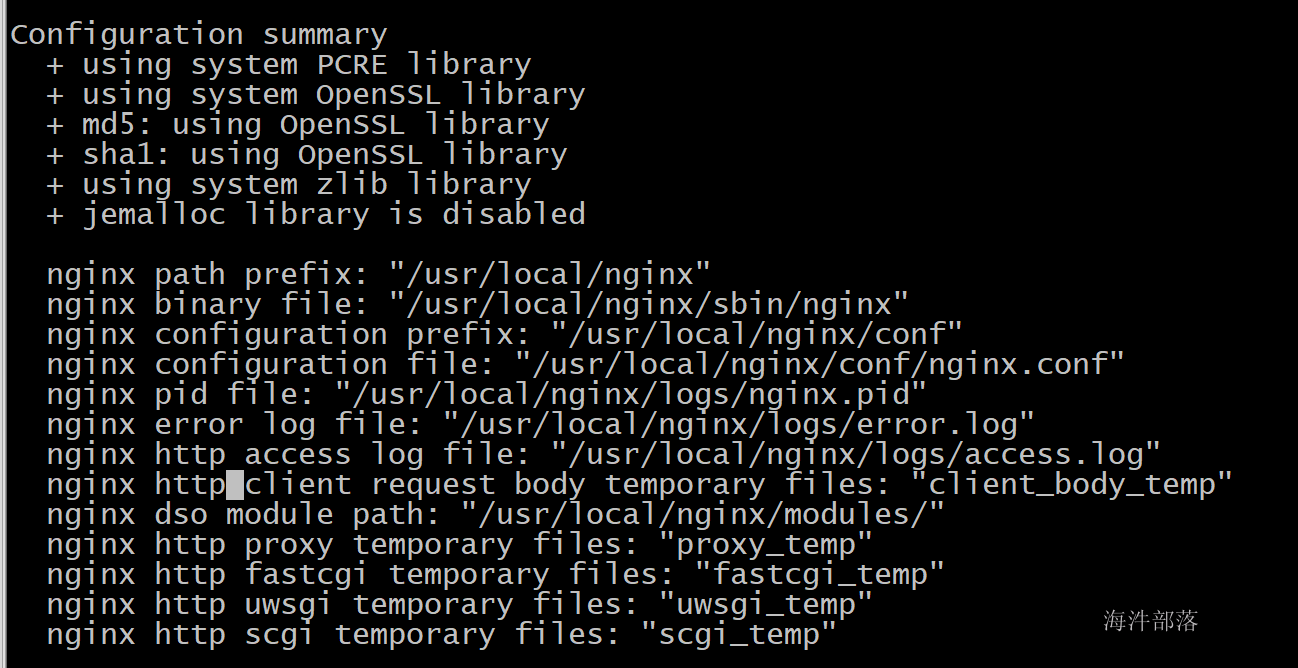

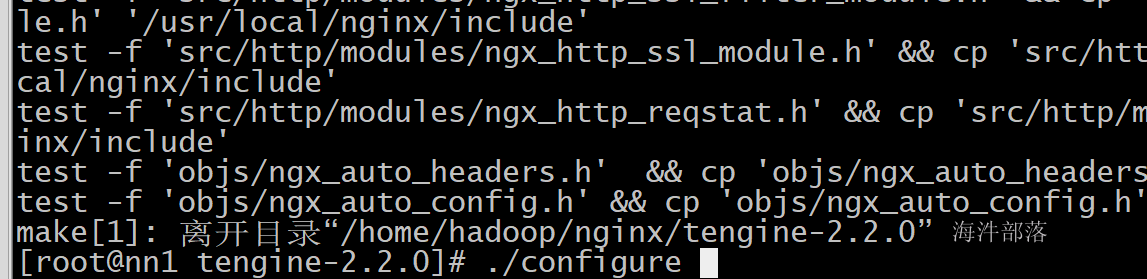

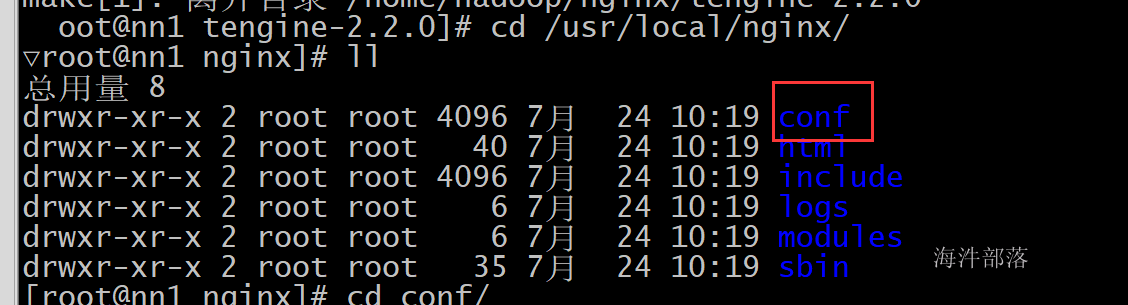

3.Standalone集群模式安装

Linux,CentOS 6/7

安装JDK

下载 flink 安装包

https://flink.apache.org/downloads.html

非高可用安装:

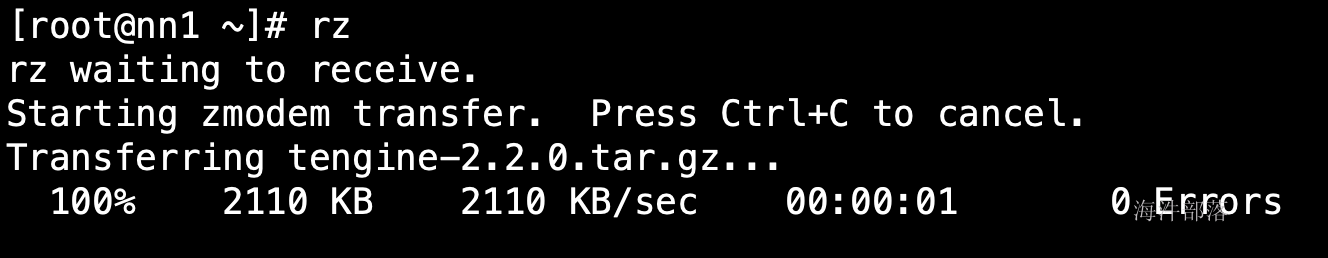

1.上传压缩包

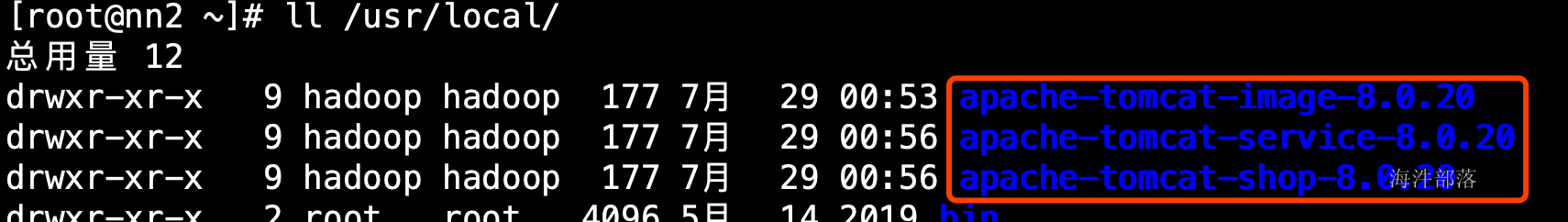

2.分发到每个机器上

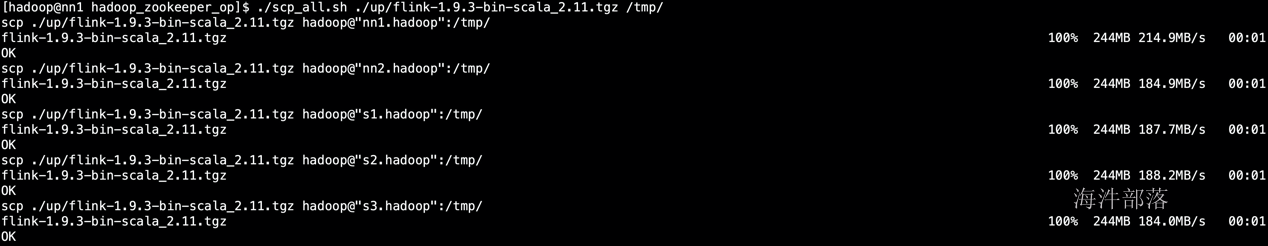

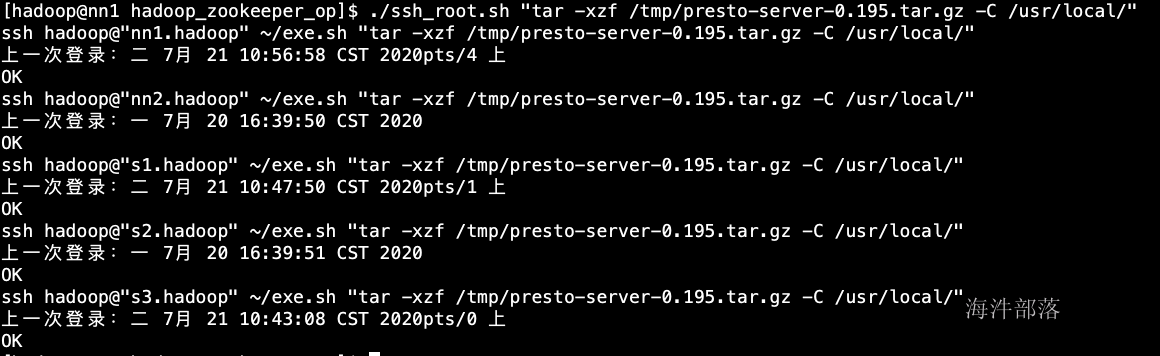

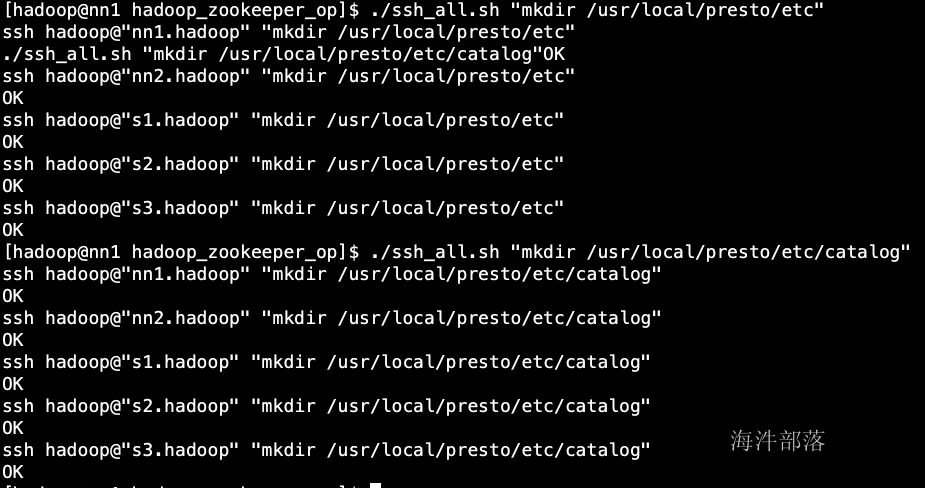

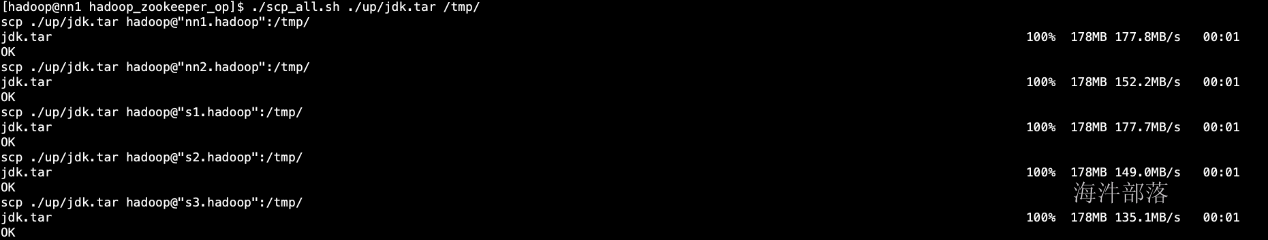

./scp_all.sh ./up/flink-1.9.3-bin-scala_2.11.tgz /tmp/

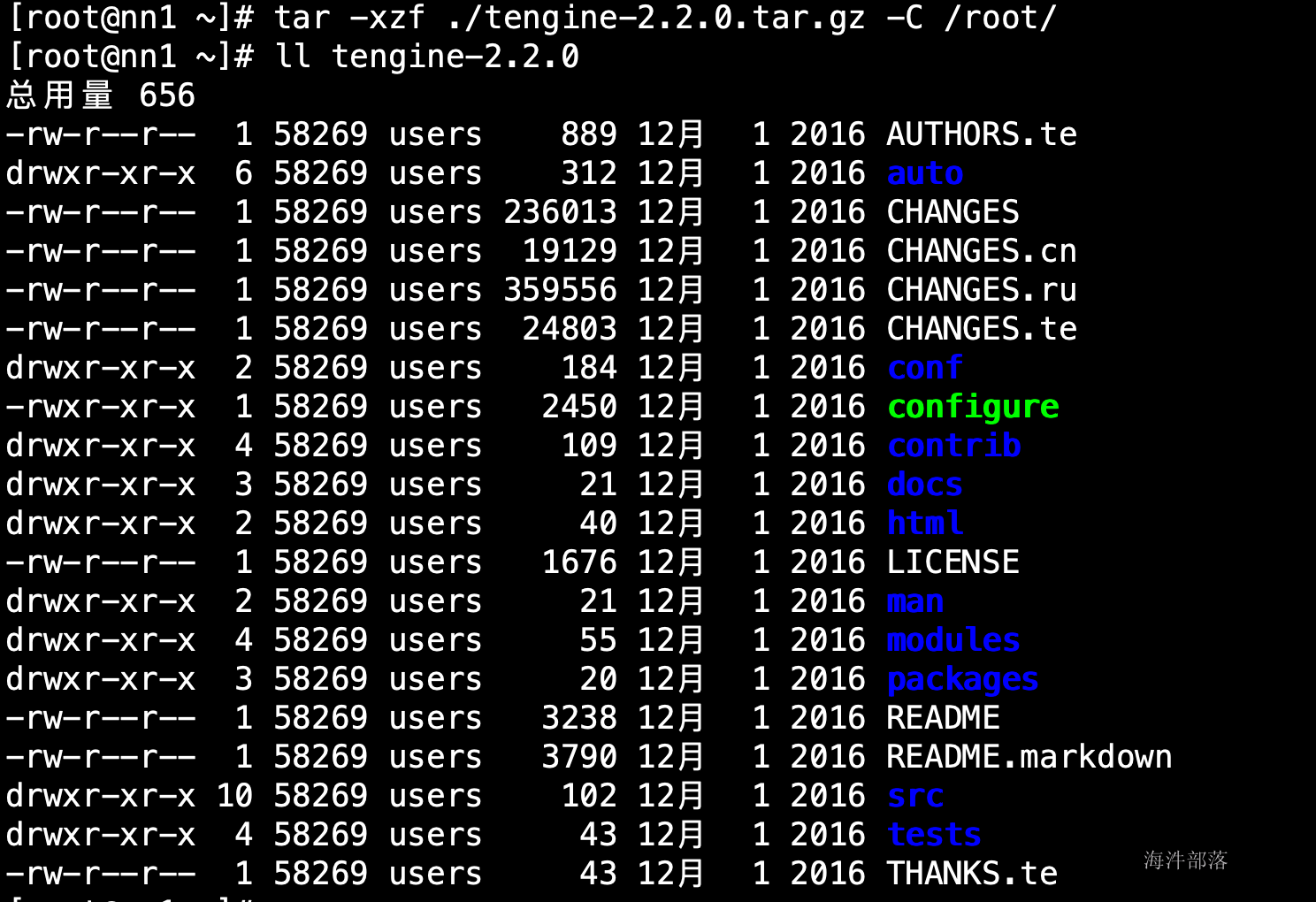

3.解压到/usr/local目录下

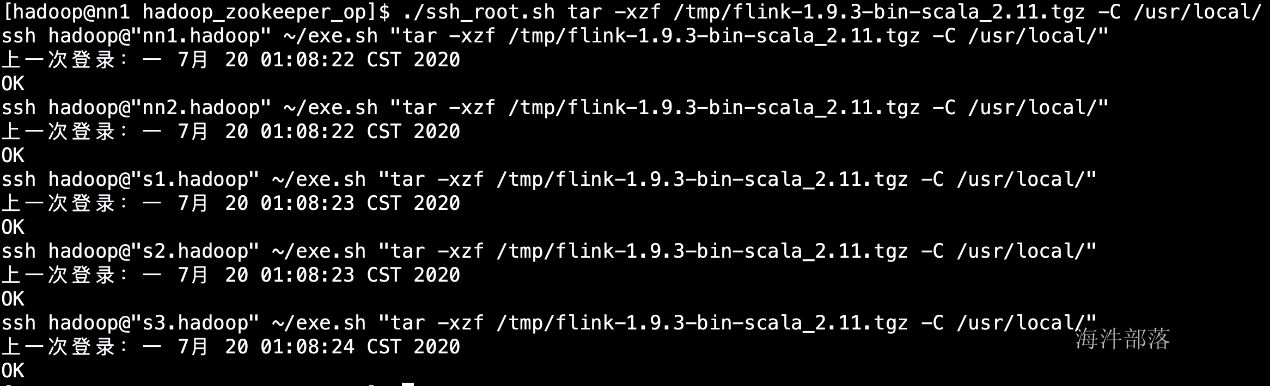

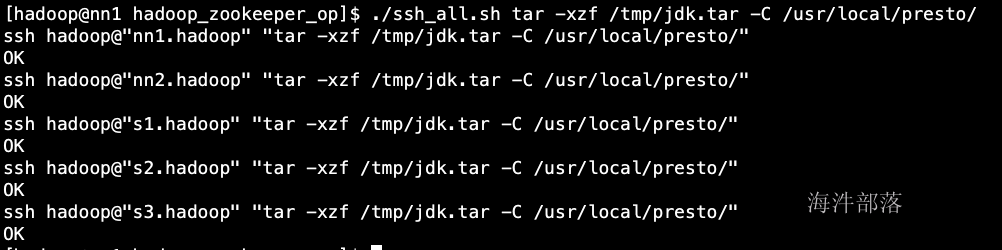

./ssh_root.sh tar -xzf /tmp/flink-1.9.3-bin-scala_2.11.tgz -C /usr/local/

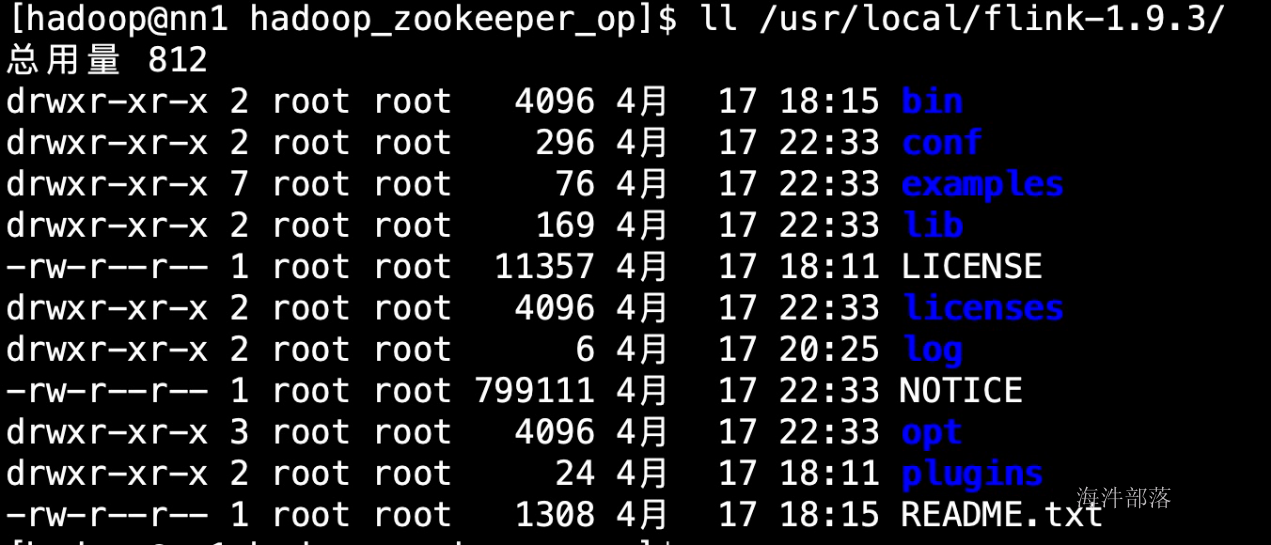

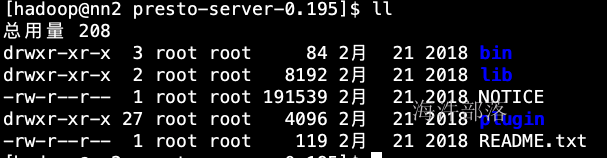

目录说明:

- bin:可执行脚本

- conf:配置文件目录

- examples:测试样例

- lib:依赖jar

- opt:扩展依赖jar

- log:日志

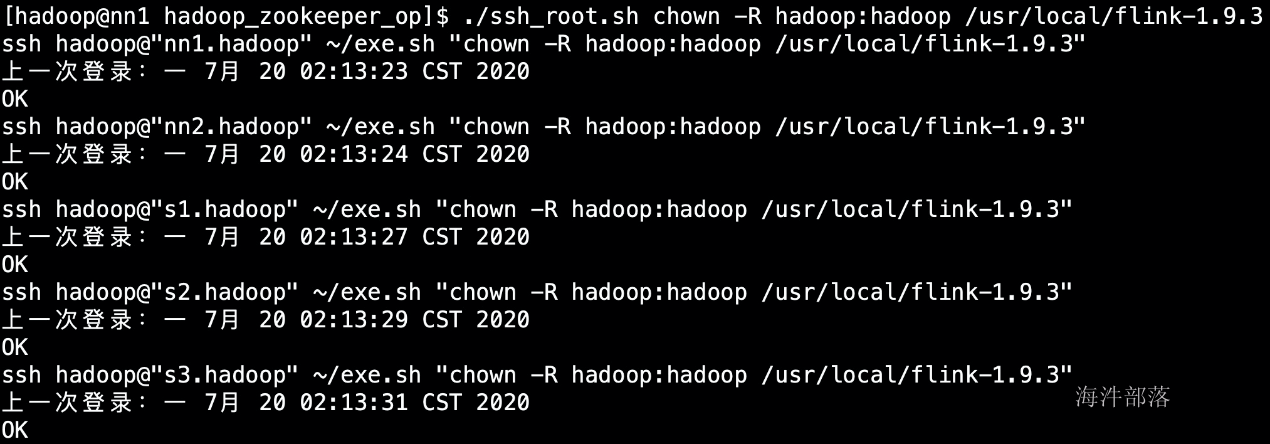

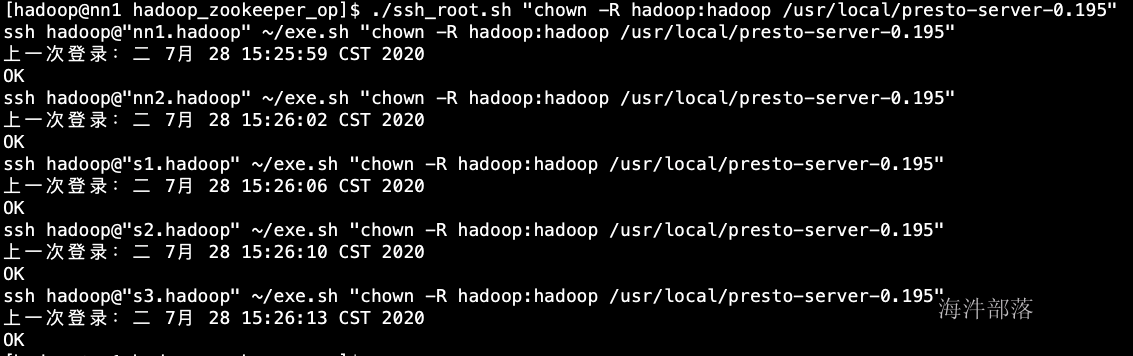

4.修改权限为hadoop

./ssh_root.sh chown -R hadoop:hadoop /usr/local/flink-1.9.3

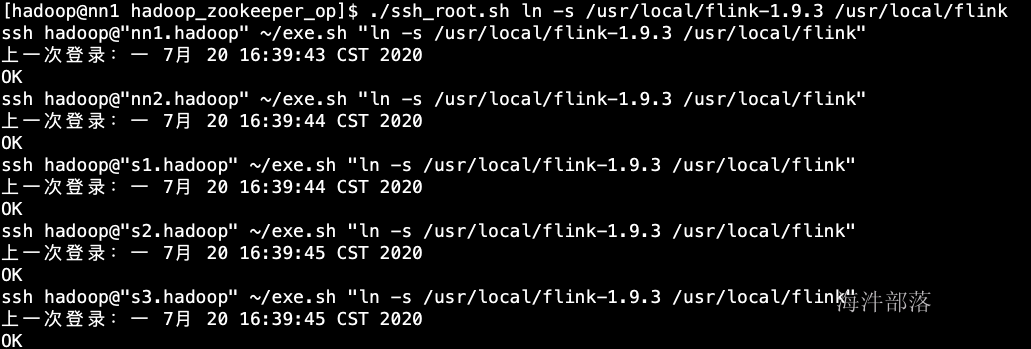

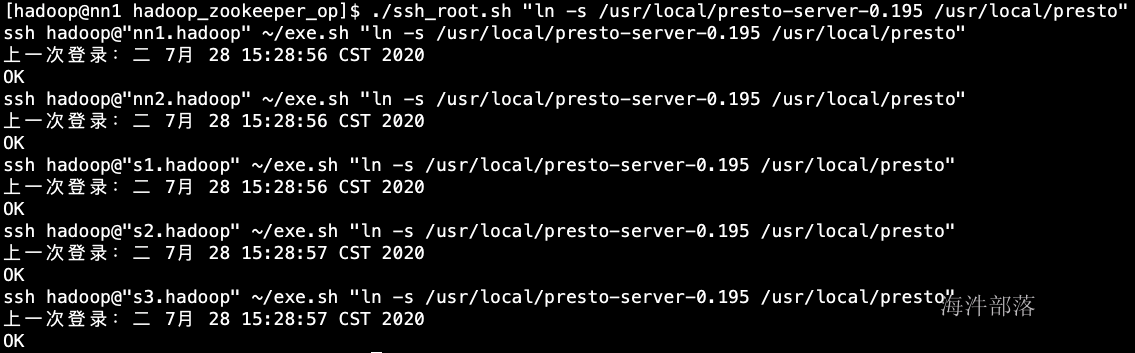

5.创建软件链接

./ssh_root.sh ln -s /usr/local/flink-1.9.3 /usr/local/flink

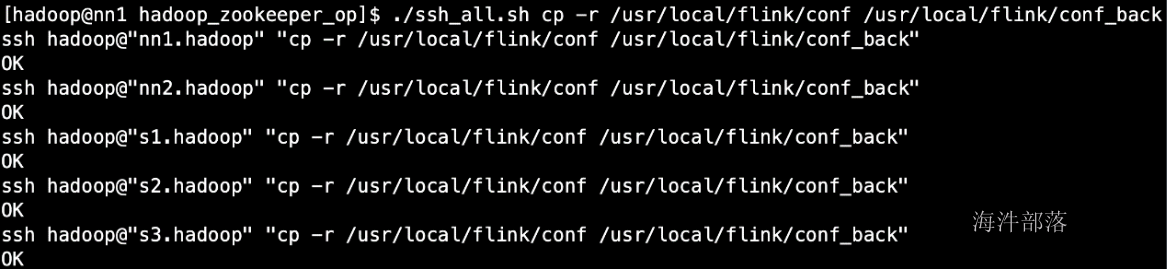

6.备份原有配置

./ssh_all.sh cp -r /usr/local/flink/conf /usr/local/flink/conf_back

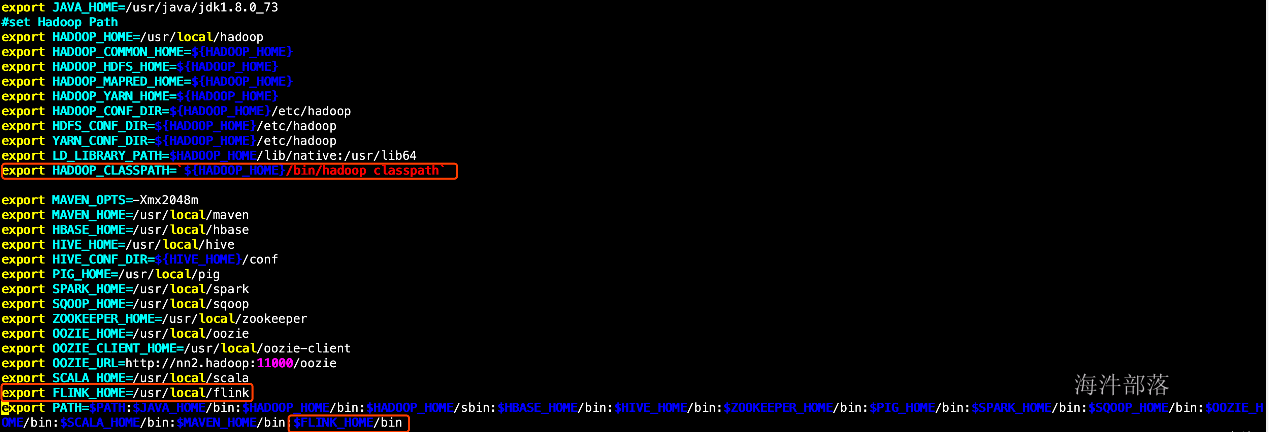

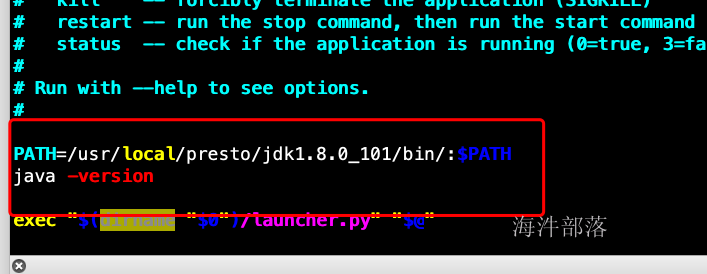

7.在每个机器上增加FLINK_HOME环境变量,之后source一下

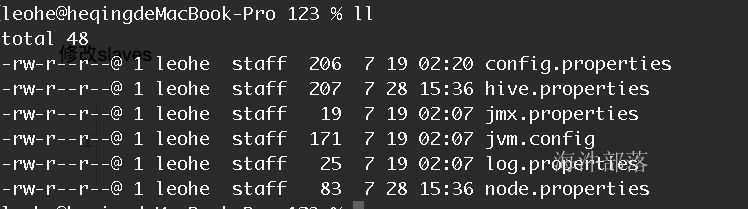

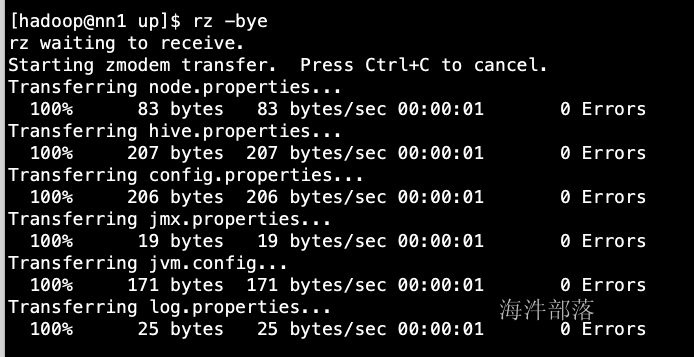

8.修改配置(conf目录下)

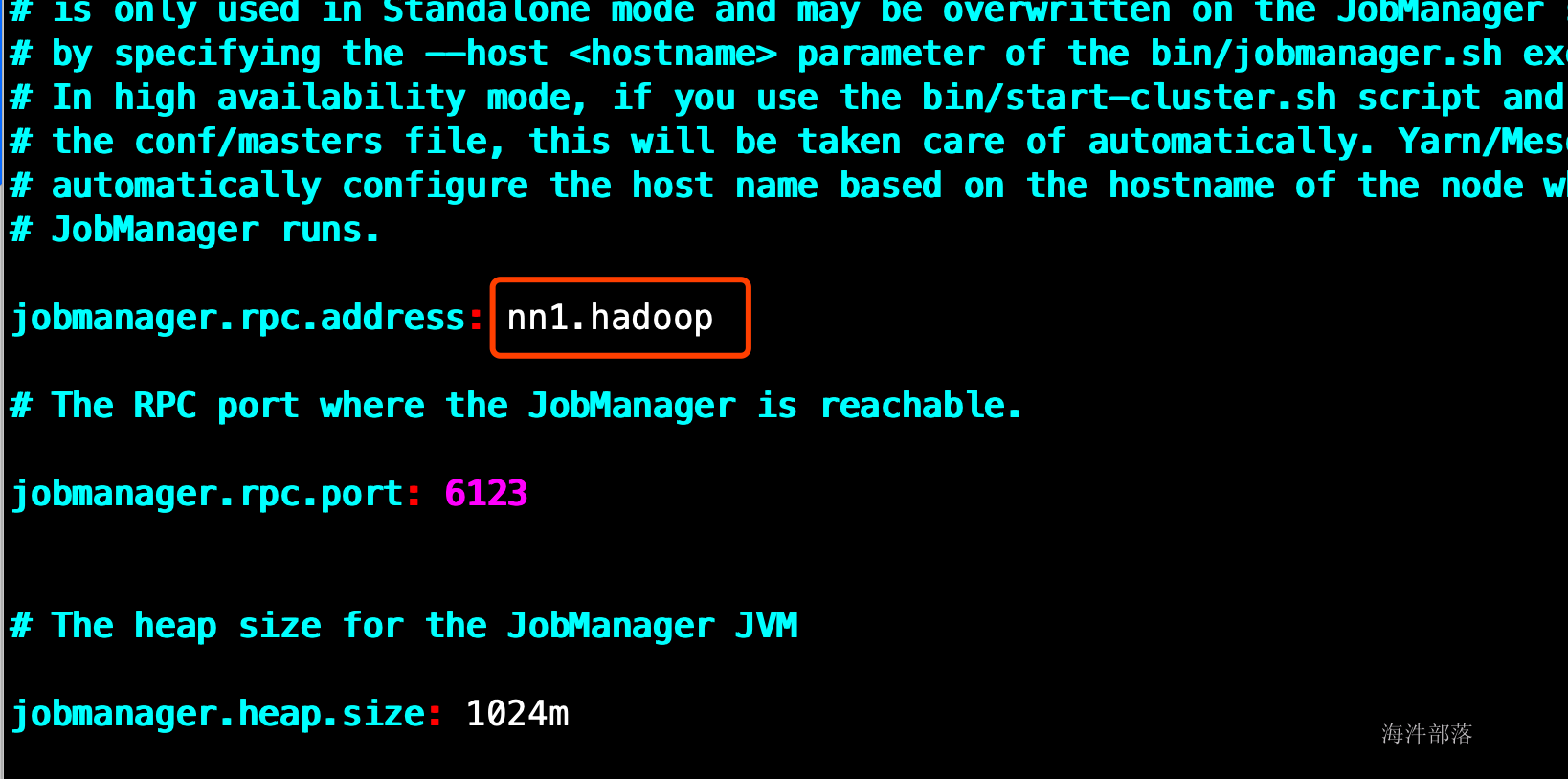

修改flink-conf.yaml

vim /usr/local/flink/conf/flink-conf.yaml

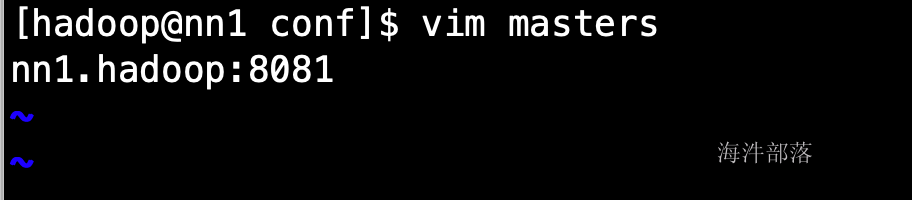

修改master

vim /usr/local/flink/conf/masters

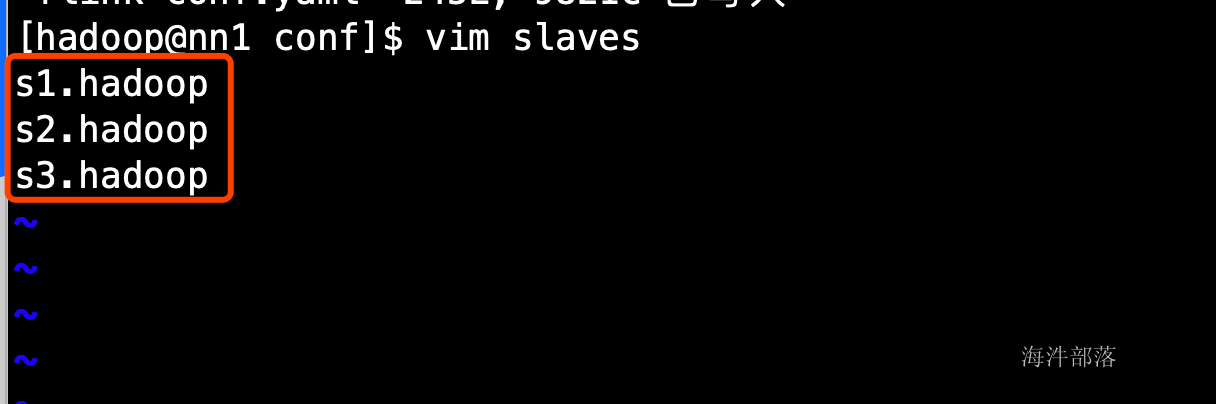

修改slaves

vim /usr/local/flink/conf/slaves

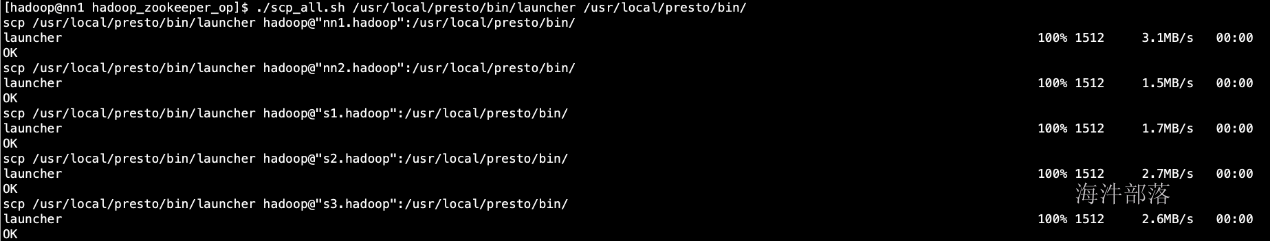

分发修改配置

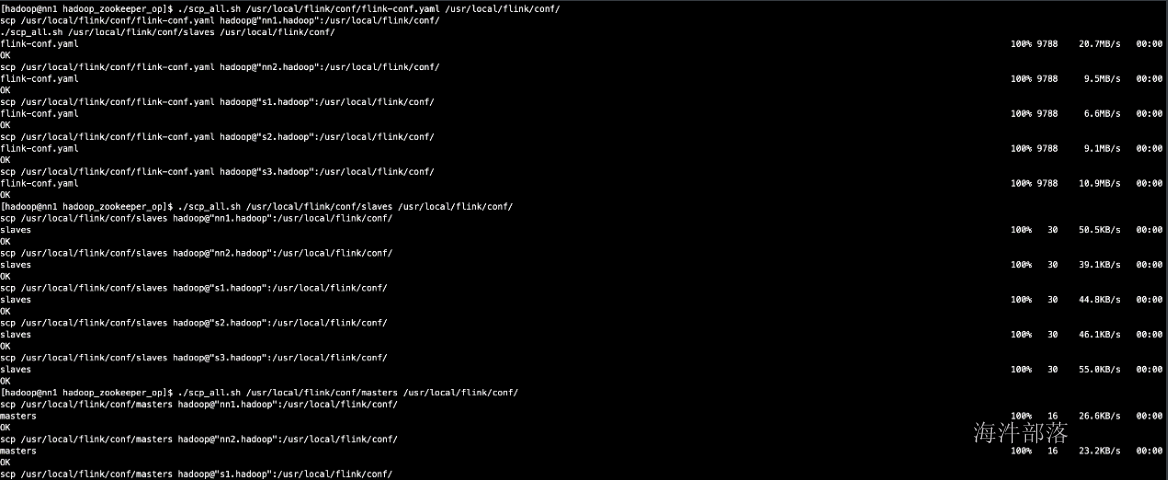

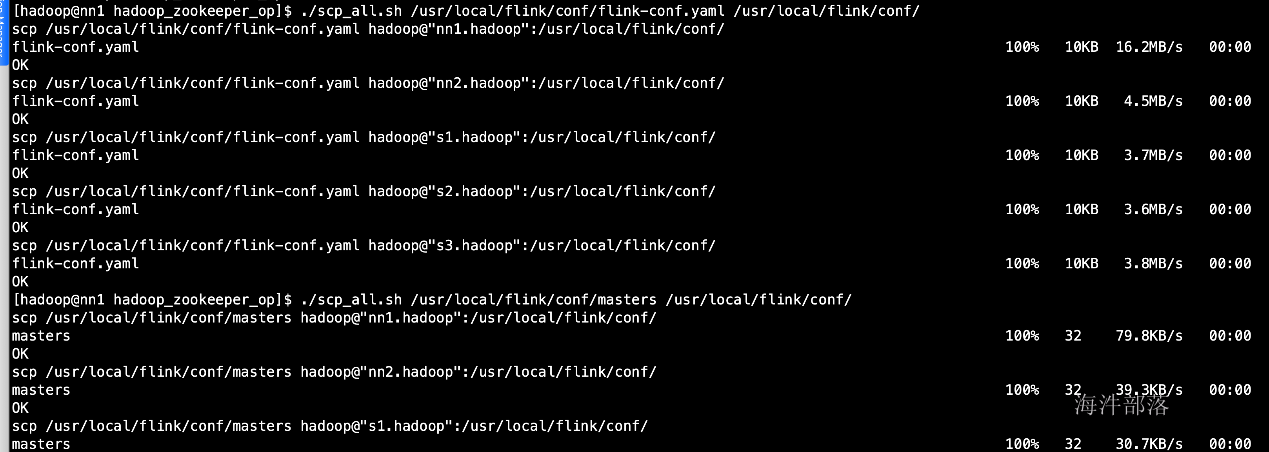

./scp_all.sh /usr/local/flink/conf/flink-conf.yaml /usr/local/flink/conf/

./scp_all.sh /usr/local/flink/conf/slaves /usr/local/flink/conf/

./scp_all.sh /usr/local/flink/conf/masters /usr/local/flink/conf/

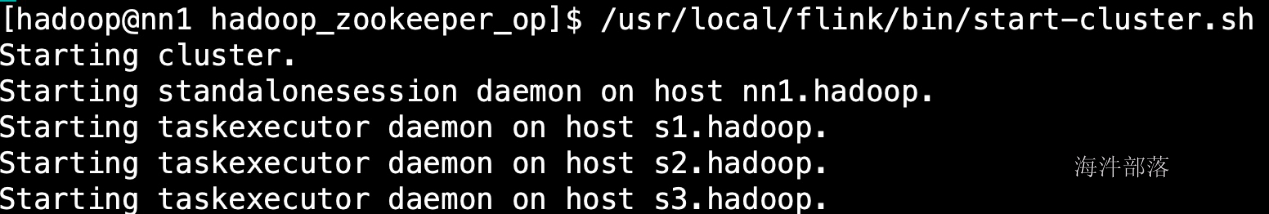

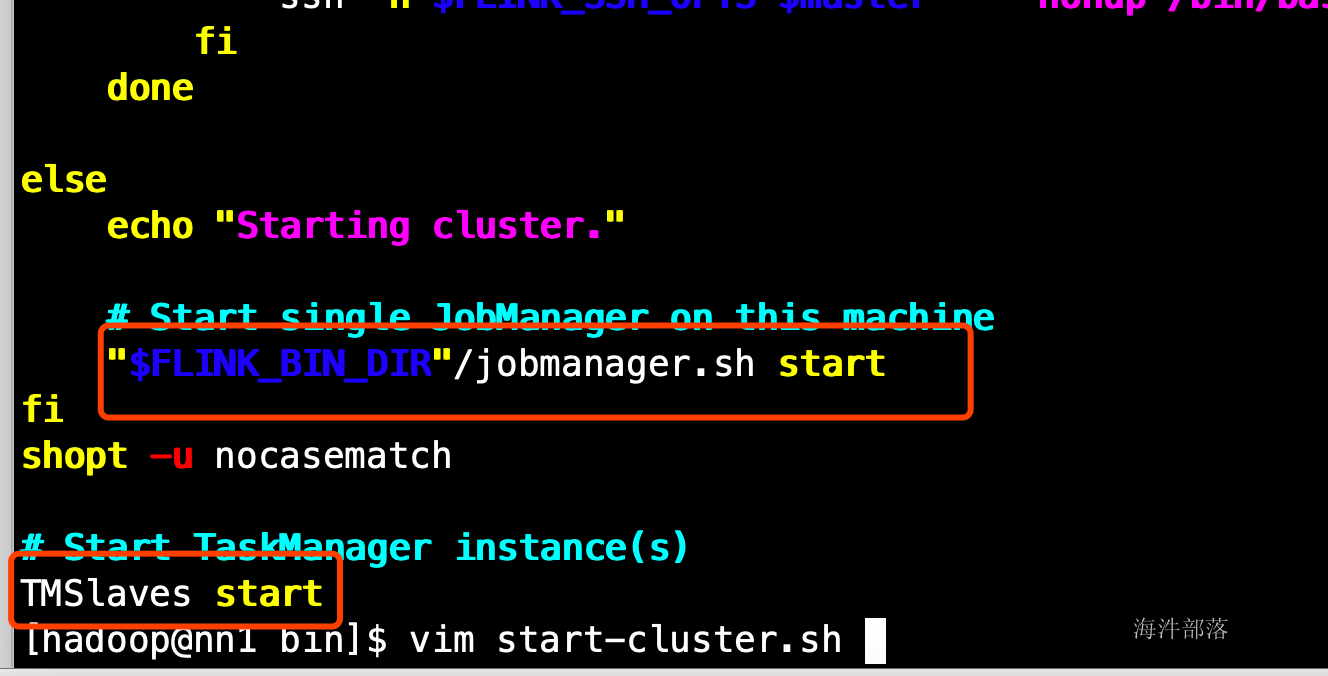

9.启动

/usr/local/flink/bin/start-cluster.sh

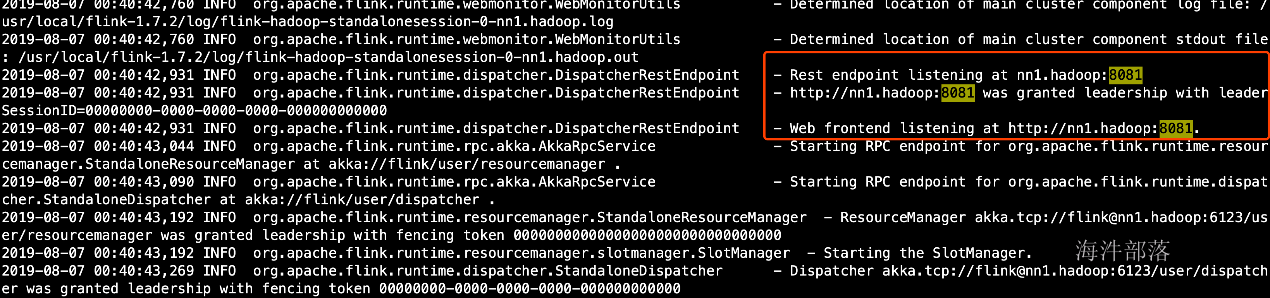

启动日志

vim /usr/local/flink/log/flink-hadoop-standalonesession-0-nn1.hadoop.log

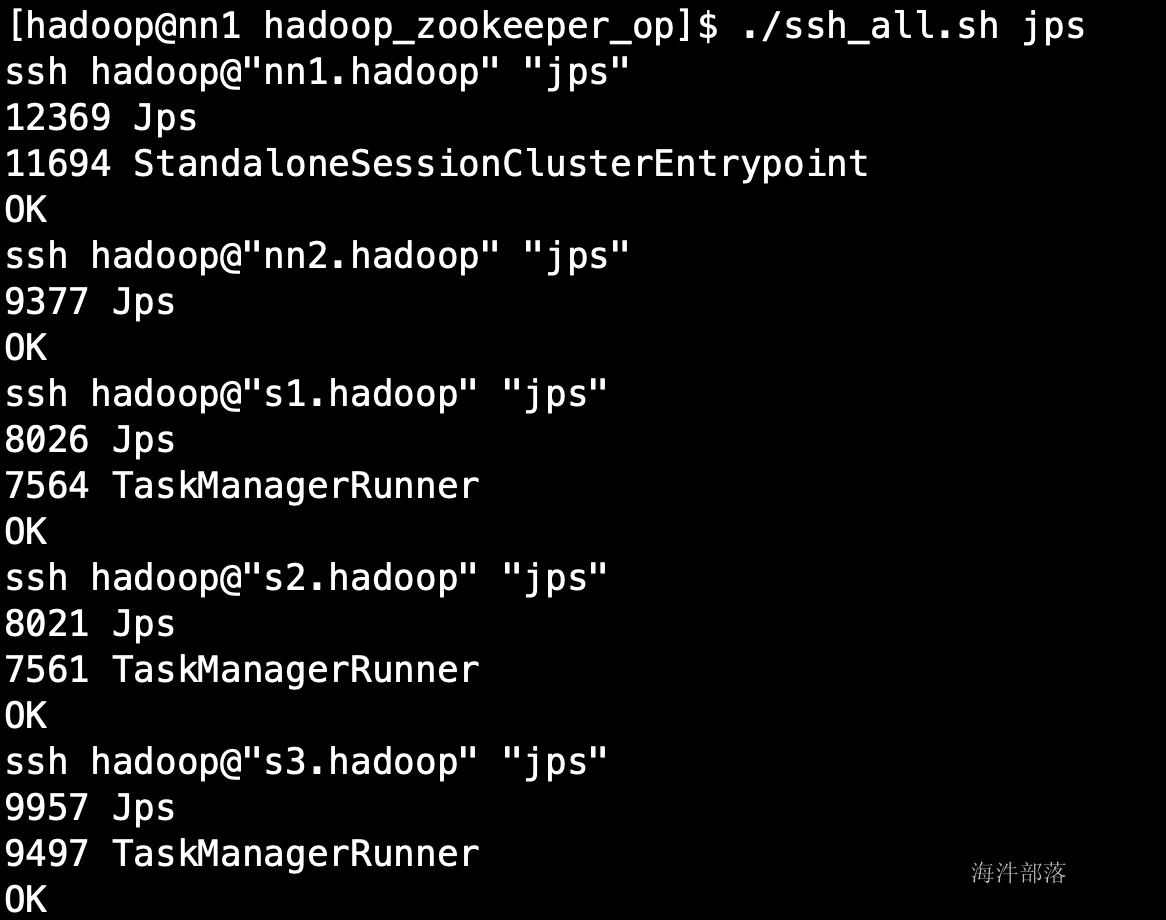

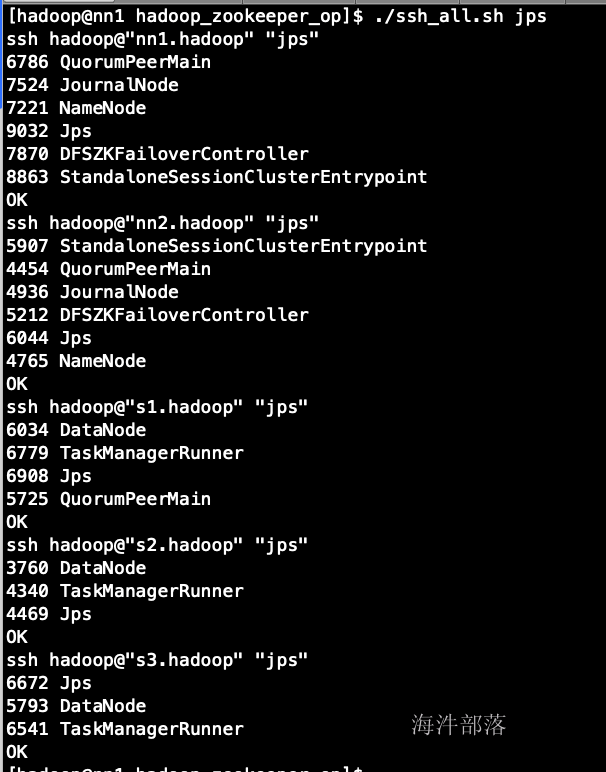

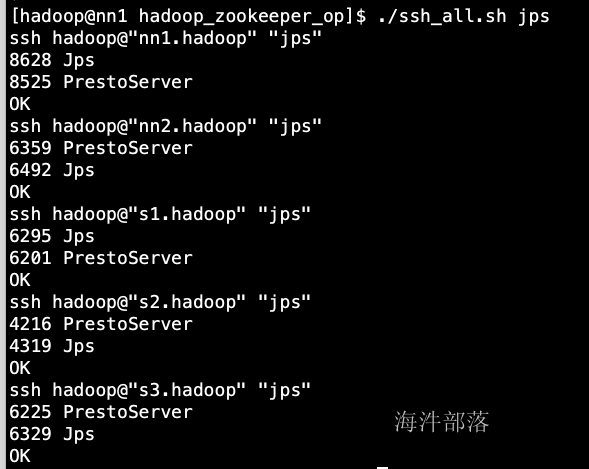

启动flink之后各机器上的进程

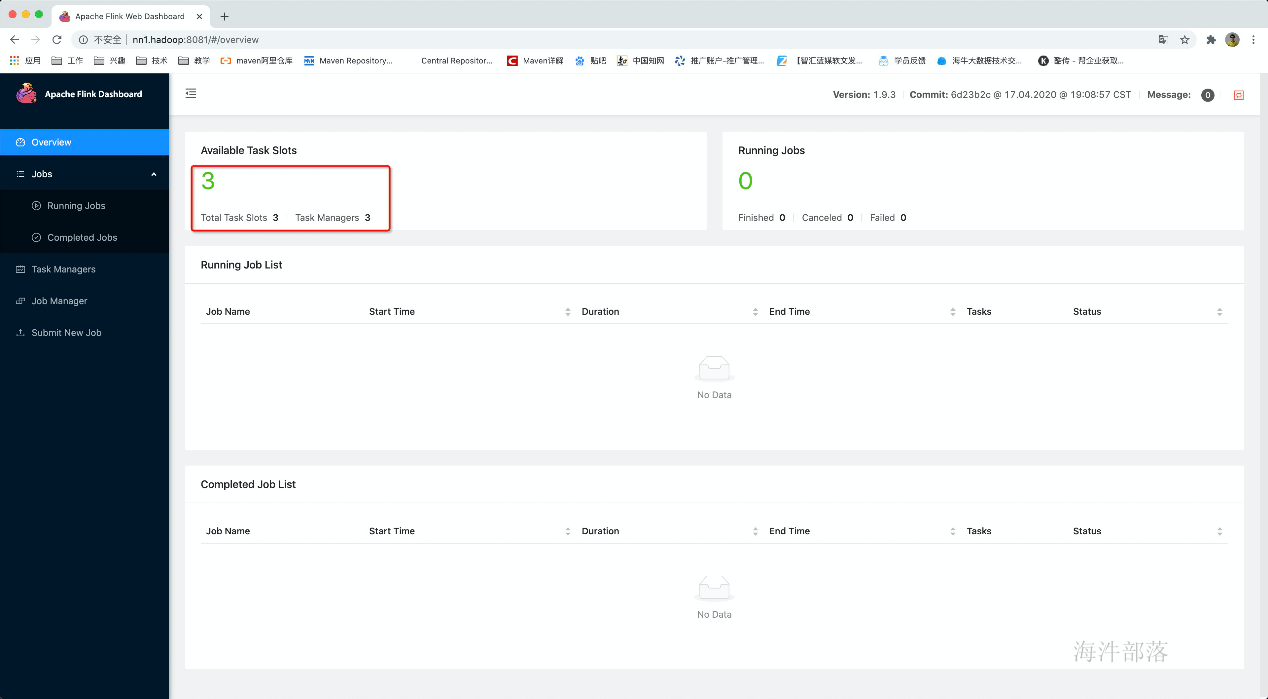

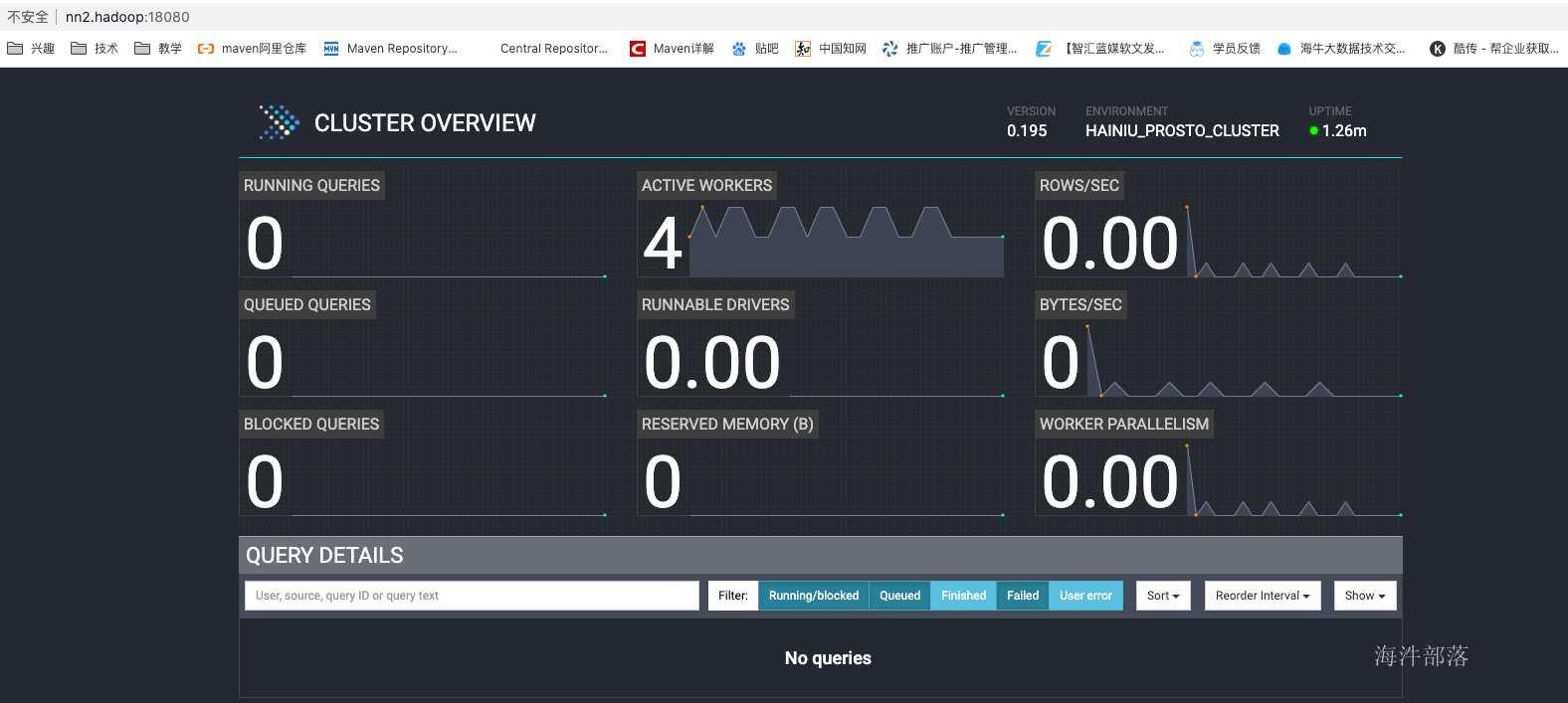

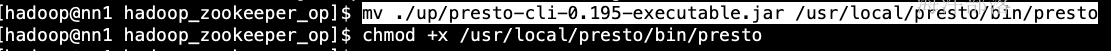

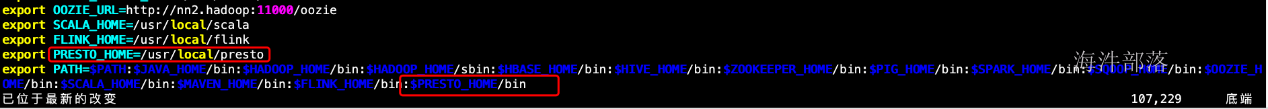

jobManager界面

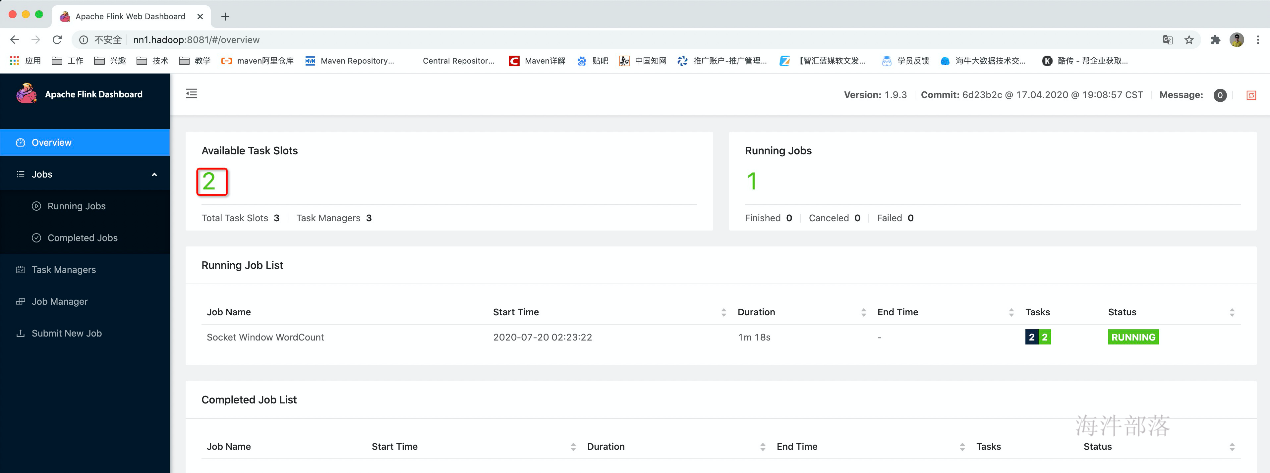

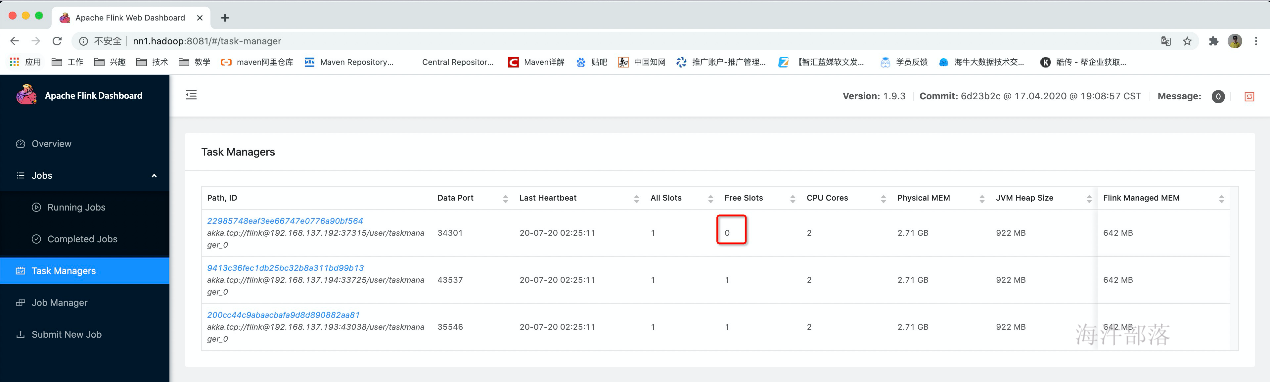

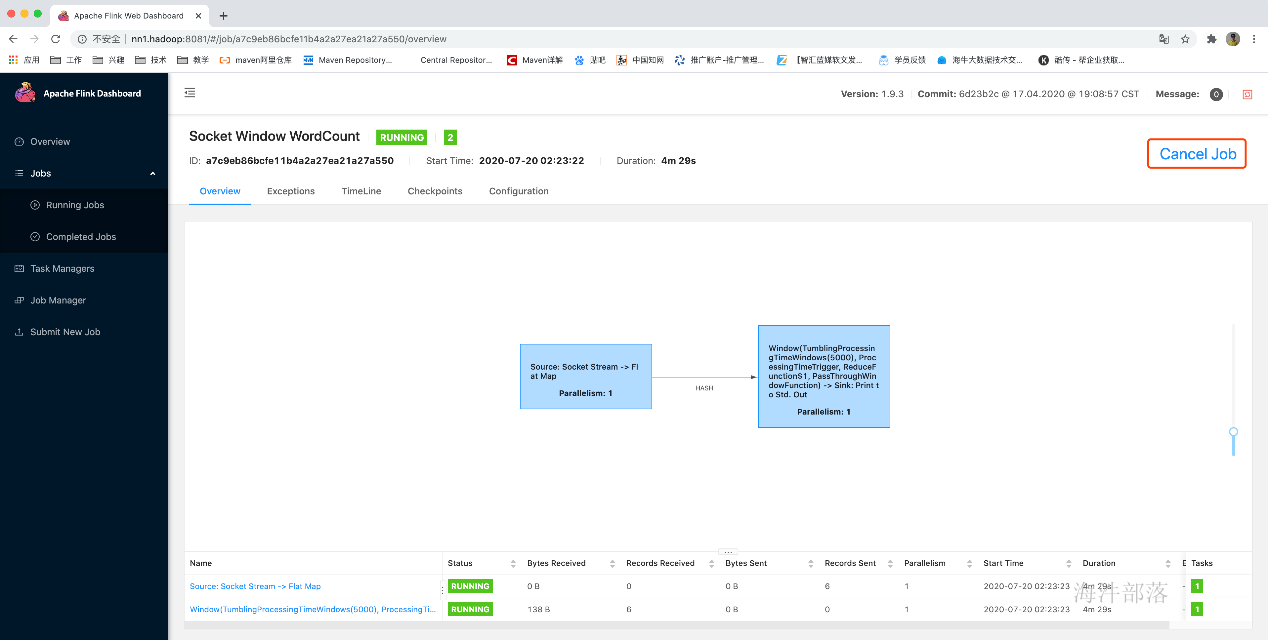

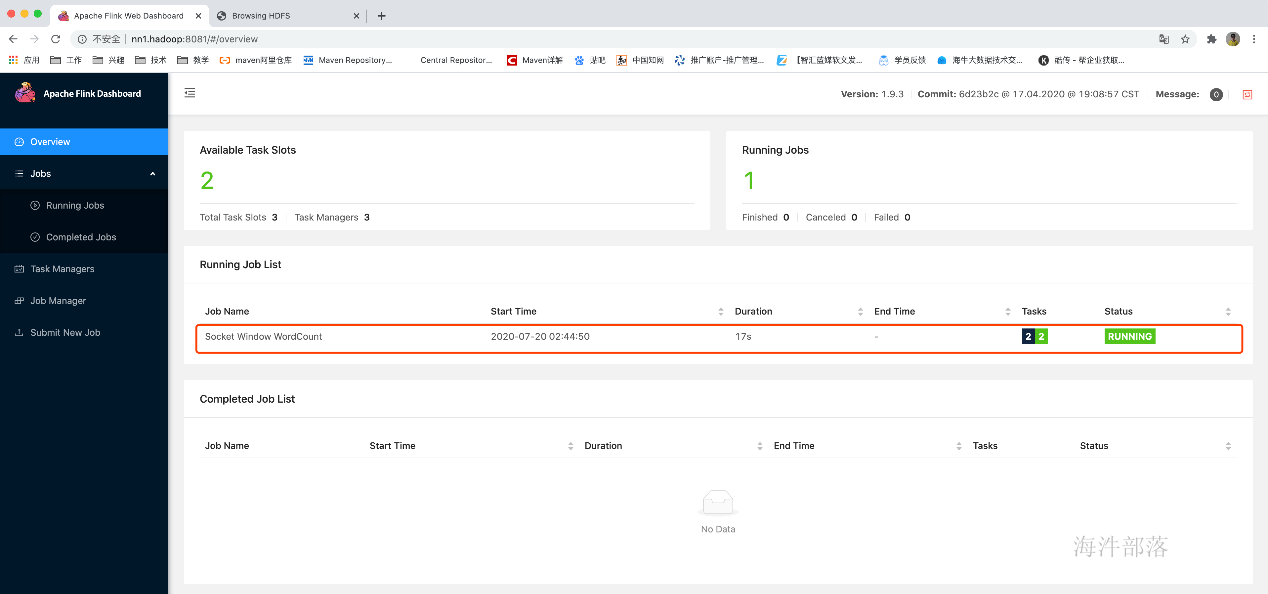

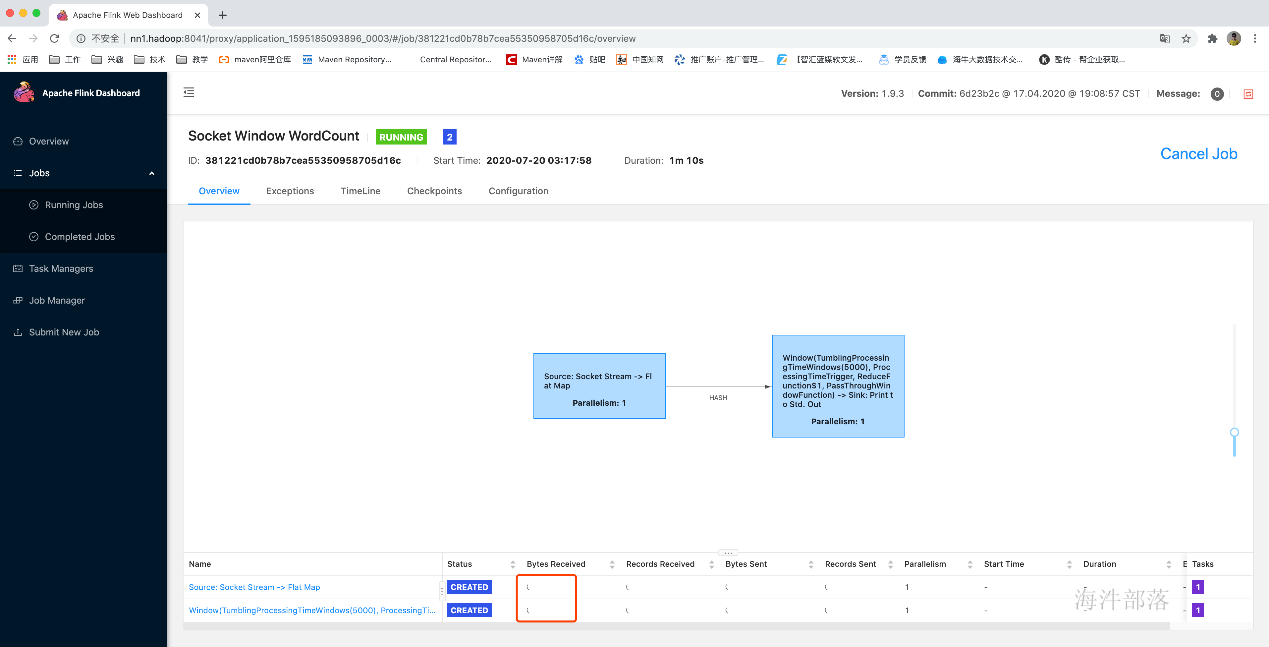

10.测试一下

功能是一个streaming版的WordCount

首先在nn1启动socketServer

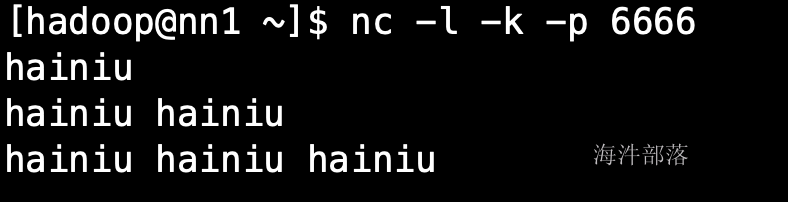

nc -l -k -p 6666

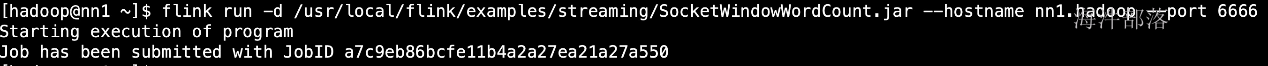

提交任务

flink run -d /usr/local/flink/examples/streaming/SocketWindowWordCount.jar --hostname

在nc中输入数据:

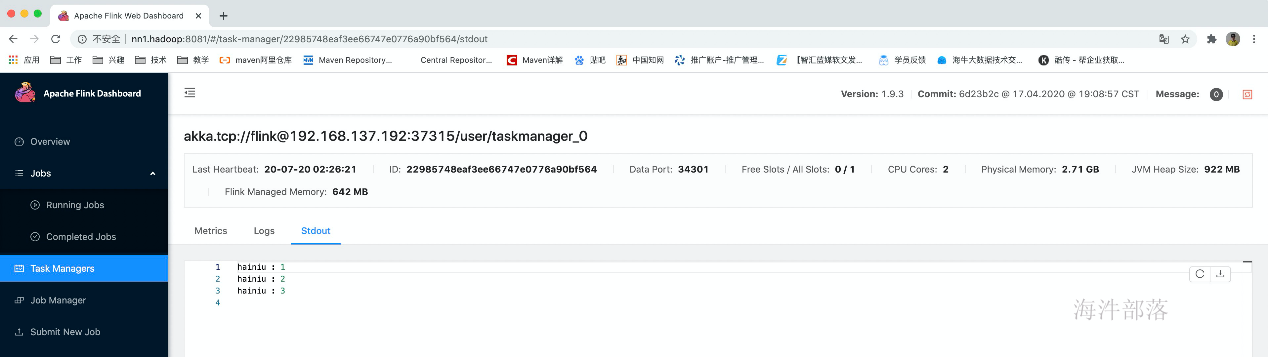

由于任务是在tm中运行,所以数据被打印到tm中

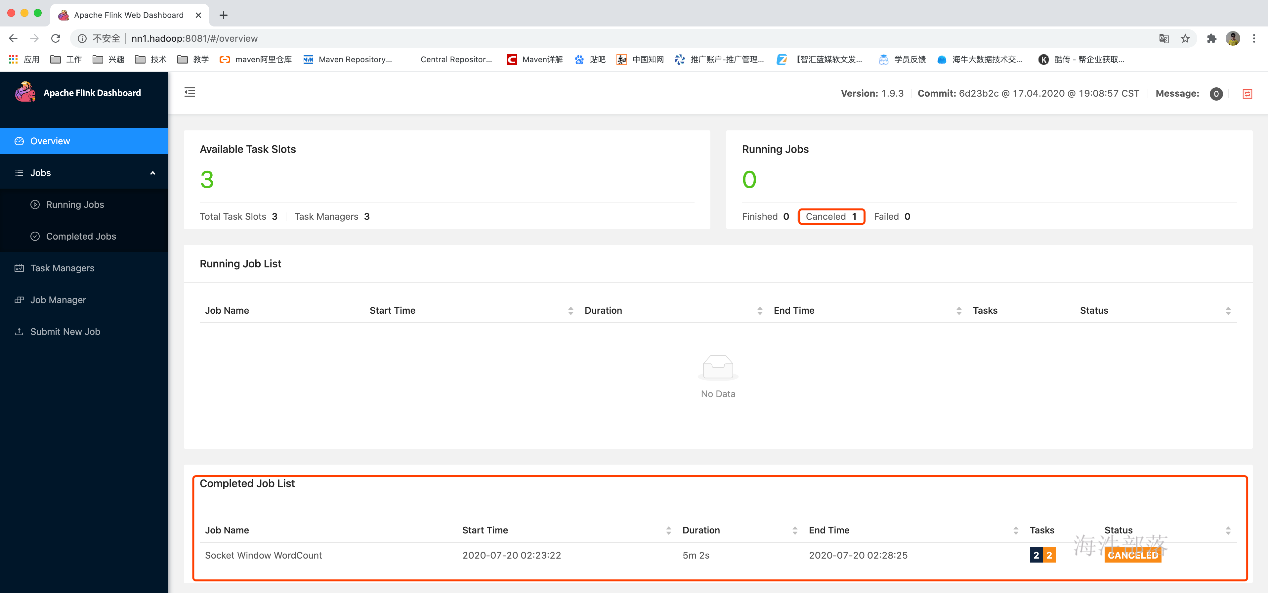

终止任务运行

11.关闭集群

stop-cluster.sh高可用安装:

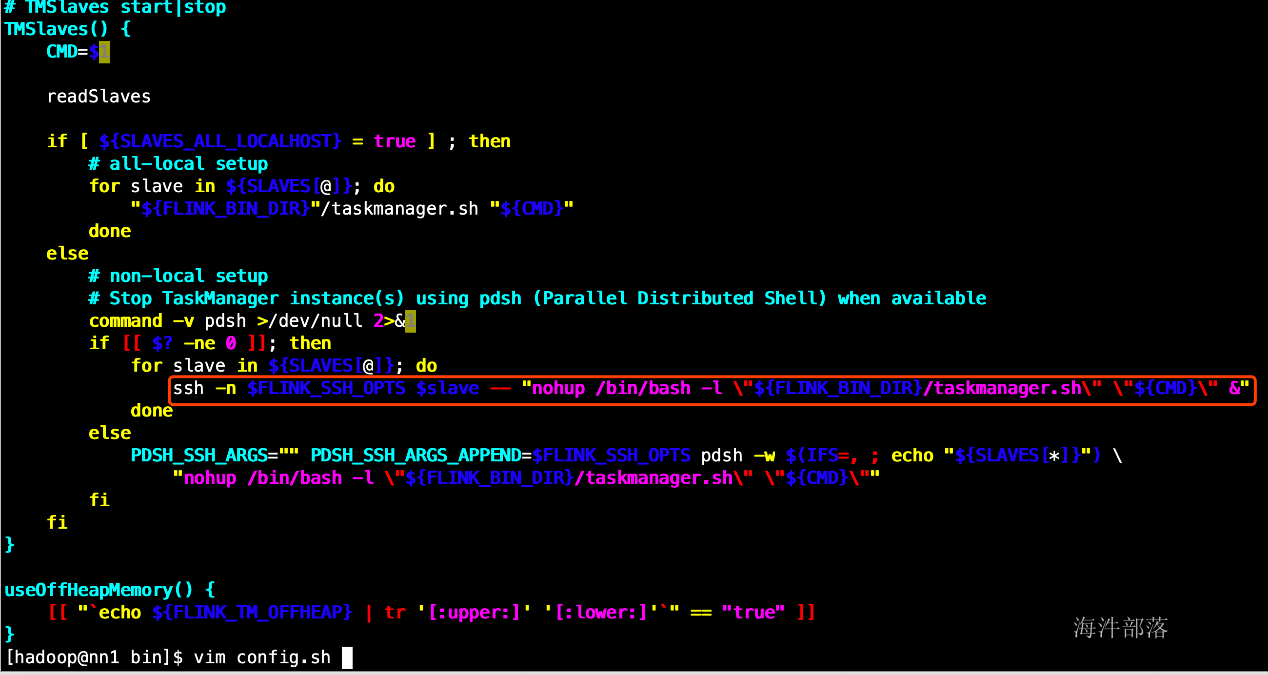

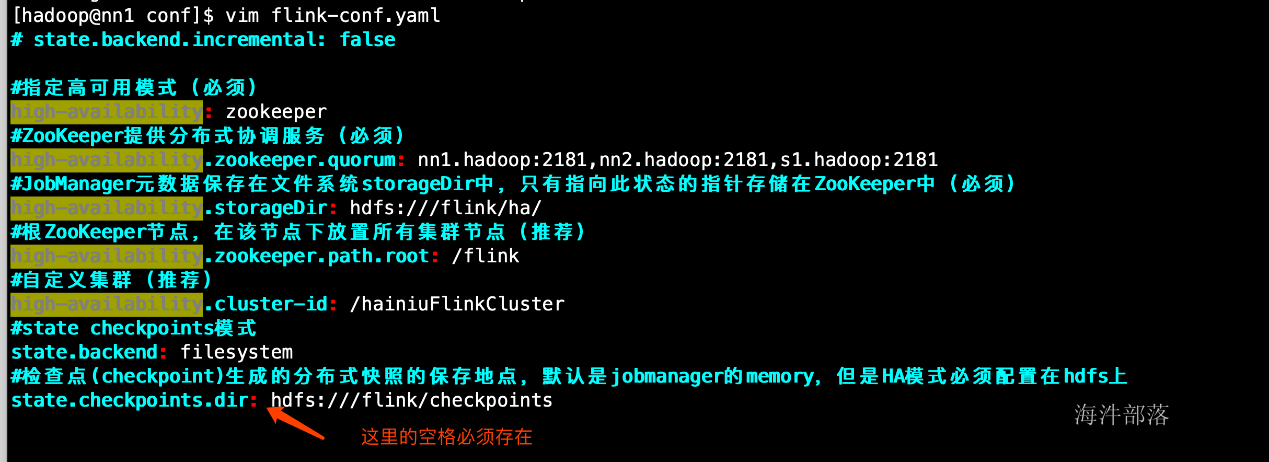

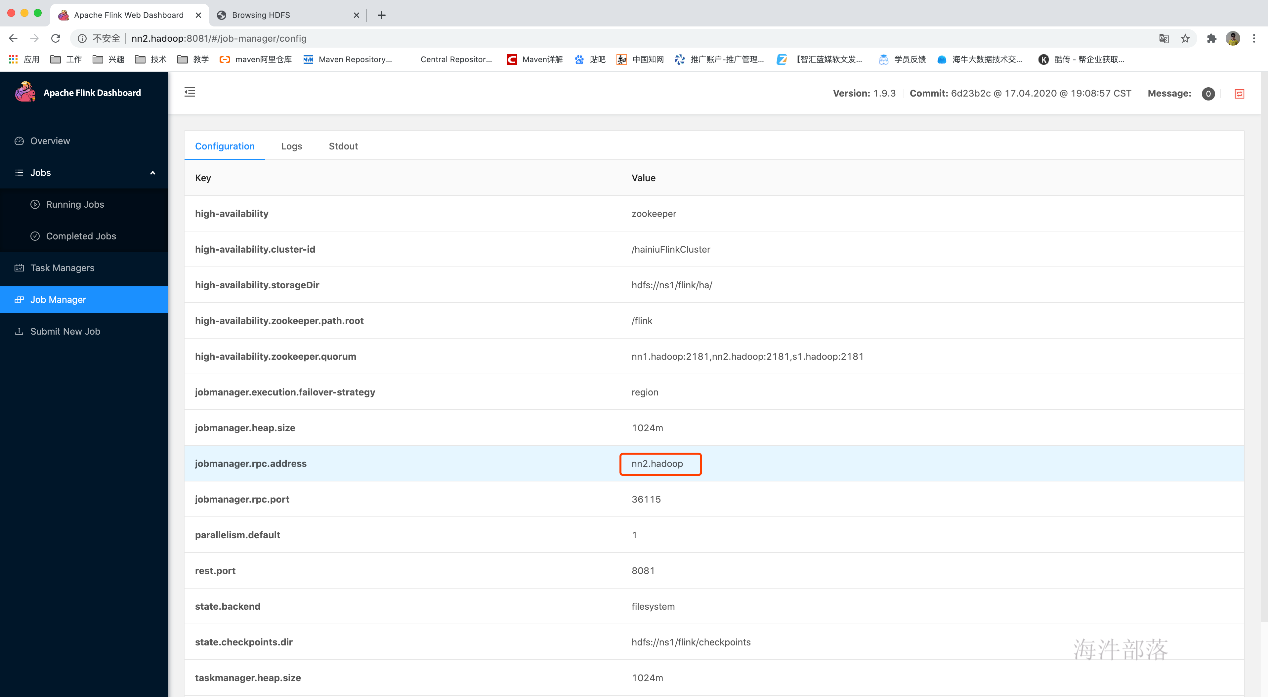

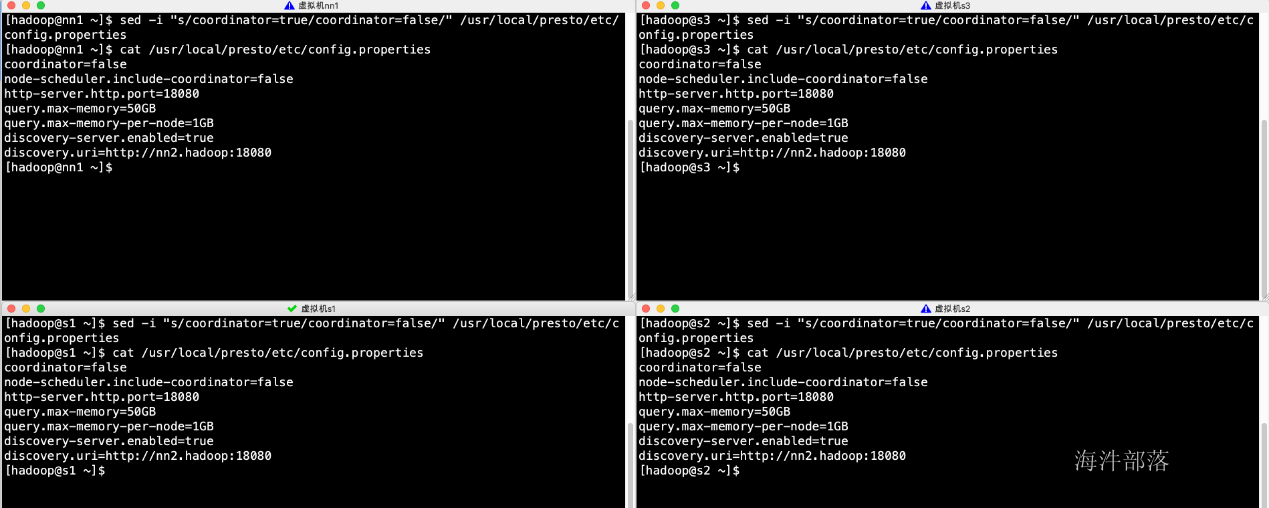

1.修改配置(conf目录下)

修改flink-conf.yaml

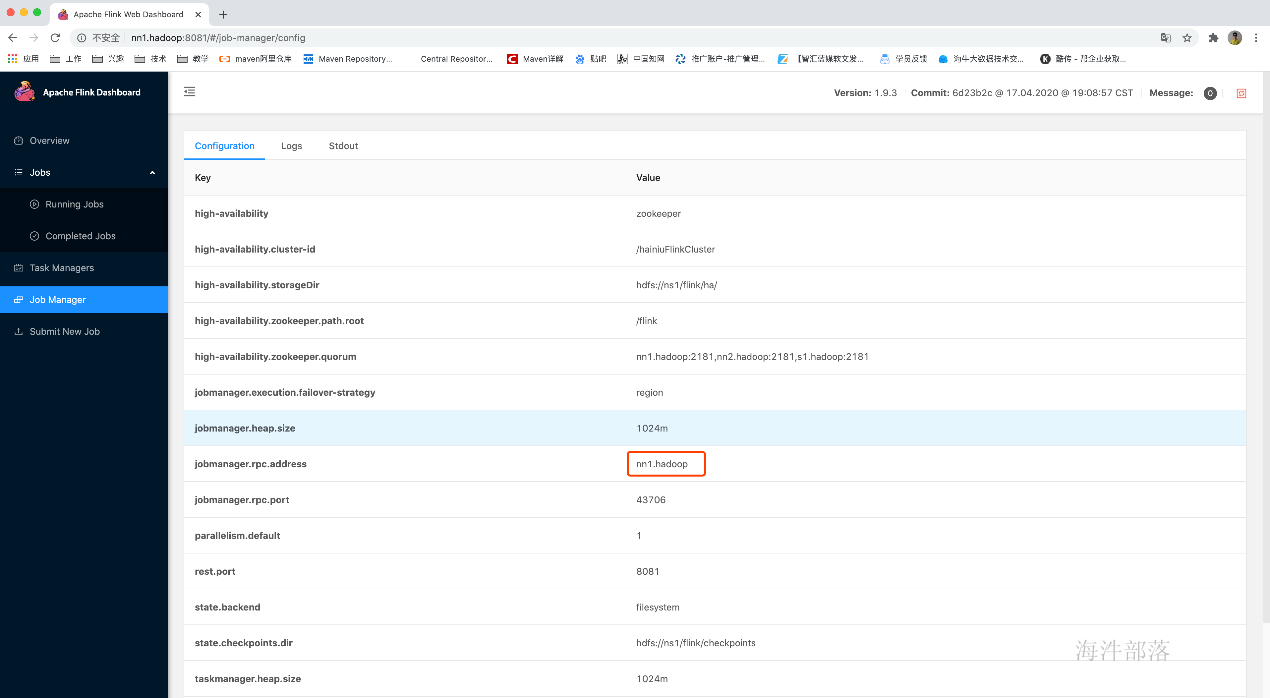

vim /usr/local/flink/conf/flink-conf.yaml高可用相关参数解释:

#指定高可用模式(必须)

high-availability: zookeeper

#ZooKeeper提供分布式协调服务(必须)

high-availability.zookeeper.quorum: nn1.hadoop:2181,nn2.hadoop:2181,s1.hadoop:2181

#根ZooKeeper节点,在该节点下放置所有集群节点(推荐)

high-availability.zookeeper.path.root: /flink

#JobManager元数据保存在文件系统storageDir中,只有指向此状态的指针存储在ZooKeeper中(必须)

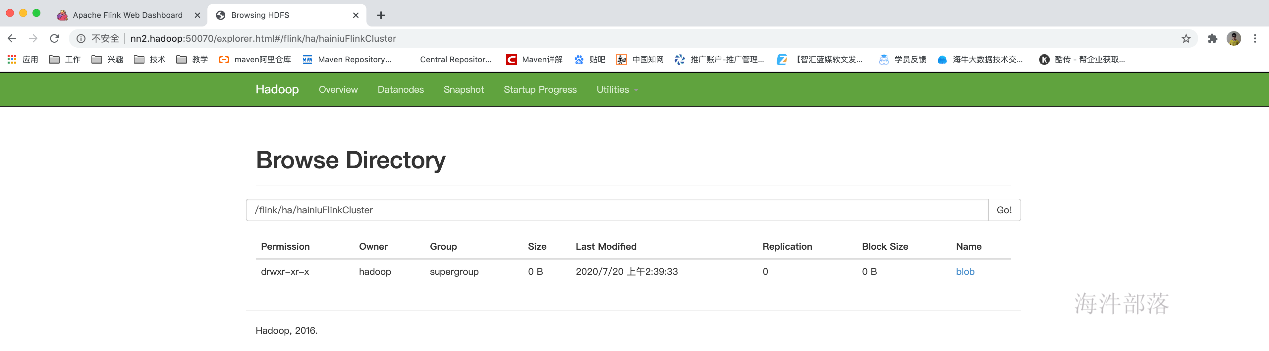

high-availability.storageDir: hdfs://ns1/flink/ha/

#自定义集群(推荐)

high-availability.cluster-id: /hainiuFlinkCluster

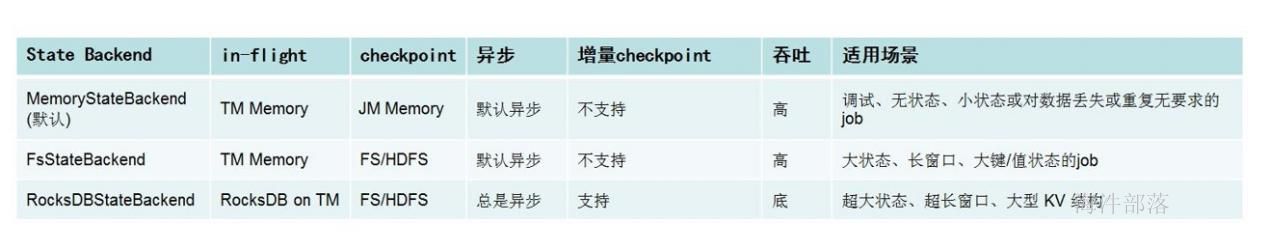

#state checkpoints模式

state.backend: filesystem

#检查点(checkpoint)生成的分布式快照的保存地点,默认是jobmanager的memory,但是HA模式必须配置在hdfs上

state.checkpoints.dir: hdfs://ns1/flink/checkpoints

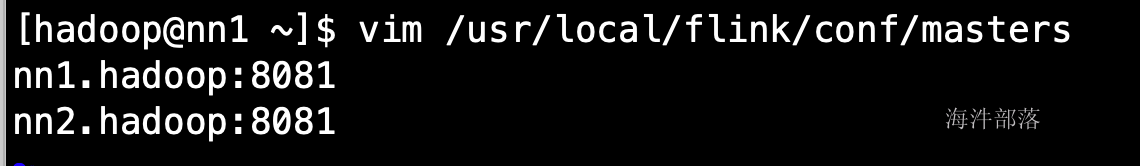

修改master

vim /usr/local/flink/conf/masters

分发修改配置

./scp_all.sh /usr/local/flink/conf/flink-conf.yaml /usr/local/flink/conf/

./scp_all.sh /usr/local/flink/conf/masters /usr/local/flink/conf/

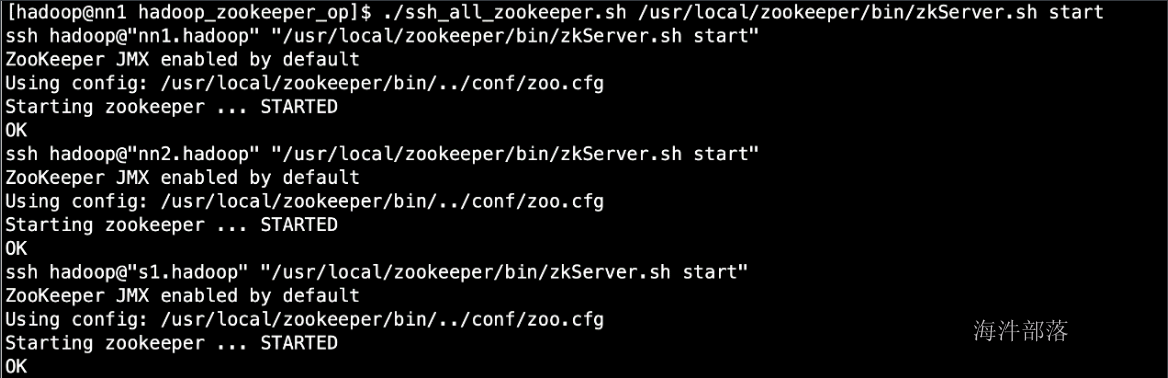

2.启动HA

先启动zookeeper

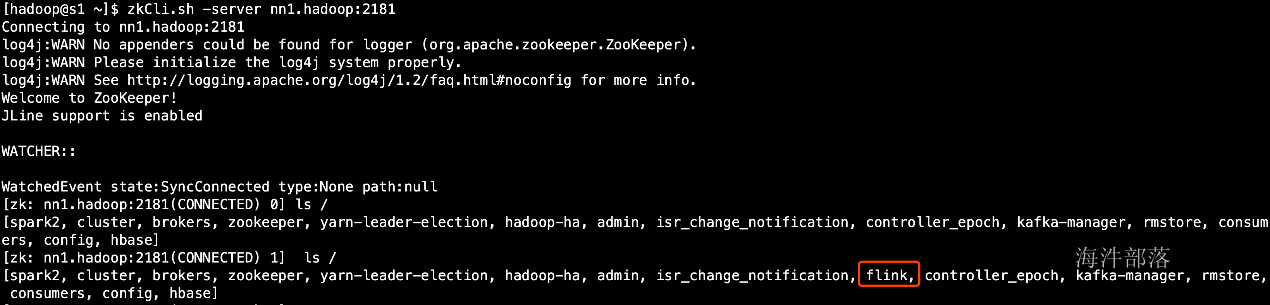

./ssh_all_zookeeper.sh /usr/local/zookeeper/bin/zkServer.sh start

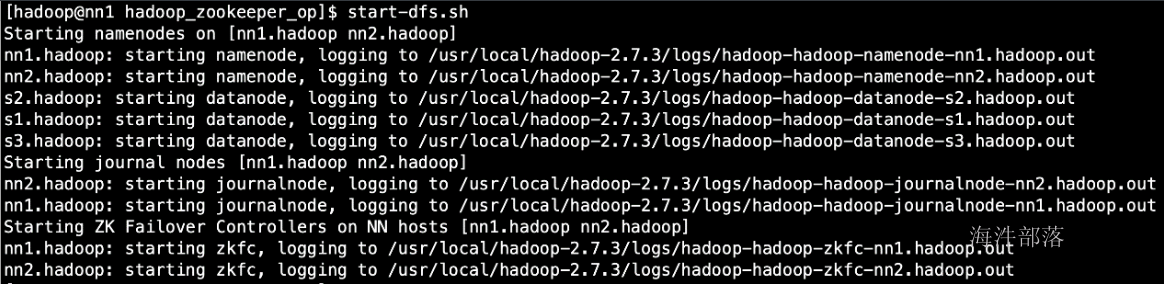

3.再启动hdfs

start-dfs.sh

4.创建hdfs目录

hadoop fs -mkdir -p hdfs:///flink/ha/

hadoop fs -mkdir -p hdfs:///flink/checkpoints

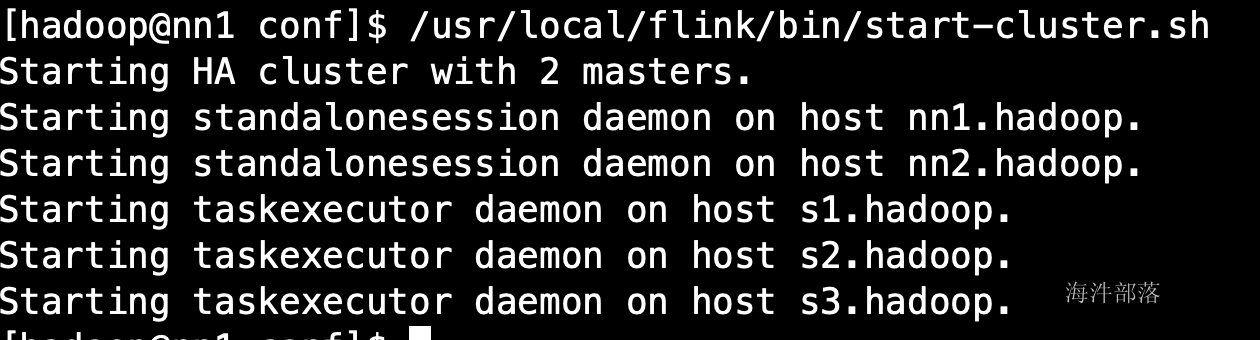

5.启动flink

/usr/local/flink/bin/start-cluster.sh

6.验证HA是否生效

查看主master的webUI

查看hdfs上的master元数据目录

查看zk中的是否新建/flink数据目录

各机器上的进程

7.高可用演示:

提交任务

flink run -d /usr/local/flink/examples/streaming/SocketWindowWordCount.jar --hostna

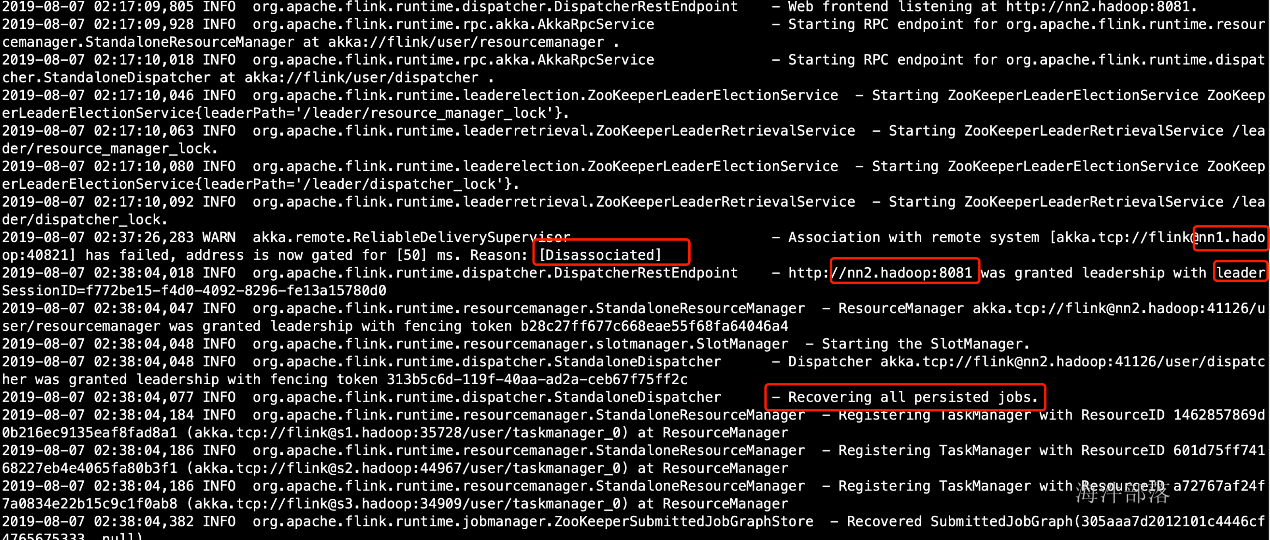

kill掉主master看看从master是否启用,以及运行中的任务是否还在

此时查看 从master 的日志,发现已经进入恢复模式

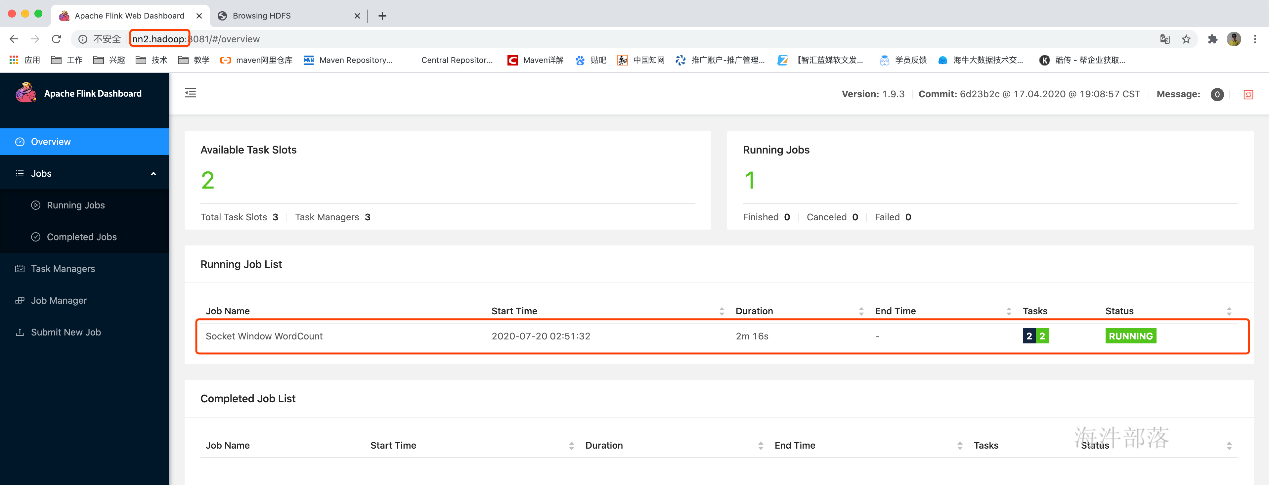

查看原来的从master的webUI,发现此时已经变成了主master

发现任务已恢复并正在运行

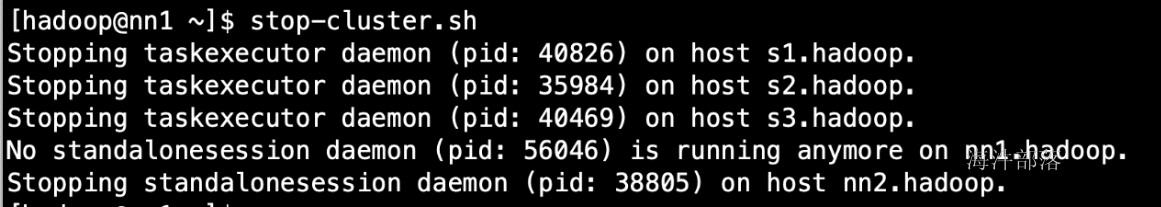

8.关闭集群,自动关闭HA

stop-cluster.sh

4.Flink On YARN模式

1.前言

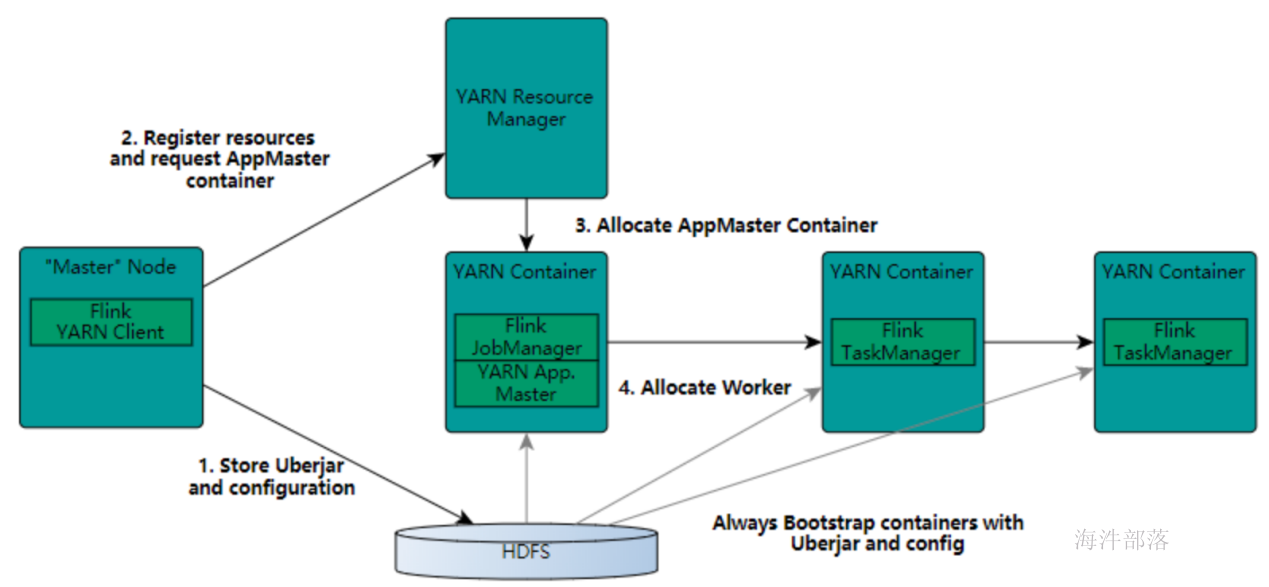

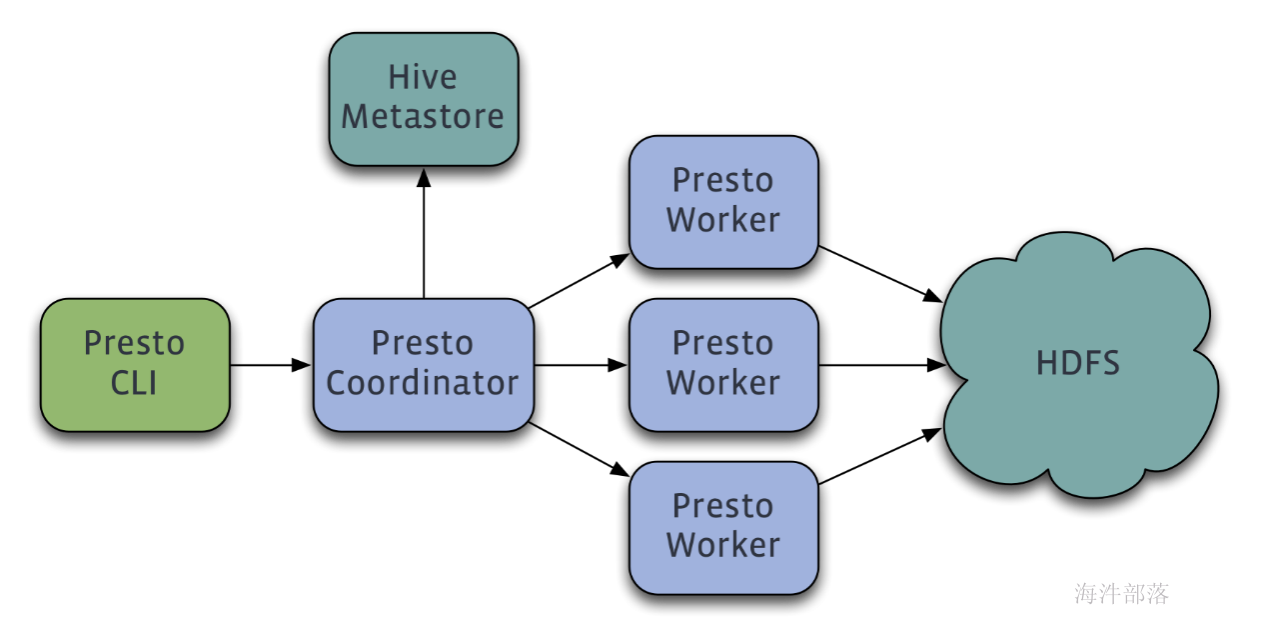

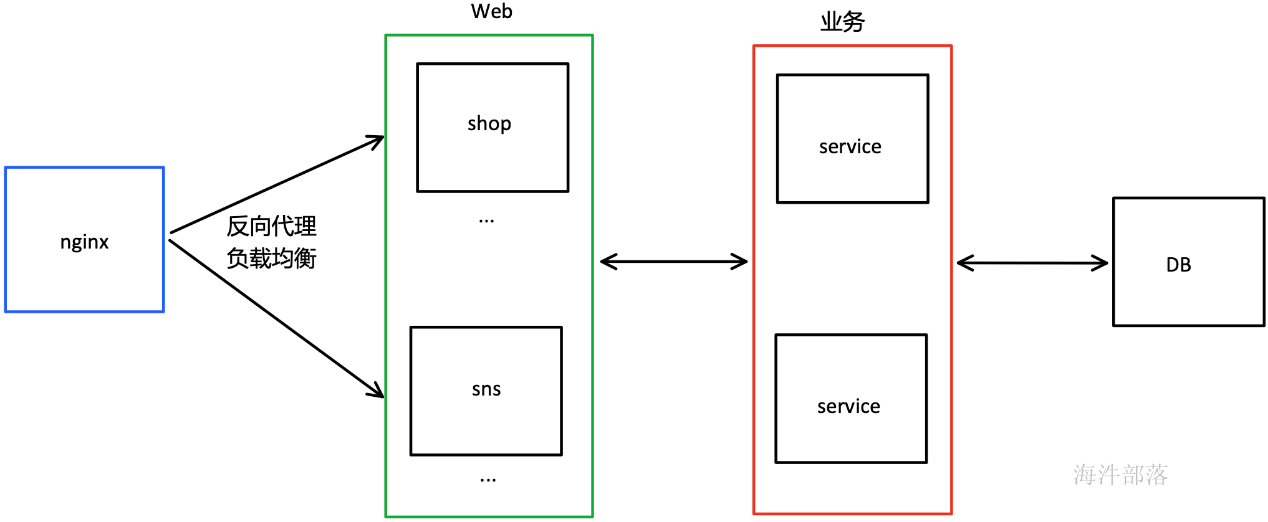

在一个企业中,为了最大化的利用集群资源,一般都会在一个集群中同时运行多种类型的 Workload。因此 Flink 也支持在 Yarn 上面运行。首先,让我们通过下图了解下 Yarn 和 Flink 的关系。

- 在图中可以看出,Flink 与 Yarn 的关系与 MapReduce 和 Yarn 的关系是一样的。Flink 通过 Yarn 的接口实现了自己的 App Master。当在 Yarn 中部署了 Flink,Yarn 就会用自己的 Container 来启动 Flink 的 JobManager(也就是 App Master)和 TaskManager。

- 启动新的Flink YARN会话时,客户端首先检查所请求的资源(容器和内存)是否可用。之后,它将包含Flink和配置的jar上传到HDFS(步骤1)。

- 客户端的下一步是请求(步骤2)YARN容器以启动ApplicationMaster(步骤3)。由于客户端将配置和jar文件注册为容器的资源,因此在该特定机器上运行的YARN的NodeManager将负责准备容器(例如,下载文件)。完成后,将启动ApplicationMaster(AM)。

- 该JobManager和AM在同一容器中运行。一旦它们成功启动,AM就知道JobManager(它自己的主机)的地址。它正在为TaskManagers生成一个新的Flink配置文件(以便它们可以连接到JobManager)。该文件也上传到HDFS。此外,AM容器还提供Flink的Web界面。YARN代码分配的所有端口都是临时端口。这允许用户并行执行多个Flink YARN会话。

- 之后,AM开始为Flink的TaskManagers分配容器,这将从HDFS下载jar文件和修改后的配置。完成这些步骤后,即可建立Flink并准备接受作业。

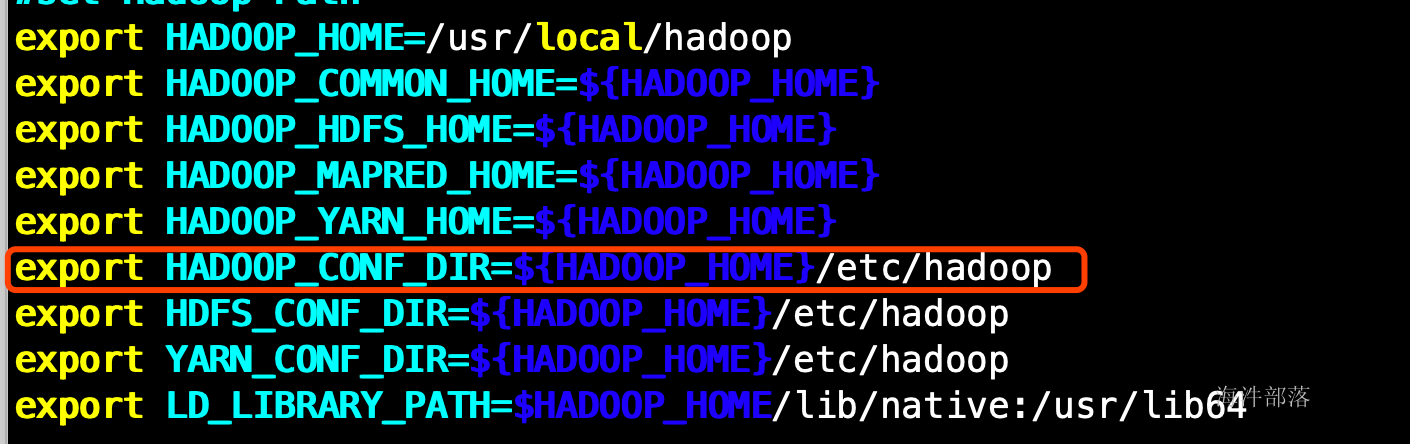

2.修改配置

配置环境变量

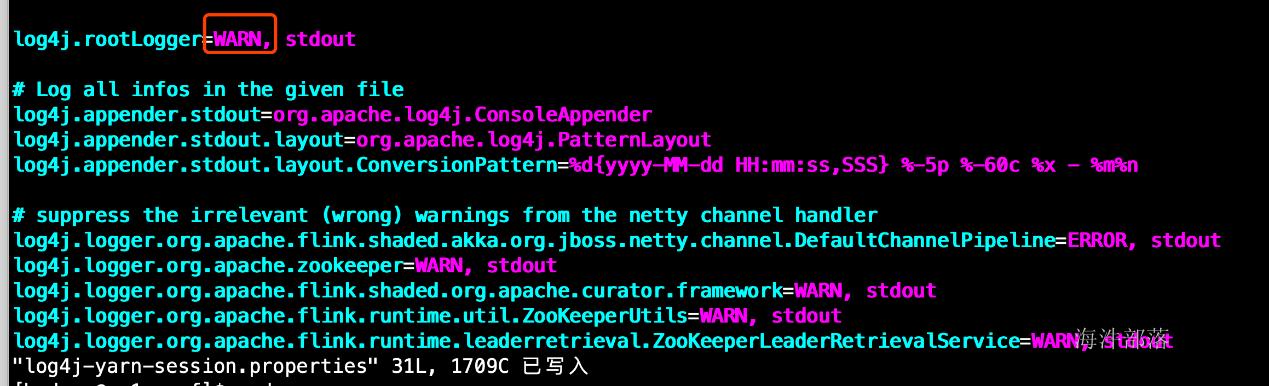

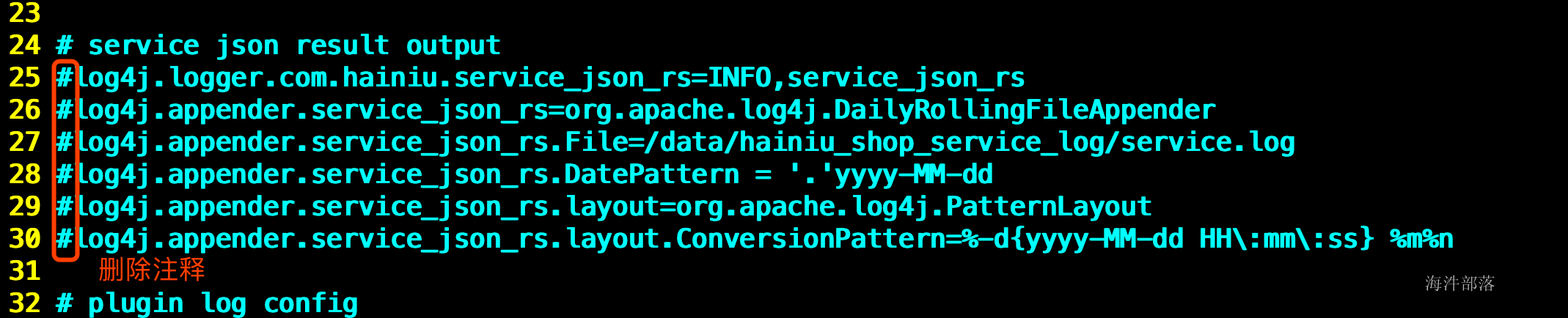

配置日志级别

vim /usr/local/flink/conf/log4j-yarn-session.properties

然后启动yarn

start-yarn.sh

yarn-daemon.sh start proxyserver

#并删除原来的HA信息,不然会恢复以前的任务

#HDFS

hadoop fs -rmr /flink/checkpoints/*

hadoop fs -rmr /flink/ha/*

#ZK

zkCli.sh -server nn1.hadoop:2181

rmr /flink3.在yarn上启动jobManager

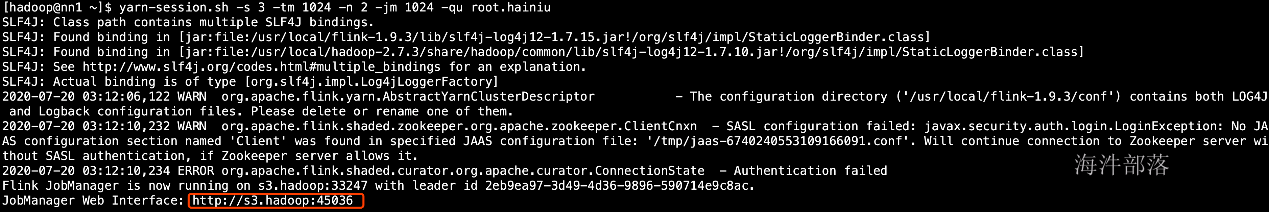

yarn-session.sh -s 3 -tm 1024 -n 2 -jm 1024 -qu root.hainiu参数解释:

-s : 每个TaskManager的slot的数量,executor-cores。建议将slot的数量设置每台机器的处理器数量

-tm : 每个TaskManager的内存大小,executor-memory

-n : TaskManager的数量,相当于executor的数量

-jm : JobManager的内存大小,driver-memory

-qu : yarn的资源队列

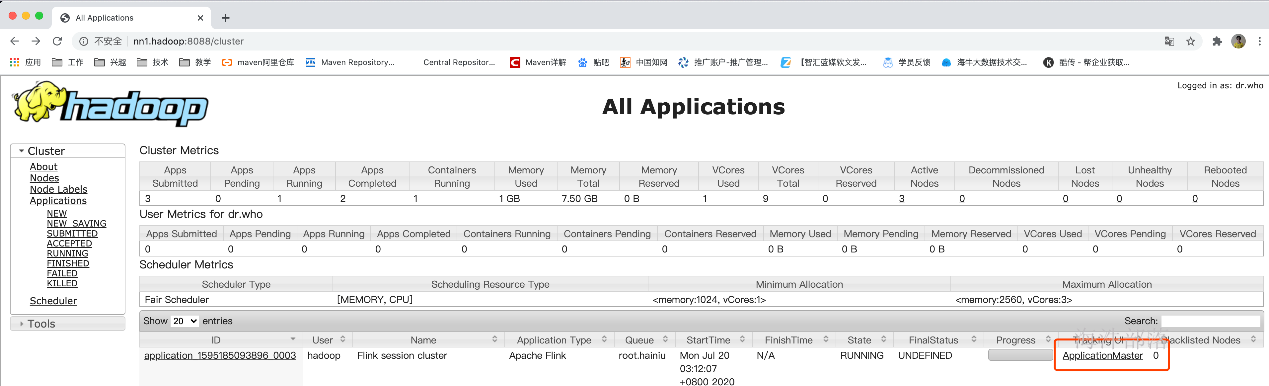

#可以通过 yarn-session.sh -h 命令来查看其它参数的使用

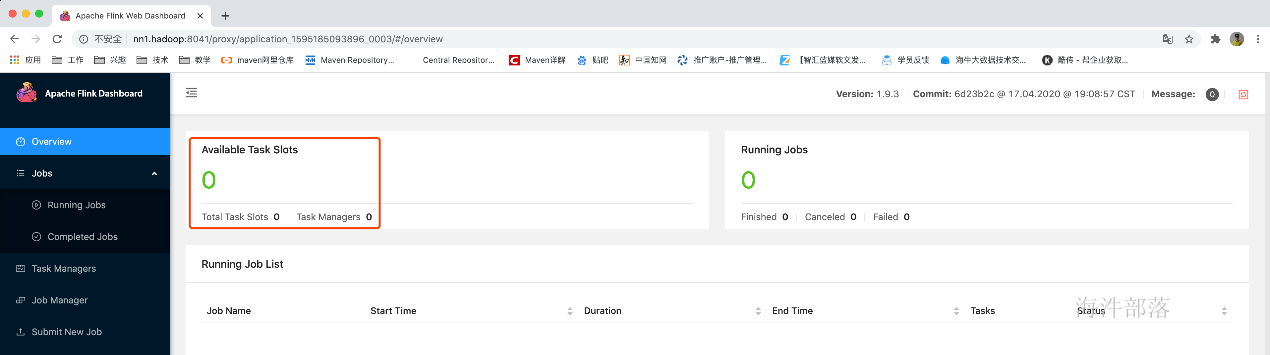

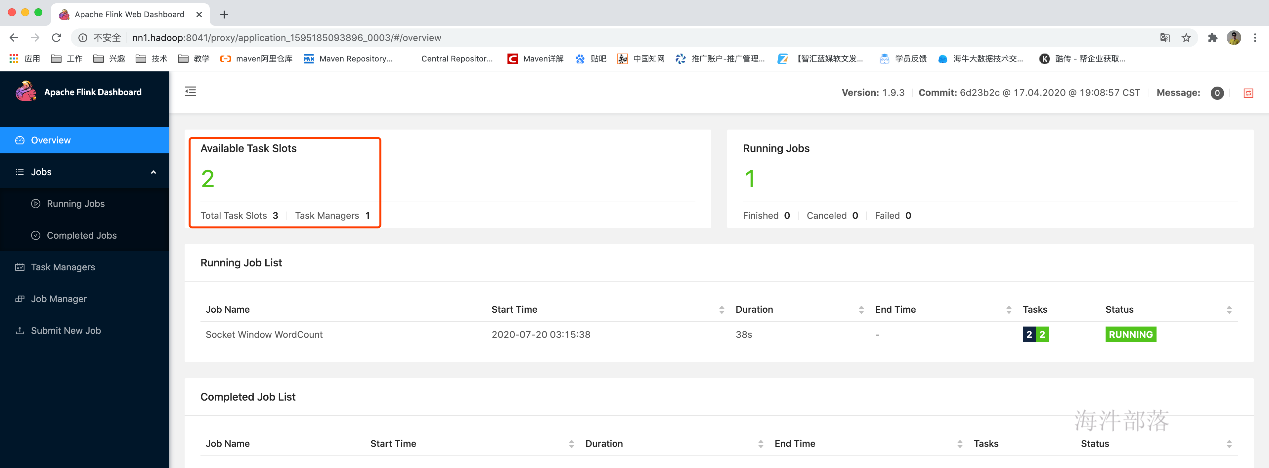

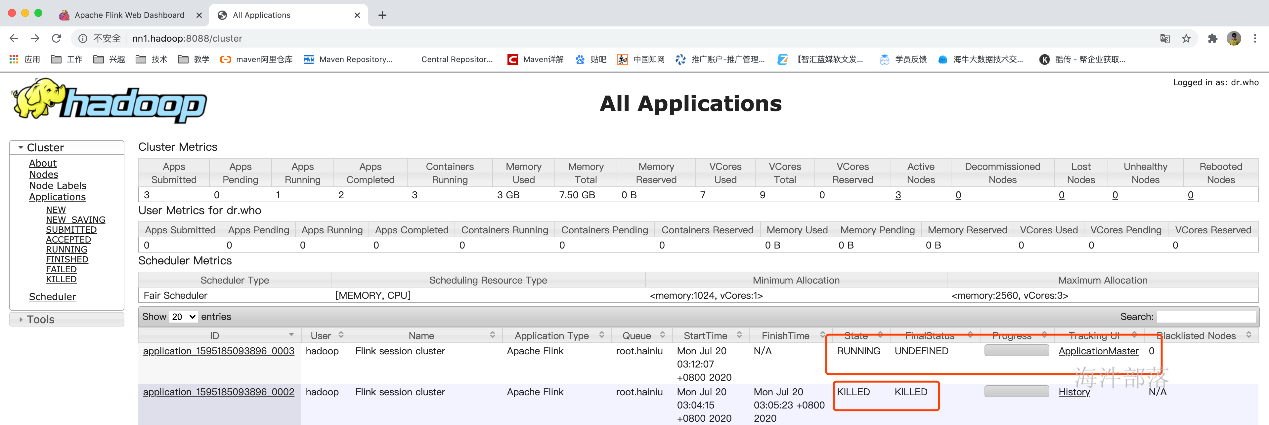

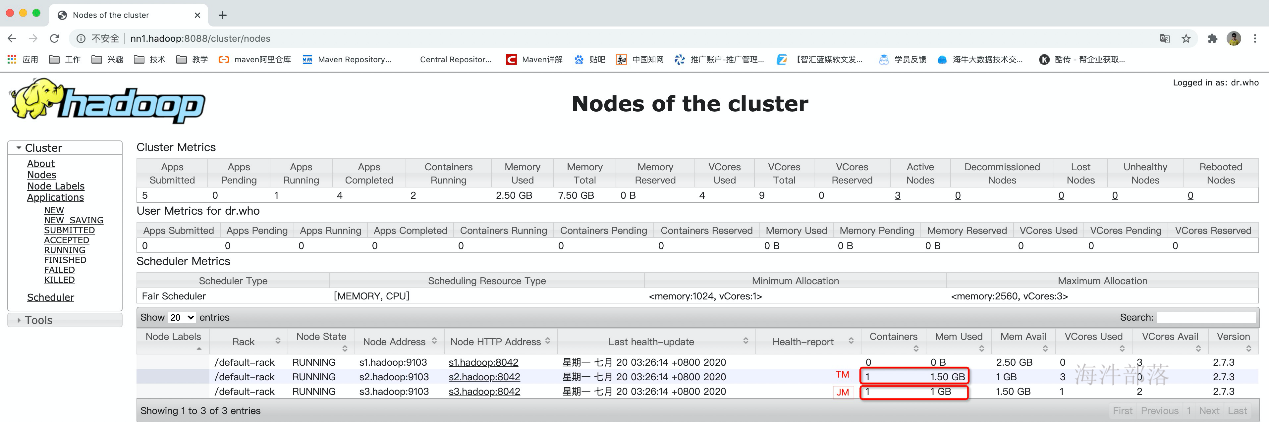

此时只是启动了一个jobManager

由于没有启动taskManager所以可用资源为0

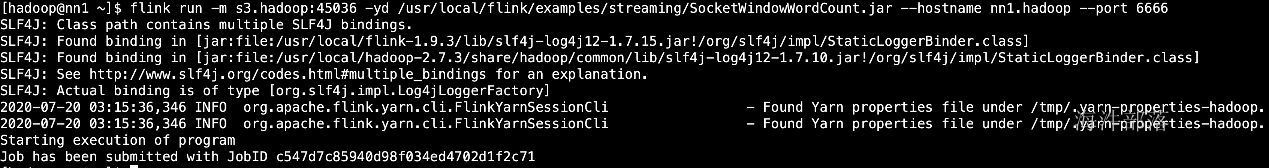

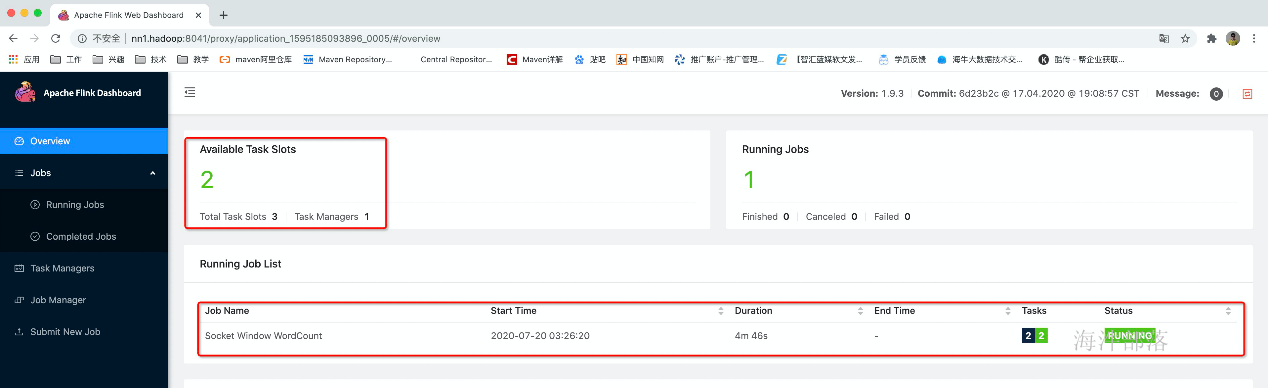

4.此时提交任务,使用刚才的jobManager的address

先启动nc

nc -l -k -p 6666

flink run -m s3.hadoop:45036 -yd /usr/local/flink/examples/streaming/SocketWindowWordCount.jar --hostname nn1.hadoop --port 6666参数解释:

-m jobManager的地址

-yd yarn模式下后台运行

#可以通过直接输入 flink 命令来查看其它参数的使用

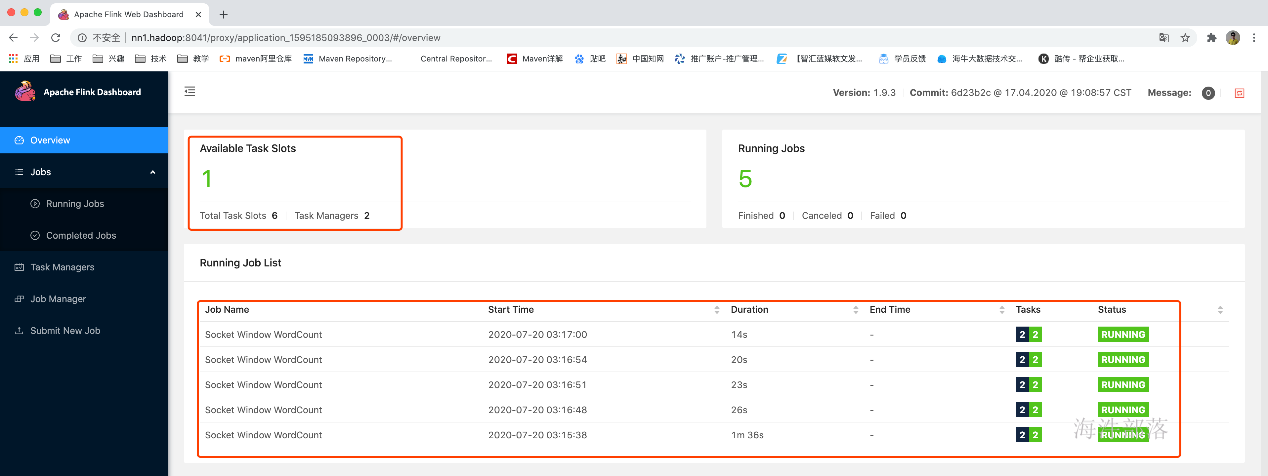

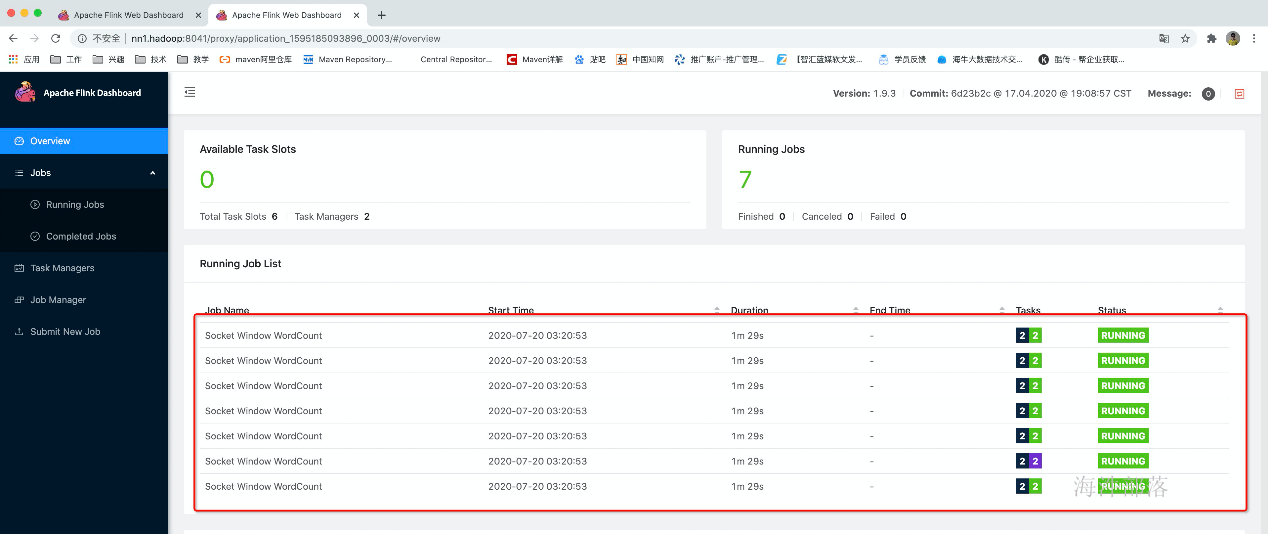

任务提交成功后,根据任务配置的最小资源模式启动相应的taskManager来运行这个任务,由于刚才配置的是2个taskManager每个有3个slot,而这个任务只需要一个slot,所以启动一个taskManager就够用了

此时启动了5个任务,需要5个slot,而已启动的一个taskManager只有3个slot,所以无法满足已有任务的资源需求,所以就另外再启动了一个taskManager,那整个应用的slot就多出来了3个slot,变成了6个

那如果是7个任务怎么办呢?还会再继续启动一个taskManager。如果yarn队列资源不够了才不会继续启动。

如果资源不够用了,那任务会是等待状态,长时间等待任务就会退出。

任务的等待状态

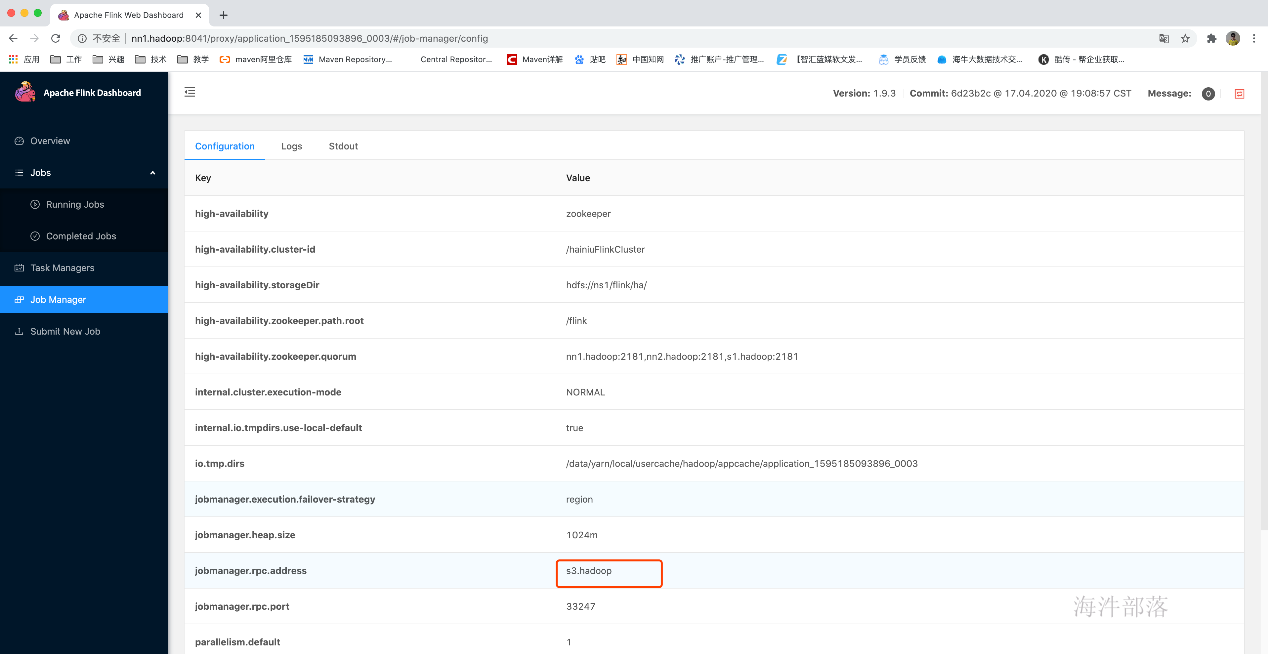

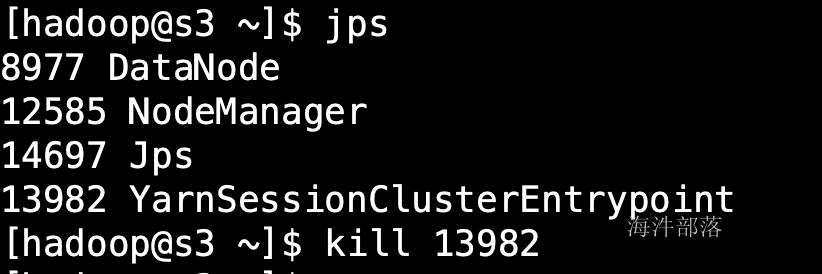

5.yarn模式的HA演示

然后去所在机器上kill掉这个jobManager的yarn模式进程

此时yarn会马上尝试重新再次启动这个jobManager

然后jobManager会去恢复,以前重新运行的任务

总结:说明flink在yarn模式下也是具备HA功能的,前提是你得在flink-conf.yaml配置HA相关的信息

以上是使用yarn-session.sh先启动了一个jobManager,然后再使用flink run -m jobManamger address来把任务提交到使用yarn-session.sh脚本启动的jobManager上

也可以不使用yarn-session.sh预先启动一个jobManager,而是直接使用flink run来运行一个自带jobManager的flink任务

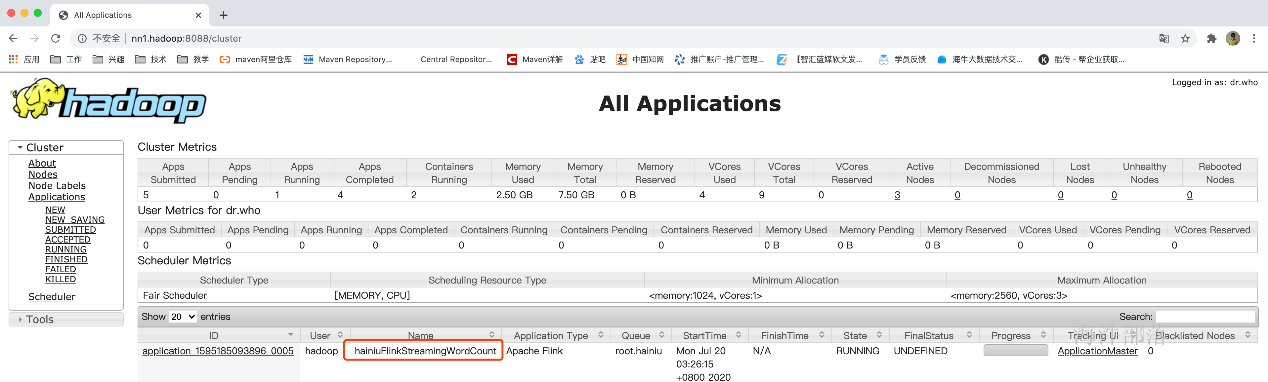

比如下面这个命令,可以启动自带一个内存为1024MB的jobManager,最多2个内存为1536MB的taskManager,并且每个taskManager的taskSlots为3的flink应用,然后在这个flink应用直接运行了一个SocketWindowWordCount的任务

通过此命令运行的flink程序启动临时的jobManager和临时的taskManager,如果结果这个job,那临时的jobManager和taskManager也会直接退出

flink run -m yarn-cluster -yjm 1024 -ytm 1536 -yn 2 -ys 3 -yqu root.hainiu -ynm hainiuFlinkStreamingWordCount \

/usr/local/flink/examples/streaming/SocketWindowWordCount.jar --hostname nn1.hadoop --port 6666参数解释:

-yjm jobManager的内存

-ytm taskManager的内存

-yn tm的数量

-ys 每个tm的任务槽

-yqu yarn资源队列名称

-ynm yarn application nameyarn application name已修改:

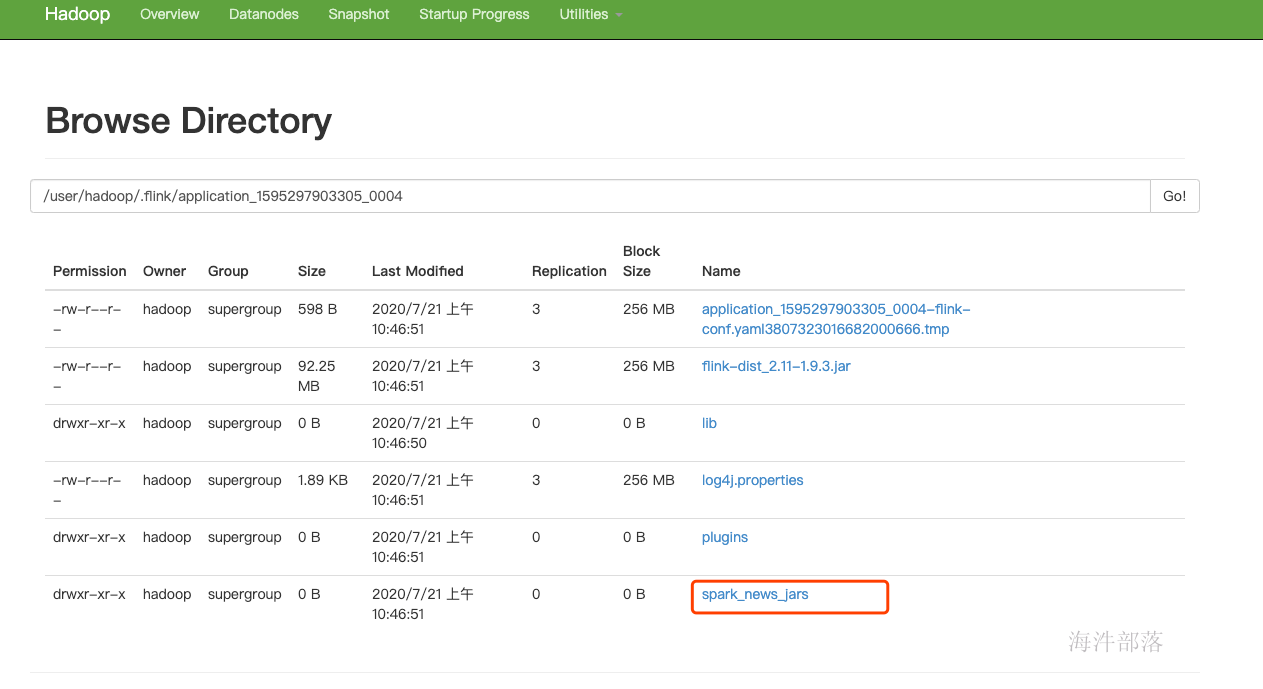

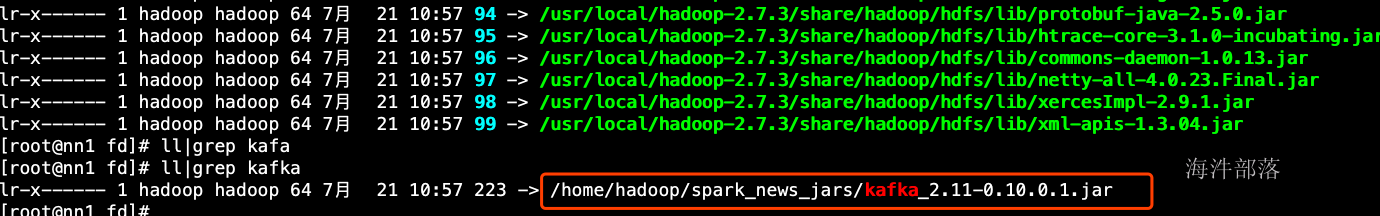

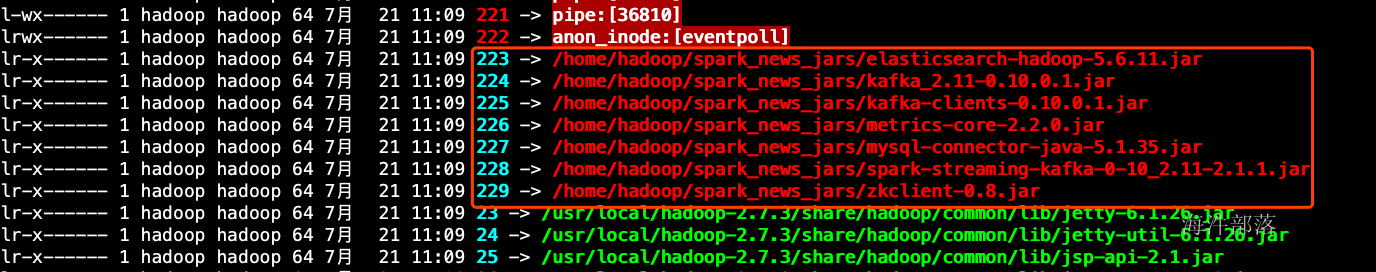

6.怎么在yarn模式上使用thinjar

1.怎么让你的tm找到依赖的jar包

flink run -m yarn-cluster -yt /home/hadoop/spark_news_jars -yjm 1024 -ytm 1536 -yn 2 -ys 3 -yqu root.hainiu \

-ynm hainiuFlinkStreamingWordCount /usr/local/flink/examples/streaming/SocketWindowWordCount.jar --hostname nn1.hadoop --port 6666

#yt命令是上传指定目录到flink任务的hdfs目录,然后flink在yarn上中的程序先从这个HDFS把目录下的所有文件(包换刚才yt命令指定的本地目录)下载过来

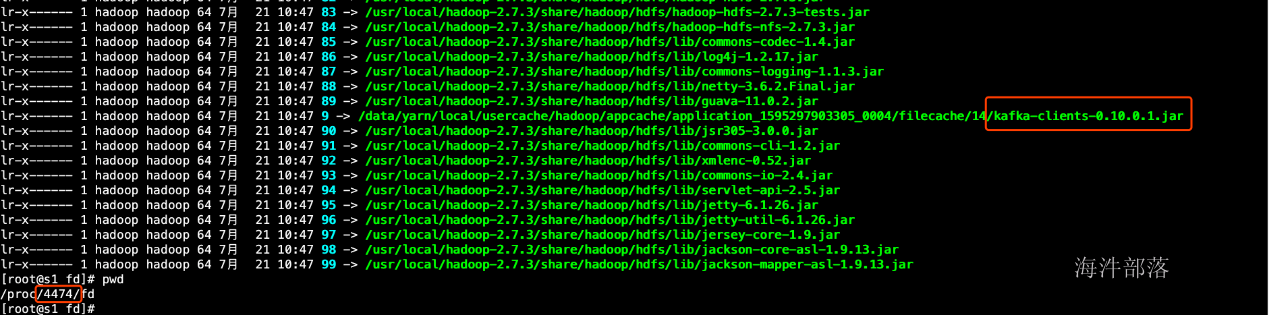

跑任务那个机器的tm的进程信息

2.怎么让你的driver找到依赖的jar包

跑任务那

flink run -m yarn-cluster -yt /home/hadoop/spark_news_jars -yjm 1024 -ytm 1536 -yn 2 -ys 3 -yqu root.hainiu -ynm hainiuFlinkStreamingWordCount \

-C file:///home/hadoop/spark_news_jars/kafka_2.11-0.10.0.1.jar /usr/local/flink/examples/streaming/SocketWindowWordCount.jar --hostname nn1.hadoop --port 6666

#-C 命令是同时指定driver和taskManager运行的java程序的classpath。这里用这个命令只为了让driver找到jar包,taskmanager是通过yt命令找到jar包的,所以tm上有没有-C命令指定的文件是无所谓的。

#-C 命令指定的文件路径必须URI格式的,那本地文件就以file:///开头,注意不能使用文件通配符"*"个机器的driver的进程信息

怎么指定dirver端找到多个依赖的jar包

结合shell脚本:

$(ll /home/hadoop/spark_news_jars/ |awk 'NR>1{print "-C file:///home/hadoop/spark_news_jars/"$9}'|tr '\n' ' ')最终的命令如下:

flink run -m yarn-cluster -yt /home/hadoop/spark_news_jars -yjm 1024 -ytm 1536 -yn 2 -ys 3 -yqu root.hainiu -ynm hainiuFlinkStreamingWordCount \

$(ll /home/hadoop/spark_news_jars/ |awk 'NR>1{print "-C file:///home/hadoop/spark_news_jars/"$9}'|tr '\n' ' ') \

/usr/local/flink/examples/streaming/SocketWindowWordCount.jar --hostname nn1.hadoop --port 6666跑任务那个机器的driver的进程信息

3.Flink的API分层、开发环境搭建、基本开发流、架构与组件原理、并行度、任务执行计划、chains、SlotGroup与Slot共享

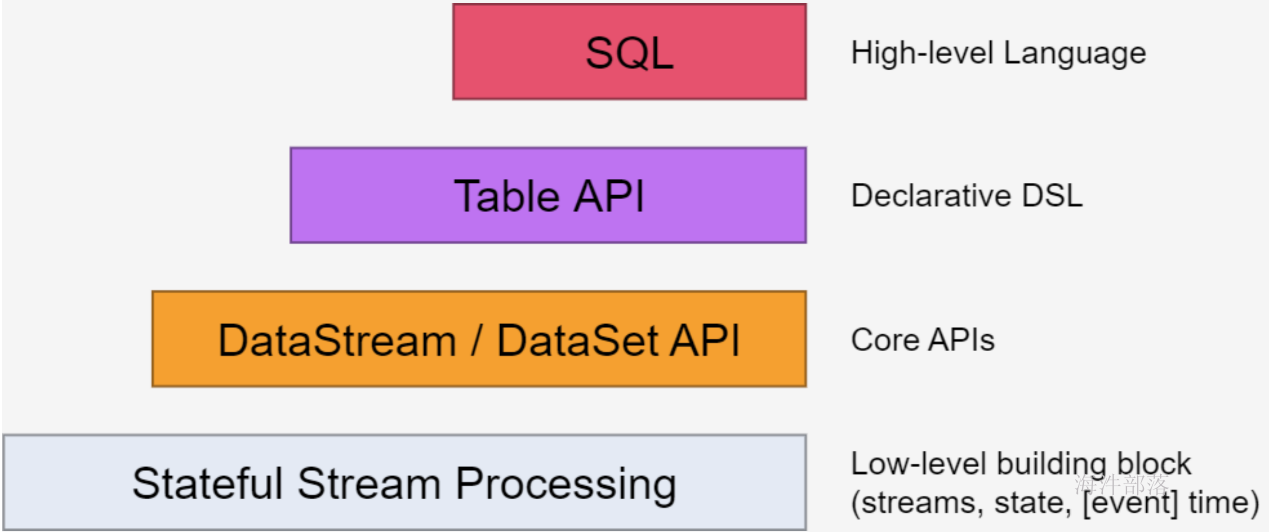

1.Flink的API分层

注:越底层API越灵活,越上层的API越轻便

Stateful Stream Processing

- 位于最底层, 是core API 的底层实现

- processFunction

- 利用低阶,构建一些新的组件或者算子

- 灵活性高,但开发比较复杂

Core API

- DataSet - 批处理 API

- DataStream –流处理 API

Table API & SQL

- SQL 构建在Table 之上,都需要构建Table 环境

- 不同的类型的Table 构建不同的Table 环境

- Table 可以与DataStream或者DataSet进行相互转换

- Streaming SQL不同于存储的SQL,最终会转化为流式执行计划

2.flink开发环境搭建

使用maven搭建开发环境

pom:

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xmlns="http://maven.apache.org/POM/4.0.0"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>com.hainiu</groupId>

<artifactId>hainiuflink</artifactId>

<version>1.0</version>

<properties>

<java.version>1.8</java.version>

<scala.version>2.11</scala.version>

<flink.version>1.9.3</flink.version>

<parquet.version>1.10.0</parquet.version>

<hadoop.version>2.7.3</hadoop.version>

<fastjson.version>1.2.72</fastjson.version>

<redis.version>2.9.0</redis.version>

<mysql.version>5.1.35</mysql.version>

<log4j.version>1.2.17</log4j.version>

<slf4j.version>1.7.7</slf4j.version>

<maven.compiler.source>1.8</maven.compiler.source>

<maven.compiler.target>1.8</maven.compiler.target>

<maven.compiler.compilerVersion>1.8</maven.compiler.compilerVersion>

<project.build.sourceEncoding>UTF-8</project.build.sourceEncoding>

<project.build.scope>compile</project.build.scope>

<!-- <project.build.scope>provided</project.build.scope>-->

<mainClass>com.hainiu.Driver</mainClass>

</properties>

<dependencies>

<dependency>

<groupId>org.slf4j</groupId>

<artifactId>slf4j-log4j12</artifactId>

<version>${slf4j.version}</version>

<scope>${project.build.scope}</scope>

</dependency>

<dependency>

<groupId>log4j</groupId>

<artifactId>log4j</artifactId>

<version>${log4j.version}</version>

<scope>${project.build.scope}</scope>

</dependency>

<!-- flink的hadoop兼容 -->

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>${hadoop.version}</version>

<scope>${project.build.scope}</scope>

</dependency>

<!-- flink的hadoop兼容 -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-hadoop-compatibility_${scala.version}</artifactId>

<version>${flink.version}</version>

<scope>${project.build.scope}</scope>

</dependency>

<!-- flink的java的api -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-java</artifactId>

<version>${flink.version}</version>

<scope>${project.build.scope}</scope>

</dependency>

<!-- flink streaming的java的api -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-streaming-java_${scala.version}</artifactId>

<version>${flink.version}</version>

<scope>${project.build.scope}</scope>

</dependency>

<!-- flink的scala的api -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-scala_${scala.version}</artifactId>

<version>${flink.version}</version>

<scope>${project.build.scope}</scope>

</dependency>

<!-- flink streaming的scala的api -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-streaming-scala_${scala.version}</artifactId>

<version>${flink.version}</version>

<scope>${project.build.scope}</scope>

</dependency>

<!-- flink运行时的webUI -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-runtime-web_${scala.version}</artifactId>

<version>${flink.version}</version>

<scope>${project.build.scope}</scope>

</dependency>

<!-- 使用rocksdb保存flink的state -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-statebackend-rocksdb_${scala.version}</artifactId>

<version>${flink.version}</version>

<scope>${project.build.scope}</scope>

</dependency>

<!-- flink操作hbase -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-hbase_${scala.version}</artifactId>

<version>${flink.version}</version>

<scope>${project.build.scope}</scope>

</dependency>

<!-- flink操作es -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-elasticsearch5_${scala.version}</artifactId>

<version>${flink.version}</version>

<scope>${project.build.scope}</scope>

</dependency>

<!-- flink 的kafka -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-kafka-0.10_${scala.version}</artifactId>

<version>${flink.version}</version>

<scope>${project.build.scope}</scope>

</dependency>

<!-- flink 写文件到HDFS -->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-filesystem_${scala.version}</artifactId>

<version>${flink.version}</version>

<scope>${project.build.scope}</scope>

</dependency>

<!-- mysql连接驱动 -->

<dependency>

<groupId>mysql</groupId>

<artifactId>mysql-connector-java</artifactId>

<version>${mysql.version}</version>

<scope>${project.build.scope}</scope>

</dependency>

<!-- redis连接 -->

<dependency>

<groupId>redis.clients</groupId>

<artifactId>jedis</artifactId>

<version>${redis.version}</version>

<scope>${project.build.scope}</scope>

</dependency>

<!-- flink操作parquet文件格式 -->

<dependency>

<groupId>org.apache.parquet</groupId>

<artifactId>parquet-avro</artifactId>

<version>${parquet.version}</version>

<scope>${project.build.scope}</scope>

</dependency>

<dependency>

<groupId>org.apache.parquet</groupId>

<artifactId>parquet-hadoop</artifactId>

<version>${parquet.version}</version>

<scope>${project.build.scope}</scope>

</dependency>

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-parquet_${scala.version}</artifactId>

<version>${flink.version}</version>

<scope>${project.build.scope}</scope>

</dependency>

<!-- json操作 -->

<dependency>

<groupId>com.alibaba</groupId>

<artifactId>fastjson</artifactId>

<version>${fastjson.version}</version>

<scope>${project.build.scope}</scope>

</dependency>

</dependencies>

<build>

<resources>

<resource>

<directory>src/main/resources</directory>

</resource>

</resources>

<plugins>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-assembly-plugin</artifactId>

<configuration>

<descriptors>

<descriptor>src/assembly/assembly.xml</descriptor>

</descriptors>

<archive>

<manifest>

<mainClass>${mainClass}</mainClass>

</manifest>

</archive>

</configuration>

<executions>

<execution>

<id>make-assembly</id>

<phase>package</phase>

<goals>

<goal>single</goal>

</goals>

</execution>

</executions>

</plugin>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-surefire-plugin</artifactId>

<version>2.12</version>

<configuration>

<skip>true</skip>

<forkMode>once</forkMode>

<excludes>

<exclude>**/**</exclude>

</excludes>

</configuration>

</plugin>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-compiler-plugin</artifactId>

<version>3.1</version>

<configuration>

<source>${java.version}</source>

<target>${java.version}</target>

<encoding>${project.build.sourceEncoding}</encoding>

</configuration>

</plugin>

</plugins>

</build>

</project>

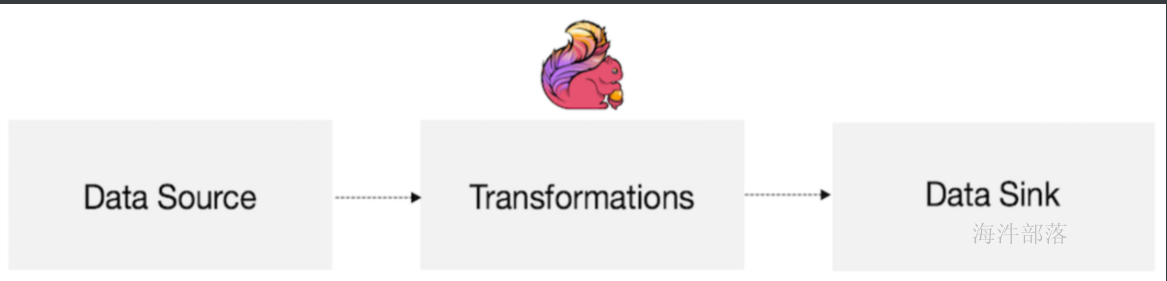

3.flink开发基本流程

1).DataStreamContext

- getExecutionEnvironment 适合jar包与命令

- Jar

- cmd

- createLocalEnvironment 适合本地测试开发

2).DataSet 与 DataStream

- 表示Flink app中的分布式数据集

- 包含重复的、不可变数据集

- DataSet有界、DataStream可以是无界

- 可以从数据源、也可以通过各种转换操作创建

3).flink编程套路

- 获取执行环境(execution environment)

- 加载/创建初始数据集

- 对数据集进行各种转换操作(生成新的数据集)

- 指定将计算的结果放到何处去

- 触发APP执行

4).flink的app计算方式和spark一样都是惰性的

- Flink APP都是延迟执行的

- 只有当execute()被显示调用时才会真正执行

- 本地执行还是在集群上执行取决于执行环境的类型

- 好处:用户可以根据业务构建复杂的应用,Flink可以整体进优化并生成执行计划

5).与sparkstreaming执行任务的不同之处:

- sparkstreaming是生成每小批的task放到executor放起来,任务跑完之后就退出,然后再生成新的task,executor再跑新的task,循环往复执行此动作。

- flink是生成task放到taskManager的taskSlot里面,然后这个task一直不退出,直到这个application整个退出它才退出。

计算模型:

- 定义源

- 写Transformations,就是写operators

- 定义输出

示例代码:

scala版:

package com.hainiu.flink.operator

import org.apache.flink.api.common.functions.FlatMapFunction

import org.apache.flink.configuration.Configuration

import org.apache.flink.streaming.api.scala.{DataStream, StreamExecutionEnvironment}

import org.apache.flink.util.Collector

object SocketWordCount {

def main(args: Array[String]): Unit = {

//获得local运行环境

val env: StreamExecutionEnvironment = StreamExecutionEnvironment.createLocalEnvironmentWithWebUI(new Configuration())

//定义socket的source源

val text: DataStream[String] = env.socketTextStream("localhost", 6666)

//scala开发需要加一行隐式转换,否则在调用operator的时候会报错,作用是找到scala类型的TypeInformation

import org.apache.flink.api.scala._

//写Transformations进行数据的转换

//定义operators,作用是解析数据,分组,并且求wordCount

// val wordCount: DataStream[(String, Int)] = text.flatMap(_.split(" ")).map((_, 1)).keyBy(_._1).sum(1)

//使用FlatMapFunction自定义函数来完成flatMap和map的组合功能

val wordCount: DataStream[(String, Int)] = text.flatMap(new FlatMapFunction[String, (String, Int)] {

override def flatMap(value: String, out: Collector[(String, Int)]) = {

val strings: Array[String] = value.split(" ")

for (s <- strings) {

out.collect((s, 1))

}

}

}).keyBy(_._1).sum(1)

//定义sink,打印数据到控制台

wordCount.print()

//定义任务的名称并运行

//注意:operator是惰性的,只有遇到execute才执行

env.execute("SocketWordCount")

}

}java版:

package com.hainiu.operator;

import org.apache.flink.api.java.tuple.Tuple;

import org.apache.flink.api.java.tuple.Tuple2;

import org.apache.flink.configuration.Configuration;

import org.apache.flink.streaming.api.datastream.DataStreamSource;

import org.apache.flink.streaming.api.datastream.SingleOutputStreamOperator;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.functions.KeyedProcessFunction;

import org.apache.flink.streaming.api.functions.ProcessFunction;

import org.apache.flink.util.Collector;

public class SocketWordCount {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment env = StreamExecutionEnvironment.createLocalEnvironmentWithWebUI(new Configuration());

DataStreamSource<String> socket = env.socketTextStream("localhost", 6666);

//1.lambda写法

// SingleOutputStreamOperator<String> flatMap = socket.flatMap((String value, Collector<String> out) -> {

// Arrays.stream(value.split(" ")).forEach(word -> {

// out.collect(word);

// });

// }).returns(Types.STRING);

//

// SingleOutputStreamOperator<Tuple2<String, Integer>> map = flatMap.map(f -> Tuple2.of(f, 1)).returns(Types.TUPLE(Types.STRING, Types.INT));

//

// SingleOutputStreamOperator<Tuple2<String, Integer>> sum = map.keyBy(0).sum(1);

//

// sum.print();

//2.function写法

// SingleOutputStreamOperator<String> flatMap = socket.flatMap(new FlatMapFunction<String, String>() {

// @Override

// public void flatMap(String value, Collector<String> out) throws Exception {

// String[] s = value.split(" ");

// for (String ss : s) {

// out.collect(ss);

// }

// }

// });

//

// SingleOutputStreamOperator<Tuple2<String, Integer>> map = flatMap.map(new MapFunction<String, Tuple2<String, Integer>>() {

// @Override

// public Tuple2<String, Integer> map(String value) throws Exception {

// return Tuple2.of(value, 1);

// }

// });

//

// SingleOutputStreamOperator<Tuple2<String, Integer>> sum = map.keyBy("f0").sum(1);

//

// sum.print();

//3.function组合写法

// SingleOutputStreamOperator<Tuple2<String,Integer>> flatMap = socket.flatMap(new FlatMapFunction<String, Tuple2<String,Integer>>() {

// @Override

// public void flatMap(String value, Collector<Tuple2<String,Integer>> out) throws Exception {

// String[] s = value.split(" ");

// for (String ss : s) {

// out.collect(Tuple2.of(ss,1));

// }

// }

// });

//

// SingleOutputStreamOperator<Tuple2<String, Integer>> sum = flatMap.keyBy(f -> f.f0).sum(1);

//

// sum.print();

//4.richfunction组合写法

// SingleOutputStreamOperator<Tuple2<String, Integer>> flatMap = socket.flatMap(new RichFlatMapFunction<String, Tuple2<String, Integer>>() {

//

// private String name = null;

//

// @Override

// public void open(Configuration parameters) throws Exception {

// name = "hainiu_";

// }

//

// @Override

// public void close() throws Exception {

// name = null;

// }

//

// @Override

// public void flatMap(String value, Collector<Tuple2<String, Integer>> out) throws Exception {

// String[] s = value.split(" ");

// for (String ss : s) {

// System.out.println(getRuntimeContext().getIndexOfThisSubtask());

// out.collect(Tuple2.of(name + ss, 1));

// }

// }

// });

//

// SingleOutputStreamOperator<Tuple2<String, Integer>> sum = flatMap.keyBy(new KeySelector<Tuple2<String, Integer>, String>() {

// @Override

// public String getKey(Tuple2<String, Integer> value) throws Exception {

// return value.f0;

// }

// }).sum(1);

//

// sum.print();

//5.processfunction组合写法

SingleOutputStreamOperator<Tuple2<String, Integer>> sum = socket.process(new ProcessFunction<String, Tuple2<String, Integer>>() {

private String name = null;

@Override

public void open(Configuration parameters) throws Exception {

name = "hainiu_";

}

@Override

public void close() throws Exception {

name = null;

}

@Override

public void processElement(String value, Context ctx, Collector<Tuple2<String, Integer>> out) throws Exception {

// getRuntimeContext()

String[] s = value.split(" ");

for (String ss : s) {

System.out.println(getRuntimeContext().getIndexOfThisSubtask());

out.collect(Tuple2.of(name + ss, 1));

}

}

}).keyBy(0).process(new KeyedProcessFunction<Tuple, Tuple2<String, Integer>, Tuple2<String, Integer>>() {

private Integer num = 0;

@Override

public void processElement(Tuple2<String, Integer> value, Context ctx, Collector<Tuple2<String, Integer>> out) throws Exception {

num += value.f1;

out.collect(Tuple2.of(value.f0,num));

}

});

sum.print();

env.execute();

}

}4.Flink架构

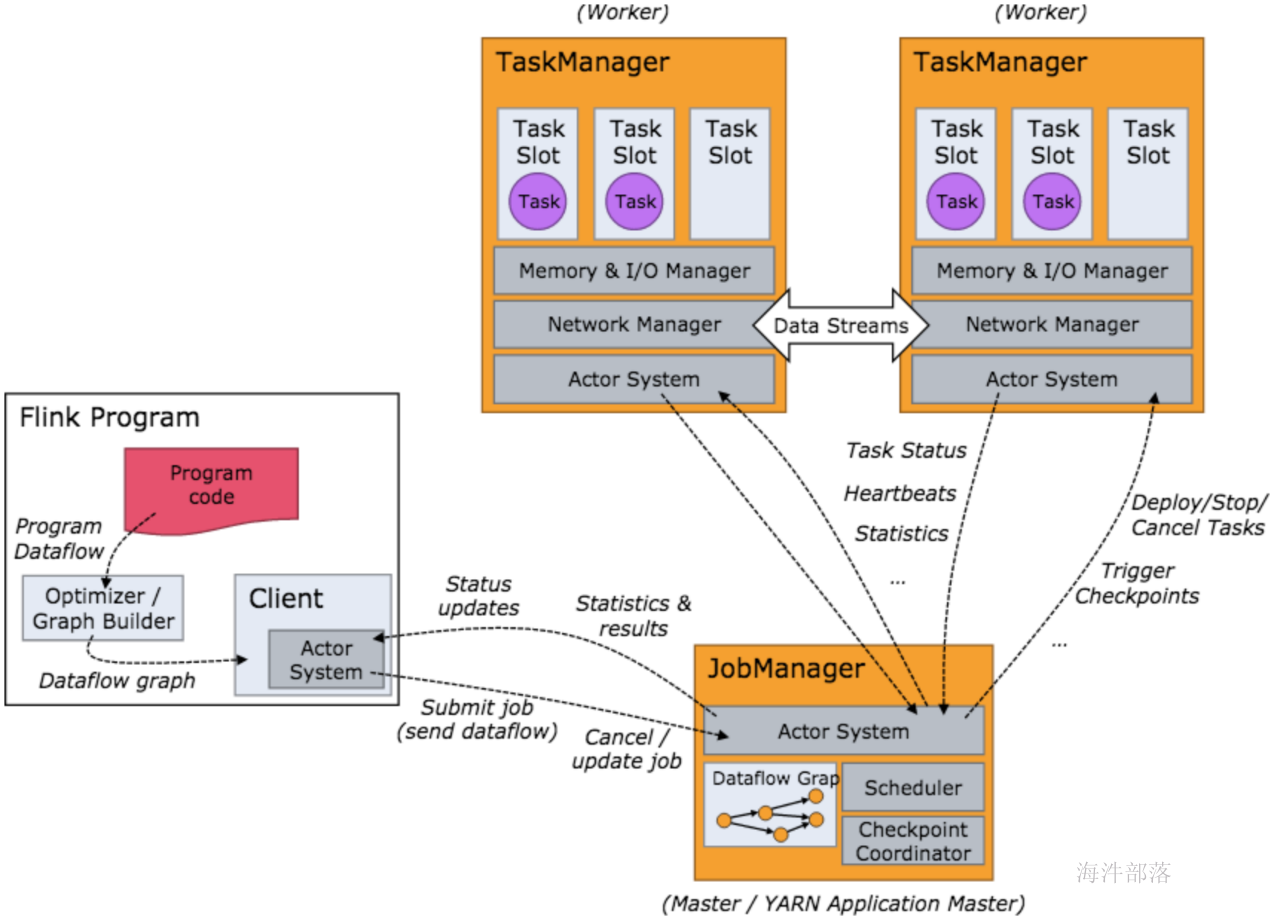

当 Flink 集群启动后,首先会启动一个 JobManger 和一个或多个的 TaskManager。由 Client 提交任务给 JobManager,JobManager 再调度任务到各个 TaskManager 去执行,然后 TaskManager 将心跳和统计信息汇报给 JobManager。TaskManager 之间以流的形式进行数据的传输。上述三者均为独立的 JVM 进程。

- Client 为提交 Job 的客户端,可以是运行在任何机器上(与 JobManager 环境连通即可)。提交 Job 后,Client 可以结束进程(Streaming的任务),也可以不结束并等待结果返回。

- JobManager 主要负责从 Client 处接收到 Job 和 JAR 包等资源后,会生成优化后的执行计划,并以 Task 的单元调度到各个 TaskManager 去执行。

- TaskManager 在启动的时候就设置好了槽位数(Slot),每个 slot 能启动一个 Task,Task 为线程。从 JobManager 处接收需要部署的 Task,部署启动后,与自己的上游建立 Netty 连接,接收数据并处理。

- flnik架构中的角色间的通信使用Akka,数据的传输使用Netty

5.Task Slot

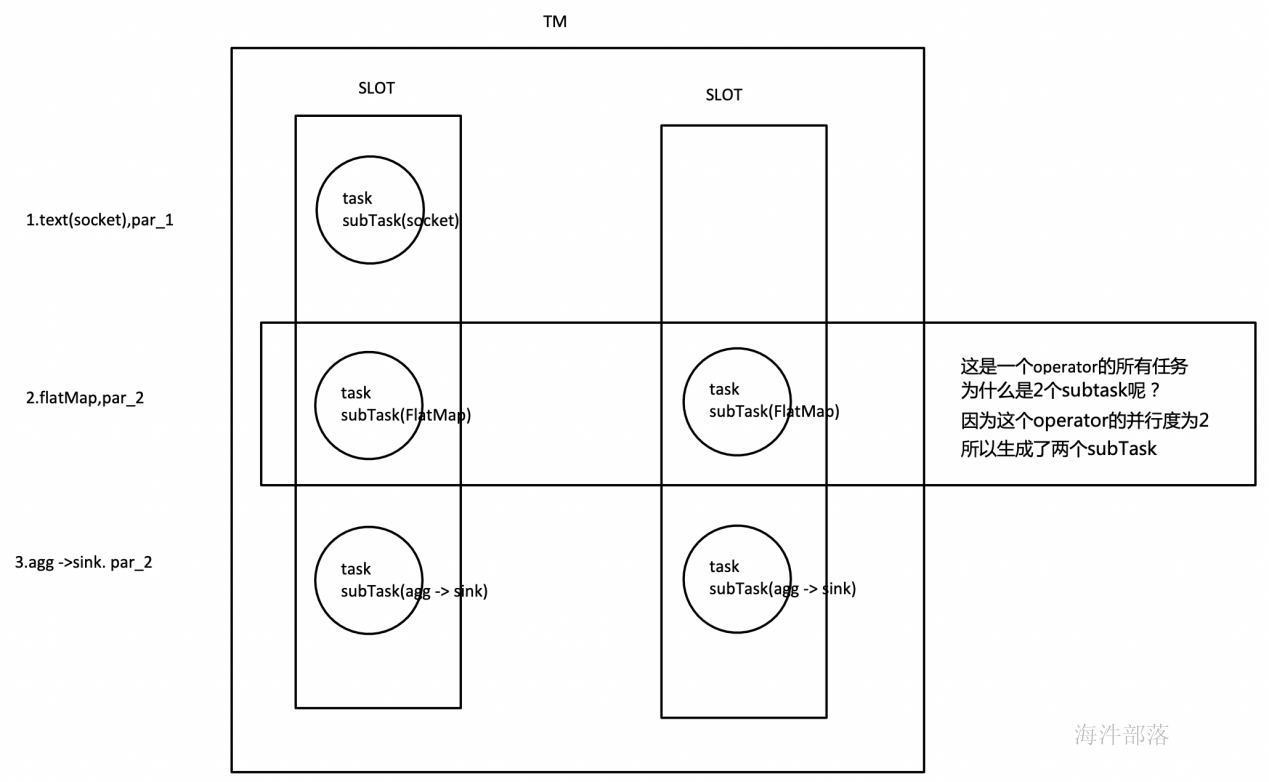

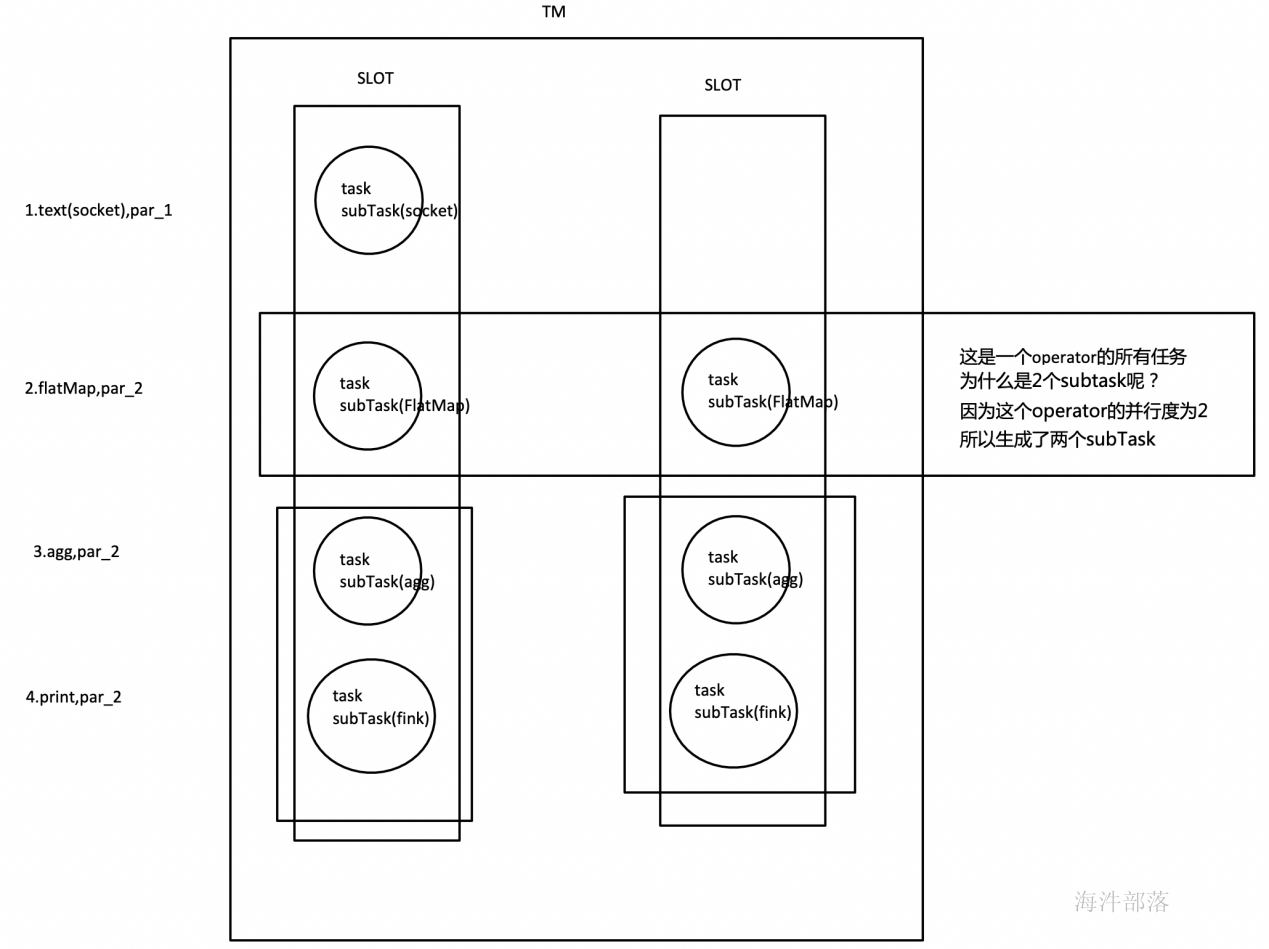

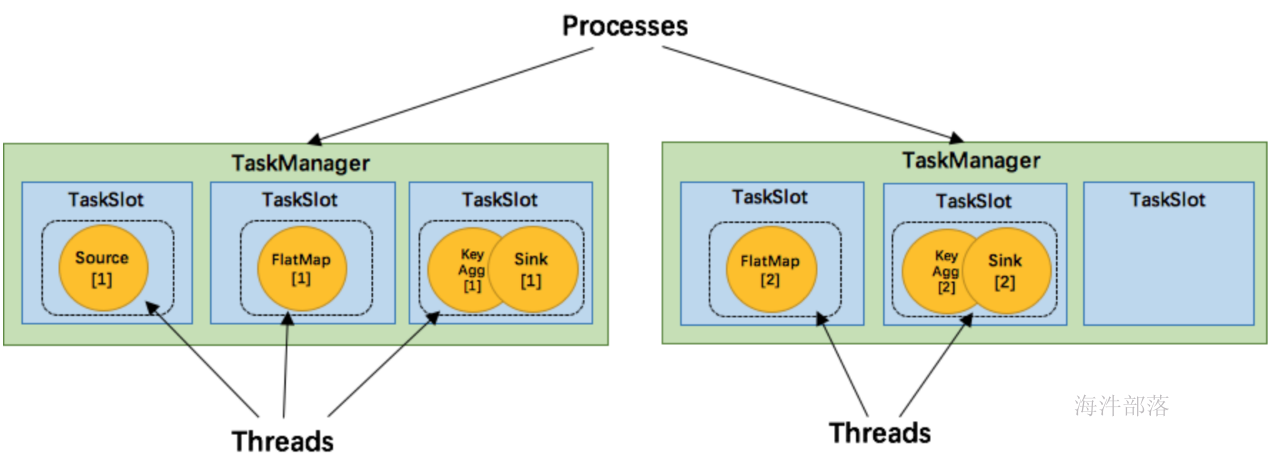

在上图中我们介绍了 TaskManager 是一个 JVM 进程,并会以独立的线程来执行一个task或多个subtask。为了控制一个 TaskManager 能接受多少个 task,Flink 提出了 Task Slot 的概念。

Flink 中的计算资源通过 Task Slot 来定义。每个 task slot 代表了 TaskManager 的一个固定大小的资源子集。例如,一个拥有3个slot的 TaskManager,会将其管理的内存平均分成三分分给各个 slot。将资源 slot 化意味着来自不同job的task不会为了内存而竞争,而是每个task都拥有一定数量的内存储备。需要注意的是,这里不会涉及到CPU的隔离,slot目前仅仅用来隔离task的内存。

通过调整 task slot 的数量,用户可以定义task之间是如何相互隔离的。每个 TaskManager 有一个slot,也就意味着每个task运行在独立的 JVM 中。每个 TaskManager 有多个slot的话,也就是说多个task运行在同一个JVM中。而在同一个JVM进程中的task,可以共享TCP连接(基于多路复用)和心跳消息,可以减少数据的网络传输。也能共享一些数据结构,一定程度上减少了每个task的消耗。

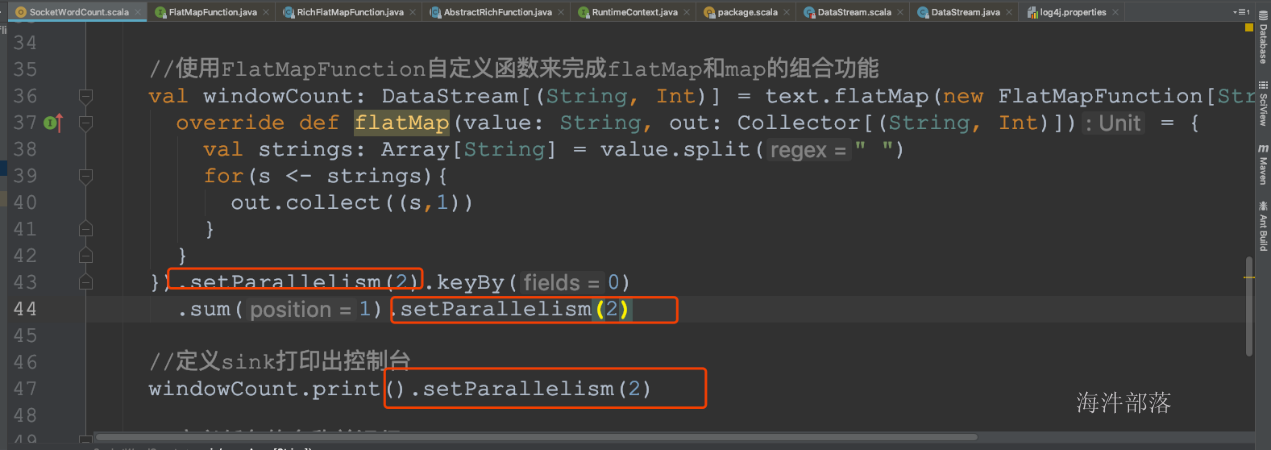

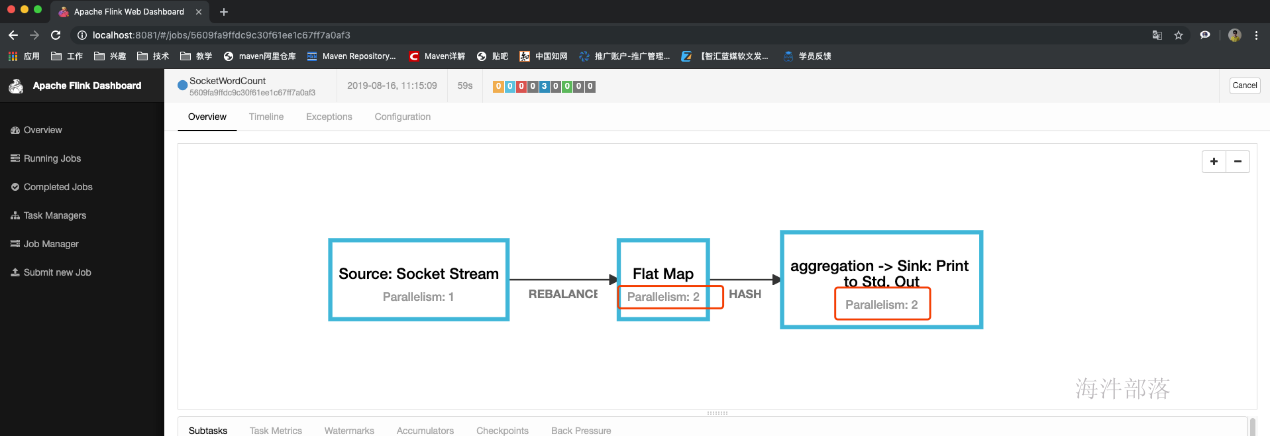

6.task的并行度

通过job的webUI界面查看任务的并行度

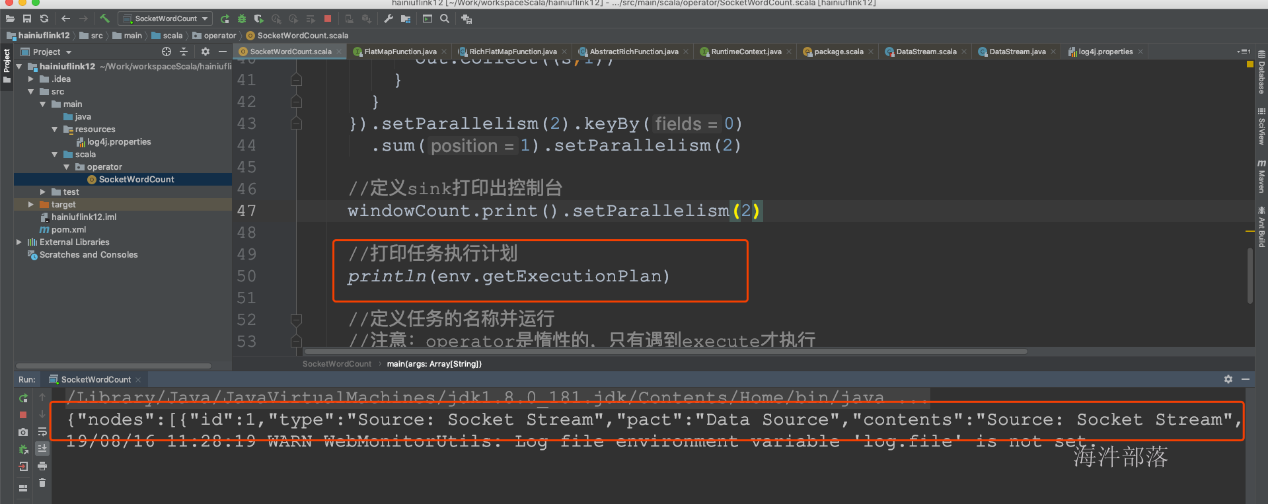

7.任务执行计划

生成个json字符串然后粘贴在这里https://flink.apache.org/visualizer/会看到任务执行图

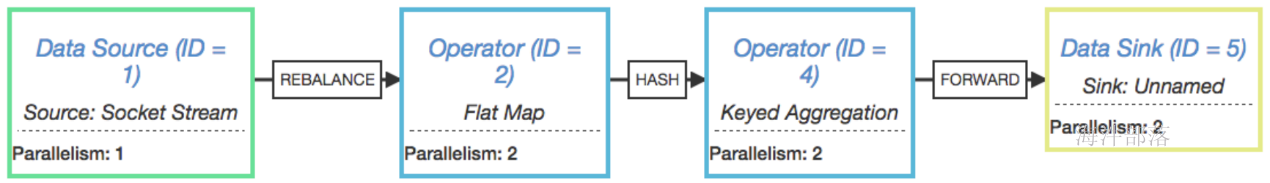

但这并不是最终在 Flink 中运行的执行图,只是一个表示拓扑节点关系的计划图,在 Flink 中对应了 SteramGraph。另外,提交拓扑后(并发度设为2)还能在 UI 中看到另一张执行计划图,如下所示,该图对应了 Flink 中的 JobGraph。

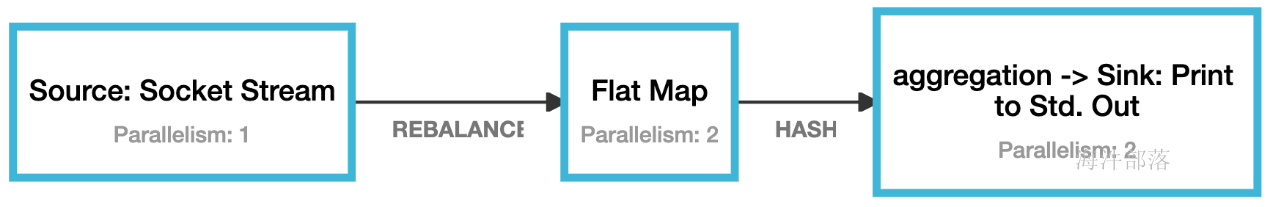

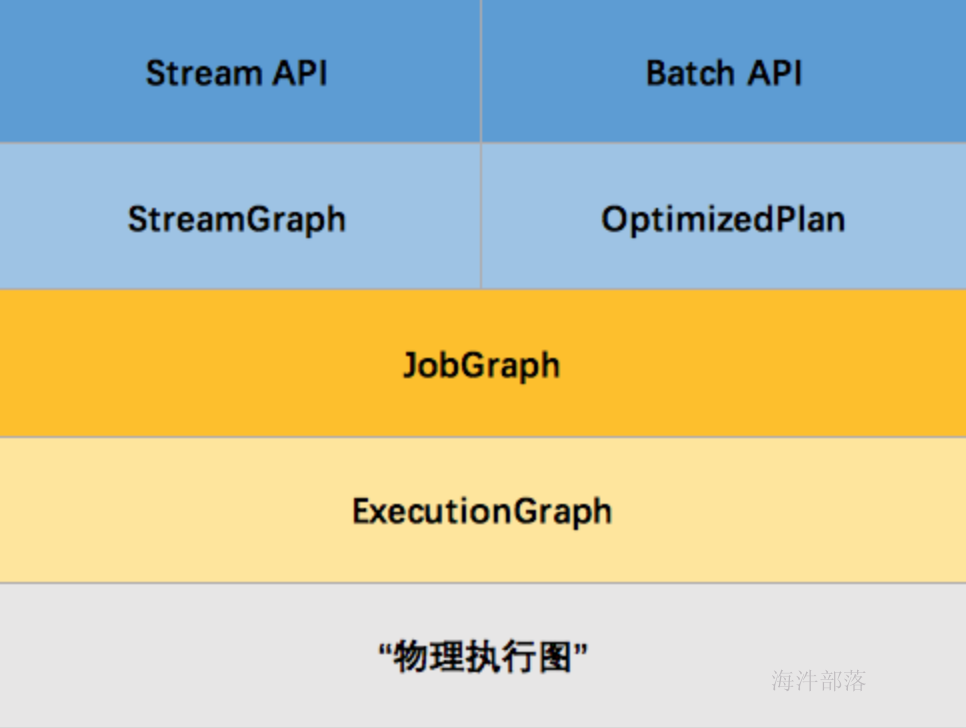

其实Flink 中的执行图可以分成四层:StreamGraph -> JobGraph -> ExecutionGraph -> 物理执行图

- StreamGraph:是根据用户通过 Stream API 编写的代码生成的最初的图。用来表示程序的拓扑结构。

- JobGraph:StreamGraph经过优化后生成了 JobGraph,提交给 JobManager 的数据结构。主要的优化为,将多个符合条件的节点 chain 在一起作为一个节点,这样可以减少数据在节点之间流动所需要的序列化/反序列化/传输消耗。

- ExecutionGraph:JobManager 根据 JobGraph 生成ExecutionGraph。ExecutionGraph是JobGraph的并行化版本,是调度层最核心的数据结构。

- 物理执行图:JobManager 根据 ExecutionGraph 对 Job 进行调度后,在各个TaskManager 上部署 Task 后形成的“图”,并不是一个具体的数据结构。

例如上文中的2个并发度(Source为1个并发度)的 SocketTextStreamWordCount 四层执行图的演变过程如下图所示:

那么 Flink 为什么要设计这4张图呢,其目的是什么呢?Spark 中也有多张图,数据依赖图以及物理执行的DAG。其目的都是一样的,就是解耦,每张图各司其职,每张图对应了 Job 不同的阶段,更方便做该阶段的事情。我们给出更完整的 Flink Graph 的层次图。

首先我们看到,JobGraph 之上除了 StreamGraph 还有 OptimizedPlan。OptimizedPlan 是由 Batch API 转换而来的。StreamGraph 是由 Stream API 转换而来的。为什么 API 不直接转换成 JobGraph?因为,Batch 和 Stream 的图结构和优化方法有很大的区别,比如 Batch 有很多执行前的预分析用来优化图的执行,而这种优化并不普适于 Stream,所以通过 OptimizedPlan 来做 Batch 的优化会更方便和清晰,也不会影响 Stream。JobGraph 的责任就是统一 Batch 和 Stream 的图,用来描述清楚一个拓扑图的结构,并且做了 chaining 的优化,chaining 是普适于 Batch 和 Stream 的,所以在这一层做掉。ExecutionGraph 的责任是方便调度和各个 tasks 状态的监控和跟踪,所以 ExecutionGraph 是并行化的 JobGraph。而“物理执行图”就是最终分布式在各个机器上运行着的tasks了。所以可以看到,这种解耦方式极大地方便了我们在各个层所做的工作,各个层之间是相互隔离的。

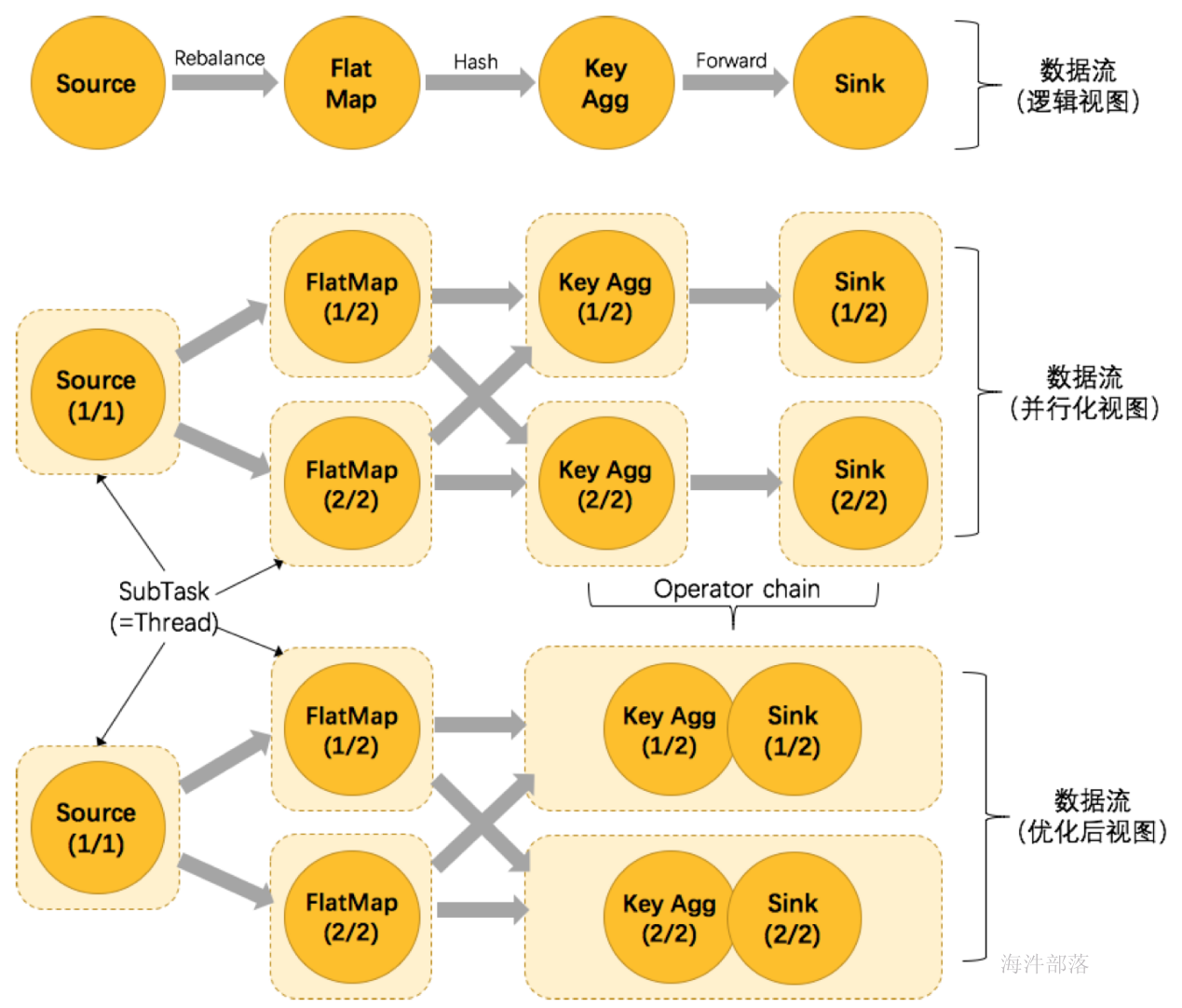

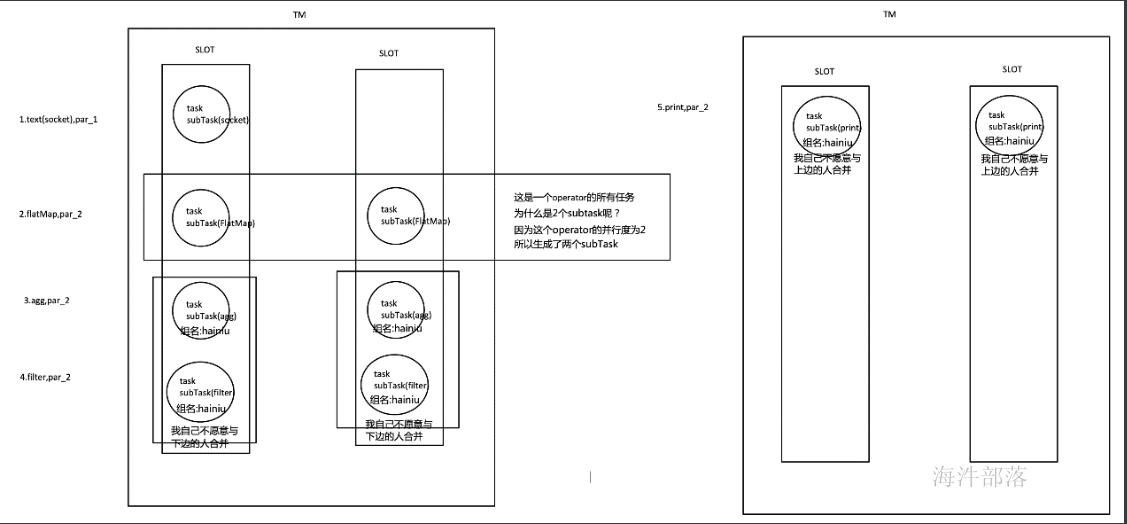

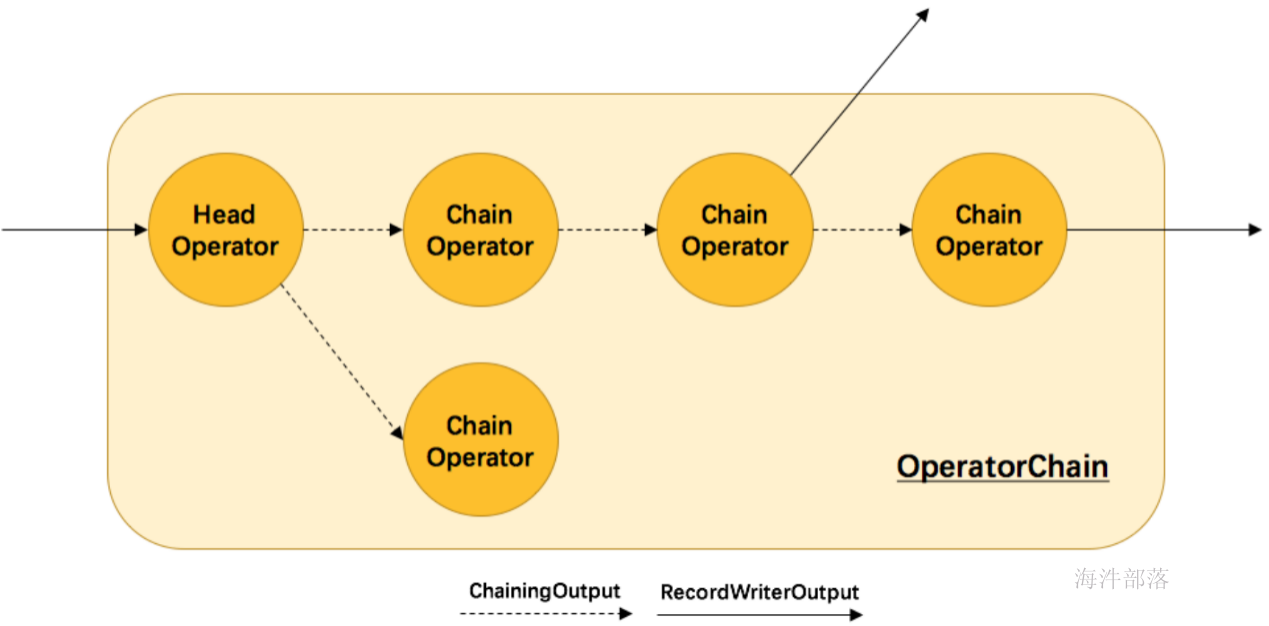

8.Operator Chains

为了更高效地分布式执行,Flink会尽可能地将operator的subtask链接(chain)在一起形成task。每个task在一个线程中执行。将operators链接成task是非常有效的优化:它能减少线程之间的切换,减少消息的序列化/反序列化,减少数据在缓冲区的交换,减少了延迟的同时提高整体的吞吐量。

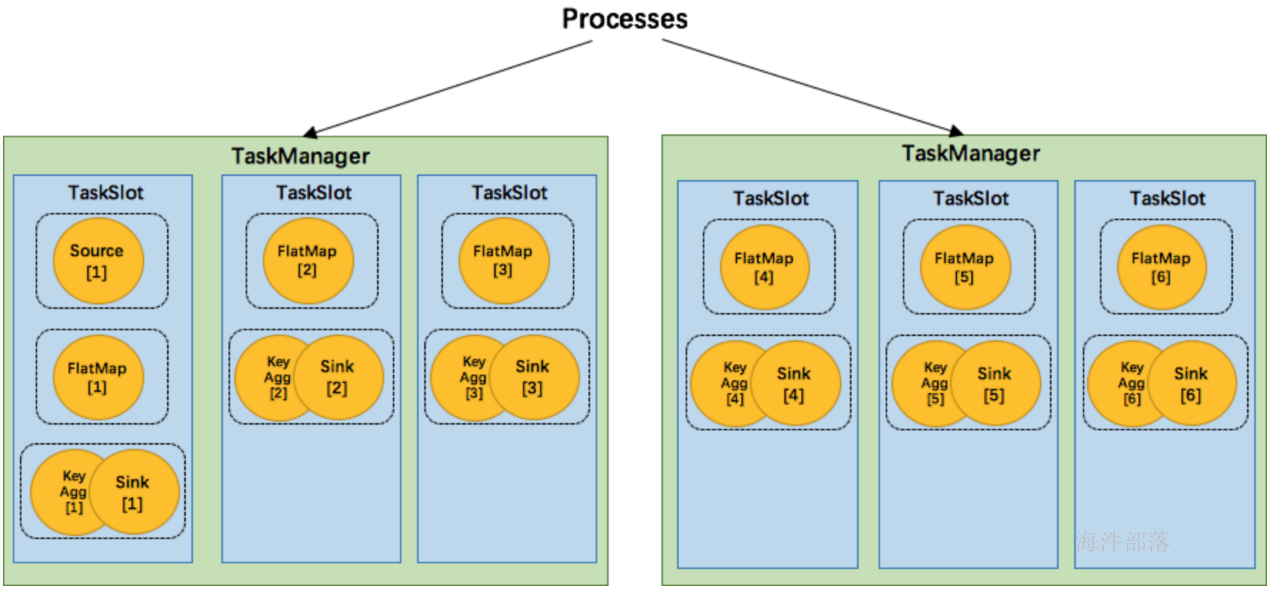

我们仍以上面的 WordCount 为例,下面这幅图,展示了Source并行度为1,FlatMap、KeyAggregation、Sink并行度均为2,最终以5个并行的线程来执行的优化过程。

上图中将KeyAggregation和Sink两个operator进行了合并,因为这两个合并后并不会改变整体的拓扑结构。但是,并不是任意两个 operator 就能 chain 一起的。其条件还是很苛刻的:

- 上下游的并行度一致

- 下游节点的入度为1 (也就是说下游节点没有来自其他节点的输入)

- 上下游节点都在同一个 slot group 中(下面会解释 slot group)

- 下游节点的 chain 策略为 ALWAYS(可以与上下游链接,map、flatmap、filter等默认是ALWAYS)

- 上游节点的 chain 策略为 ALWAYS 或 HEAD(只能与下游链接,不能与上游链接,Source默认是HEAD)

- 上下游算子之间没有数据shuffle (数据分区方式是 forward)

- 用户没有禁用 chain

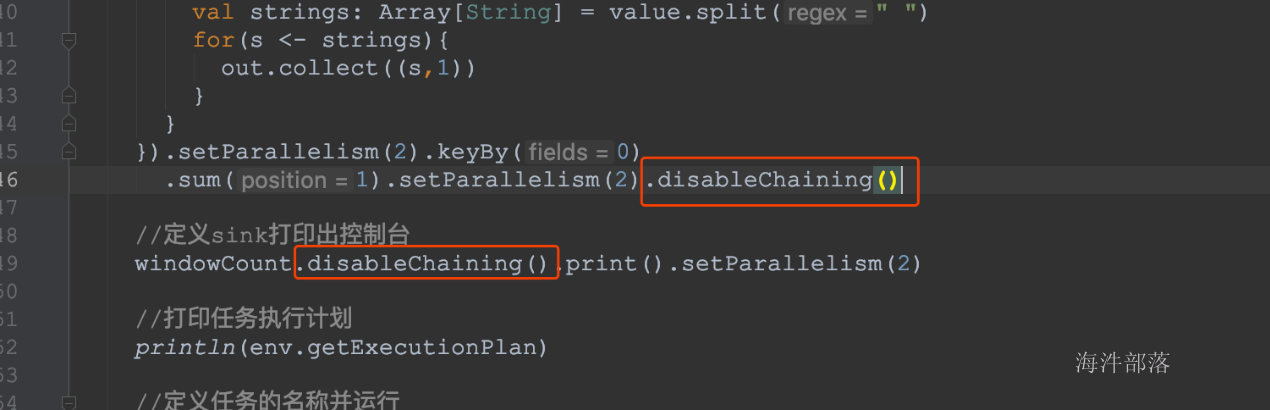

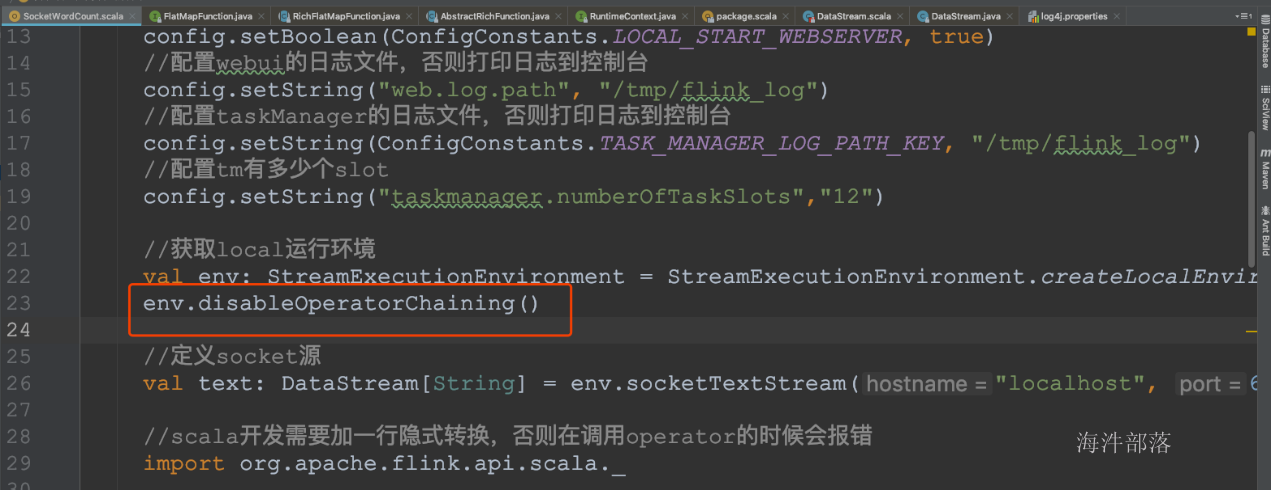

Operator chain的行为可以通过编程API中进行指定。可以通过在DataStream的operator后面(如someStream.map(..))调用startNewChain()来指示从该operator开始一个新的chain(与前面截断,不会被chain到前面)。或者调用disableChaining()来指示该operator不参与chaining(不会与前后的operator chain一起)。在底层,这两个方法都是通过调整operator的 chain 策略(HEAD、NEVER)来实现的。另外,也可以通过调用StreamExecutionEnvironment.disableOperatorChaining()来全局禁用chaining。

代码验证:

- operator禁用chaining

- 全局禁用chaining

查看job的graph图

OperatorChain的优缺点:

那么 Flink 是如何将多个 operators chain在一起的呢?chain在一起的operators是如何作为一个整体被执行的呢?它们之间的数据流又是如何避免了序列化/反序列化以及网络传输的呢?下图展示了operators chain的内部实现:

如上图所示,Flink内部是通过OperatorChain这个类来将多个operator链在一起形成一个新的operator。OperatorChain形成的框框就像一个黑盒,Flink 无需知道黑盒中有多少个ChainOperator、数据在chain内部是怎么流动的,只需要将input数据交给 HeadOperator 就可以了,这就使得OperatorChain在行为上与普通的operator无差别,上面的OperaotrChain就可以看做是一个入度为1,出度为2的operator。所以在实现中,对外可见的只有HeadOperator,以及与外部连通的实线输出,这些输出对应了JobGraph中的JobEdge,在底层通过RecordWriterOutput来实现。另外,框中的虚线是operator chain内部的数据流,这个流内的数据不会经过序列化/反序列化、网络传输,而是直接将消息对象传递给下游的 ChainOperator 处理,这是性能提升的关键点,在底层是通过 ChainingOutput 实现的

OperatorChain的优点总结:

- 减少线程切换

- 减少序列化与反序列化

- 减少数据在缓冲区的交换

- 减少延迟并且提高吞吐能力

OperatorChain的缺点总结:

- 可能会让N个比较复杂的业务跑在一个slot中,本来一个业务就慢,这发生这种情况就更慢了,所以可以通过startNewChain()/disableChaining()或全局禁用disableOperatorChaining()给分开

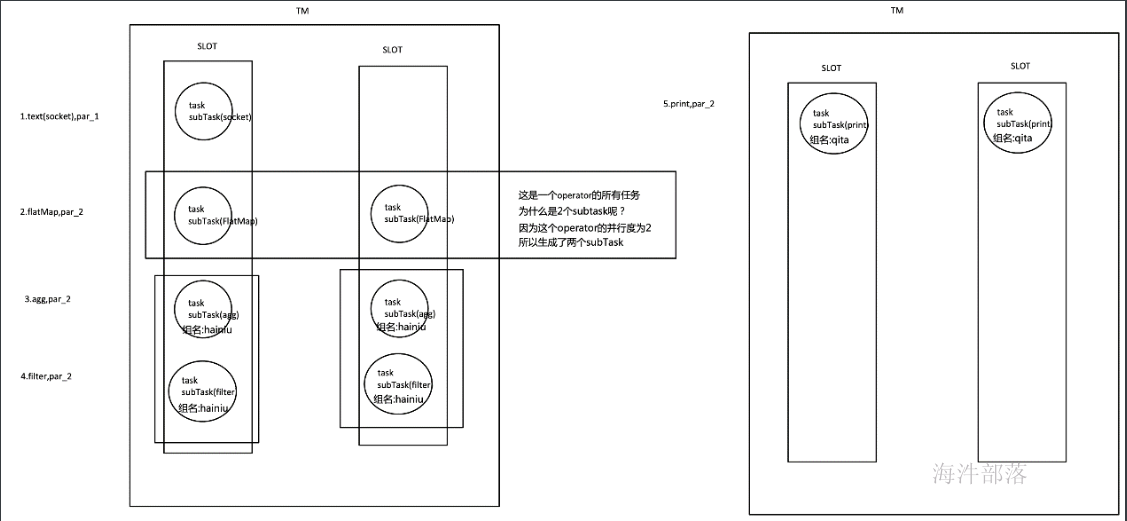

9.SlotSharingGroup 与 CoLocationGroup

每一个 TaskManager 会拥有一个或多个的 task slot,每个 slot 都能跑由多个连续 task 组成的一个 pipeline,比如 MapFunction 的第n个并行实例和 ReduceFunction 的第n个并行实例可以组成一个 pipeline。

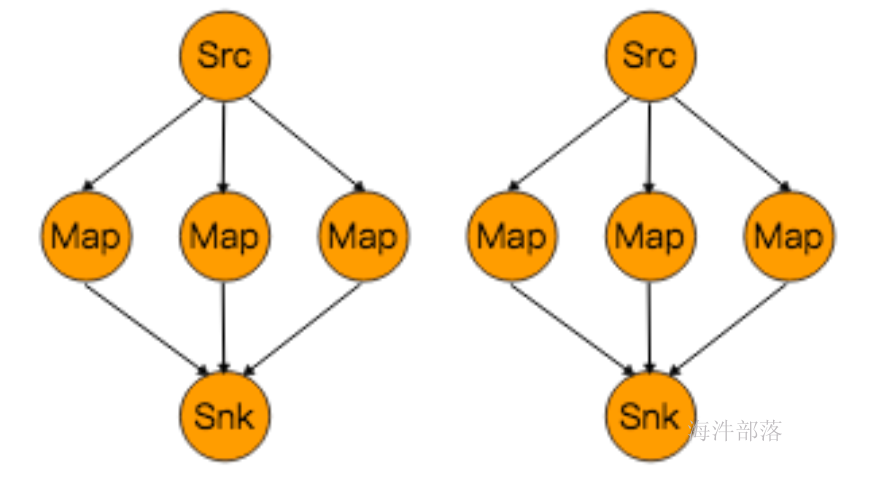

如上文所述的 WordCount 例子,5个Task没有solt共享的时候在TaskManager的slots中如下图分布,2个TaskManager,每个有3个slot:

默认情况下,Flink 允许subtasks共享slot,条件是它们都来自同一个Job的不同task的subtask。结果可能一个slot持有该job的整个pipeline。允许slot共享有以下两点好处:

- Flink 集群所需的task slots数与job中最高的并行度一致。

- 更容易获得更充分的资源利用。如果没有slot共享,那么非密集型操作source/flatmap就会占用同密集型操作 keyAggregation/sink 一样多的资源。如果有slot共享,将基线的2个并行度增加到6个,能充分利用slot资源,同时保证每个TaskManager能平均分配到相同数量的subtasks。

我们将 WordCount 的并行度从之前的2个增加到6个(Source并行度仍为1),并开启slot共享(所有operator都在default共享组),将得到如上图所示的slot分布图。该任务最终会占用6个slots(最高并行度为6)。其次,我们可以看到密集型操作 keyAggregation/sink 被平均地分配到各个 TaskManager。

SlotSharingGroup:

- SlotSharingGroup是Flink中用来实现slot共享的类,它尽可能地让subtasks共享一个slot。

- 保证同一个group的并行度相同的sub-tasks 共享同一个slots

- 算子的默认group为default(即默认一个job下的subtask都可以共享一个slot)

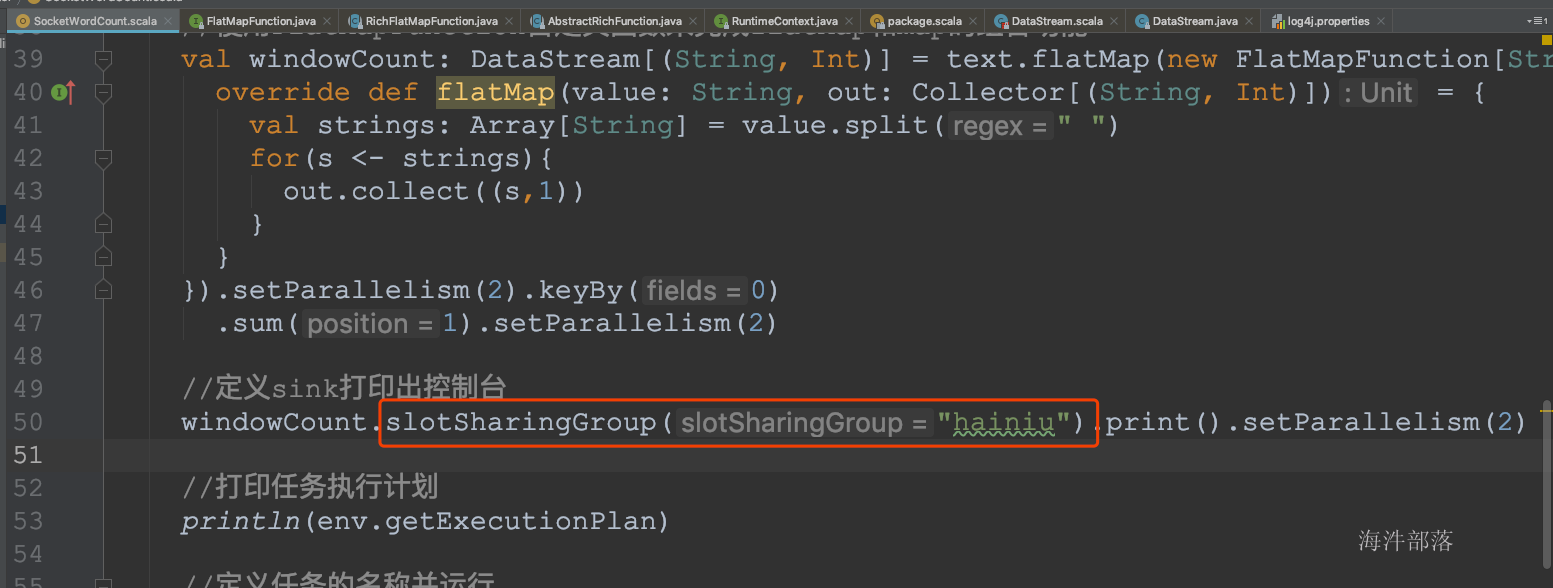

- 为了防止不合理的共享,用户也能通过API来强制指定operator的共享组,比如:someStream.filter(...).slotSharingGroup("group1");就强制指定了filter的slot共享组为group1。

- 怎么确定一个未做SlotSharingGroup设置的算子的Group是什么呢(根据上游算子的 group和自身是否设置group共同确定)

- 适当设置可以减少每个slot运行的线程数,从而整体上减少机器的负载

CoLocationGroup(强制):

- 保证所有的并行度相同的sub-tasks运行在同一个slot

- 主要用于迭代流(训练机器学习模型)

代码验证:

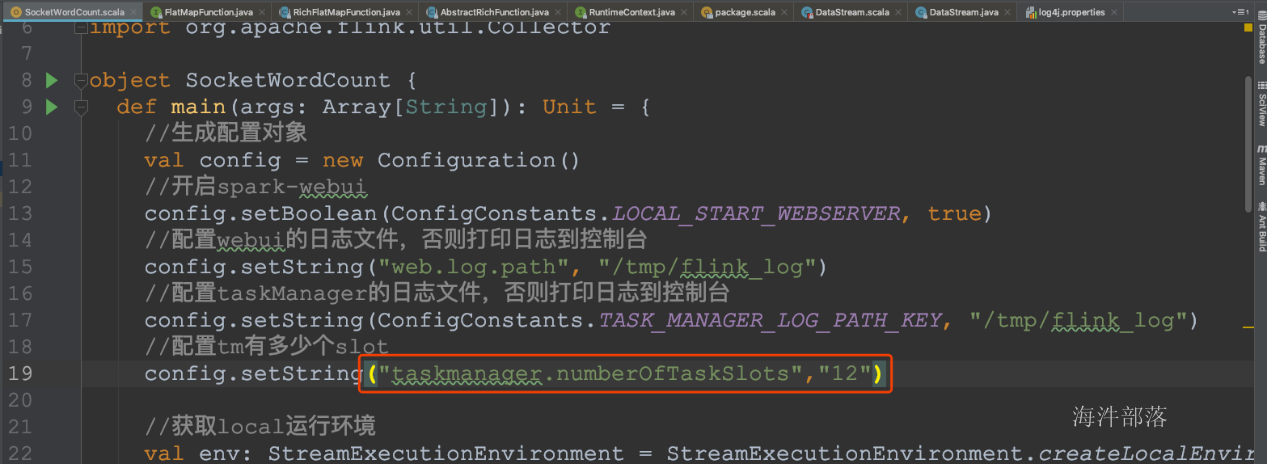

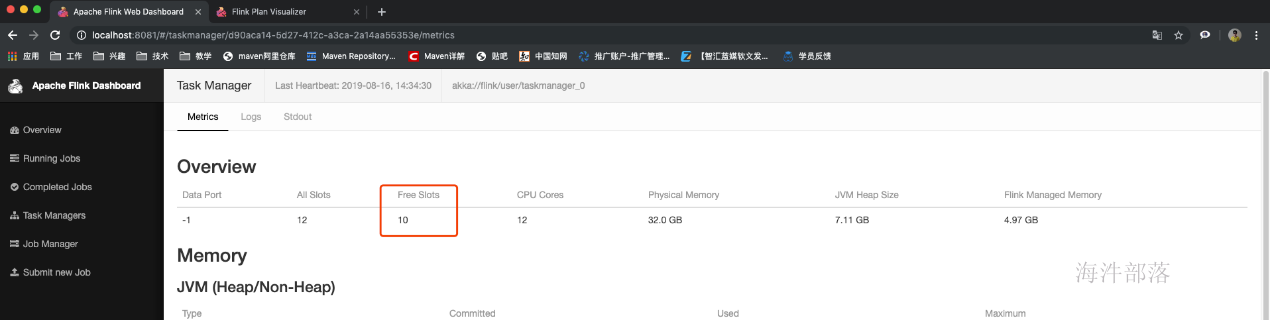

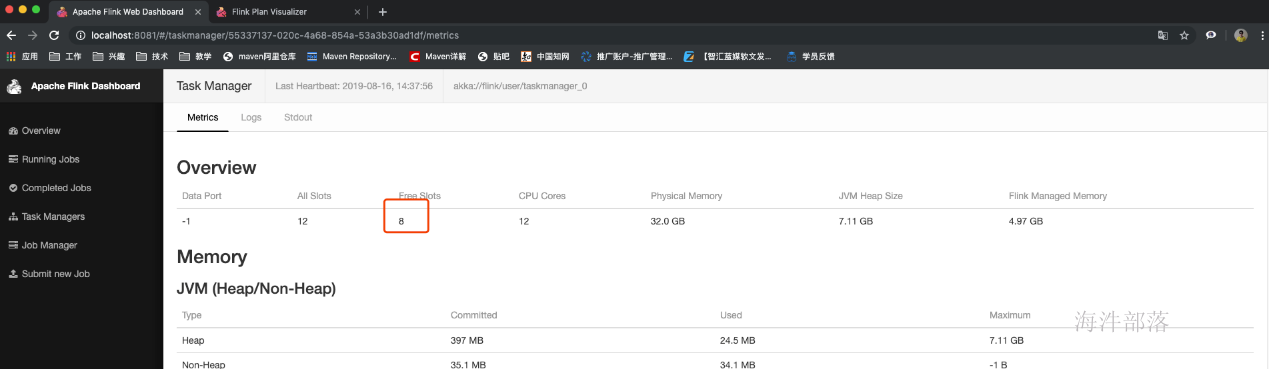

- 设置本地开发环境tm的slot数量

- 设置最后的operator使用新的group

- 由于不和前面的operator在一个group,无法进行slot的共享,所以最后的operator占用了其它slot

- 为什么占用了两个呢?

- 因为不同组,与上面的default不能共享slot,组间互斥

- 同组中的同一个operator的subtask不能在一个slot中,由于operator的并行度是2,所以占用了两个槽位,subtask组内互斥

原理与实现

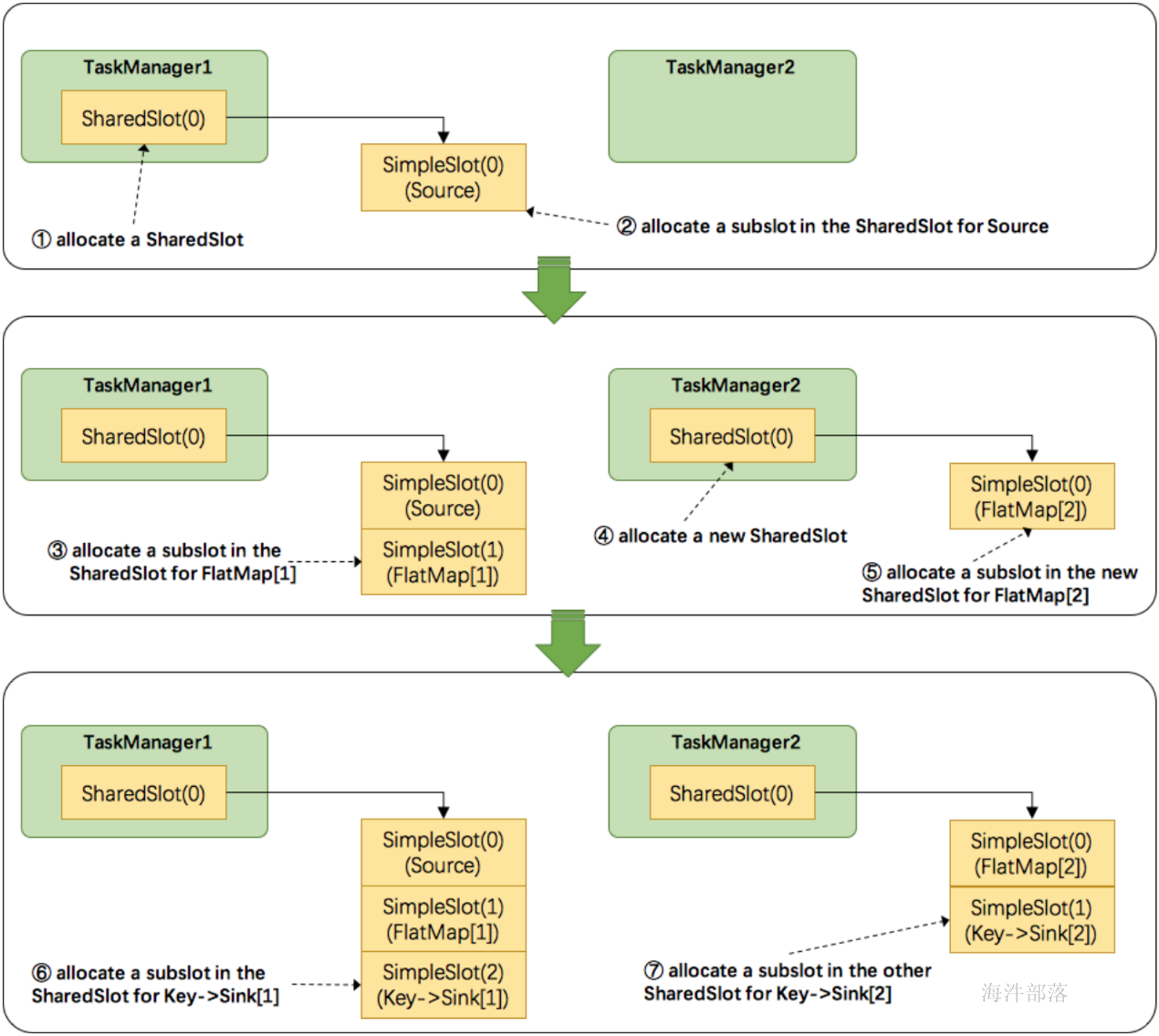

那么多个tasks(或者说operators)是如何共享slot的呢?

关于Flink调度,有两个非常重要的原则我们必须知道:

- 同一个operator的各个subtask是不能呆在同一个SharedSlot中的,例如FlatMap[1]和FlatMap[2]是不能在同一个SharedSlot中的。

- Flink是按照拓扑顺序从Source一个个调度到Sink的。例如WordCount(Source并行度为1,其他并行度为2),那么调度的顺序依次是:Source -> FlatMap[1] -> FlatMap[2] -> KeyAgg->Sink[1] -> KeyAgg->Sink[2]。假设现在有2个TaskManager,每个只有1个slot(为简化问题),那么分配slot的过程如图所示:

注:图中 SharedSlot 与 SimpleSlot 后带的括号中的数字代表槽位号(slotNumber)

- 为Source分配slot。首先,我们从TaskManager1中分配出一个SharedSlot。并从SharedSlot中为Source分配出一个SimpleSlot。如上图中的①和②。

- 为FlatMap[1]分配slot。目前已经有一个SharedSlot,则从该SharedSlot中分配出一个SimpleSlot用来部署FlatMap[1]。如上图中的③。

- 为FlatMap[2]分配slot。由于TaskManager1的SharedSlot中已经有同operator的FlatMap[1]了,我们只能分配到其他SharedSlot中去。从TaskManager2中分配出一个SharedSlot,并从该SharedSlot中为FlatMap[2]分配出一个SimpleSlot。如上图的④和⑤。

- 为Key->Sink[1]分配slot。目前两个SharedSlot都符合条件,从TaskManager1的SharedSlot中分配出一个SimpleSlot用来部署Key->Sink[1]。如上图中的⑥。

- 为Key->Sink[2]分配slot。TaskManager1的SharedSlot中已经有同operator的Key->Sink[1]了,则只能选择另一个SharedSlot中分配出一个SimpleSlot用来部署Key->Sink[2]。如上图中的⑦。

最后Source、FlatMap[1]、Key->Sink[1]这些subtask都会部署到TaskManager1的唯一一个slot中,并启动对应的线程。FlatMap[2]、Key->Sink[2]这些subtask都会被部署到TaskManager2的唯一一个slot中,并启动对应的线程。从而实现了slot共享。

Flink中计算资源的相关概念以及原理实现。最核心的是 Task Slot,每个slot能运行一个或多个task。为了拓扑更高效地运行,Flink提出了Chaining,尽可能地将operators chain在一起作为一个task来处理。为了资源更充分的利用,Flink又提出了SlotSharingGroup,尽可能地让多个task共享一个slot。

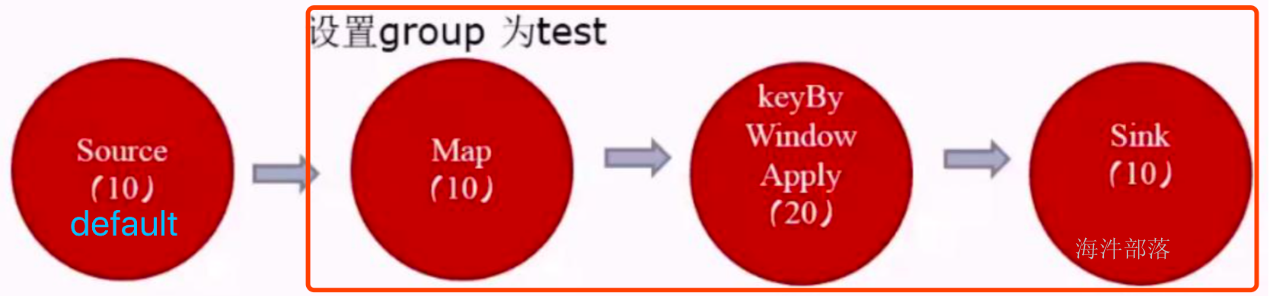

10.如何计算一个应用需要多少slot

- 不设置SlotSharingGroup,就是不设置新的组大家都为default组。(应用的最大并行度)

- 设置SlotSharingGroup ,就是设置了新的组,比如下图有两个组default和test组(所有SlotSharingGroup中的最大并行度之和)

由于source和map之后的operator不属于同一个group,所以source和它们不能在一个solt中运行,而这里的source的default组的并行度是10,test组的并行度是20,所以所需槽位一共是30

11.运行时概念总结

- Job

- Operator

- Parallelism

- Task 与 subtask(线程)

- Chain

- SlotSharingGroup

- CoLocationGroup

- Jobmanger

- TaskManger

- TaskManager Slots

4.flink开发source、operator、sink

1.计算模型

2.DataSource

输入Controlling Latency(控制延迟)

默认情况下,流中的元素并不会一个一个的在网络中传输(这会导致不必要的网络流量消耗) ,而是缓存起来,缓存的大小可以在Flink的配置文件、 ExecutionEnvironment、在某个算子上进行配置(默认100ms)

- 好处:提高吞吐

- 坏处:增加了延迟

- 如何把握平衡

- 为了最大吞吐量,可以设置setBufferTimeout(-1),这会移除timeout机制,缓存中的数据一满就会被发送

- 为了最小的延迟,可以将超时设置为接近0的数(例如5或者10ms)

- 缓存的超时不要设置为0,因为设置为0会带来一些性能的损耗

内置数据源

- 基于文件

env.readTextFile("file:///path")

env.readFile(inputFormat, "file:///path");- 基于Socket

env.socketTextStream("localhost", 6666, '\n')- 基于Collection

env.socketTextStream("localhost", 6666, '\n')import org.apache.flink.api.scala._

env.fromCollection(List(1,2,3))

env.fromElements(1,2,3)

env.generateSequence(0, 1000) #不需要隐式转换自定义数据源

1.实现SourceFunction(非并行的)

示例代码:

function:

package com.hainiu.source;

import org.apache.flink.streaming.api.functions.source.SourceFunction;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataInputStream;

import org.apache.hadoop.fs.FileChecksum;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import java.io.BufferedReader;

import java.io.InputStreamReader;

public class FileCountryDictSourceFunction implements SourceFunction<String> {

private String md5 = null;

private Boolean isCancel = true;

private Integer interval = 10000;

@Override

public void run(SourceContext<String> ctx) throws Exception {

Path pathString = new Path("hdfs://ns1/user/qingniu/country_data");

Configuration hadoopConf = new Configuration();

FileSystem fs = FileSystem.get(hadoopConf);

while (isCancel) {

if(!fs.exists(pathString)){

Thread.sleep(interval);

continue;

}

FileChecksum fileChecksum = fs.getFileChecksum(pathString);

String md5Str = fileChecksum.toString();

String currentMd5 = md5Str.substring(md5Str.indexOf(":") + 1);

if (!currentMd5.equals(md5)) {

FSDataInputStream open = fs.open(pathString);

BufferedReader reader = new BufferedReader(new InputStreamReader(open));

String line = reader.readLine();

while (line != null) {

ctx.collect(line);

line = reader.readLine();

}

reader.close();

md5 = currentMd5;

}

Thread.sleep(interval);

}

}

@Override

public void cancel() {

isCancel = false;

}

}运行类:

package com.hainiu.source;

import org.apache.flink.streaming.api.datastream.DataStreamSource;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

public class FileSource {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

DataStreamSource<String> stringDataStreamSource = env.addSource(new FileCountryDictSourceFunction());

stringDataStreamSource.print();

env.execute();

}

}2.实现ParallelSourceFunction与RichParallelSourceFunction(并行的)

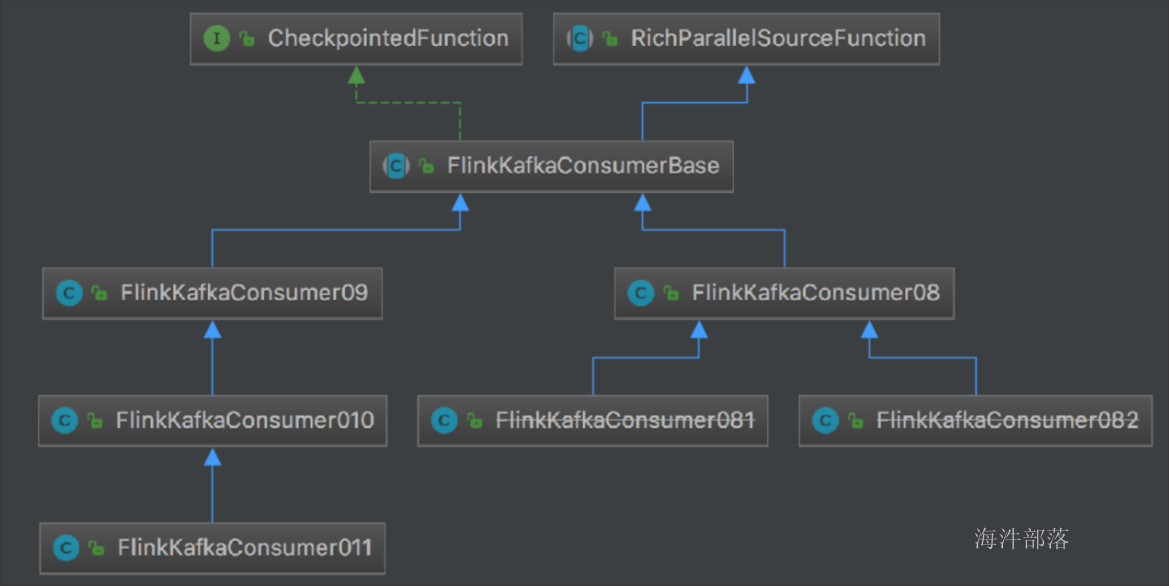

以Kafka-connector-source为代表

- 基于Kafka 的partition 机制,Flink实现了并行化数据切分

- Flink 可以消费Kafka的topic,和sink数据到Kafka

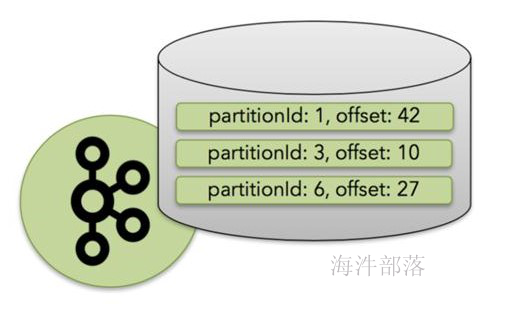

- 出现失败时,flink通过checkpoint机制来协调Kafka来恢复应用(通过设置kafka的offset)

引入依赖:

flink支持的kafka版本对比:

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-kafka-0.10_2.11</artifactId>

<version>1.9.3</version>

<scope>compile</scope>

</dependency>flink支持的kafka版本对比:

| Maven Dependency | 支持自 | Class name | Kafka版本 | 说明 |

|---|---|---|---|---|

| flink-connector-kafka- 0.8_2.11 | 1.0.0 | FlinkKafkaConsumer08 FlinkKafkaProducer08 | 0.8.x | 内部使用kakfa的 SimpleConsumer API 。 Flink把Offset提交给Zookeeper |

| flink-connector-kafka- 0.9_2.11 | 1.0.0 | FlinkKafkaConsumer09 FlinkKafkaProducer09 | 0.9.x | 使用kafka的new Consumer API Kafka. |

| flink-connector-kafka- 0.10_2.11 | 1.2.0 | FlinkKafkaConsumer010 FlinkKafkaProducer010 | 0.10.x | 生产和消费支持 Kafka messages with timestamps |

1).Flink KafkaConsumer 的Source API

1.FlinkKafkaConsumer010创建方式:

FlinkKafkaConsumer010(String topic, KeyedDeserializationSchema<T> deserializer, Properties props)

FlinkKafkaConsumer010(List<String> topics, DeserializationSchema<T> deserializer, Properties props)

FlinkKafkaConsumer010(List<String> topics, KeyedDeserializationSchema<T> deserializer, Properties props)

FlinkKafkaConsumer010(Pattern subscriptionPattern, KeyedDeserializationSchema<T> deserializer, Properties props)- 三个构造参数:

- 要消费的topic(topic name / topic names/正表达式)

- DeserializationSchema / KeyedDeserializationSchema(反序列化Kafka中的数据))

- Kafka consumer的属性,其中三个属性必须提供:

- bootstrap.servers(逗号分隔的Kafka broker列表)

- zookeeper.connect(逗号分隔的Zookeeper server列表,仅Kafka 0.8需要))

- group.id(consumer group id)

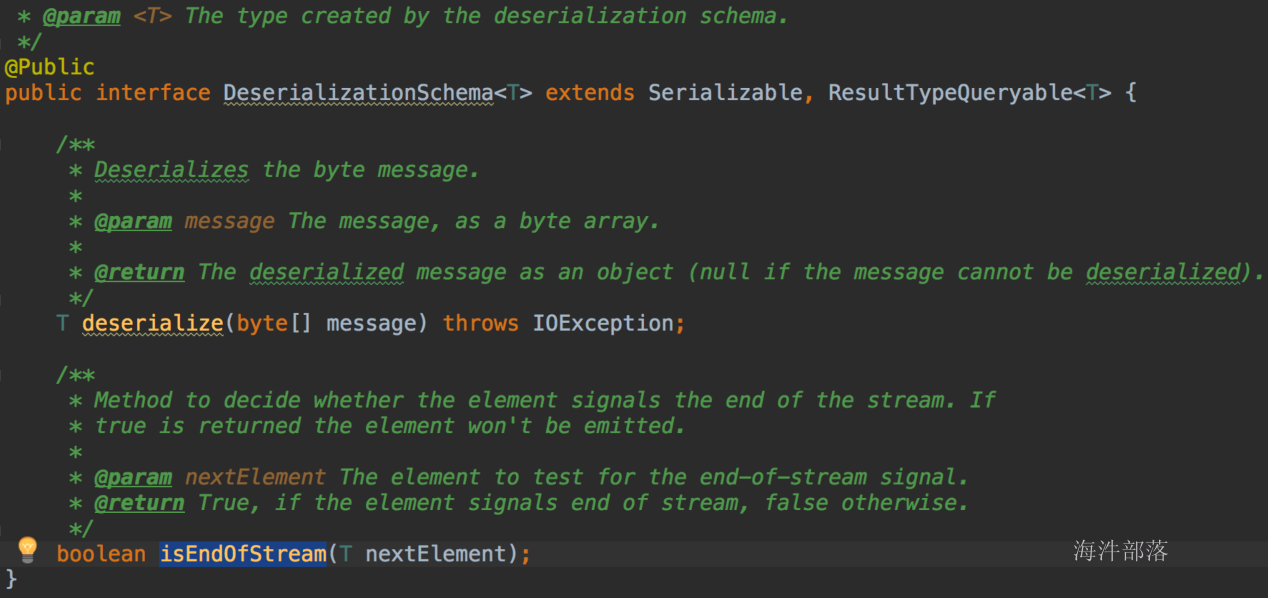

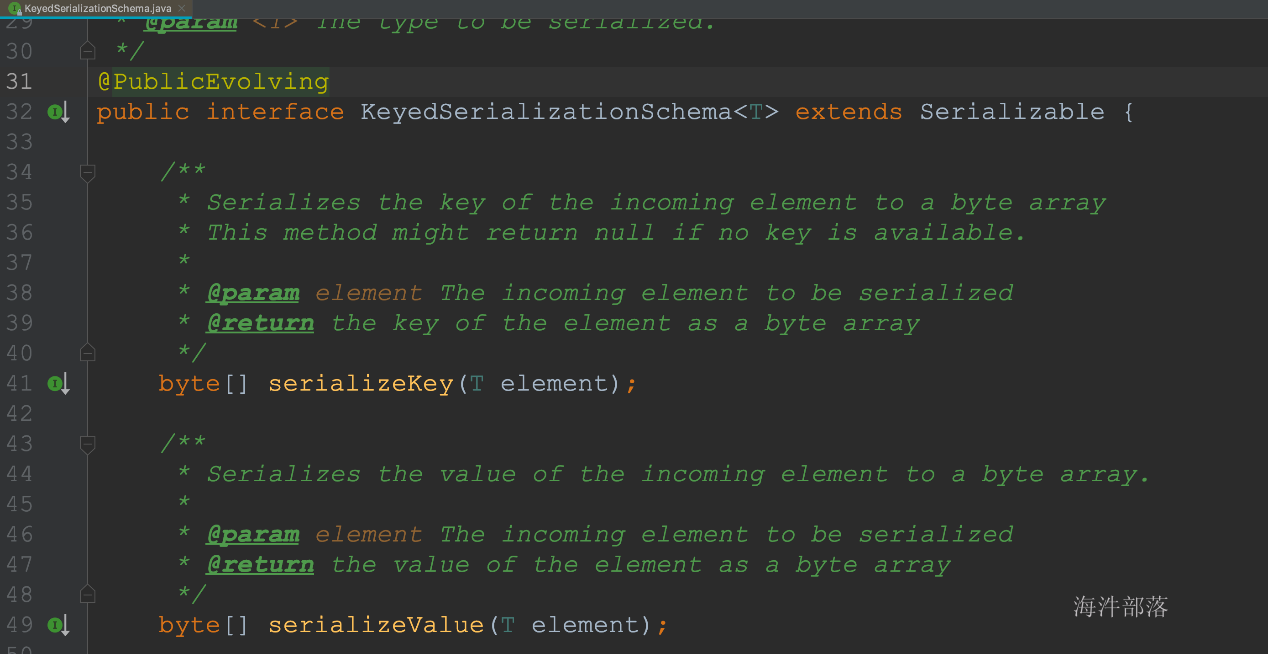

2.反序列化Schema类型

- 作用:对kafka里获取的二进制数据进行反序列化

- FlinkKafkaConsumer需要知道如何将Kafka中的二进制数据转换成Java/Scala对象,DeserializationSchema定义了该转换模式,通过T deserialize(byte[] message)

- FlinkKafkaConsumer从kafka获取的每条消息都会通过DeserializationSchema的T deserialize(byte[] message)反序列化处理

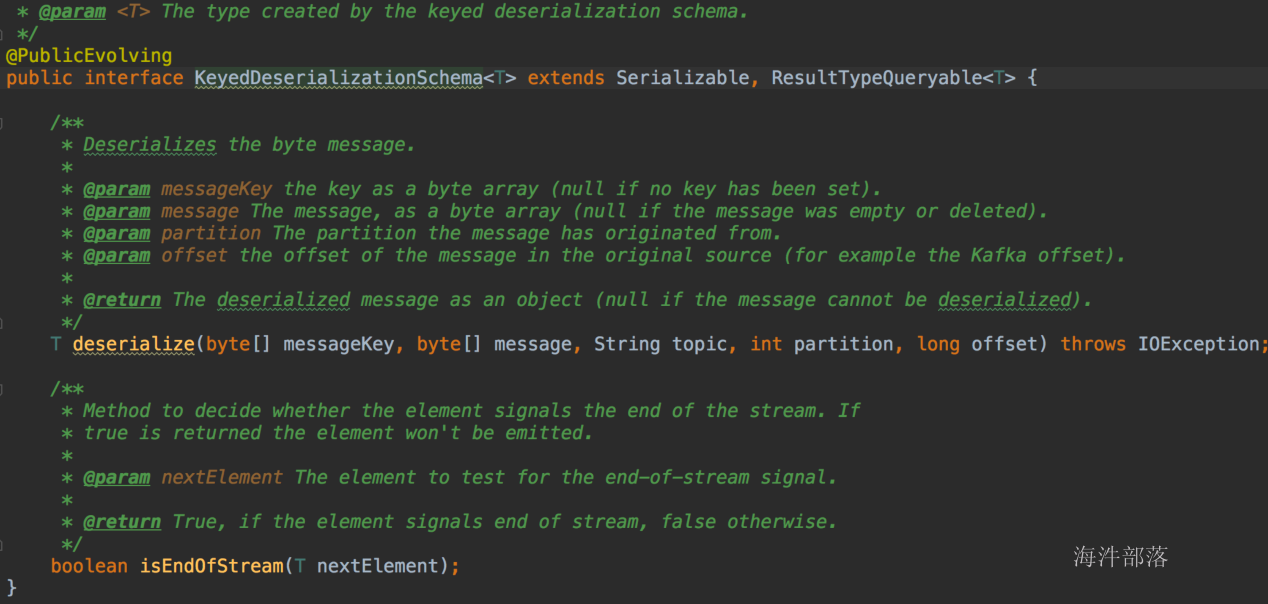

- 反序列化Schema类型(接口):

- DeserializationSchema(只反序列化value)

- KeyedDeserializationSchema

3.常见反序列化Schema

- SimpleStringSchema

- JSONDeserializationSchema / JSONKeyValueDeserializationSchema

- TypeInformationSerializationSchema / TypeInformationKeyValueSerializationSchema

- AvroDeserializationSchema

4.自定义反序列化Schema:

- 实现DeserializationSchema与KeyedDeserializationSchema接口

DeserializationSchema:

KeyedDeserializationSchema:

bean:

package com.hainiu.source;

public class HainiuKafkaRecord {

private String record;

public HainiuKafkaRecord(String record) {

this.record = record;

}

public String getRecord() {

return record;

}

public void setRecord(String record) {

this.record = record;

}

}schema:

package com.hainiu.source;

import org.apache.flink.api.common.serialization.DeserializationSchema;

import org.apache.flink.api.common.typeinfo.TypeInformation;

import java.io.IOException;

public class HainiuKafkaRecordSchema implements DeserializationSchema<HainiuKafkaRecord> {

@Override

public HainiuKafkaRecord deserialize(byte[] message) throws IOException {

HainiuKafkaRecord hainiuKafkaRecord = new HainiuKafkaRecord(new String(message));

return hainiuKafkaRecord;

}

@Override

public boolean isEndOfStream(HainiuKafkaRecord nextElement) {

return false;

}

@Override

public TypeInformation<HainiuKafkaRecord> getProducedType() {

return TypeInformation.of(HainiuKafkaRecord.class);

}

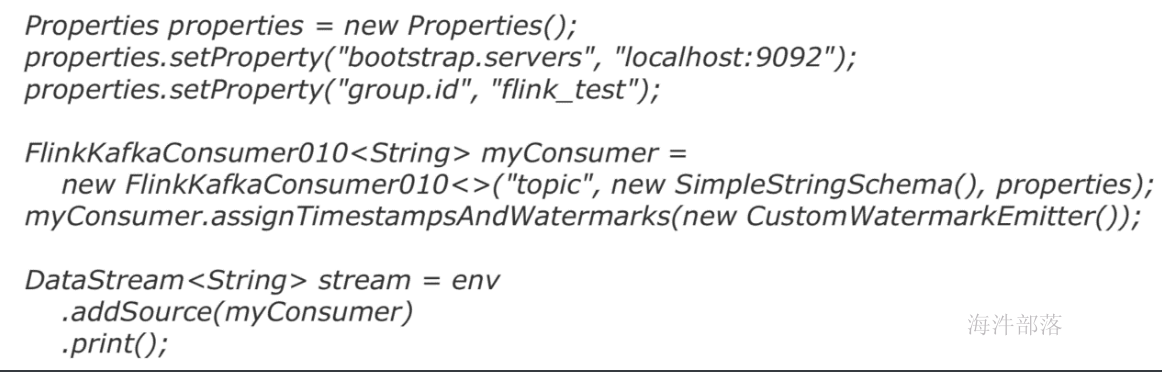

}5.FlinkKafkaConsumer010最简样版代码

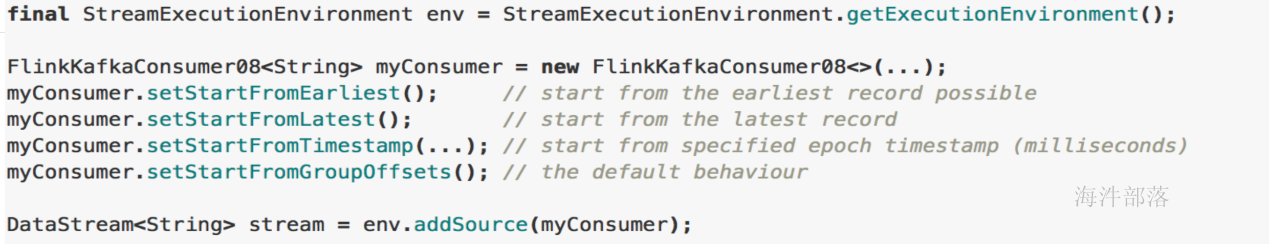

6.FlinkKafkaConsumer消费

| 消费模式 | 说明 | |

|---|---|---|

| setStartFromEarliest | 从队头开始,最早的记录 | 内部的Consumer提交到Kafka/zk中的偏移量将被忽略 |

| setStartFromLatest | 从队尾开始,最新的记录 | |

| setStartFromGroupOffsets() | 默认值,从当前消费组记录的偏移量开始,接着上次的偏移量消费 | 以Consumer提交到Kafka/zk中的偏移量最为起始位置开始消费, group.id设置在consumer的properties里; 如果没找到记录的偏移量,则使用consumer的properties的 auto.offset.reset设置的策略 |

| setStartFromSpecificOffsets(Map\<TopicPa rtition, Long>的参数) | 从指定的具体位置开始消费 | |

| setStartFromTimestamp(long) | 从指定的时间戳开始消费 | 对于每个分区,时间戳大于或等于指定时间戳的记录将用作起始位 置。如果一个分区的最新记录早于时间戳,那么只需要从最新记录 中读取该分区。在此模式下,Kafka/zk中提交的偏移量将被忽略 |

注意

- kafka 0.8版本, consumer提交偏移量到zookeeper,后续版本提交到kafka(一个特殊的topic: __consumer_offsets)

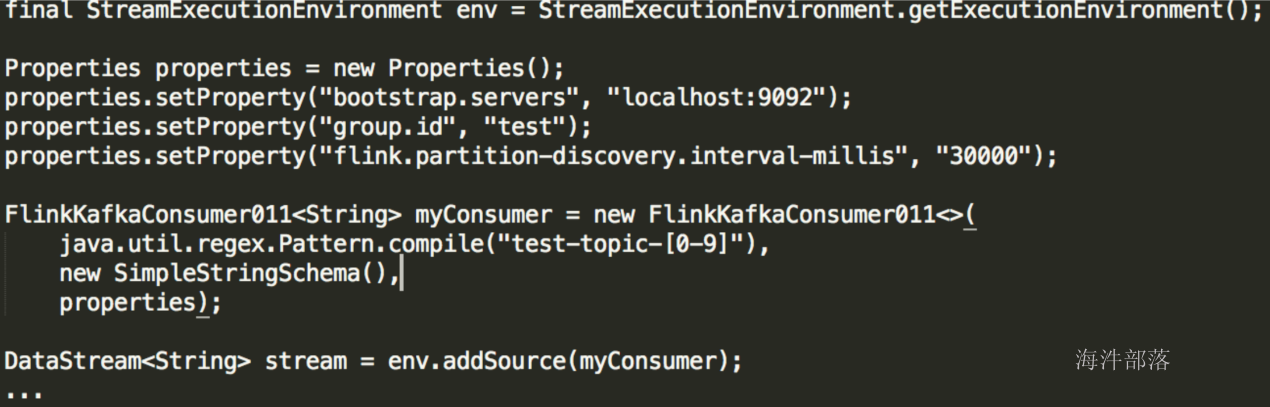

7.动态Partition discovery

- Flink Kafka Consumer支持动态发现Kafka分区,且能保证exactly-once

- 默认禁止动态发现分区,把flink.partition-discovery.interval-millis设置大于0即可启用:

properties.setProperty("flink.partition-discovery.interval-millis", "30000")

8.动态Topic discovery

- Flink Kafka Consumer支持动态发现Kafka Topic,仅限通过正则表达式指定topic的方式

- 默认禁止动态发现topic,把flink.partition-discovery.interval-millis设置大于0即可启用

示例代码:

package com.hainiu.source;

import org.apache.flink.api.common.serialization.SimpleStringSchema;

import org.apache.flink.streaming.api.datastream.DataStreamSource;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.connectors.kafka.FlinkKafkaConsumer010;

import java.util.Properties;

import java.util.regex.Pattern;

public class KafkaRichParallelSource {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

Properties kafkaConsumerProps = new Properties();

kafkaConsumerProps.setProperty("bootstrap.servers", "s1.hadoop:9092,s2.hadoop:9092,s3.hadoop:9092,s4.hadoop:9092,s5.hadoop:9092,s6.hadoop:9092,s7.hadoop:9092,s8.hadoop:9092");

kafkaConsumerProps.setProperty("group.id", "qingniuflink");

kafkaConsumerProps.setProperty("flink.partition-discovery.interval-millis", "30000");

FlinkKafkaConsumer010<String> kafkaSource = new FlinkKafkaConsumer010<>("flink_event", new SimpleStringSchema(), kafkaConsumerProps);

// FlinkKafkaConsumer010<String> kafkaSource = new FlinkKafkaConsumer010<>(Pattern.compile("flink_event_[0-9]"), new SimpleStringSchema(), kafkaConsumerProps);

// kafkaSource.setStartFromEarliest()

// kafkaSource.setStartFromGroupOffsets()

kafkaSource.setStartFromLatest();

DataStreamSource<String> kafkaInput = env.addSource(kafkaSource);

kafkaInput.print();

FlinkKafkaConsumer010<HainiuKafkaRecord> kafkaBeanSource = new FlinkKafkaConsumer010<>("flink_event", new HainiuKafkaRecordSchema(), kafkaConsumerProps);

DataStreamSource<HainiuKafkaRecord> kafkaBeanInput = env.addSource(kafkaBeanSource);

kafkaBeanInput.print();

env.execute();

}

}3.transformations

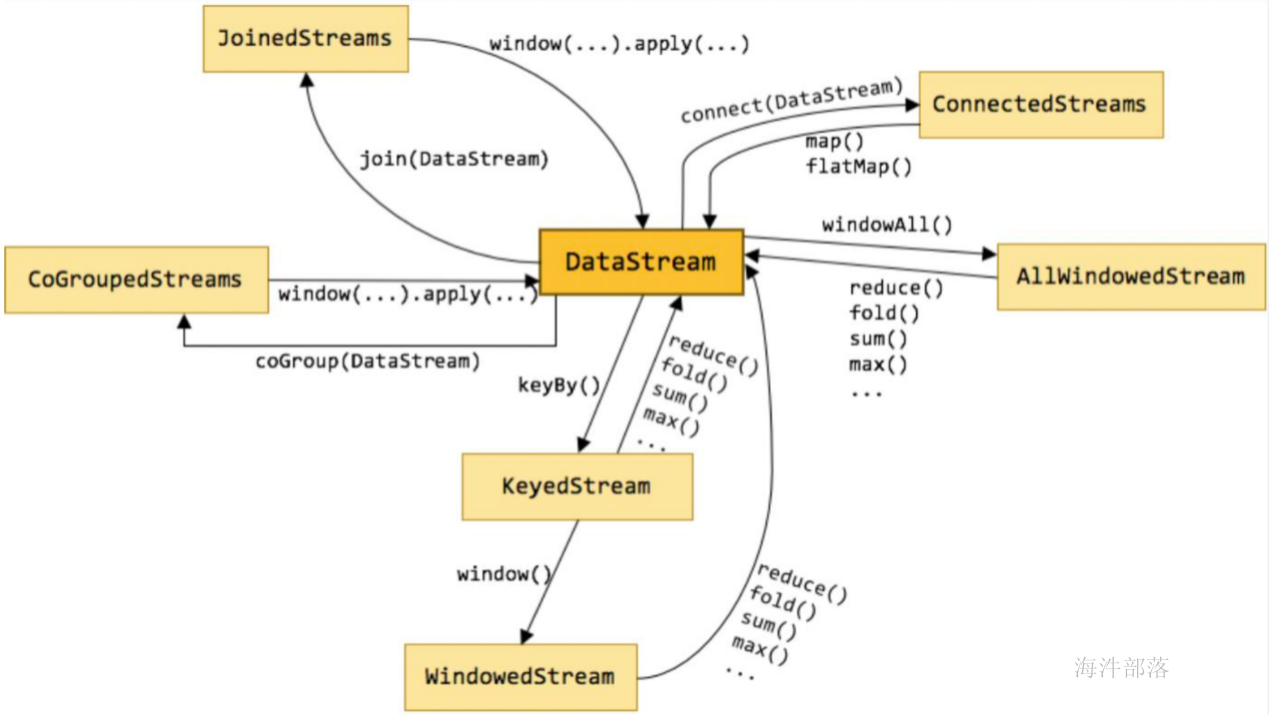

下图展示了 Flink 中目前支持的主要几种流的类型,以及它们之间的转换关系。

DataStream

DataStream 是 Flink 流处理 API 中最核心的数据结构。它代表了一个运行在多个分区上的并行流。一个 DataStream 可以从 StreamExecutionEnvironment 通过env.addSource(SourceFunction) 获得。

DataStream 上的转换操作都是逐条的,比如 map(),flatMap(),filter()

自定义转换函数

1.函数

scala函数

data.flatMap(f => f.split(" "))java的lambda

data.flatMap(f -> f.split(" "));- 实现接口

text.flatMap(new FlatMapFunction[String,String] {

override def flatMap(value: String, out: Collector[String]) = {

val strings: Array[String] = value.split(" ")

for(s <- strings){

out.collect(s)

}

}

})data.flatMap(f -> f.split(" "));3.Rich Functions

Rich Function中有非常有用的四个方法:open,close,getRuntimeContext和setRuntimecontext 这些功能在创建本地状态、获取广播变量、获取运行时信息(例如累加器和计数器)和迭代信息时非常有帮助。

示例代码:

import java.util.Properties

import org.apache.flink.api.common.functions.RichFlatMapFunction

import org.apache.flink.configuration.Configuration

import org.apache.flink.util.Collector

import org.apache.kafka.clients.producer.{KafkaProducer, Producer, ProducerRecord}

class HainiuRichFlatMapFunction(topic:String,props:Properties) extends RichFlatMapFunction[String,Int]{

var producer:Producer[String,String] = _

override def open(parameters: Configuration): Unit = {

//创建kafka生产者

producer = new KafkaProducer[String,String](props)

}

override def close(): Unit = {

//关闭kafka生产者

producer.close()

}

override def flatMap(value: String, out: Collector[Int]): Unit = {

//使用RuntimeContext得到子线程ID,比如可以用于多线程写文件

println(getRuntimeContext.getIndexOfThisSubtask)

//发送数据到kafka

producer.send(new ProducerRecord[String,String](topic,value))

}

}operators

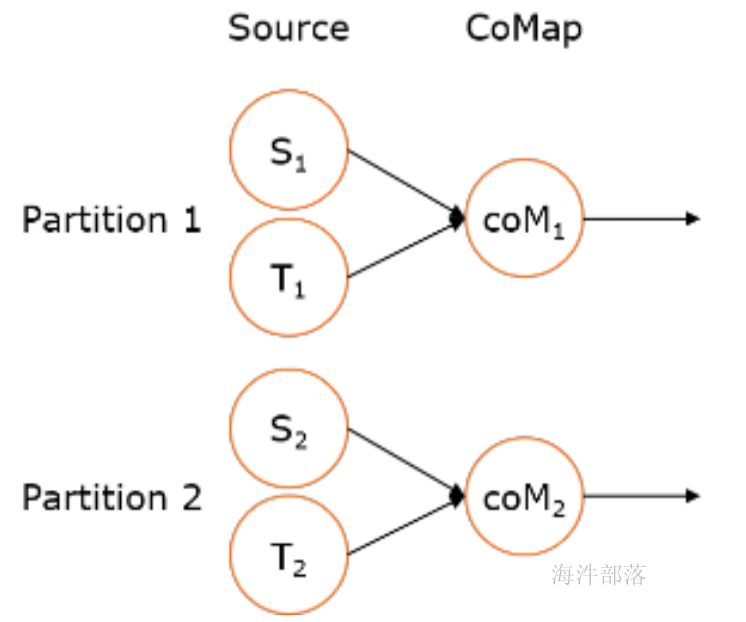

1.connect 与 union (合并流)

- connect之后生成ConnectedStreams,会对两个流的数据应用不同的处理方法,并且双流之间可以共享状态(比如计数)。这在第一个流的输入会影响第二个流时, 会非常有用。union 合并多个流,新的流包含所有流的数据。

- union是DataStream → DataStream

- connect只能连接两个流,而union可以连接多于两个流

- connect连接的两个流类型可以不一致,而union连接的流的类型必须一致

示例代码:

union:

package com.hainiu.operator;

import com.hainiu.source.FileCountryDictSourceFunction;

import org.apache.flink.api.common.serialization.SimpleStringSchema;

import org.apache.flink.streaming.api.datastream.DataStream;

import org.apache.flink.streaming.api.datastream.DataStreamSource;

import org.apache.flink.streaming.api.datastream.SingleOutputStreamOperator;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.functions.ProcessFunction;

import org.apache.flink.streaming.connectors.kafka.FlinkKafkaConsumer010;

import org.apache.flink.util.Collector;

import java.util.HashMap;

import java.util.Map;

import java.util.Properties;

public class CountryCodeUnion {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

env.setParallelism(1);

DataStreamSource<String> countryDictSource = env.addSource(new FileCountryDictSourceFunction());

Properties kafkaConsumerProps = new Properties();

kafkaConsumerProps.setProperty("bootstrap.servers", "s1.hadoop:9092,s2.hadoop:9092,s3.hadoop:9092,s4.hadoop:9092,s5.hadoop:9092,s6.hadoop:9092,s7.hadoop:9092,s8.hadoop:9092");

kafkaConsumerProps.setProperty("group.id", "qingniuflink");

kafkaConsumerProps.setProperty("flink.partition-discovery.interval-millis", "30000");

FlinkKafkaConsumer010<String> kafkaSource = new FlinkKafkaConsumer010<>("flink_event", new SimpleStringSchema(), kafkaConsumerProps);

// kafkaSource.setStartFromEarliest()

// kafkaSource.setStartFromGroupOffsets()

kafkaSource.setStartFromLatest();

DataStreamSource<String> kafkainput = env.addSource(kafkaSource);

DataStream<String> union = countryDictSource.union(kafkainput);

SingleOutputStreamOperator<String> process = union.process(new ProcessFunction<String, String>() {

private Map<String, String> map = new HashMap<>();

@Override

public void processElement(String value, Context ctx, Collector<String> out) throws Exception {

String[] split = value.split("\t");

if (split.length > 1) {

map.put(split[0], split[1]);

out.collect(value);

} else {

String countryName = map.get(value);

String outStr = countryName == null ? "no match" : countryName;

out.collect(outStr);

}

}

});

process.print();

env.execute();

}

}connect:

package com.hainiu.operator;

import com.hainiu.source.FileCountryDictSourceFunction;

import com.hainiu.source.HainiuKafkaRecord;

import com.hainiu.source.HainiuKafkaRecordSchema;

import org.apache.flink.streaming.api.datastream.ConnectedStreams;

import org.apache.flink.streaming.api.datastream.DataStreamSource;

import org.apache.flink.streaming.api.datastream.SingleOutputStreamOperator;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.functions.co.CoProcessFunction;

import org.apache.flink.streaming.connectors.kafka.FlinkKafkaConsumer010;

import org.apache.flink.util.Collector;

import java.util.HashMap;

import java.util.Map;

import java.util.Properties;

public class CountryCodeConnect {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

env.setParallelism(1);

DataStreamSource<String> countryDictSource = env.addSource(new FileCountryDictSourceFunction());

Properties kafkaConsumerProps = new Properties();

kafkaConsumerProps.setProperty("bootstrap.servers", "s1.hadoop:9092,s2.hadoop:9092,s3.hadoop:9092,s4.hadoop:9092,s5.hadoop:9092,s6.hadoop:9092,s7.hadoop:9092,s8.hadoop:9092");

kafkaConsumerProps.setProperty("group.id", "qingniuflink");

kafkaConsumerProps.setProperty("flink.partition-discovery.interval-millis", "30000");

FlinkKafkaConsumer010<HainiuKafkaRecord> kafkaSource = new FlinkKafkaConsumer010<>("flink_event", new HainiuKafkaRecordSchema(), kafkaConsumerProps);

// kafkaSource.setStartFromEarliest()

// kafkaSource.setStartFromGroupOffsets()

kafkaSource.setStartFromLatest();

DataStreamSource<HainiuKafkaRecord> kafkainput = env.addSource(kafkaSource);

ConnectedStreams<String, HainiuKafkaRecord> connect = countryDictSource.connect(kafkainput);

SingleOutputStreamOperator<String> connectInput = connect.process(new CoProcessFunction<String, HainiuKafkaRecord, String>() {

private Map<String, String> map = new HashMap<String, String>();

@Override

public void processElement1(String value, Context ctx, Collector<String> out) throws Exception {

String[] split = value.split("\t");

map.put(split[0], split[1]);

out.collect(value);

}

@Override

public void processElement2(HainiuKafkaRecord value, Context ctx, Collector<String> out) throws Exception {

String countryCode = value.getRecord();

String countryName = map.get(countryCode);

String outStr = countryName == null ? "no match" : countryName;

out.collect(outStr);

}

});

connectInput.print();

env.execute();

}

}2.keyBy

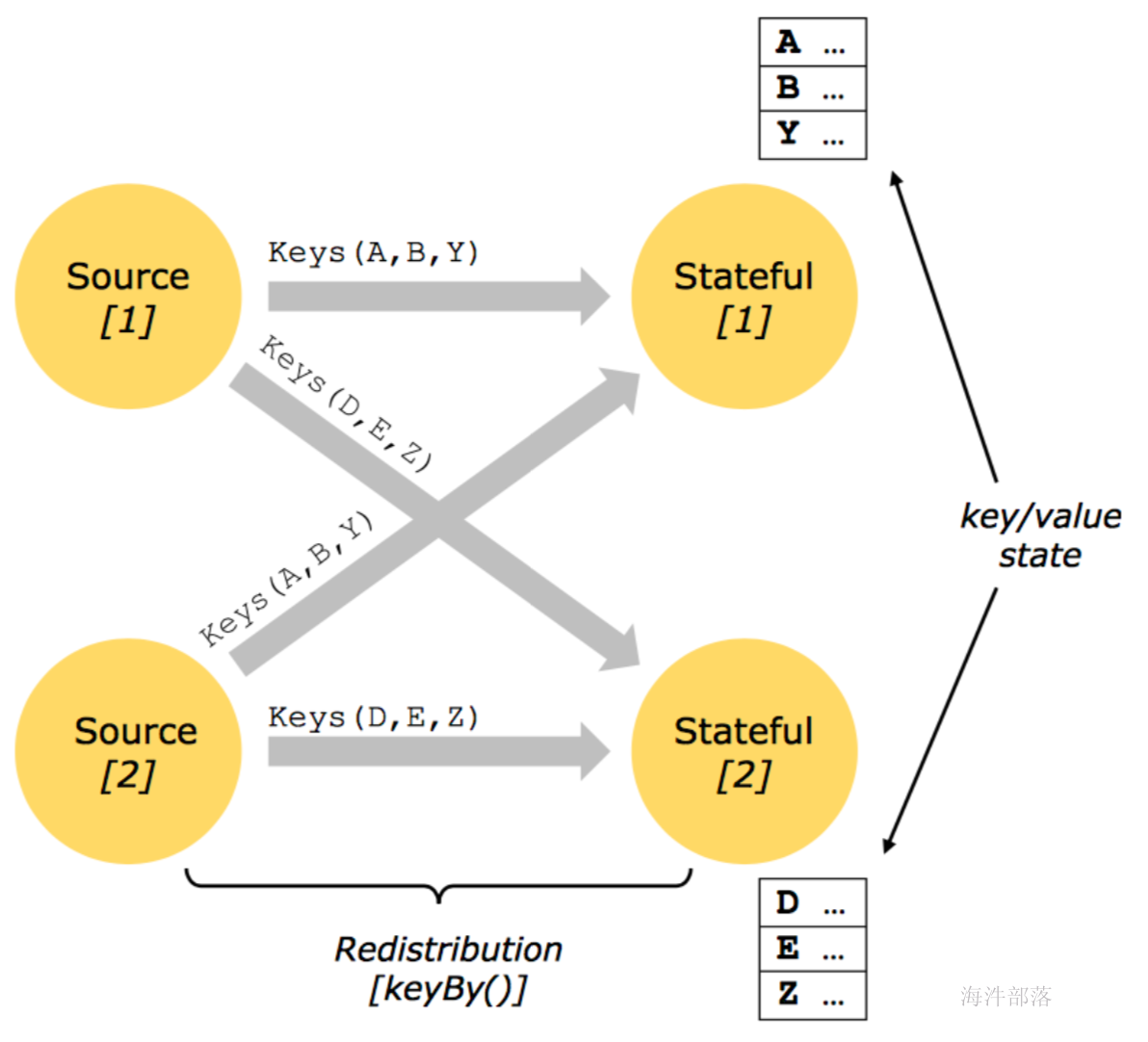

- 含义: 根据指定的key进行分组(逻辑上把DataStream分成若干不相交的分区,key一样的event会 被划分到相同的partition,内部采用类似于hash分区来实现)

- 转换关系: DataStream → KeyedStream

- 使用场景: 分组(类比SQL中的分组)比如join,coGroup,keyBy,groupBy,Reduce,GroupReduce,Aggregate,Windows

KeyedStream

- KeyedStream用来表示根据指定的key进行分组的数据流。

- 一个KeyedStream可以通过调用DataStream.keyBy()来获得。

- 在KeyedStream上进行任何transformation都将转变回DataStream。

- 在实现中,KeyedStream会把key的信息传入到算子的函数中。

示例代码:

package com.hainiu.operator;

import com.hainiu.source.FileCountryDictSourceFunction;

import com.hainiu.source.HainiuKafkaRecord;

import com.hainiu.source.HainiuKafkaRecordSchema;

import org.apache.flink.streaming.api.datastream.ConnectedStreams;

import org.apache.flink.streaming.api.datastream.DataStreamSource;

import org.apache.flink.streaming.api.datastream.SingleOutputStreamOperator;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.functions.co.CoProcessFunction;

import org.apache.flink.streaming.connectors.kafka.FlinkKafkaConsumer010;

import org.apache.flink.util.Collector;

import java.util.HashMap;

import java.util.Map;

import java.util.Properties;

public class CountryCodeConnect {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

env.setParallelism(1);

DataStreamSource<String> countryDictSource = env.addSource(new FileCountryDictSourceFunction());

Properties kafkaConsumerProps = new Properties();

kafkaConsumerProps.setProperty("bootstrap.servers", "s1.hadoop:9092,s2.hadoop:9092,s3.hadoop:9092,s4.hadoop:9092,s5.hadoop:9092,s6.hadoop:9092,s7.hadoop:9092,s8.hadoop:9092");

kafkaConsumerProps.setProperty("group.id", "qingniuflink");

kafkaConsumerProps.setProperty("flink.partition-discovery.interval-millis", "30000");

FlinkKafkaConsumer010<HainiuKafkaRecord> kafkaSource = new FlinkKafkaConsumer010<>("flink_event", new HainiuKafkaRecordSchema(), kafkaConsumerProps);

// kafkaSource.setStartFromEarliest()

// kafkaSource.setStartFromGroupOffsets()

kafkaSource.setStartFromLatest();

DataStreamSource<HainiuKafkaRecord> kafkainput = env.addSource(kafkaSource);

ConnectedStreams<String, HainiuKafkaRecord> connect = countryDictSource.connect(kafkainput);

SingleOutputStreamOperator<String> connectInput = connect.process(new CoProcessFunction<String, HainiuKafkaRecord, String>() {

private Map<String, String> map = new HashMap<String, String>();

@Override

public void processElement1(String value, Context ctx, Collector<String> out) throws Exception {

String[] split = value.split("\t");

map.put(split[0], split[1]);

out.collect(value);

}

@Override

public void processElement2(HainiuKafkaRecord value, Context ctx, Collector<String> out) throws Exception {

String countryCode = value.getRecord();

String countryName = map.get(countryCode);

String outStr = countryName == null ? "no match" : countryName;

out.collect(outStr);

}

});

connectInput.print();

env.execute();

}

}Key的类型限制:

- 不能是没有覆盖hashCode方法的POJO(也就是bean)

- 不能是数组

POJO:

package com.hainiu.source;

public class HainiuKafkaRecord {

private String record;

public HainiuKafkaRecord(String record) {

this.record = record;

}

public String getRecord() {

return record;

}

public void setRecord(String record) {

this.record = record;

}

@Override

public int hashCode() {

final int prime = 31;

int result = 1;

result = prime * result + ((record == null) ? 0 : record.hashCode());

return result;

}

}示例代码:

package com.hainiu.operator;

import com.hainiu.source.FileCountryDictSourceFunction;

import com.hainiu.source.HainiuKafkaRecord;

import com.hainiu.source.HainiuKafkaRecordSchema;

import org.apache.flink.api.common.functions.MapFunction;

import org.apache.flink.api.java.functions.KeySelector;

import org.apache.flink.api.java.tuple.Tuple2;

import org.apache.flink.streaming.api.datastream.ConnectedStreams;

import org.apache.flink.streaming.api.datastream.DataStreamSource;

import org.apache.flink.streaming.api.datastream.KeyedStream;

import org.apache.flink.streaming.api.datastream.SingleOutputStreamOperator;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.functions.co.KeyedCoProcessFunction;

import org.apache.flink.streaming.connectors.kafka.FlinkKafkaConsumer010;

import org.apache.flink.util.Collector;

import java.util.HashMap;

import java.util.Map;

import java.util.Properties;

public class CountryCodeConnectKeyByObject {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

DataStreamSource<String> countryDictSource = env.addSource(new FileCountryDictSourceFunction());

Properties kafkaConsumerProps = new Properties();

kafkaConsumerProps.setProperty("bootstrap.servers", "s1.hadoop:9092,s2.hadoop:9092,s3.hadoop:9092,s4.hadoop:9092,s5.hadoop:9092,s6.hadoop:9092,s7.hadoop:9092,s8.hadoop:9092");

kafkaConsumerProps.setProperty("group.id", "qingniuflink");

kafkaConsumerProps.setProperty("flink.partition-discovery.interval-millis", "30000");

FlinkKafkaConsumer010<HainiuKafkaRecord> kafkaSource = new FlinkKafkaConsumer010<>("flink_event", new HainiuKafkaRecordSchema(), kafkaConsumerProps);

// kafkaSource.setStartFromEarliest()

// kafkaSource.setStartFromGroupOffsets()

kafkaSource.setStartFromLatest();

DataStreamSource<HainiuKafkaRecord> kafkainput = env.addSource(kafkaSource);

KeyedStream<Tuple2<HainiuKafkaRecord, String>, HainiuKafkaRecord> countryDictKeyBy = countryDictSource.map(new MapFunction<String, Tuple2<HainiuKafkaRecord, String>>() {

@Override

public Tuple2<HainiuKafkaRecord, String> map(String value) throws Exception {

String[] split = value.split("\t");

return Tuple2.of(new HainiuKafkaRecord(new String(split[0])), split[1]);

}

}).keyBy(new KeySelector<Tuple2<HainiuKafkaRecord, String>, HainiuKafkaRecord>() {

@Override

public HainiuKafkaRecord getKey(Tuple2<HainiuKafkaRecord, String> value) throws Exception {

return value.f0;

}

});

KeyedStream<HainiuKafkaRecord, HainiuKafkaRecord> record = kafkainput.keyBy(new KeySelector<HainiuKafkaRecord, HainiuKafkaRecord>() {

@Override

public HainiuKafkaRecord getKey(HainiuKafkaRecord value) throws Exception {

return value;

}

});

ConnectedStreams<Tuple2<HainiuKafkaRecord, String>, HainiuKafkaRecord> connect = countryDictKeyBy.connect(record);

SingleOutputStreamOperator<String> connectInput = connect.process(new KeyedCoProcessFunction<HainiuKafkaRecord, Tuple2<HainiuKafkaRecord, String>, HainiuKafkaRecord, String>() {

private Map<String, String> map = new HashMap<String, String>();

@Override

public void processElement1(Tuple2<HainiuKafkaRecord, String> value, Context ctx, Collector<String> out) throws Exception {

String currentKey = ctx.getCurrentKey().getRecord();

map.put(currentKey, value.f1);

out.collect(value.toString());

}

@Override

public void processElement2(HainiuKafkaRecord value, Context ctx, Collector<String> out) throws Exception {

HainiuKafkaRecord currentKey = ctx.getCurrentKey();

String countryName = map.get(currentKey.getRecord());

String outStr = countryName == null ? "no match" : countryName;

out.collect(currentKey.toString() + "--" + outStr);

}

});

connectInput.print();

env.execute();

}

}*可能会出现数据倾斜,可根据实际情况结合物理分区来解决

3.物理分区

算子间数据传递模式

- One-to-one streams 保持元素的分区和顺序

- Redistributing streams

改变流的分区策略取决于使用的算子

- keyBy()(re-partitions by hashing the key)

- broadcast()

- rebalance()(which re-partitions randomly)

都是Transformation,都可以改变分区

| 分区Transformation | 说明 |

|---|---|

| Random partitioning | 按均匀分布随机划分元素,网络开销往往比较大 dataStream.shuffle() |

| Round-robin partitioning | 循环对元素进行分区,为每一个分区创建相等的负载,这在数据倾斜时非常有用的: dataStream.rebalance() |

| Rescaling | 跟rebalance有点类似,但不是全局的,通过轮询调度将元素从上游的task一个子 集发送到下游task的一个子集: dataStream.rescale(); |

| Broadcasting | 将元素广播到每个分区上 dataStream.broadcast(); |

| Custom partitioning | dataStream.partitionCustom(partitioner, "someKey") 或 dataStream.partitionCustom(partitioner, 0) |

4.解决数据倾斜

1).One-to-one streams 解决数据倾斜的方法:

rebalance

- 含义:再平衡,用来减轻数据倾斜

- 转换关系: DataStream → DataStream

- 使用场景:处理数据倾斜,比如某个kafka的partition的数据比较多

示例代码:

val stream: DataStream[MyType] = env.addSource(new FlinkKafkaConsumer08[String](...))

val str1: DataStream[(String, MyType)] = stream.flatMap { ... }

val str2: DataStream[(String, MyType)] = str1.rebalance()

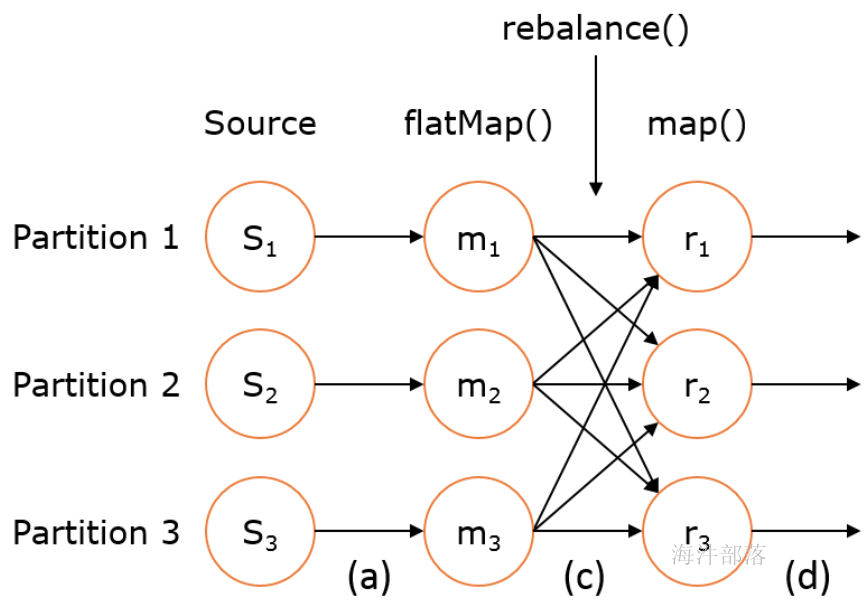

val str3: DataStream[AnotherType] = str2.map { ... }上述 DataStream 上的转换在运行时会转换成如下的执行图:

如上图的执行图所示,DataStream 各个算子会并行运行,算子之间是数据流分区。如 Source 的第一个并行实例(S1)和 flatMap() 的第一个并行实例(m1)之间就是一个数据流分区。而在 flatMap() 和 map() 之间由于加了 rebalance(),它们之间的数据流分区就有3个子分区(m1的数据流向3个map()实例)。

rescale

- 原理:通过轮询调度将元素从上游的task一个子集发送到下游task的一个子集

- 转换关系:DataStream → DataStream

- 使用场景:数据传输都在一个TaskManager内,不需要通过网络。

原理:

第一个task并行度为2,第二个task并行度为6,第三个task并行度为2。从第一个task到第二个task,Src的 子集Src1 和 Map的子集Map1,2,3对应起来,Src1会以轮询调度的方式分别向Map1,2,3发送记录。 从第二个task到第三个task,Map的子集1,2,3对应Sink的子集1,这三个流的元素只会发送到Sink1。 假设我们每个TaskManager有三个Slot,并且我们开了SlotSharingGroup,那么通过rescale,所有的数据传输都在一个TaskManager内,不需要通过网络。

2).Redistributing streams 解决数据倾斜的方法:

自定义partitioner

- 转换关系:DataStream → DataStream

- 使用场景:自定义数据处理负载

- 实现方法:

- 实现org.apache.flink.api.common.functions.Partitioner接口

- 覆盖partition方法

- 设计算法返回partitionId

示例代码:

package com.hainiu.operator;

import com.hainiu.source.FileCountryDictSourceFunction;

import com.hainiu.source.HainiuKafkaRecord;

import com.hainiu.source.HainiuKafkaRecordSchema;

import org.apache.flink.api.common.functions.MapFunction;

import org.apache.flink.api.common.functions.Partitioner;

import org.apache.flink.api.java.functions.KeySelector;

import org.apache.flink.api.java.tuple.Tuple2;

import org.apache.flink.streaming.api.datastream.ConnectedStreams;

import org.apache.flink.streaming.api.datastream.DataStream;

import org.apache.flink.streaming.api.datastream.DataStreamSource;

import org.apache.flink.streaming.api.datastream.SingleOutputStreamOperator;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.functions.co.CoProcessFunction;

import org.apache.flink.streaming.connectors.kafka.FlinkKafkaConsumer010;

import org.apache.flink.util.Collector;

import java.util.HashMap;

import java.util.Map;

import java.util.Properties;

public class CountryCodeConnectCustomPartitioner {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

DataStreamSource<String> countryDictSource = env.addSource(new FileCountryDictSourceFunction());

Properties kafkaConsumerProps = new Properties();

kafkaConsumerProps.setProperty("bootstrap.servers", "s1.hadoop:9092,s2.hadoop:9092,s3.hadoop:9092,s4.hadoop:9092,s5.hadoop:9092,s6.hadoop:9092,s7.hadoop:9092,s8.hadoop:9092");

kafkaConsumerProps.setProperty("group.id", "qingniuflink");

kafkaConsumerProps.setProperty("flink.partition-discovery.interval-millis", "30000");

FlinkKafkaConsumer010<HainiuKafkaRecord> kafkaSource = new FlinkKafkaConsumer010<>("flink_event", new HainiuKafkaRecordSchema(), kafkaConsumerProps);

// kafkaSource.setStartFromEarliest()

// kafkaSource.setStartFromGroupOffsets()

kafkaSource.setStartFromLatest();

DataStreamSource<HainiuKafkaRecord> kafkainput = env.addSource(kafkaSource);

DataStream<Tuple2<String, String>> countryDictPartition = countryDictSource.map(new MapFunction<String, Tuple2<String, String>>() {

@Override

public Tuple2<String, String> map(String value) throws Exception {

String[] split = value.split("\t");

return Tuple2.of(split[0], split[1]);

}

}).partitionCustom(new Partitioner<String>() {

@Override

public int partition(String key, int numPartitions) {

if (key.contains("CN")) {

return 0;

} else {

return 1;

}

}

}, new KeySelector<Tuple2<String, String>, String>() {

@Override

public String getKey(Tuple2<String, String> value) throws Exception {

return value.f0;

}

});

DataStream<HainiuKafkaRecord> recordPartition = kafkainput.partitionCustom(new Partitioner<String>() {

@Override

public int partition(String key, int numPartitions) {

if (key.contains("CN")) {

return 0;

} else {

return 1;

}

}

}, new KeySelector<HainiuKafkaRecord, String>() {

@Override

public String getKey(HainiuKafkaRecord value) throws Exception {

return value.getRecord();

}

});

ConnectedStreams<Tuple2<String, String>, HainiuKafkaRecord> connect = countryDictPartition.connect(recordPartition);

SingleOutputStreamOperator<String> connectInput = connect.process(new CoProcessFunction<Tuple2<String, String>, HainiuKafkaRecord, String>() {

private Map<String, String> map = new HashMap<String, String>();

@Override

public void processElement1(Tuple2<String, String> value, Context ctx, Collector<String> out) throws Exception {

map.put(value.f0, value.f1);

out.collect(value.toString());

}

@Override

public void processElement2(HainiuKafkaRecord value, Context ctx, Collector<String> out) throws Exception {

String countryCode = value.getRecord();

String countryName = map.get(countryCode);

String outStr = countryName == null ? "no match" : countryName;

out.collect(outStr);

}

});

connectInput.print();

env.execute();

}

}使用parititoner解决数据倾斜

package com.hainiu.flink.operator;

import com.hainiu.flink.source.FileCountryDictSourceFunction;

import com.hainiu.flink.source.HainiuKafkaRecord;

import com.hainiu.flink.source.HainiuKafkaRecordSchema;

import org.apache.flink.api.common.functions.FlatMapFunction;

import org.apache.flink.api.common.functions.MapFunction;

import org.apache.flink.api.common.functions.Partitioner;

import org.apache.flink.api.java.functions.KeySelector;

import org.apache.flink.api.java.tuple.Tuple2;

import org.apache.flink.configuration.Configuration;

import org.apache.flink.streaming.api.datastream.ConnectedStreams;

import org.apache.flink.streaming.api.datastream.DataStream;

import org.apache.flink.streaming.api.datastream.DataStreamSource;

import org.apache.flink.streaming.api.datastream.SingleOutputStreamOperator;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.functions.co.CoProcessFunction;

import org.apache.flink.streaming.connectors.kafka.FlinkKafkaConsumer010;

import org.apache.flink.util.Collector;

import java.util.HashMap;

import java.util.Map;

import java.util.Properties;

import java.util.Random;

public class CountryCodeConnectCustomPartitioner {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment env = StreamExecutionEnvironment.createLocalEnvironmentWithWebUI(new Configuration());

Properties kafkaConsumerProps = new Properties();

kafkaConsumerProps.setProperty("bootstrap.servers", "s1.hadoop:9092,s3.hadoop:9092,s4.hadoop:9092,s5.hadoop:9092,s6.hadoop:9092,s7.hadoop:9092,s8.hadoop:9092");

kafkaConsumerProps.setProperty("group.id", "qingniuflink");

kafkaConsumerProps.setProperty("flink.partition-discovery.interval-millis", "30000");

FlinkKafkaConsumer010<HainiuKafkaRecord> kafkaSource = new FlinkKafkaConsumer010<>("flink_event", new HainiuKafkaRecordSchema(), kafkaConsumerProps);

kafkaSource.setStartFromLatest();

DataStreamSource<HainiuKafkaRecord> kafkaInput = env.addSource(kafkaSource);

DataStream<HainiuKafkaRecord> kafka = kafkaInput.map(new MapFunction<HainiuKafkaRecord, HainiuKafkaRecord>() {

@Override

public HainiuKafkaRecord map(HainiuKafkaRecord value) throws Exception {

String record = value.getRecord();

Random random = new Random();

int i = random.nextInt(10);