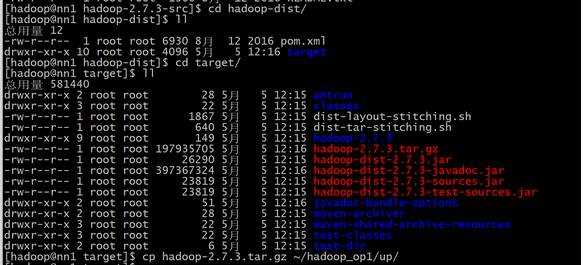

1. 把hadoop的tar包分发到每个机器上

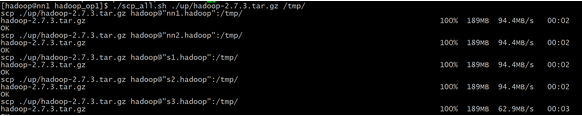

./scp_all.sh ./up/hadoop-2.7.3.tar.gz /tmp/ 拷贝到每个机器的tmp目录下

以下内容回帖刷新可见……………………

回复帖子,然后刷新页面即可查看隐藏内容

版权声明:原创作品,允许转载,转载时务必以超链接的形式表明出处和作者信息。否则将追究法律责任。来自海汼部落-青牛,http://hainiubl.com/topics/83

./scp_all.sh ./up/hadoop-2.7.3.tar.gz /tmp/ 拷贝到每个机器的tmp目录下

666

学习

666

学习

感谢海牛

学习

学习

= =

学习

学习

666

学习

求大神指点,我在执行 hadoop-daemons.sh start datanode 启动节点服务时,报错提示 s1.hadoop: /usr/local/hadoop/sbin/hadoop-daemon.sh:行165: /usr/local/hadoop/pids/hadoop-hadoop-datanode.pid: 权限不够,这个是什么原因啊

求大神指点,在使用 ./ssh_root.sh tar -xzf /tmp/hadoop-2.7.3.tar.gz -C /usr/local/ 时,提示 sudo: 没有终端存在,且未指定 askpass 程序,利用 ssh_root.sh 执行很多命令都会报这个错,但有些命令又能成功

@hainiu4mark 把后面的命令加上引号再试试,比如这样子ssh_root.sh "tar -xzf /tmp/hadoop-2.7.3.tar.gz -C /usr/local/",另外你那个exe.sh的脚本是这个样子吗?

cmd=$*

su -<<EOF

$cmd

EOF