@歌唱祖国 csv不就能用excel打开吗?你导出csv不就行了吗?

如果非要转换的话你可以看看python的xlrd和csv模块,写个python脚本直接调用就可以当命令去使用的,不过数据太大速度也不会快

- 请问在 hue 上用 hive 查询数据后导出 CSV 乱码怎么解决?

- 优化 hive sql?

- 请问在 hue 上用 hive 查询数据后导出 CSV 乱码怎么解决?

- python 有哪些技术点?

- eclipse 运行 hadoop 项目出现。ERROR: Please make sure Oracle NoSQL Database is up and running at 'localhost:5000' with store name as: 'kvstore'?

- spark on yarn 的好处 优势有哪些?

- spark on yarn 的好处 优势有哪些?

- HaDoop 硬件配置?

-

信息被删除或无权限查看

- 为甚么安装环境中就一个呢

- hadoop 搭建环境

- hadoop 为什么说 block 块多个副本便于计算呢

-

信息被删除或无权限查看

- [公告] 社区表情包已到达

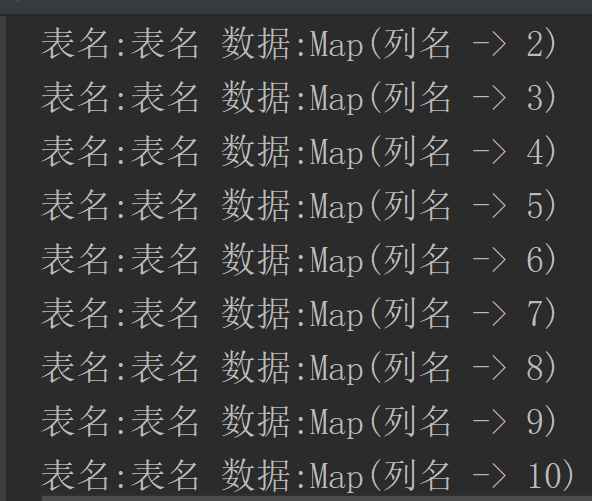

- sparkcore 将文本数据转化为表的映射关系