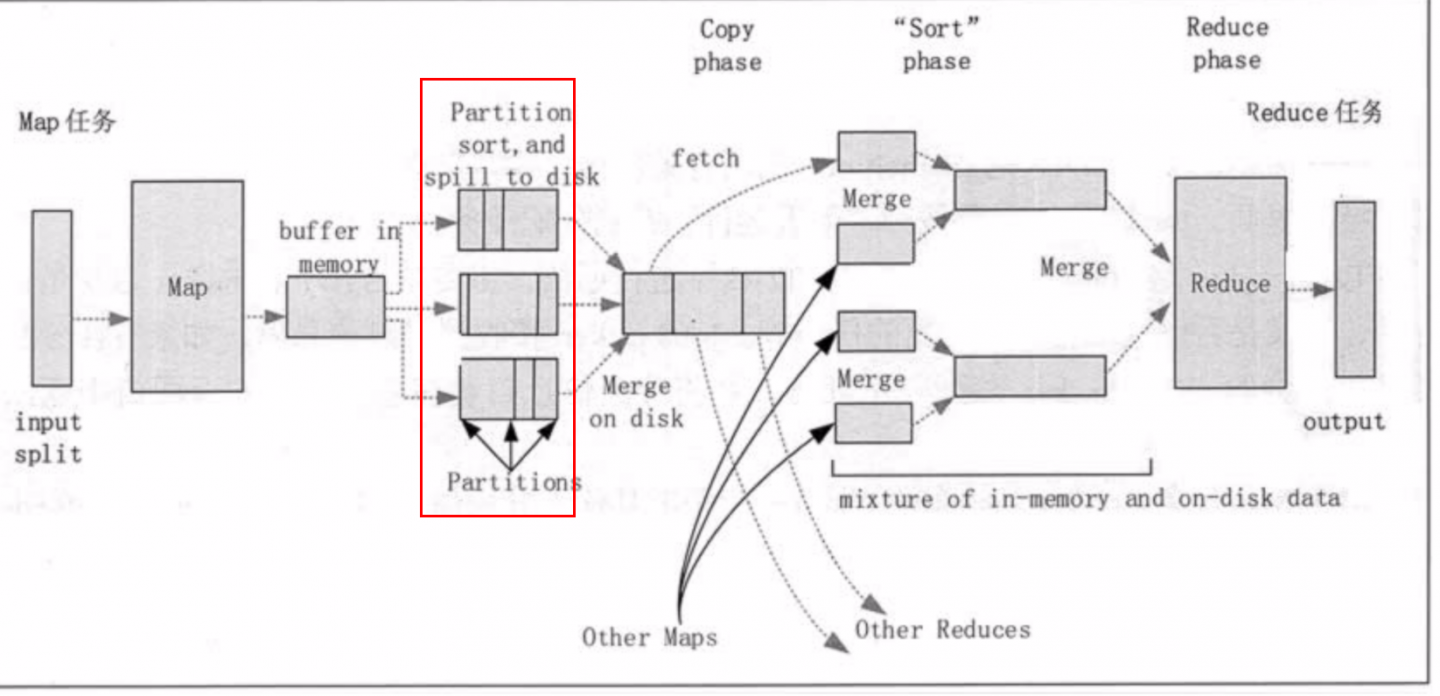

根据理解 这个 在shuffle过程中,会把相应数据划分到相应的分区中。

但是这个shuffle的时候,还不知道整个数据的全貌,如何能确认有几个partitions,又如何放置到第几个partiition中

比如数据刚开始的时候 只有3个partitions,随着数据的增长整个partition的数据量会增加的

原来放到第3个partition的数据,可能就变为第4个了,且是否每个parition中包含的key值内容也发生了改变?

MR 的 shuffle 阶段 是如何确认 数据相应的分区的?

成为第一个点赞的人吧

回复数量: 1

-

有几个reduce就有几个partition,放到那个partition中根据key的hashCode % numReduceTask去算的。一个任务跑起来那reduce的任务数就固定下来了,所以partition的数量就固定下来了,并不会因为数据变多动态调整partition。