使用官方的 elasticsearch-hadoop往es中导入数据,数据量大的时候,spark写入es会丢失一些数据,为什么?

spark 写入 Elasticsearch 丢失数据的问题?

回复数量: 7

-

中间要是没报错,那可能就是你程序的问题

-

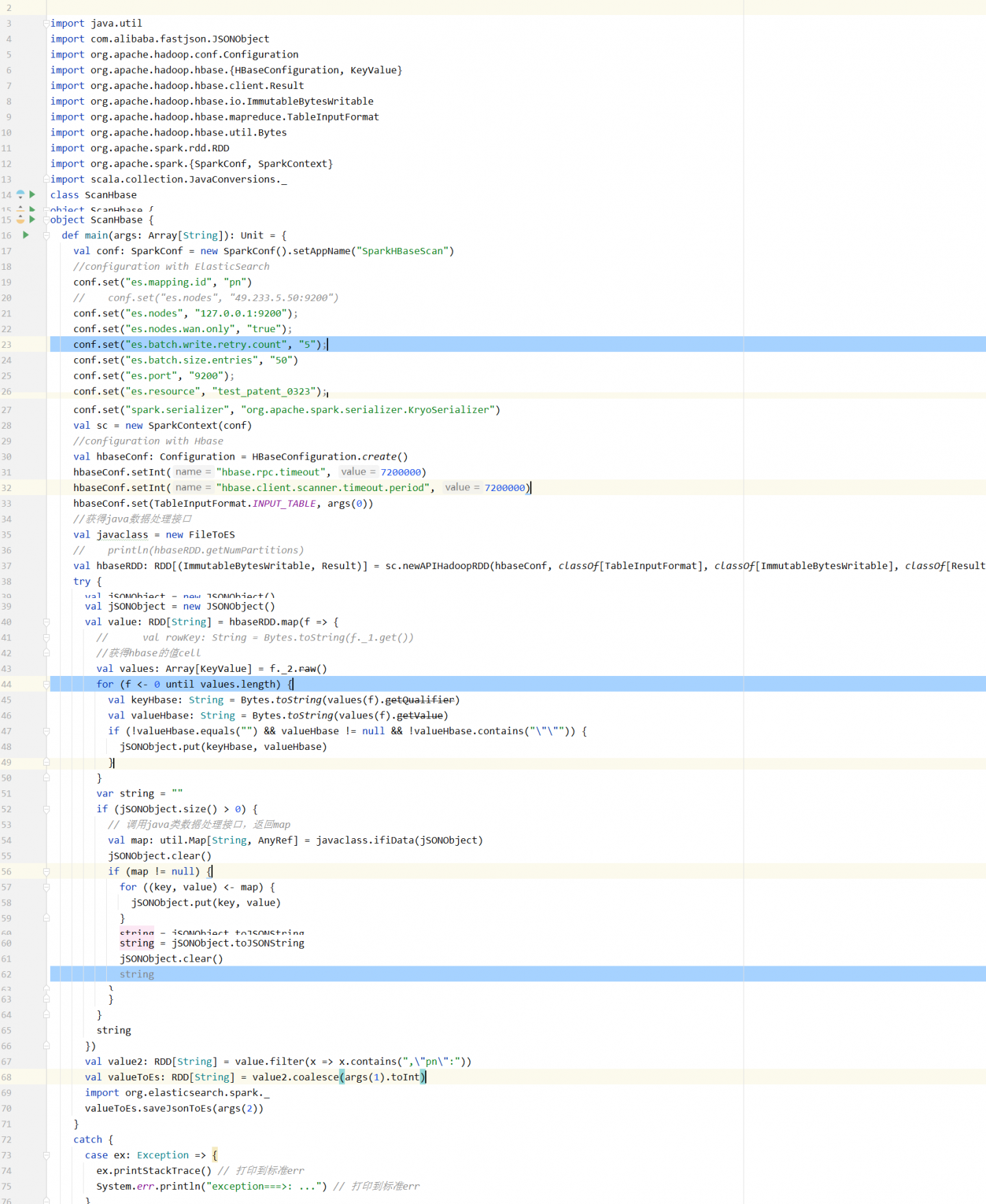

@青牛 何老师能不能看下代码.....哪里出了问题.....中间也没报错。截图有点模糊......

-

@wzyaizx1314 没看出啥毛病啊

-

@青牛 不知道哪里出的问题。想单独把hbase的数据都拿出来分析下,结果也报错了....这个是为啥

-

@wzyaizx1314 你开发环境好像有问题,native库没有

-

@青牛 环境问题解决了, spark任务总是生成_temporary/0 这种目录 跑着就自动结束了,yarn上显示成功,是为啥

-

@wzyaizx1314 生成临时目录正常,是不是你的driver挂了?