1 spark 概述

1.1 Spark产生的背景

MapReduce的局限性:

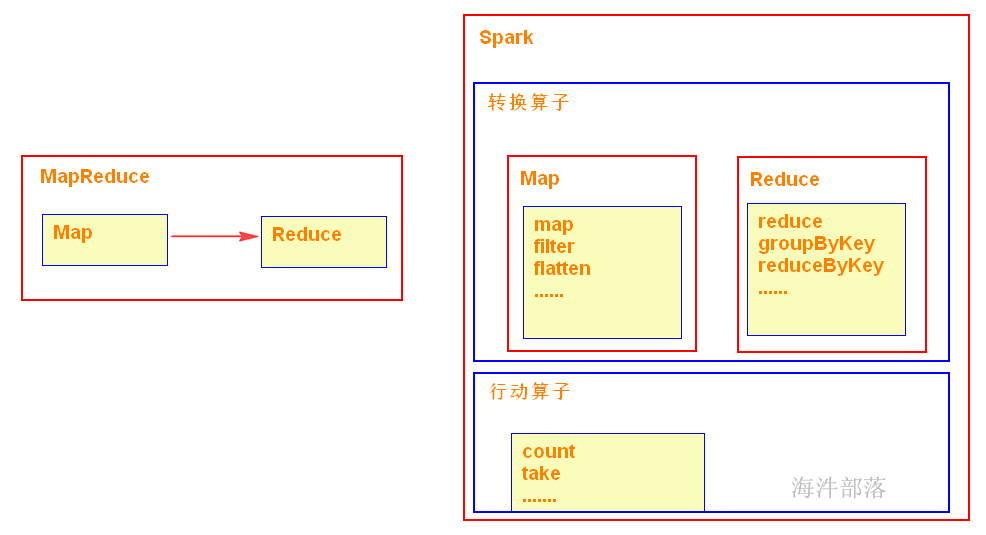

1)仅支持Map 和 Reduce 两种操作;

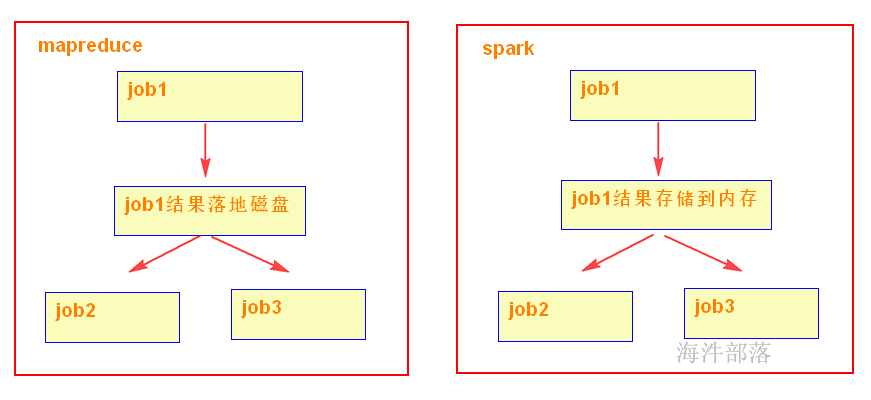

2)MapReduce多个任务的中间结果落地磁盘,不能充分利用内存,任务运行效率低;

3)适合批处理,不适合实时性要求高的场景;

4)程序编写过于复杂;

5)资源不能复用,每次需要重新发分配资源

1.2 什么是Spark

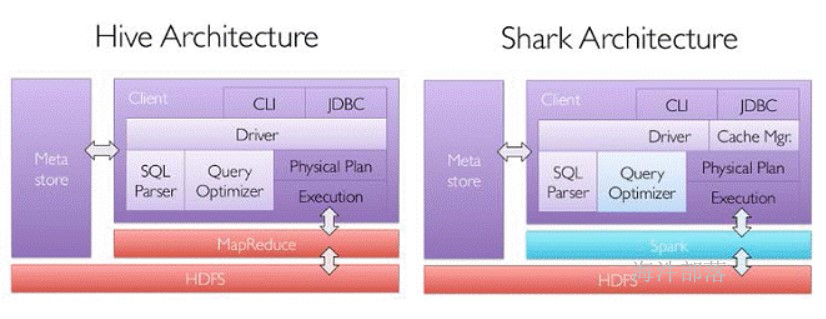

Spark,是一种通用的大数据计算框架,正如传统大数据技术Hadoop的MapReduce、Hive引擎,以及Storm流式实时计算引擎等。

Spark是加州大学伯克利分校AMP实验室(Algorithms, Machines, and People Lab)开发的通用内存并行计算框架,用于构建大型的、低延迟的数据分析应用程序。

Spark使用强大的Scala语言开发,它还提供了对Scala、Python、Java(支持Java 8)和R语言的支持。

Apache顶级项目,项目主页:http://spark.apache.org

1.3 Spark历史

2009年由Berkeley’s AMPLab开始编写最初的源代码

2010年开放源代码

2013年6月进入Apache孵化器项目

2014年2月成为Apache的顶级项目(8个月时间)

2014年5月底Spark1.0.0发布,打破Hadoop保持的基准排序纪录

2014年12月Spark1.2.0发布

2015年11月Spark1.5.2发布

2016年1月Spark1.6发布

2016年12月Spark2.1发布

1.4 为什么要用Spark

运行速度快:

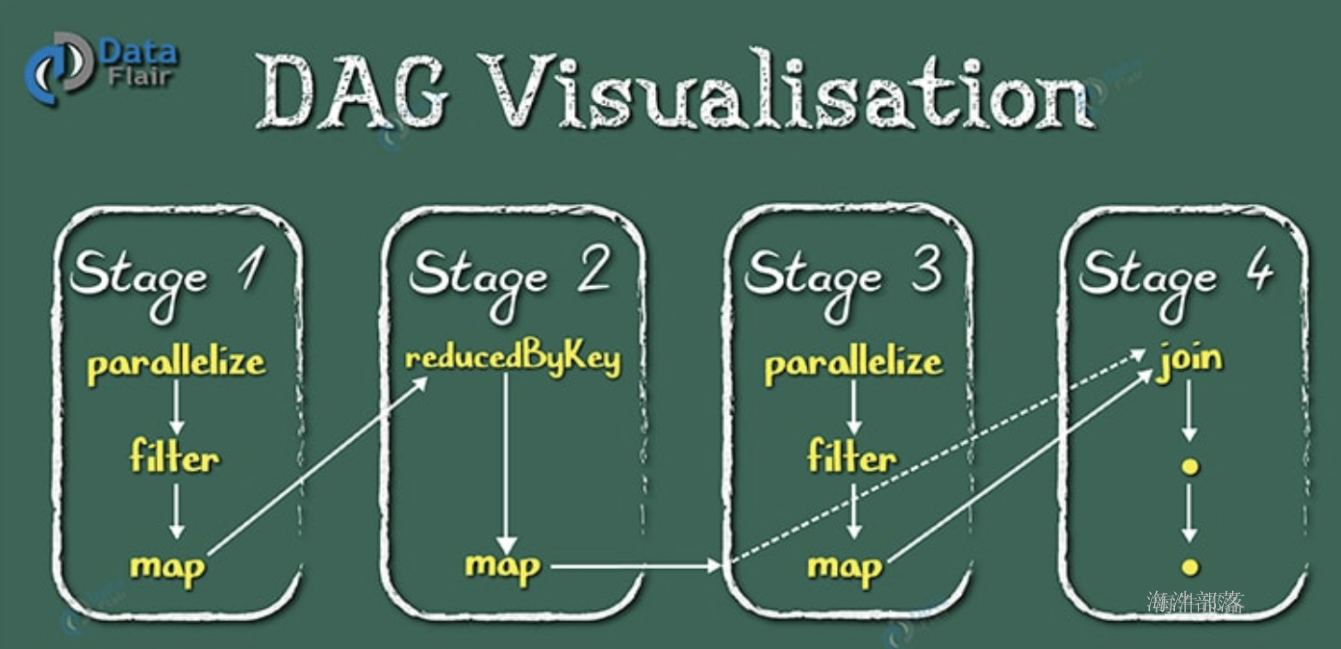

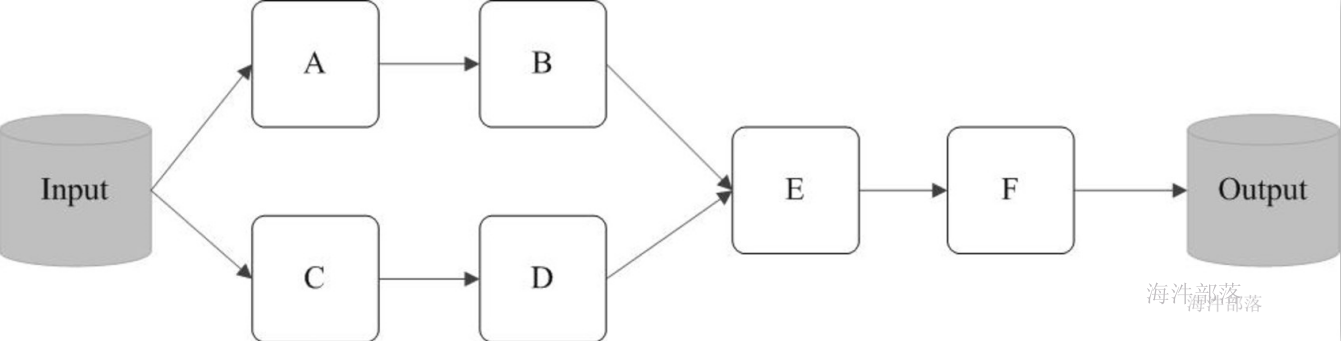

使用DAG(全称 Directed Acyclic Graph, 中文为:有向无环图)执行引擎以支持循环数据流与内存计算(当然也有部分计算基于磁盘,比如shuffle);

易用性好:

支持使用Scala、Java、Python和R语言进行编程,可以通过Spark Shell进行交互式编程 ;

通用性强:

Spark提供了完整而强大的工具,包括SQL查询、流式计算、机器学习和图算法组件;

随处运行:

可运行于独立的集群模式中,可运行于Hadoop中,也可运行于Amazon EC2等云环境中,并且可以访问HDFS、Cassandra、HBase、Hive等多种数据源;

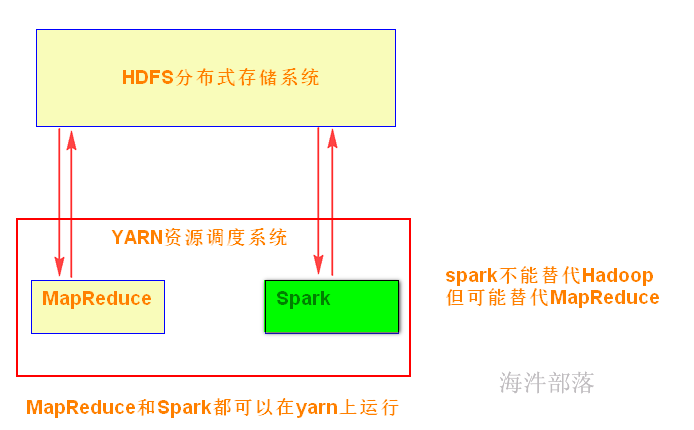

Hadoop:

可以用普通硬件搭建Hadoop集群,用于解决存储和计算问题;

1)解决存储:HDFS

2)解决计算:MapReduce

3)资源管理:YARN

Spark:

Spark是在借鉴了MapReduce之上发展而来的,继承了其分布式并行计算的优点并改进了MapReduce明显的缺陷;

Spark不能代替Hadoop,但可能代替MapReduce。

现状:

Spark主要用于大数据的计算,而Hadoop以后主要用于大数据的存储(HDFS),以及资源调度(Yarn)。Spark+Hadoop的组合,是未来大据领域最热门的组合,也是最有前景的组合! 当然spark也有自己的集群模式。

通过yarn队列去管理mr 和 spark任务的资源。

1.6 Spark 对比 MapReduce

1)spark可以把多次使用的数据放到内存中

4)在代码编写方面,不需要写那么复杂的MapReduce逻辑。

缺点:

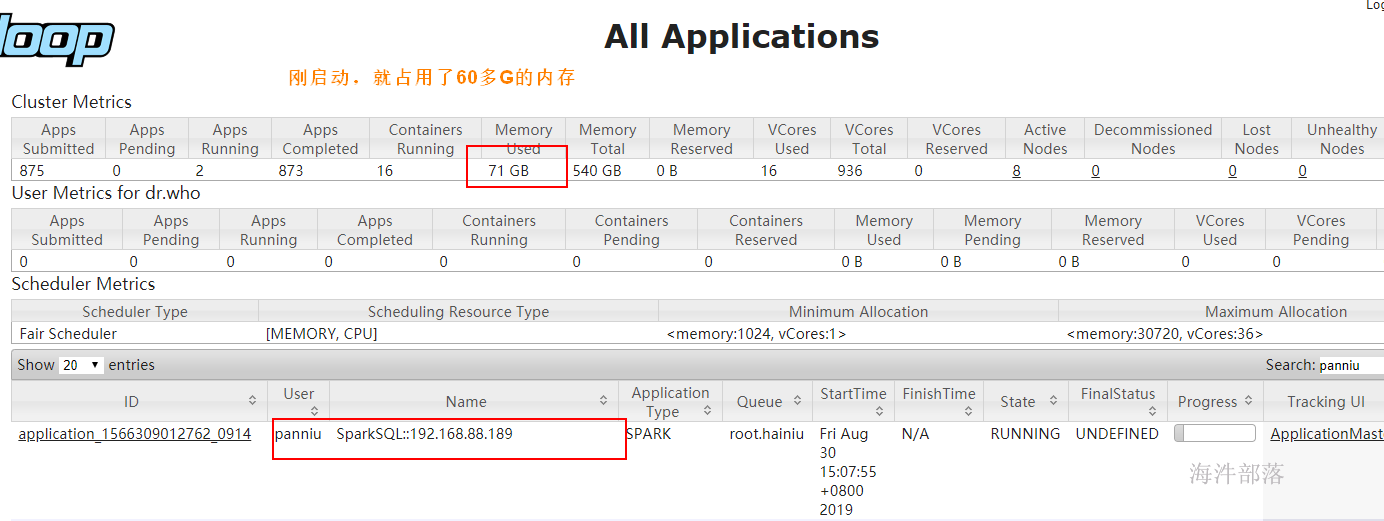

过度依赖内存,内存不够用了就很难堪

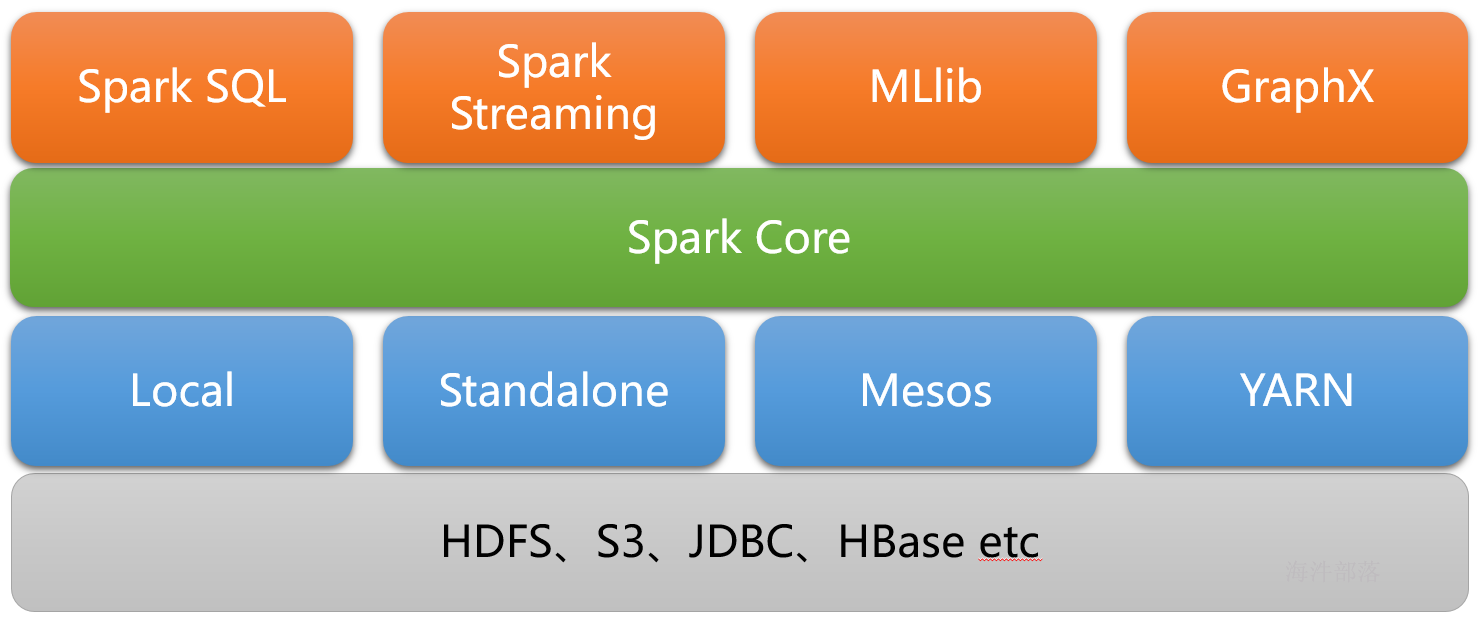

2 spark生态

实现了spark的基本功能、包括任务调度、内存管理、错误恢复与存储系统交互等模块。spark core中还包含了对弹性分布式数据集(resileent distributed dataset)的定义;

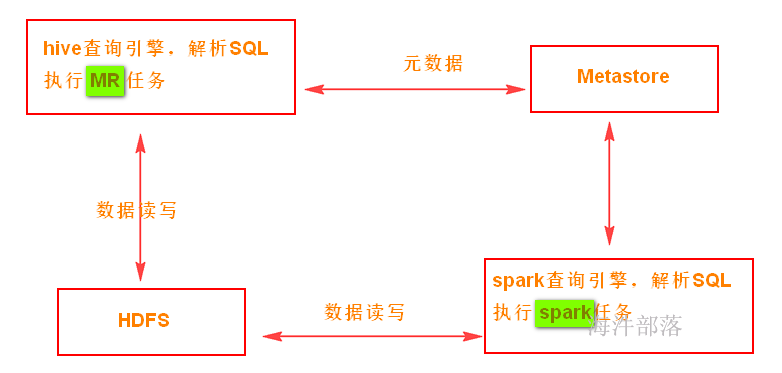

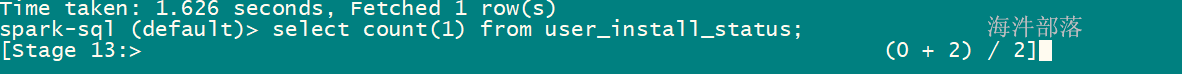

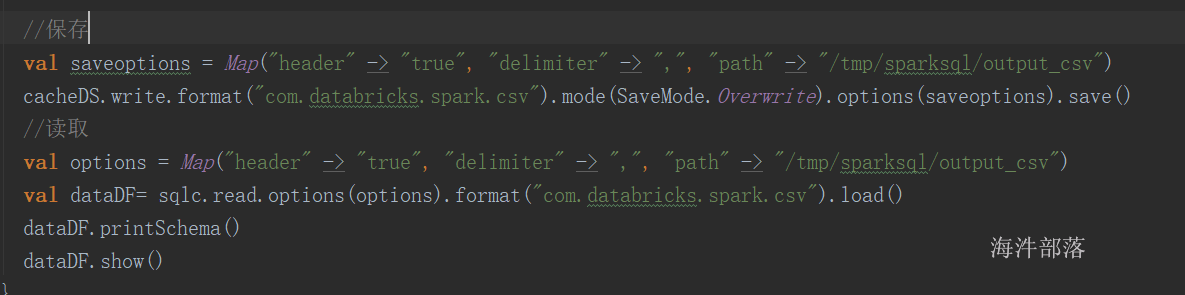

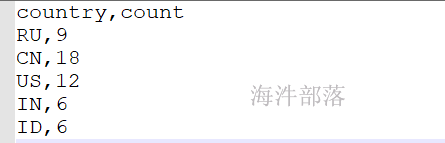

spark sql:

是spark用来操作结构化数据的程序,通过SPARK SQL,我们可以使用SQL或者HIVE(HQL)来查询数据,支持多种数据源,比如HIVE表就是JSON等,除了提供SQL查询接口,还支持将SQL和传统的RDD结合,开发者可以在一个应用中同时使用SQL和编程的方式(API)进行数据的查询分析,SPARK SQL是在1.0中被引入的;

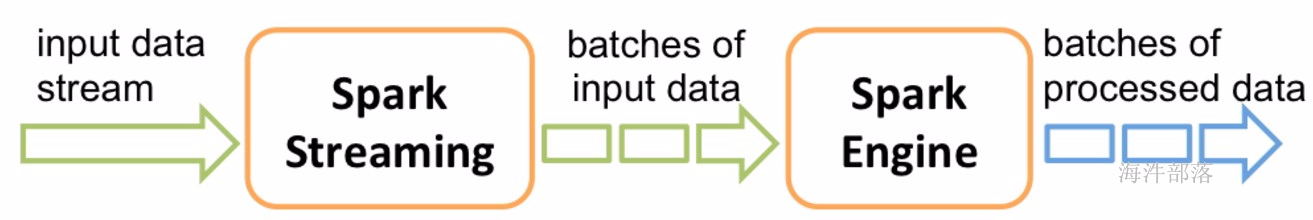

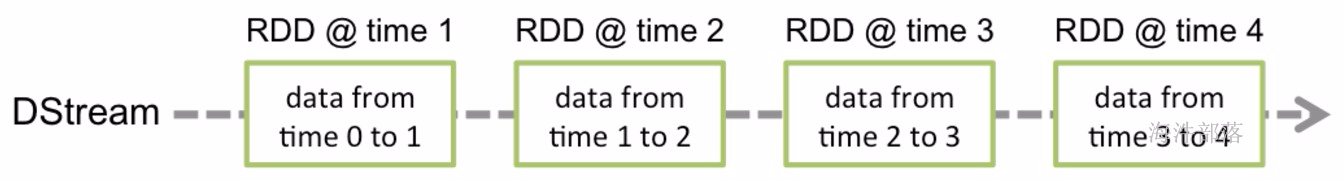

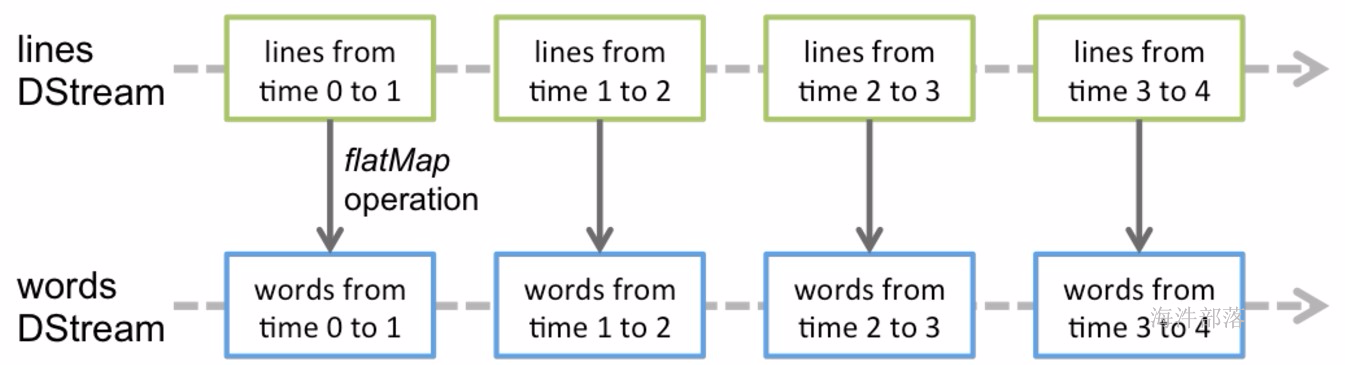

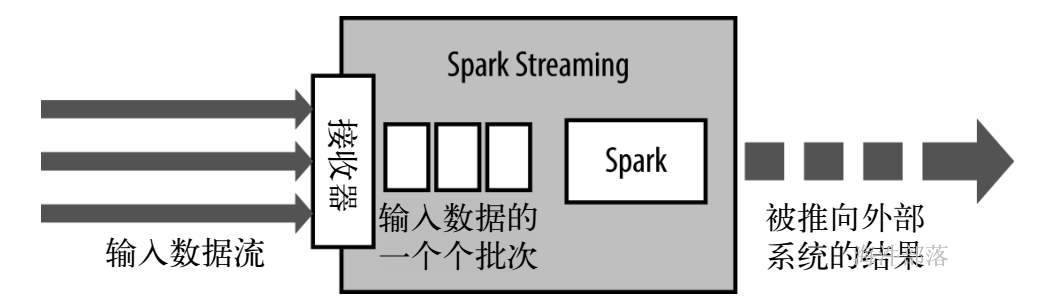

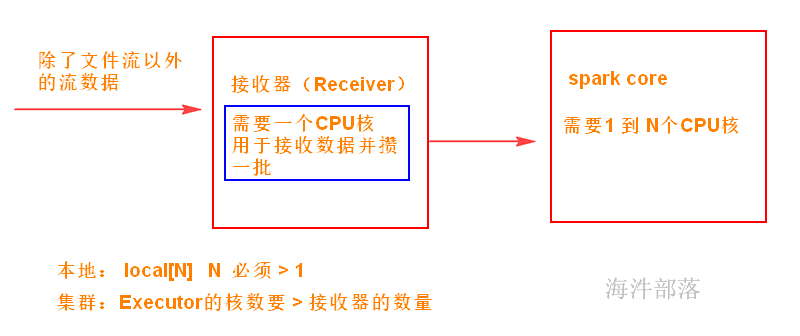

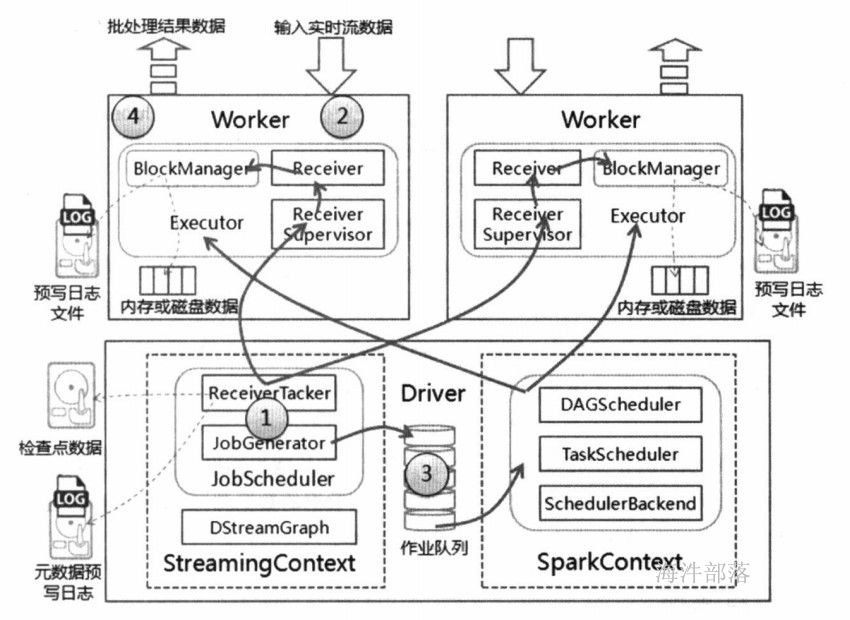

Spark Streaming:

是Spark提供的对实时数据进行流式计算的组件,比如网页服务器日志,或者是消息队列都是数据流。

MLLib:

是Spark中提供常见的机器学习功能的程序库,包括很多机器学习算法,比如分类、回归、聚类、协同过滤等。

GraphX:

是用于图计算的比如社交网络的朋友关系图。

3 Spark应用场景

Yahoo将Spark用在Audience Expansion中的应用,进行点击预测和及时查询等;

淘宝技术团队使用了Spark来解决多次迭代的机器学习算法、高计算复杂度的算法等。应用于内容推荐、社区发现等;

腾讯大数据精准推荐借助Spark快速迭代的优势,实现了在“数据实时采集、算法实时训练、系统实时预测”的全流程实时并行高维算法,最终成功应用于广点通pCTR投放系统上;

优酷土豆将Spark应用于视频推荐(图计算)、广告业务,主要实现机器学习、图计算等迭代计算;

目前大数据在互联网公司主要应用在广告、报表、推荐系统等业务上。在广告业务方面需要大数据做应用分析、效果分析、定向优化等,在推荐系统方面则需要大数据优化相关排名、个性化推荐以及热点点击分析等。这些应用场景的普遍特点是计算量大、效率要求高。

4 Spark环境部署

主要运行方式

Local

Standalone

On YARN

On Mesos

5 Standalone集群模式安装

Linux,CentOS 6/7

安装JDK

下载 spark 安装包

http://spark.apache.org/downloads.html

5.1 非高可用安装

5.1.1 安装步骤

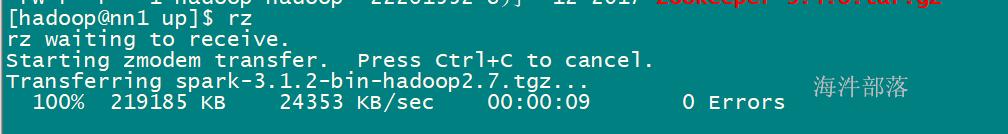

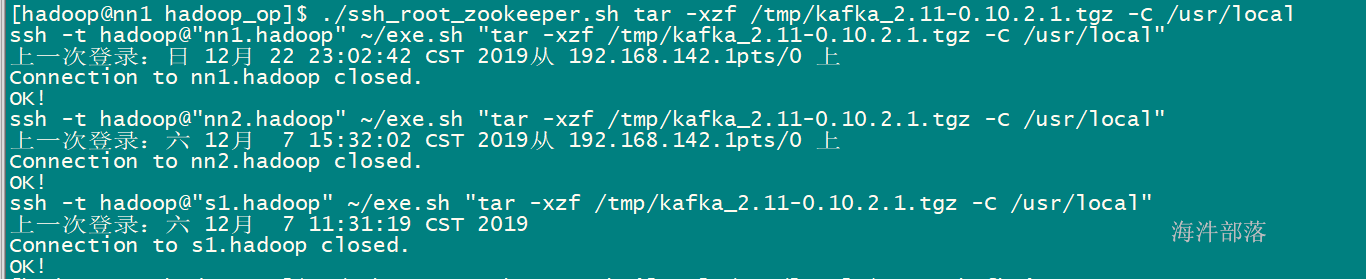

1)上传压缩包

./scp_all.sh ../up/spark-3.1.2-bin-hadoop2.7.tgz /tmp/

./ssh_root.sh tar -xzf /tmp/spark-3.1.2-bin-hadoop2.7.tgz -C /usr/local

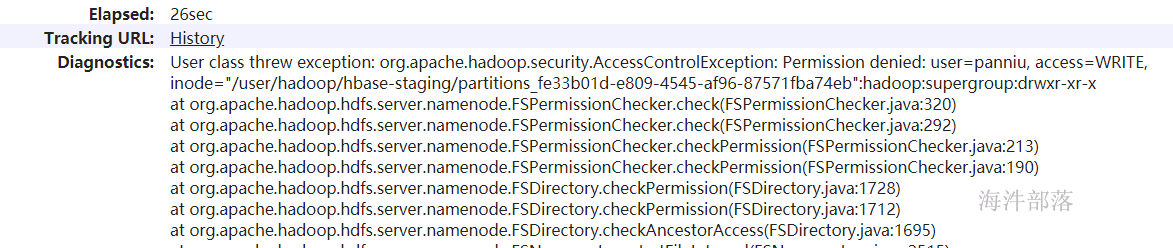

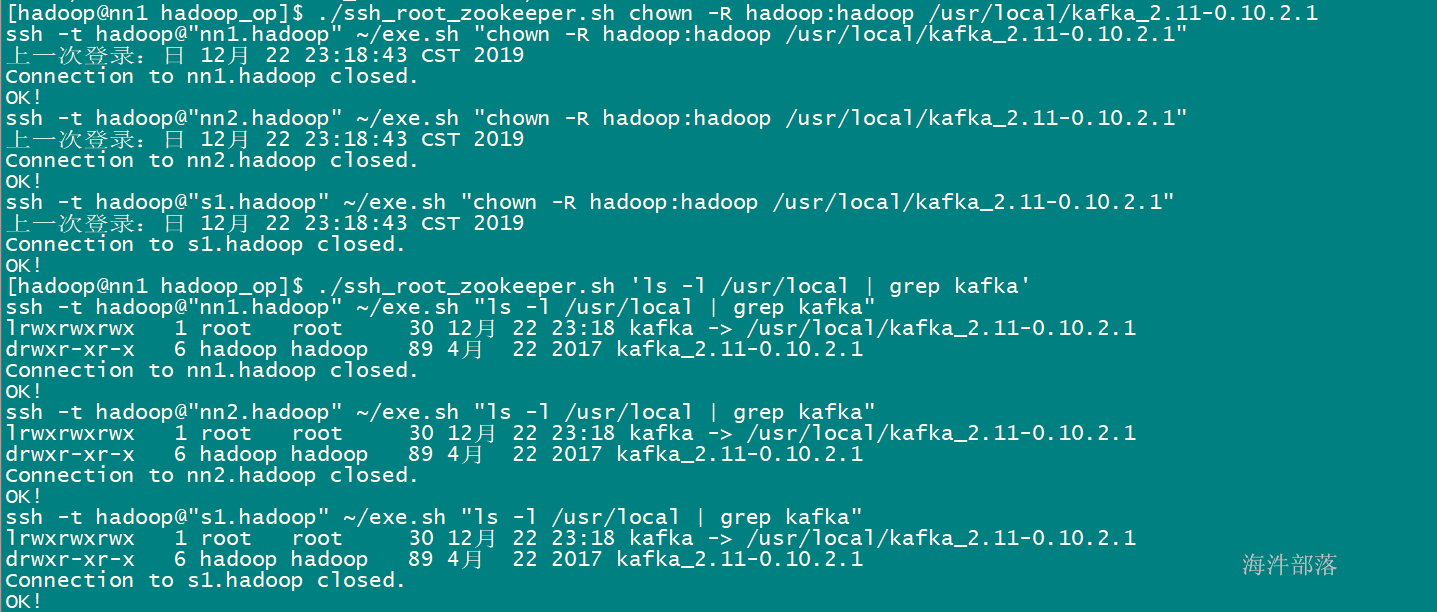

3)修改权限为hadoop

./ssh_root.sh chown -R hadoop:hadoop /usr/local/spark-3.1.2-bin-hadoop2.7

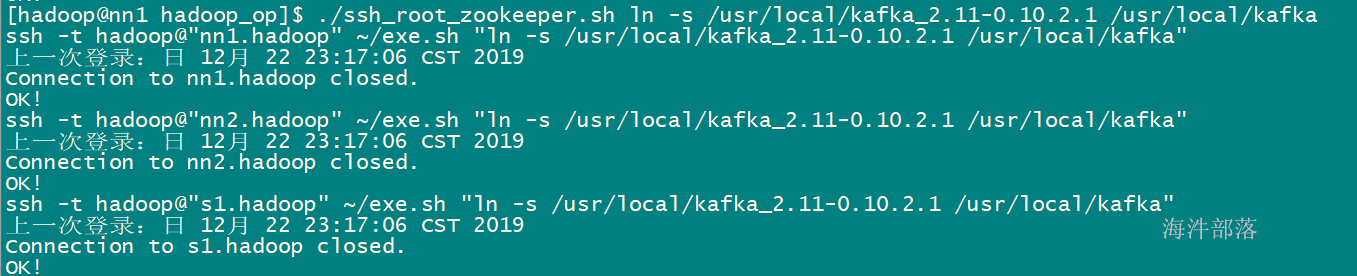

4)创建软件链接

./ssh_root.sh ln -s /usr/local/spark-3.1.2-bin-hadoop2.7 /usr/local/spark

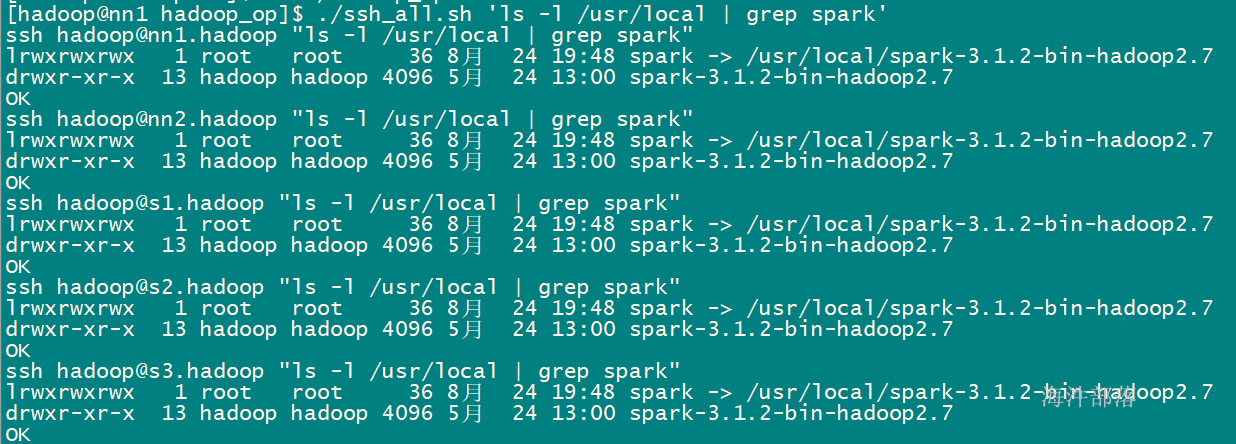

查看/usr/local/目录

bin:可执行脚本

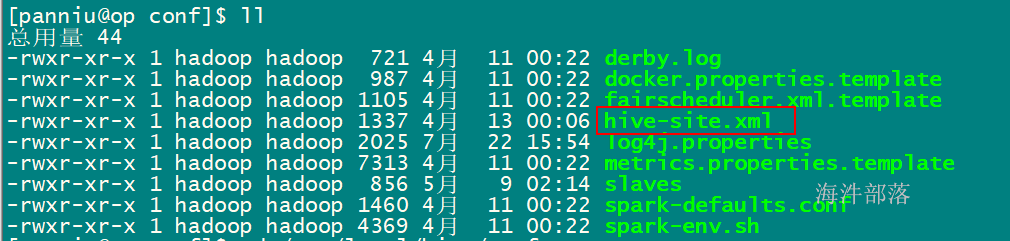

conf:配置文件目录

data:examples里的测试样例的测试数据集

examples:测试样例

jars:lib库

python/R:是python和R

sbin:控制脚本

yarn:yarn支持库

5)备份原有conf 目录

./ssh_all.sh cp -r /usr/local/spark/conf /usr/local/spark/conf_back

6)重命名conf 目录 的配置文件

./ssh_all.sh mv /usr/local/spark/conf/spark-defaults.conf.template /usr/local/spark/conf/spark-defaults.conf

./ssh_all.sh mv /usr/local/spark/conf/spark-env.sh.template /usr/local/spark/conf/spark-env.sh

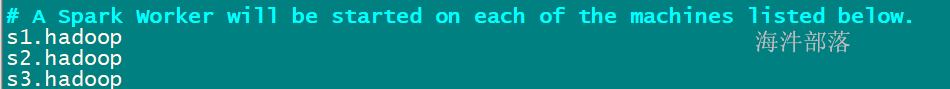

./ssh_all.sh mv /usr/local/spark/conf/workers.template /usr/local/spark/conf/workers

./ssh_all.sh mv /usr/local/spark/conf/log4j.properties.template /usr/local/spark/conf/log4j.properties

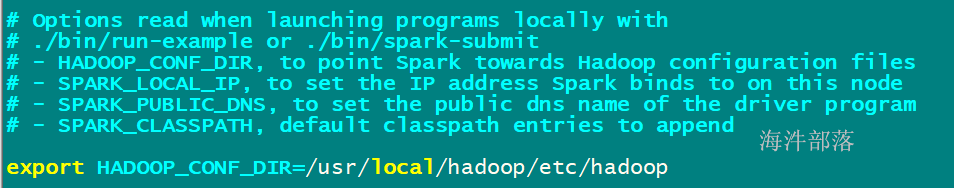

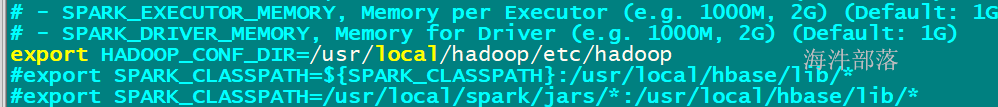

7)在 nn1.hadoop 机器 修改spark-env.sh

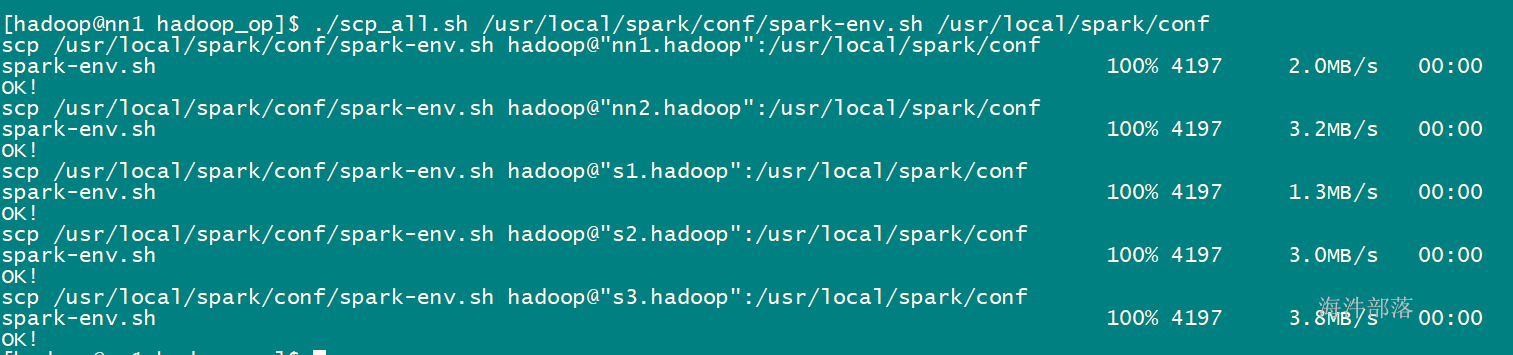

./scp_all.sh /usr/local/spark/conf/spark-env.sh /usr/local/spark/conf/

./scp_all.sh /usr/local/spark/conf/workers /usr/local/spark/conf/

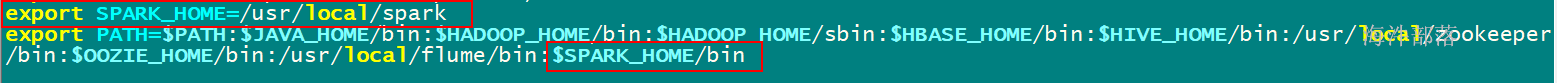

10)在/etc/profile 下增加spark的path,并分发到其他机器

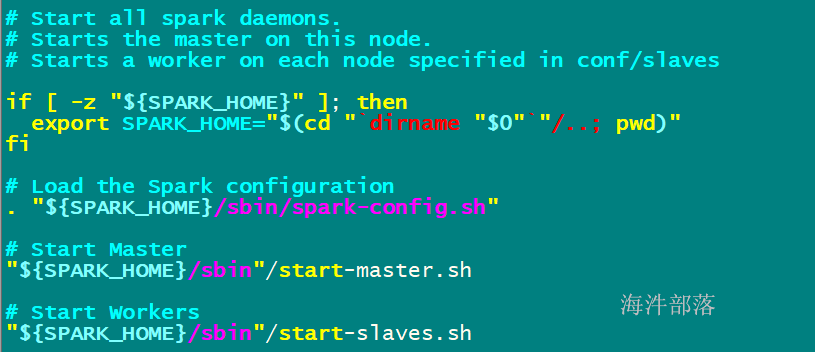

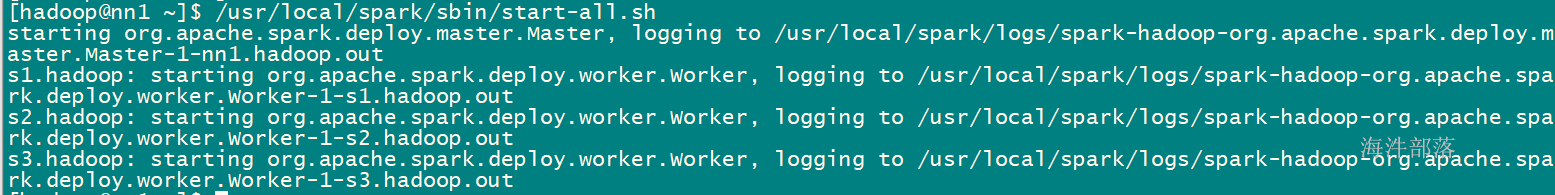

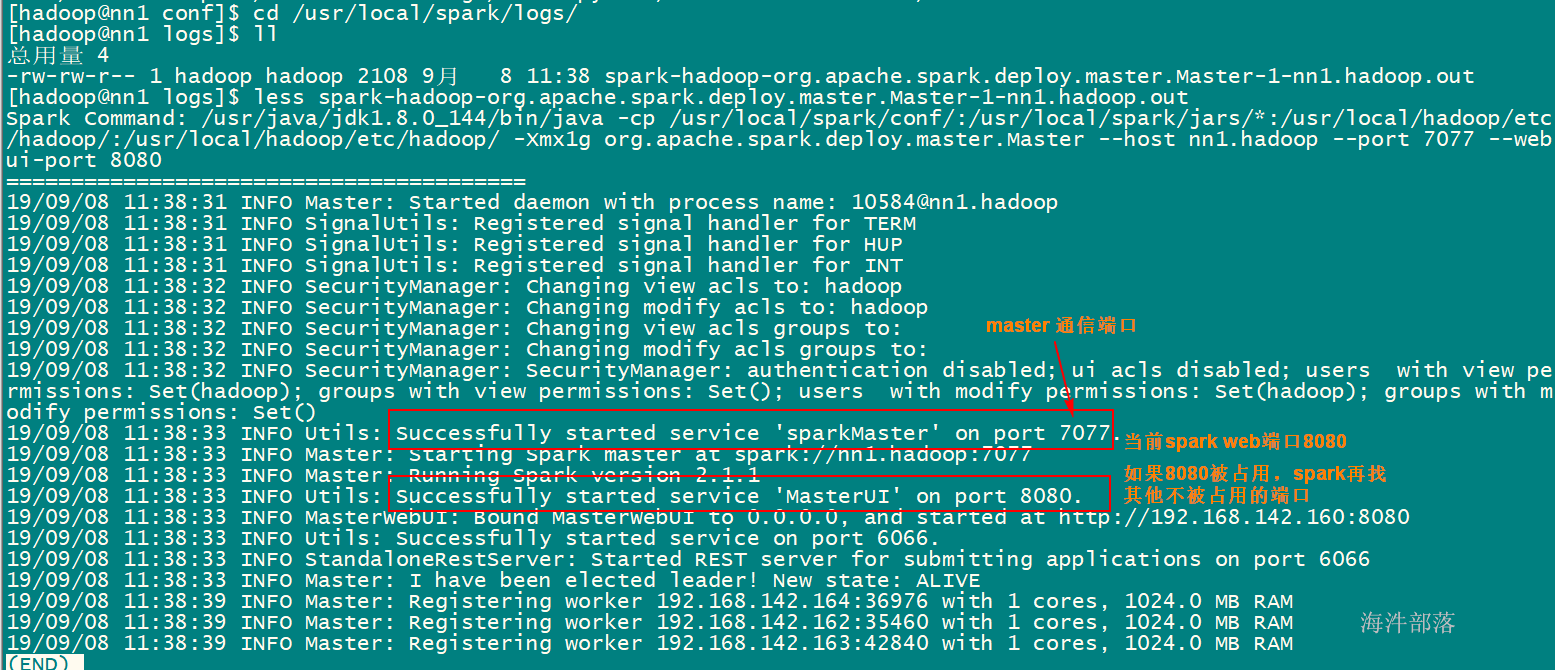

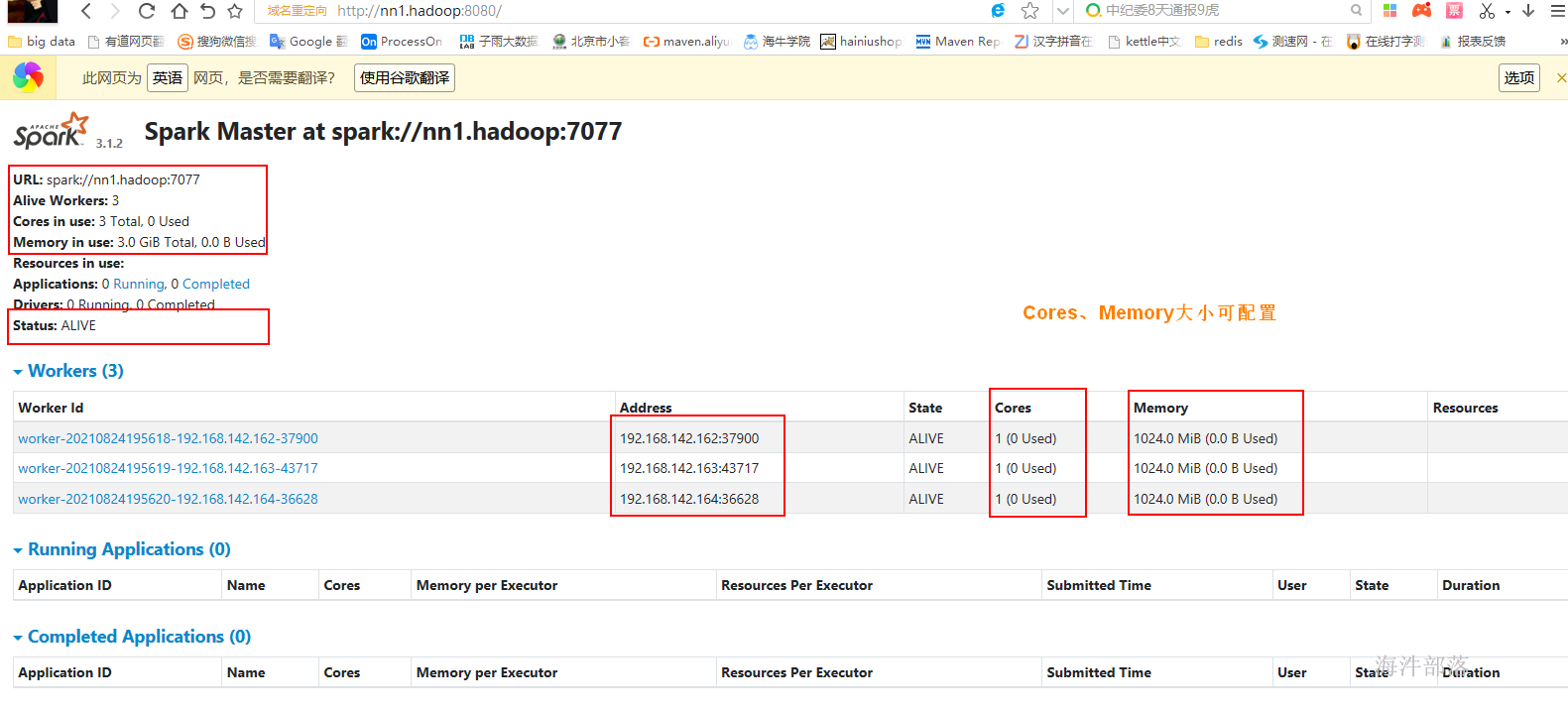

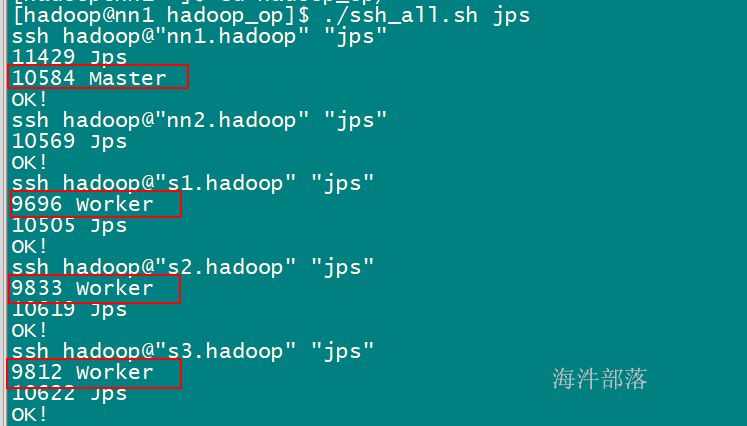

1)启动脚本

/usr/local/spark/sbin/start-all.sh

启动spark

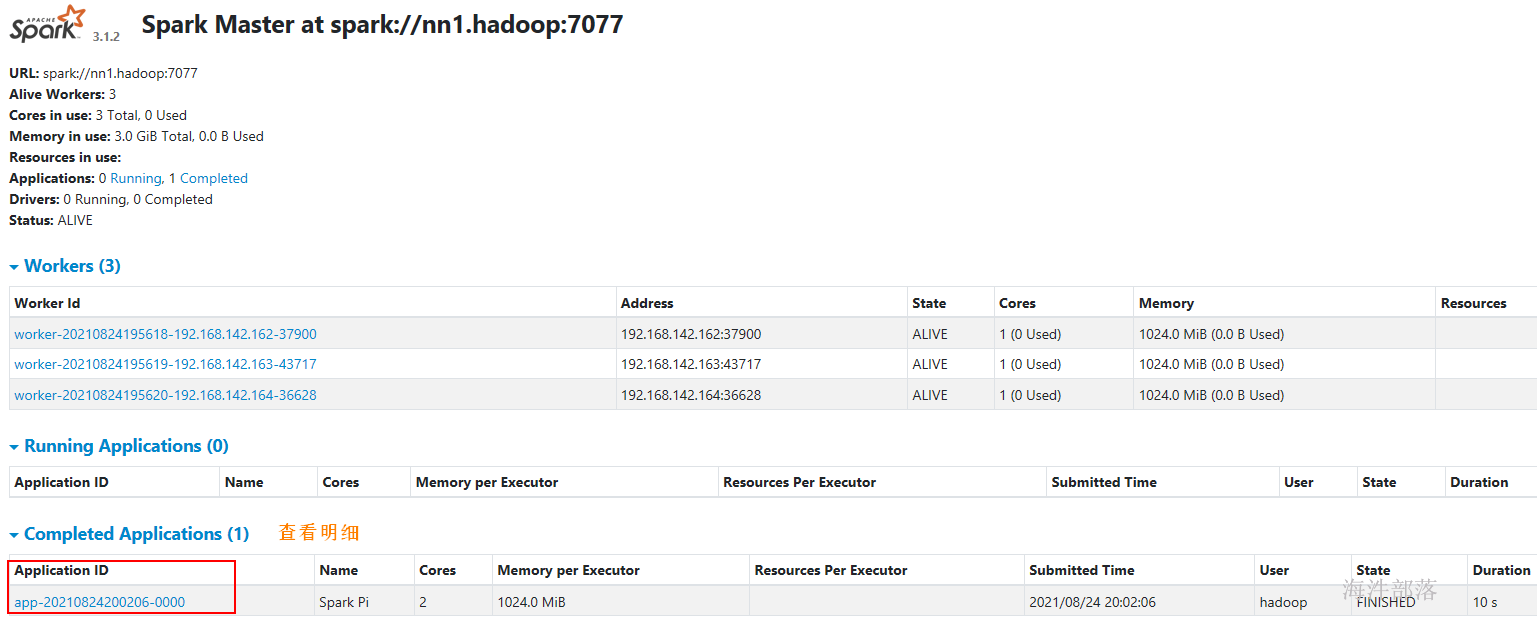

5.1.3 spark测试

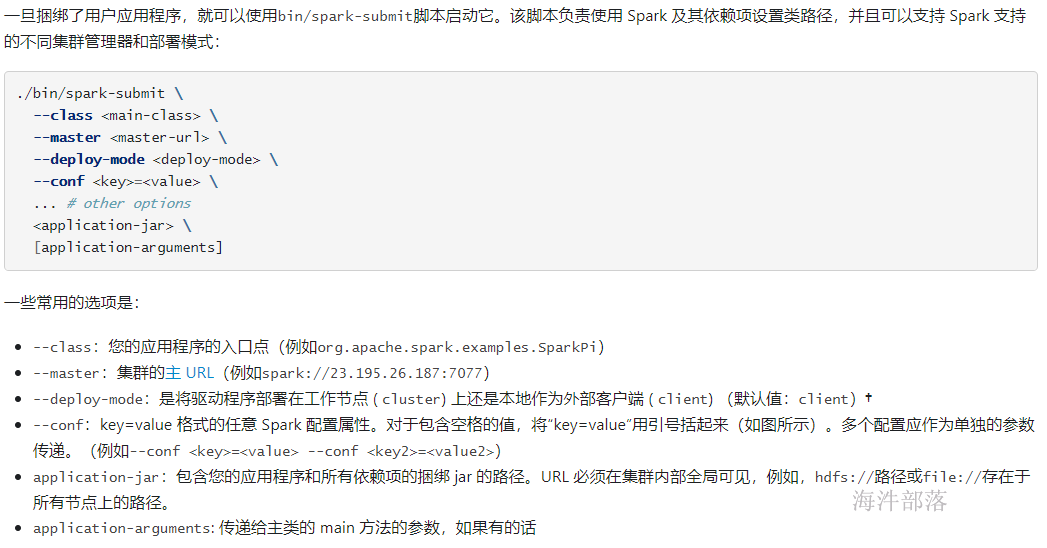

用spark-submit提交spark应用程序。

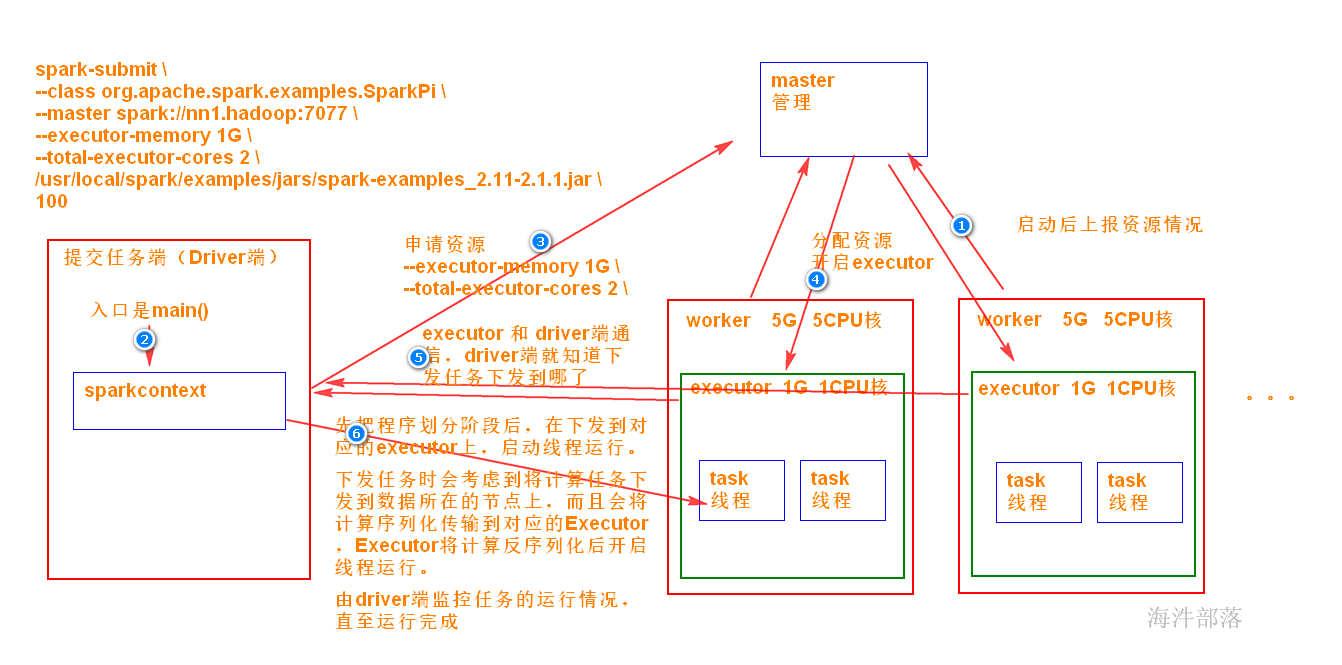

spark-submit \

--class org.apache.spark.examples.SparkPi \

--master spark://nn1.hadoop:7077 \

--executor-memory 1G \

--total-executor-cores 2 \

/usr/local/spark/examples/jars/spark-examples_2.12-3.1.2.jar \

100参考:

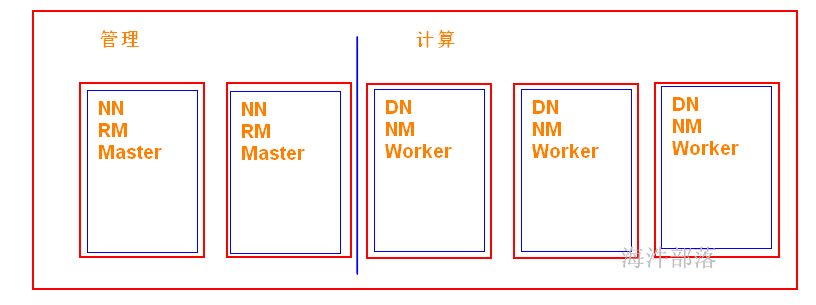

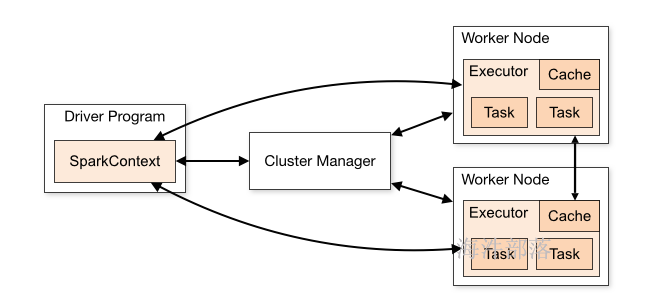

Driver: 运行 Application 的 main() 函数的节点,提交任务,并下发计算任务;

Cluster Manager:在standalone模式中即为Master主节点,负责整个集群节点管理以及资源调度;在YARN模式中为资源管理器;

Worker节点:上报自己节点的资源情况,启动 和 管理 Executor;

Executor:执行器,是为某个Application运行在worker节点上的一个进程;负责执行task任务(线程);

Task:被送到某个Executor上的工作单元,跟MR中的MapTask和ReduceTask概念一样,是运行Application的基本单位。

运行大概流程:

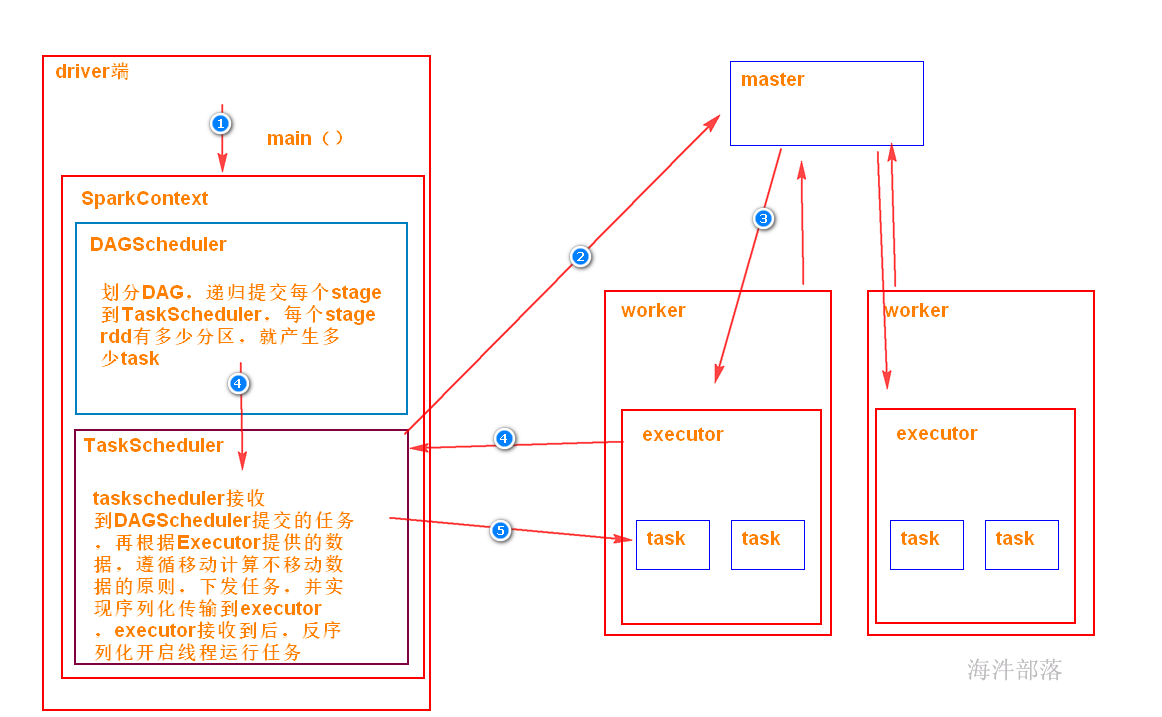

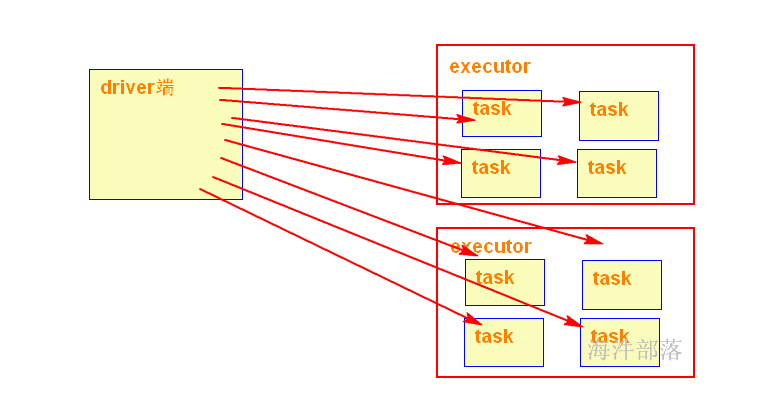

1)driver 端提交应用,并向master申请资源;

2)Master节点通过RPC和Worker节点通信,根据资源情况在相应的worker节点启动Executor 进程;并将资源参数和Driver端的位置传递过来;

3)启动的Executor 进程 会主动与 Driver端通信,Driver 端根据代码的执行情况,产生多个task,发送给Executor;

4)Executor 启动 task 做真正的计算,每个Task 得到资源参数后,对相应的输入分片数据执行计算逻辑;

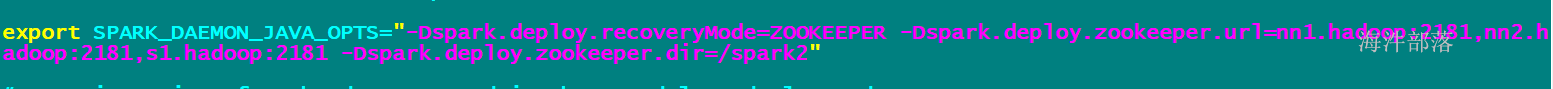

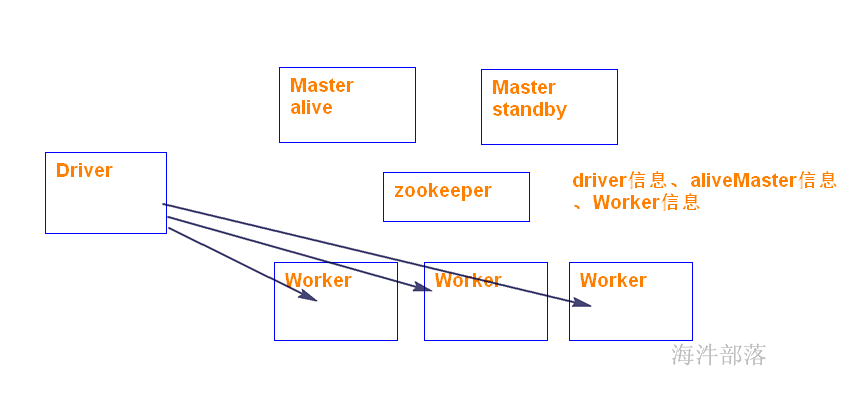

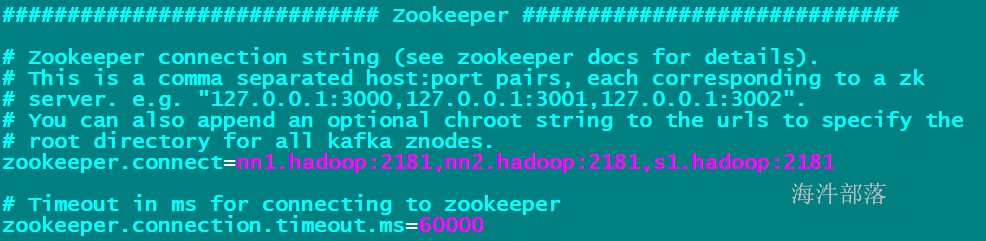

spark 高可用是通过zookeeper 实现。

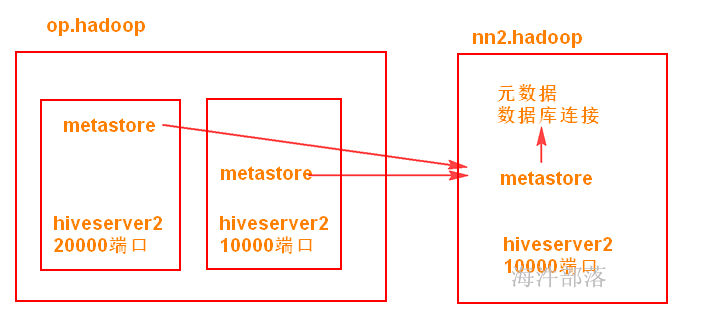

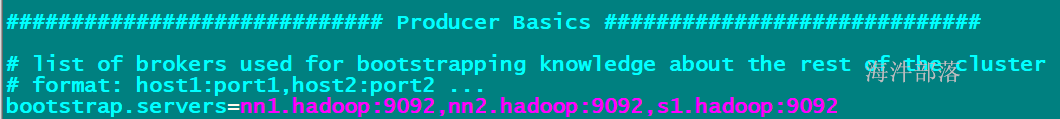

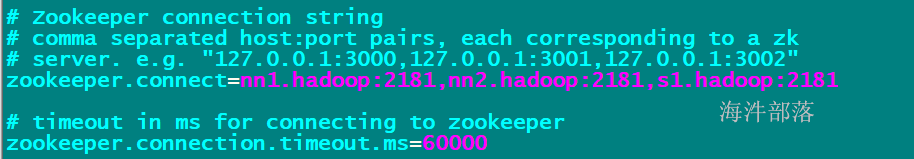

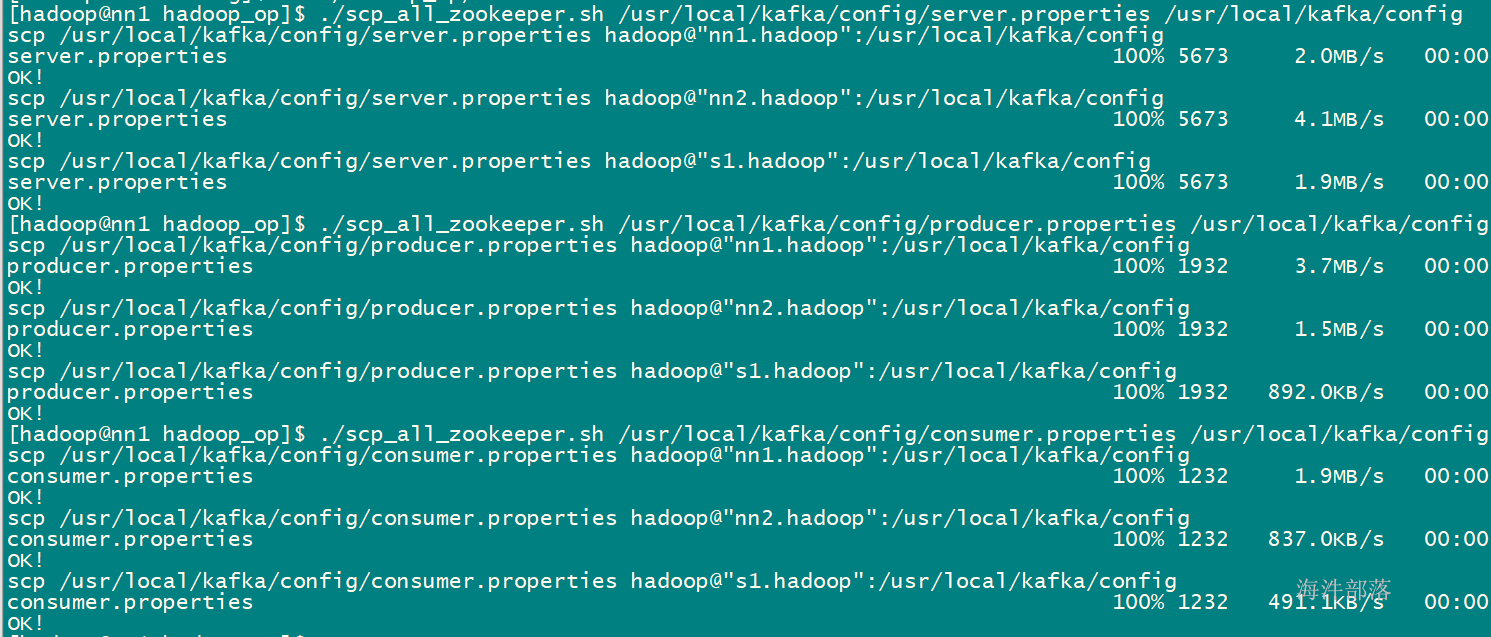

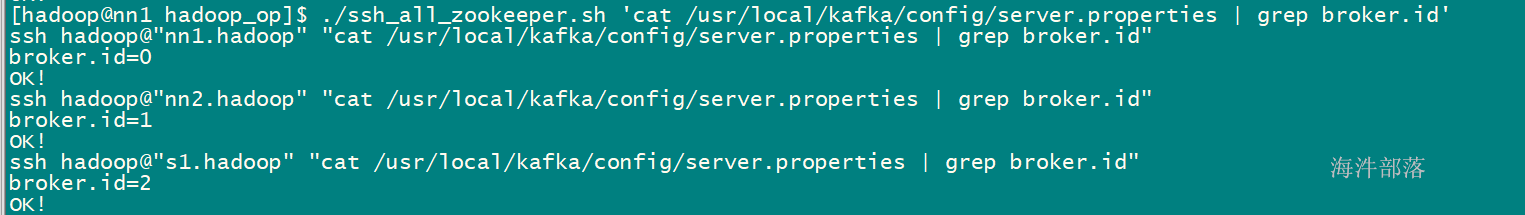

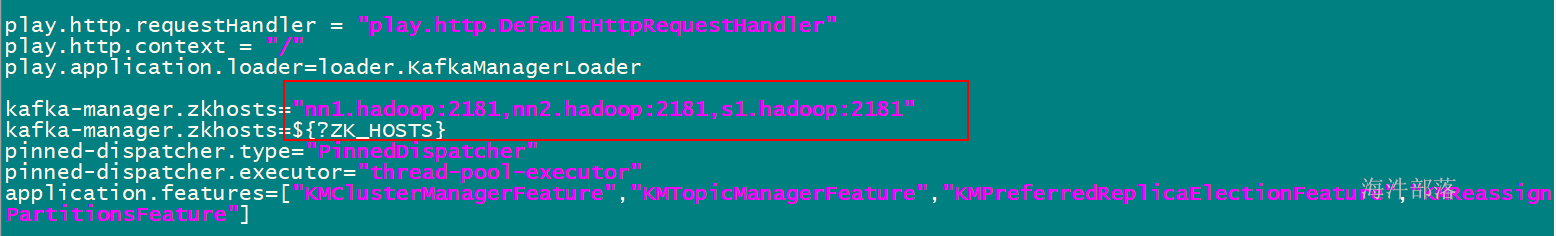

5.2.1 修改配置spark-env.sh,并分发到其他机器

export SPARK_DAEMON_JAVA_OPTS=“-Dspark.deploy.recoveryMode=ZOOKEEPER -Dspark.deploy.zookeeper.url=nn1.hadoop:2181,nn2.hadoop:2181,s1.hadoop:2181 -Dspark.deploy.zookeeper.dir=/spark2”

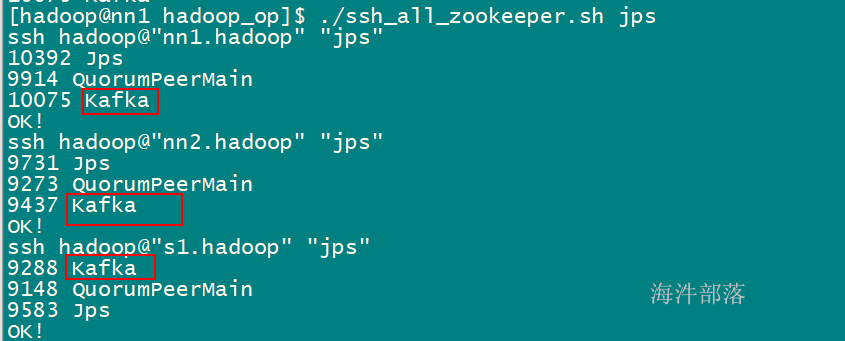

#step1:启动zookeeper

#step2:启动spark

/usr/local/spark/sbin/start-all.sh

#step3:在nn2.hadoop节点启动spark ha

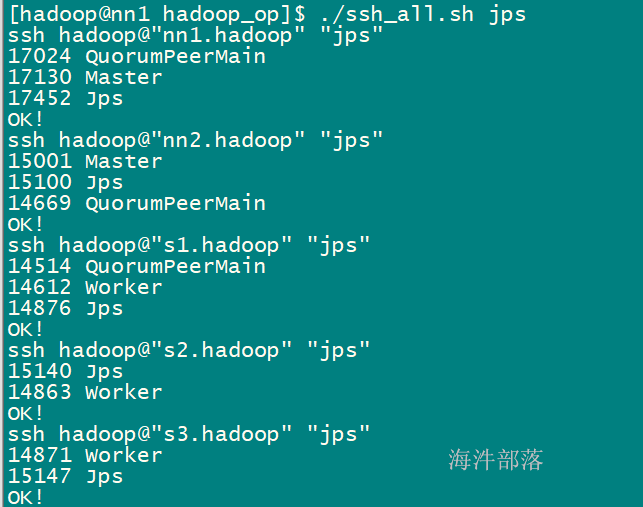

/usr/local/spark/sbin/start-master.sh 启动后查看进程:

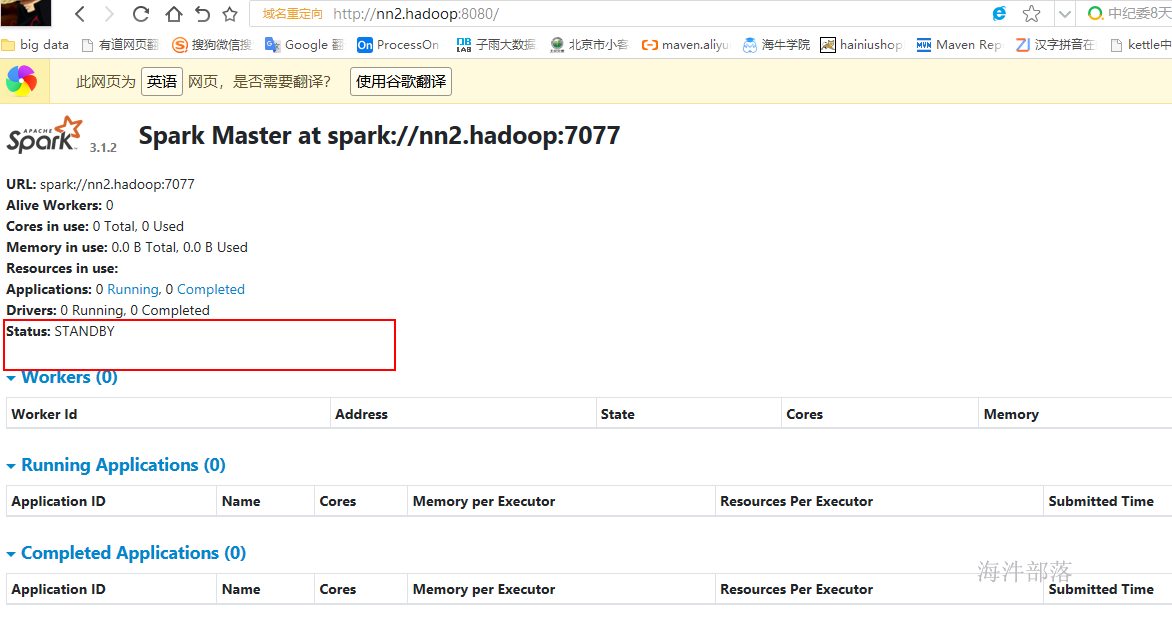

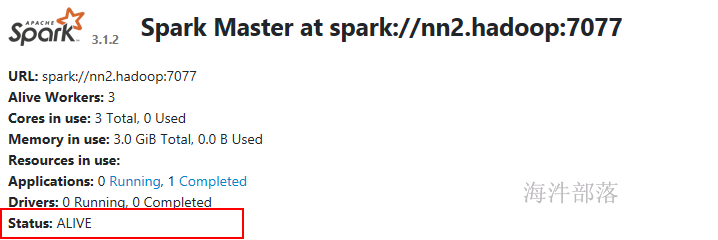

查看nn2.hadoop spark的web页面,当前是standby 状态。

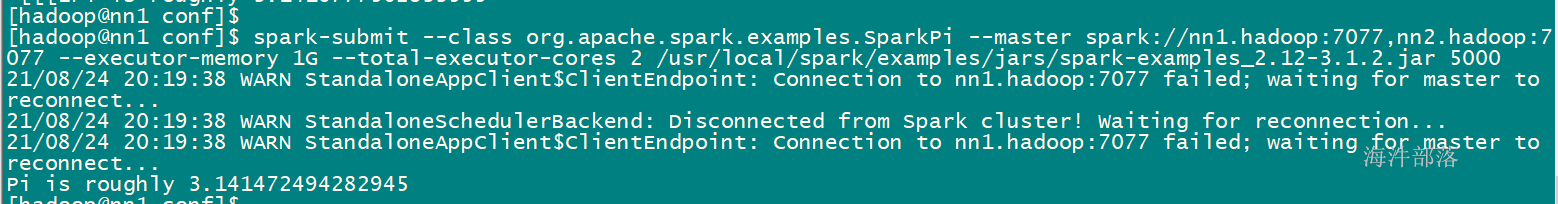

在运行下面的任务的同时,kill 掉 ALIVE 的 master,看会不会切换

spark-submit

–class org.apache.spark.examples.SparkPi

–master spark://nn1.hadoop:7077,nn2.hadoop:7077

–executor-memory 1G

–total-executor-cores 2

/usr/local/spark/examples/jars/spark-examples_2.12-3.1.2.jar

5000

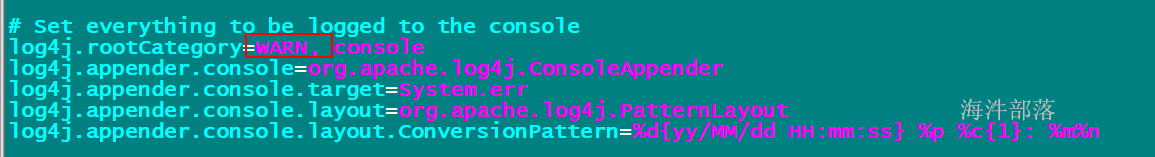

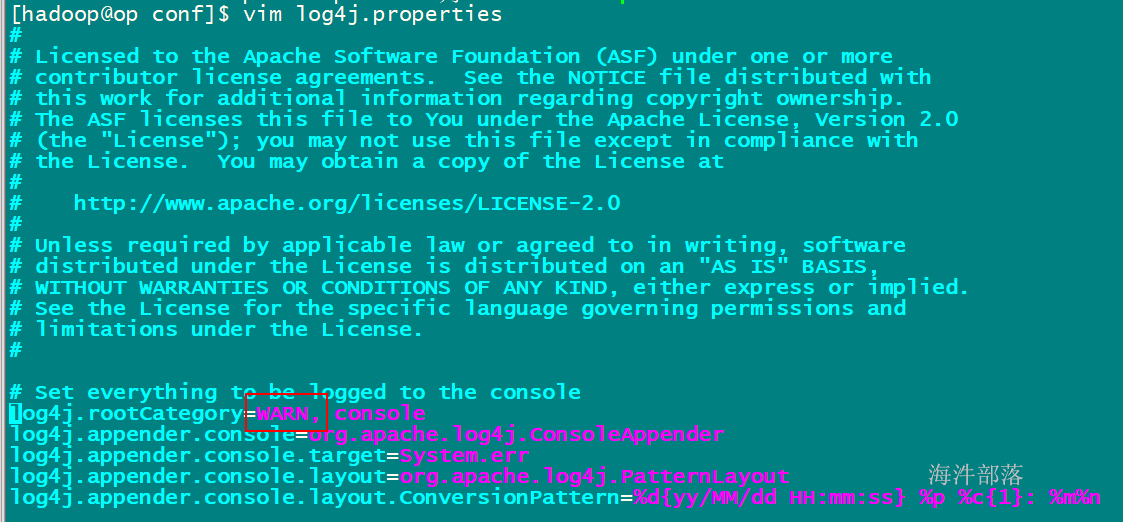

为了不打印太多日志,把log 级别设置成WARN

vim /usr/local/spark/conf/log4j.properties

5.2.4 高可用原理

在应用程序执行过程中,如果进行master 的ha切换会影响应用程序的运行吗?

不会,因为程序运行前已经向master申请过资源了。申请过后就是Driver与Executors之间的通信,这个过程一般不需要Master参与,除非executor有故障。

粗粒度:应用程序需要多少资源,就一次性分配。

好处:是一次性分配资源好后,不需要再关心资源的分配,而在作业运行过程中可以让driver和executors交互,

完成作业或程序运行。

弊端:假设有一百万个任务,如果只有一个任务没有完成,那么其他所有资源都会闲置,其他任务会等待,造成浪费。

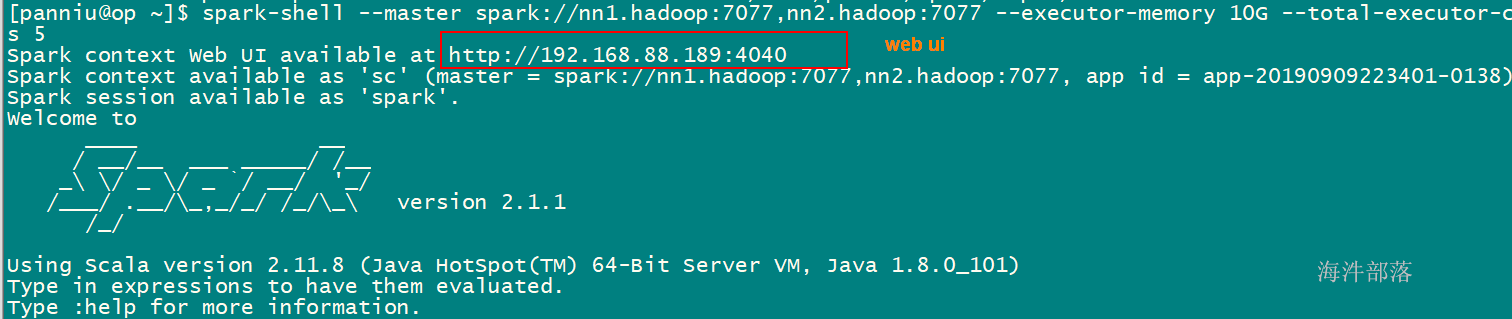

5.3 spark-shell开发wordCount

Spark Shell:

是基础scala的的命令行客户端,是一个spark的driver应用程序,可以写spark程序进行测试,可以本地运行也可以集群运行,取决于是否设置–master

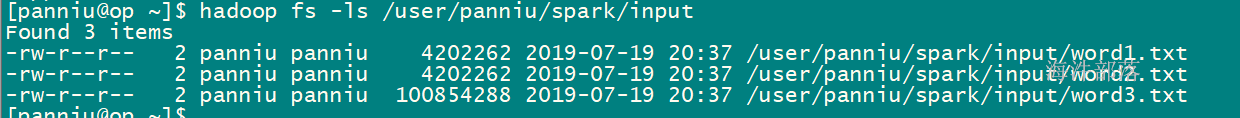

准备数据

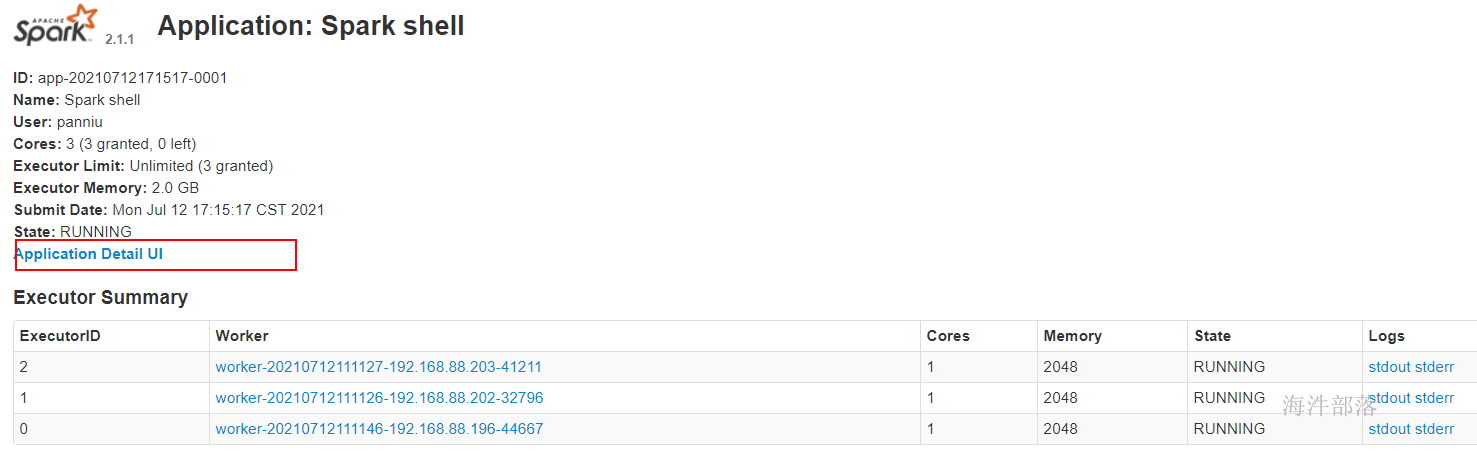

spark-shell –master spark://nn1.hadoop:7077 –executor-memory 2G –total-executor-cores 3

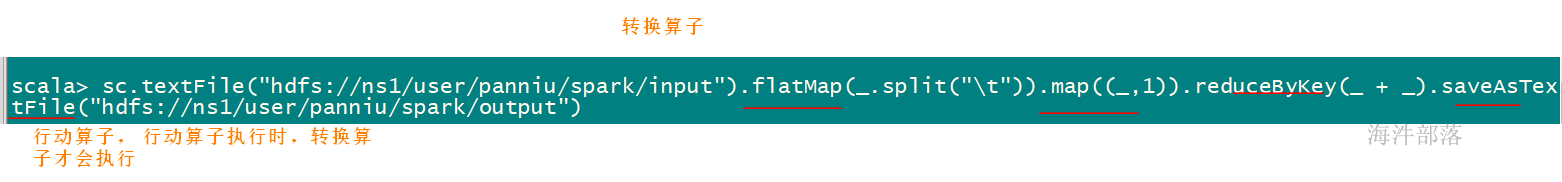

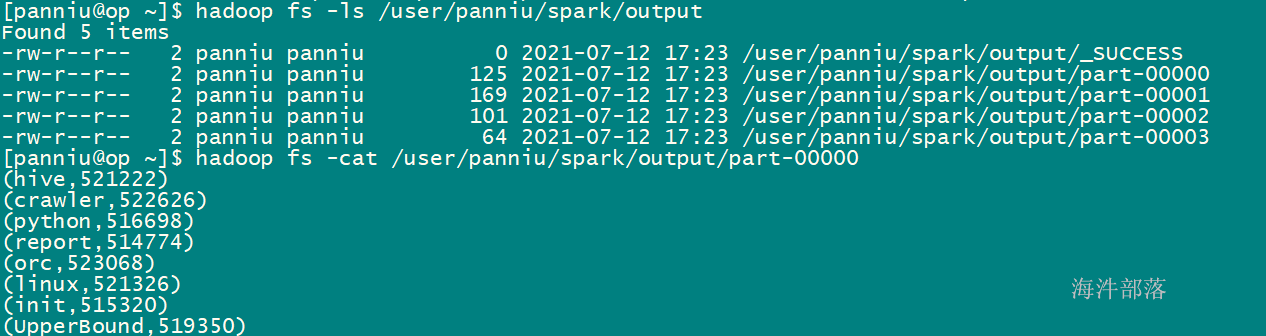

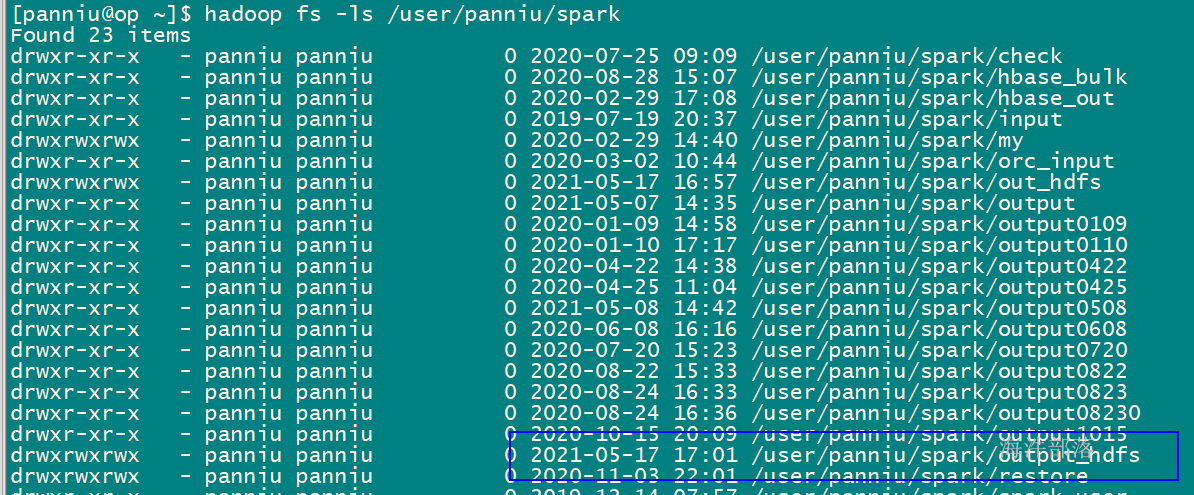

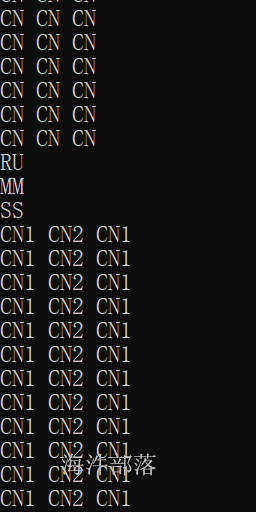

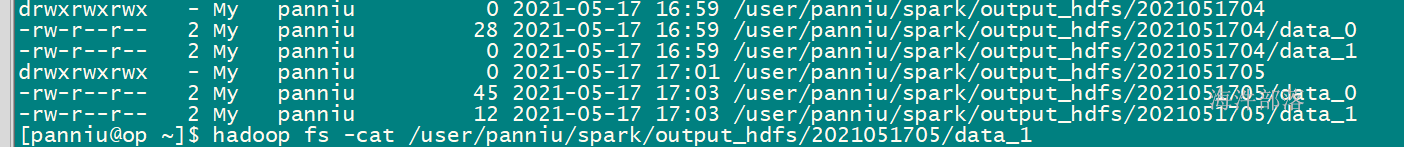

// 计算hdfs目录下的wordcount,并输出到/user/panniu/spark/output

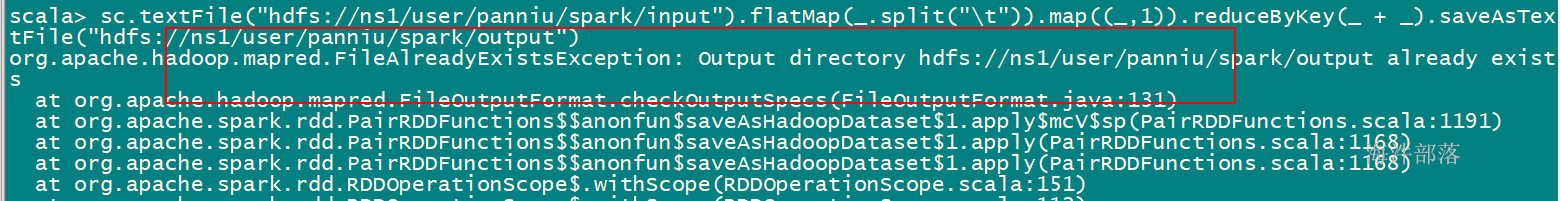

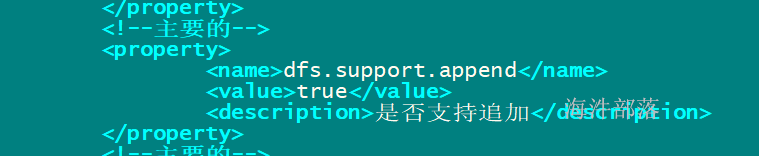

sc.textFile("hdfs://ns1/user/panniu/spark/input").flatMap(_.split("\t")).map((_,1)).reduceByKey(_ + _).saveAsTextFile("hdfs://ns1/user/panniu/spark/output")输出目录不能存在,存在报错

| yarn | spark的standAlone调度模式对比 | spark集群各组件的功能 |

|---|---|---|

| ResourceManager | Master | 管理子节点,调度资源,接受任务请求 |

| NodeManger | Worker | 管理当前节点,并管理子节点 |

| YarnChild | Executor (Task) | 运行真正的计算逻辑(Task) |

| client | driver | driver(Client+AppMaster)提交App,管理该任务的Executor |

| ApplicationMaster |

spark on yarn 的

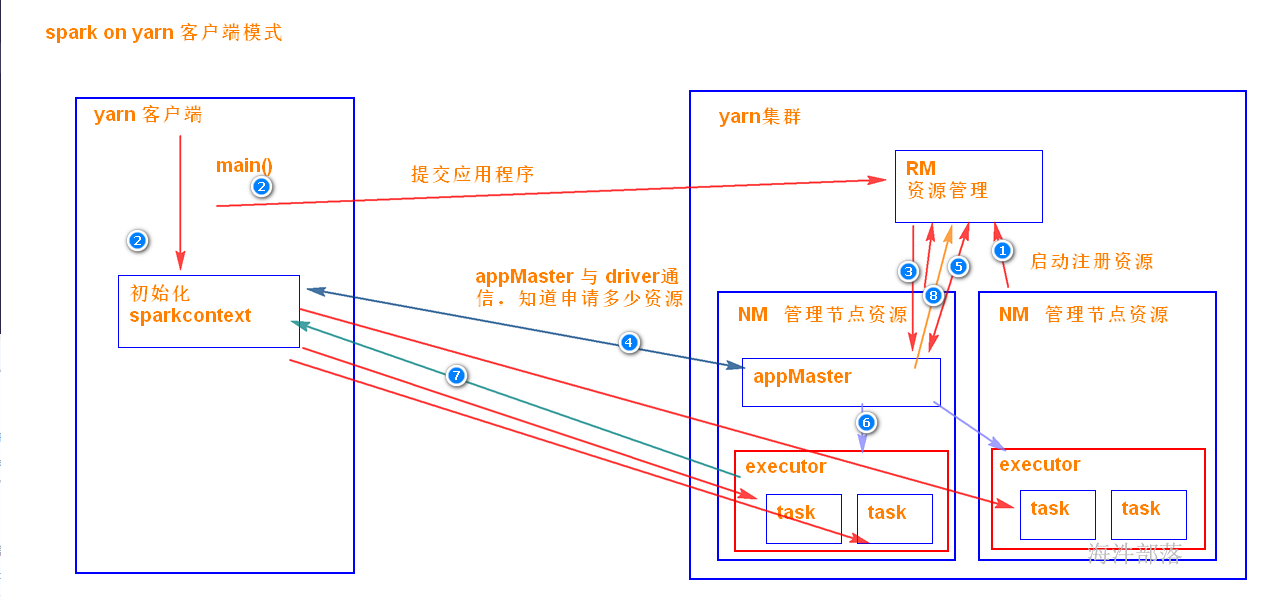

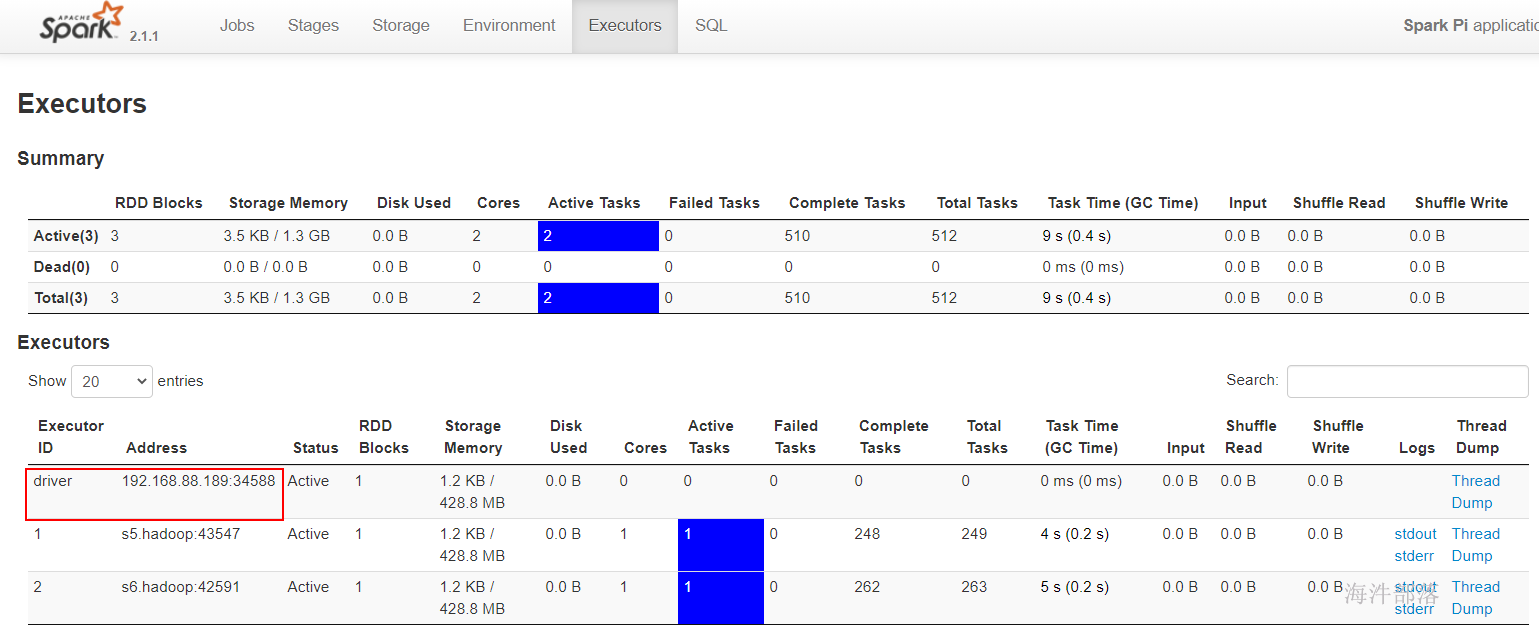

5.4.1 yarn-client模式

是driver端是独立于 yarn集群的,运算的时候,driver端需要管理executor 中task的运行,所以driver端(客户端)是不能离开的。

driver端在客户端上,所以好调试日志。

当在客户端提交多个spark应用时,它会对客户端造成很大的网络压力,yarn-client模式只适合 交互式环境开发。

spark-submit \

--class org.apache.spark.examples.SparkPi \

--master yarn \

--queue hainiu \

/usr/local/spark/examples/jars/spark-examples_2.12-3.1.2.jar \

20000

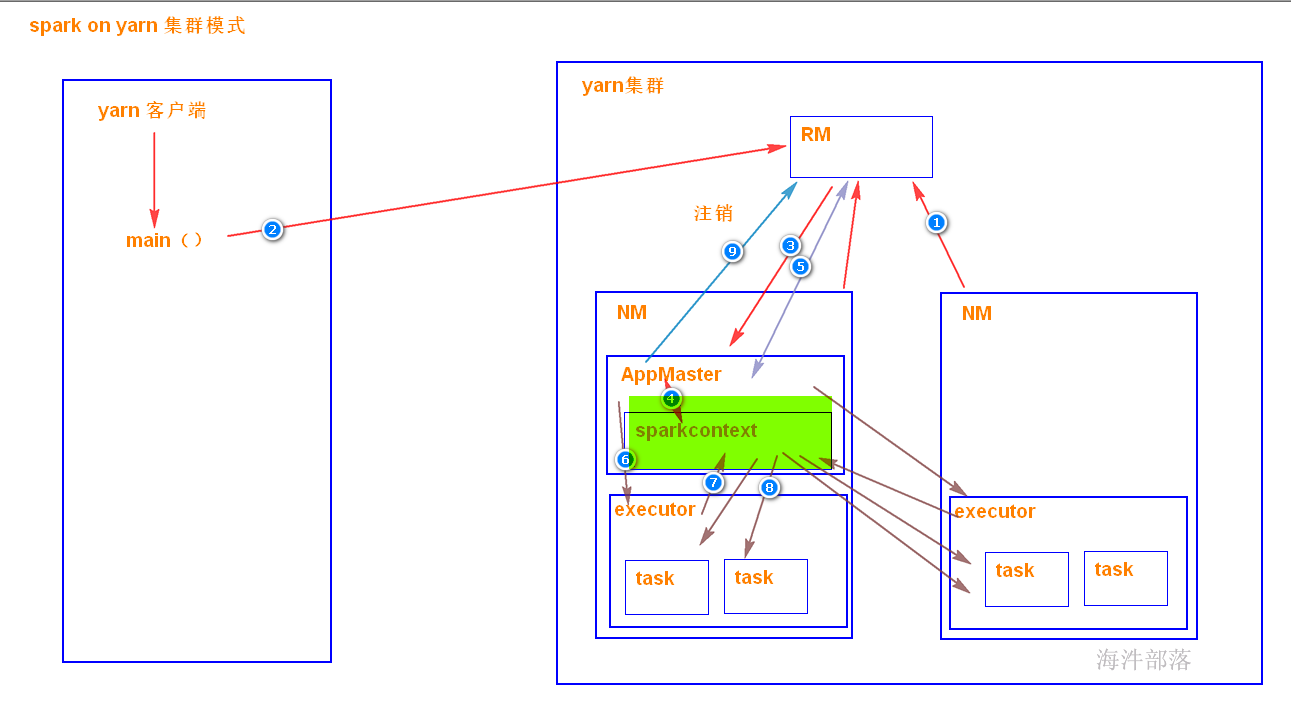

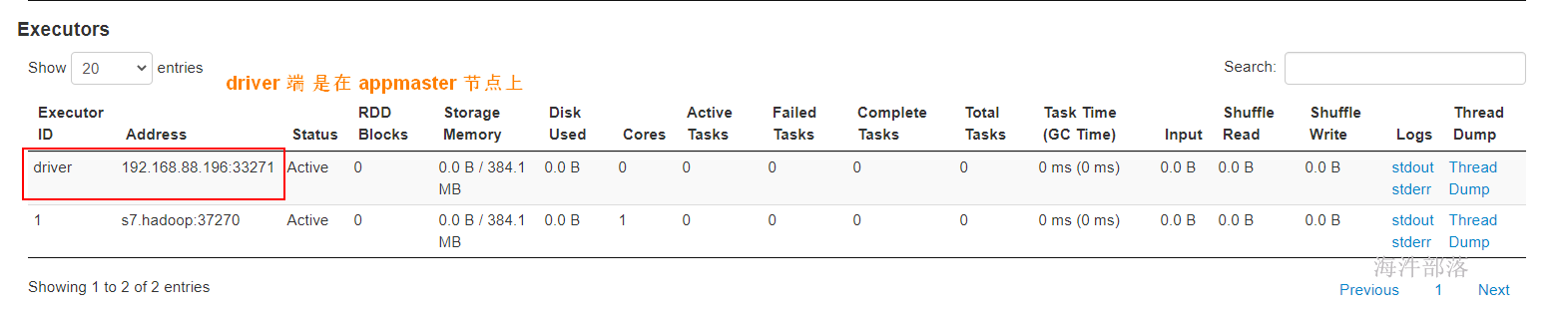

5.4.2 yarn-集群模式

driver端是在APPMater节点,是在yarn集群里面,那运行和监控executor 的任务都是在yarn集群里面。yarn提交任务的客户端是可以离开的。

driver端在yarn集群里面,所以不好调试日志。

客户端一经提交可以离开,常用于正常的提交应用,适合生产环境。

spark-submit \

--class org.apache.spark.examples.SparkPi \

--master yarn \

--queue hainiu \

--deploy-mode cluster \

/usr/local/spark/examples/jars/spark-examples_2.12-3.1.2.jar \

20000

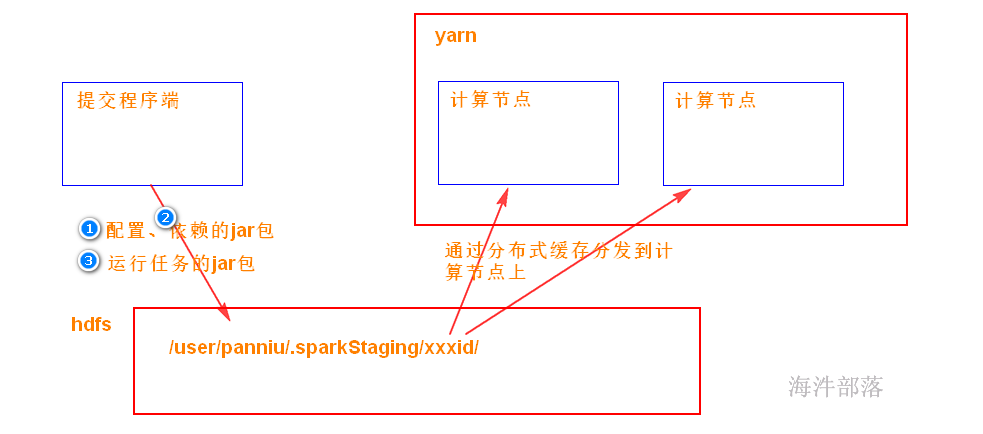

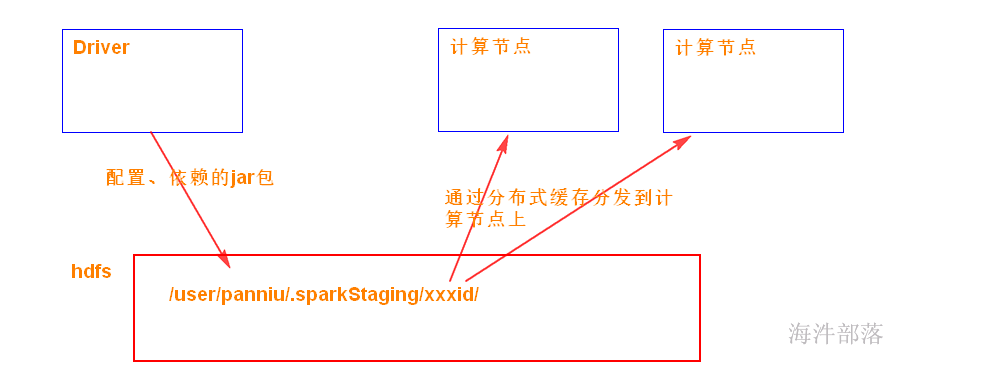

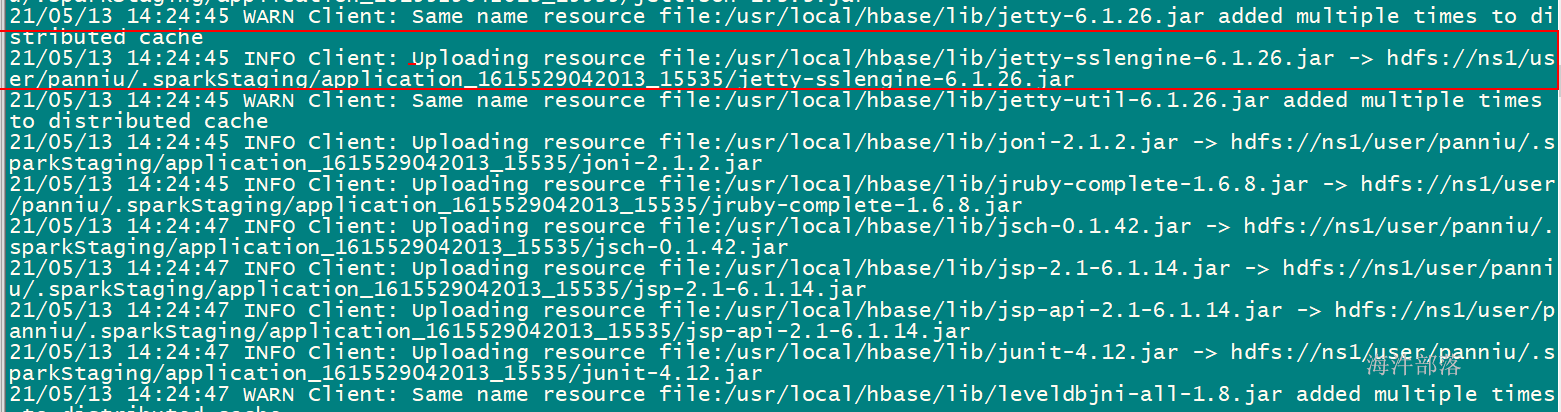

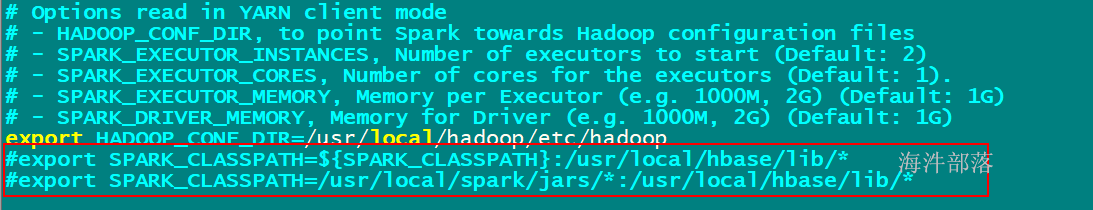

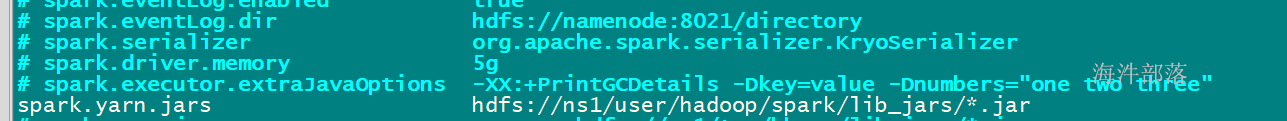

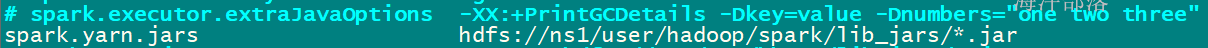

当spark在yarn上运行时,yarn要拿到 3样:

1)运行用的配置

2)运行要依赖的jar包

默认是SPARK_HOME/jars 目录下的jar包打包

如果想加入其它jar包,可通过 –jars 添加

3)运行任务的jar包(带有代码的jar包)

这3样需要从提交程序端 上传到 /user/xxx/.sparkStaging/yarnid/目录下(分布式缓存),然后再分发到运行任务的计算节点。

6.1

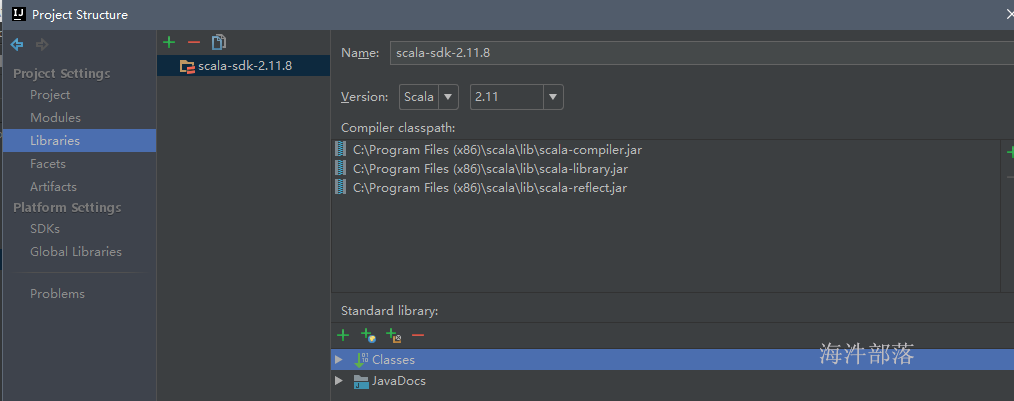

JDK 1.8

IDEA + scala2.12的sdk

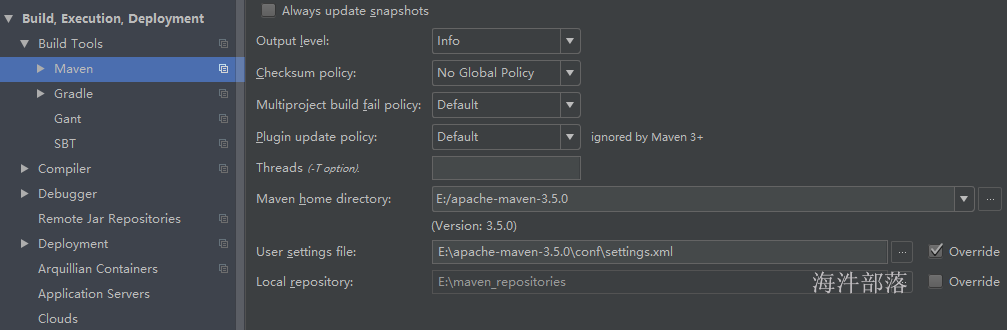

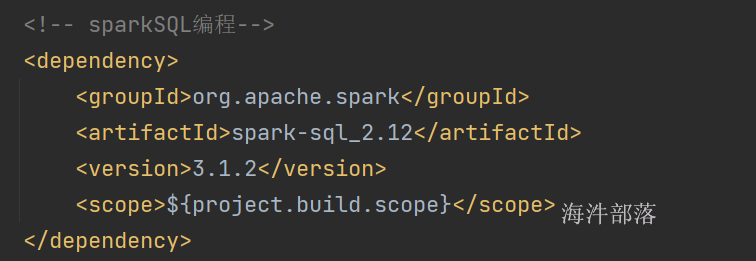

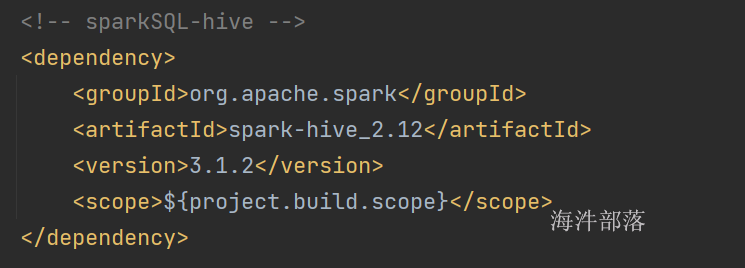

6.2 开发spark项目的maven依赖

本课程采用spark3.1.2 + scala2.12的sdk

<dependencies>

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-core_2.12</artifactId>

<version>3.1.2</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>2.7.3</version>

</dependency>

</dependencies>6.3 搭建spark的开发环境

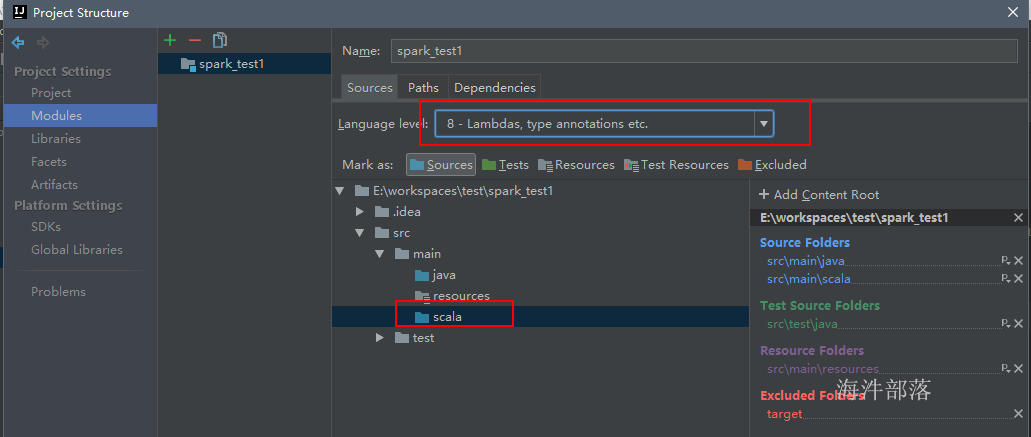

1)在idea创建maven工程

2)创建scala目录,并设置成代码目录 和 jdk级别为8

6)添加 log4j.properties

7 spark wordcount 代码实现

7.1 scala版

第一版wordcount

import org.apache.hadoop.conf.Configuration

import org.apache.hadoop.fs.{FileSystem, Path}

import org.apache.spark.rdd.RDD

import org.apache.spark.{SparkConf, SparkContext}

object WordCount {

def main(args: Array[String]): Unit = {

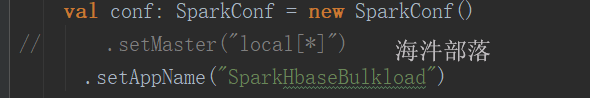

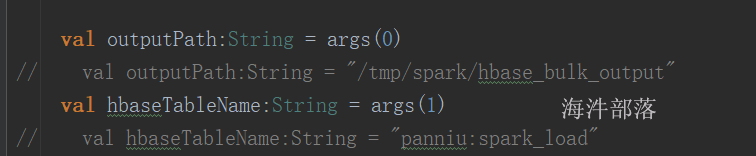

val conf: SparkConf = new SparkConf().setMaster("local[*]").setAppName("wordcount")

val sc: SparkContext = new SparkContext(conf)

val rdd: RDD[String] = sc.textFile("/tmp/spark/input1")

val mapRdd: RDD[(String, Int)] = rdd.flatMap(_.split("\t")).map((_,1))

// groupBy+mapValues 效率低, groupBy只是按照key把数据集合在一起,并不计算,拉取的数据量特别大

// val resRdd: RDD[(String, Int)] = mapRdd.groupBy(_._1).mapValues(_.size)

// reduceByKey效率高, reduceByKey是按照key把数据聚合在一起并计算出value的结果

// RDD 里没有 reduceByKey, 但是能用, 说明有隐式转换函数将 rdd增强了

val resRdd: RDD[(String, Int)] = mapRdd.reduceByKey(_ + _)

// val arr: Array[(String, Int)] = resRdd.collect()

// println(arr.toBuffer)

val outputDir:String = "/tmp/spark/output"

val outputPath:Path = new Path(outputDir)

// 主动删除输出目录

val hadoopConf: Configuration = new Configuration()

val fs: FileSystem = FileSystem.get(hadoopConf)

if(fs.exists(outputPath)){

fs.delete(outputPath, true)

println(s"delete outputpath: ${outputPath.toString}")

}

resRdd.saveAsTextFile(outputDir)

}

}第二版:

利用隐式转换函数, 给字符串赋予删除hdfs目录功能

HdfsUtil

package com.hainiu.util

import org.apache.hadoop.conf.Configuration

import org.apache.hadoop.fs.{FileSystem, Path}

class HdfsUtil(val outputDir:String) {

def deleteHdfs = {

val outputPath:Path = new Path(outputDir)

// 主动删除输出目录

val hadoopConf: Configuration = new Configuration()

val fs: FileSystem = FileSystem.get(hadoopConf)

if(fs.exists(outputPath)){

fs.delete(outputPath, true)

println(s"delete outputpath: ${outputPath.toString}")

}

}

}隐式转换

package com.hainiu.util

object MyPredef {

// 定义隐式转换函数实现 将String转HdfsUtil

implicit def string2HdfsUtil(outputDir:String) = new HdfsUtil(outputDir)

}程序

import org.apache.hadoop.conf.Configuration

import org.apache.hadoop.fs.{FileSystem, Path}

import org.apache.spark.rdd.RDD

import org.apache.spark.{SparkConf, SparkContext}

object WordCount {

def main(args: Array[String]): Unit = {

val conf: SparkConf = new SparkConf().setMaster("local[*]").setAppName("wordcount")

val sc: SparkContext = new SparkContext(conf)

val rdd: RDD[String] = sc.textFile("/tmp/spark/input1")

val mapRdd: RDD[(String, Int)] = rdd.flatMap(_.split("\t")).map((_,1))

// groupBy+mapValues 效率低, groupBy只是按照key把数据集合在一起,并不计算,拉取的数据量特别大

// val resRdd: RDD[(String, Int)] = mapRdd.groupBy(_._1).mapValues(_.size)

// reduceByKey效率高, reduceByKey是按照key把数据聚合在一起并计算出value的结果

// RDD 里没有 reduceByKey, 但是能用, 说明有隐式转换函数将 rdd增强了

val resRdd: RDD[(String, Int)] = mapRdd.reduceByKey(_ + _)

// val arr: Array[(String, Int)] = resRdd.collect()

// println(arr.toBuffer)

val outputDir:String = "/tmp/spark/output"

import com.hainiu.util.MyPredef.string2HdfsUtil

// 给字符串赋予删除hdfs的功能

outputDir.deleteHdfs

resRdd.saveAsTextFile(outputDir)

}

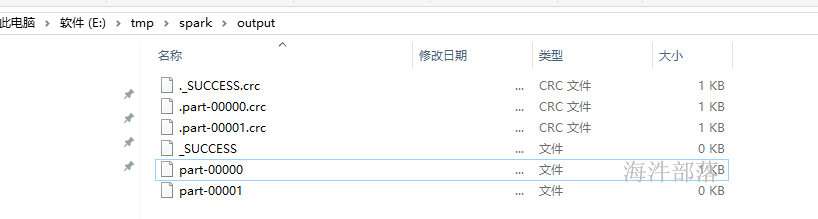

}结果:

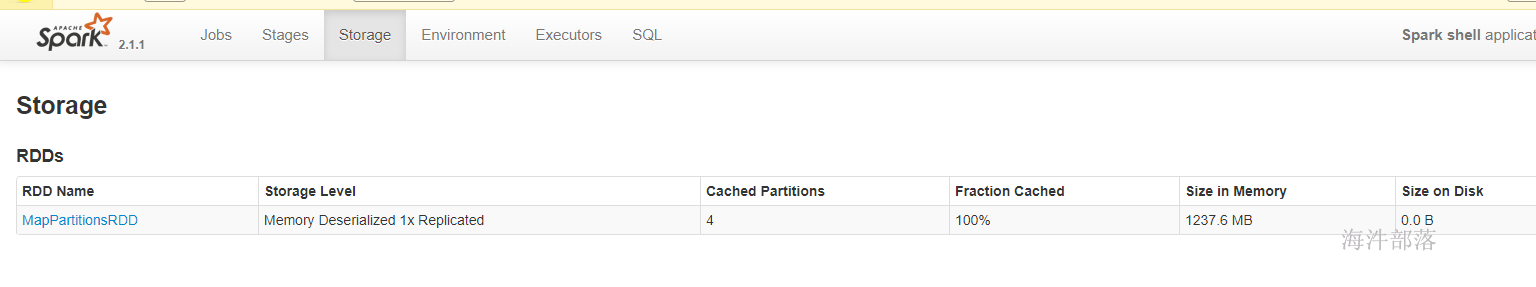

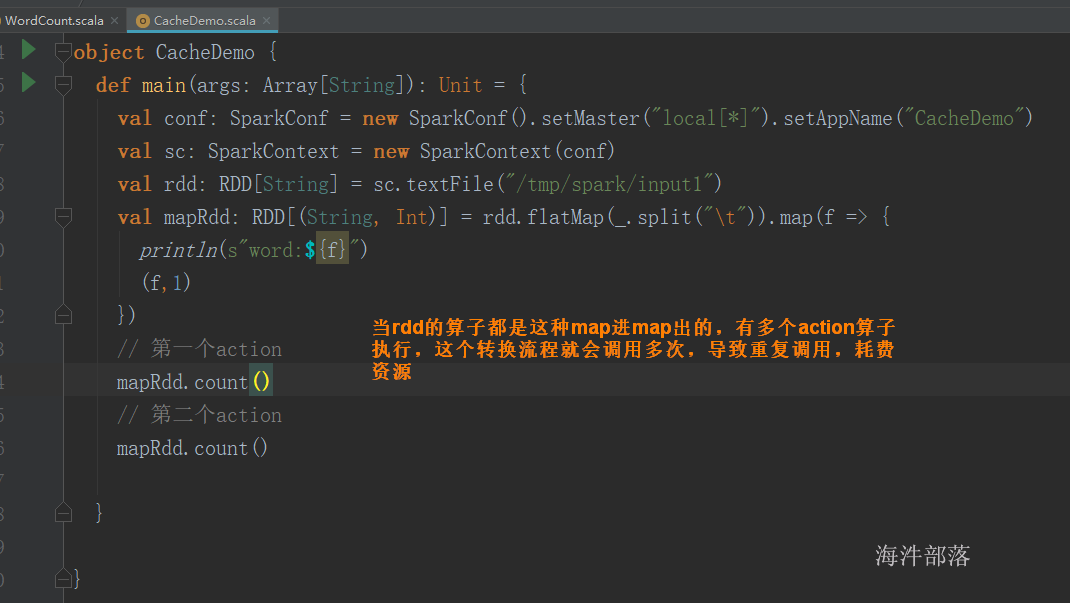

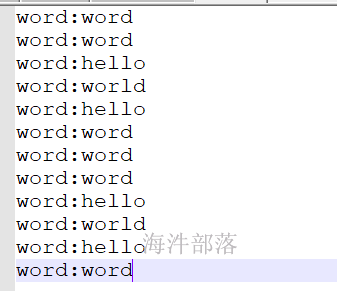

用cache优化,实现复用:

import org.apache.spark.rdd.RDD

import org.apache.spark.{SparkConf, SparkContext}

object CacheDemo {

def main(args: Array[String]): Unit = {

val conf: SparkConf = new SparkConf().setMaster("local[*]").setAppName("CacheDemo")

val sc: SparkContext = new SparkContext(conf)

val rdd: RDD[String] = sc.textFile("/tmp/spark/input1")

val mapRdd: RDD[(String, Int)] = rdd.flatMap(_.split("\t")).map(f => {

println(s"word:${f}")

(f,1)

})

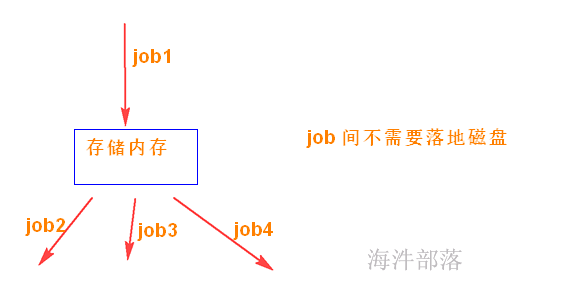

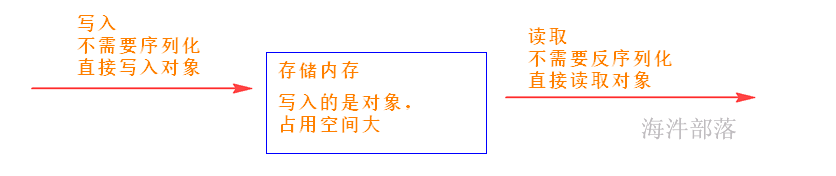

// 当执行cache时,会将mapRdd的数据缓存到存储内存,等下一个action执行时,碰到cache,

// 就不向上追溯,直接从存储内存拿取数据取运算,这样实现复用

// cache的默认缓存级别 :StorageLevel.MEMORY_ONLY

// 缓存到内存,写入存储内存的数据不需要序列化,直接把对象写入即可,使用时也许不要反序列化速度快。

val cache: RDD[(String, Int)] = mapRdd.cache()

// 第一个action

println(cache.count())

// 第二个action

println(cache.count())

}

}

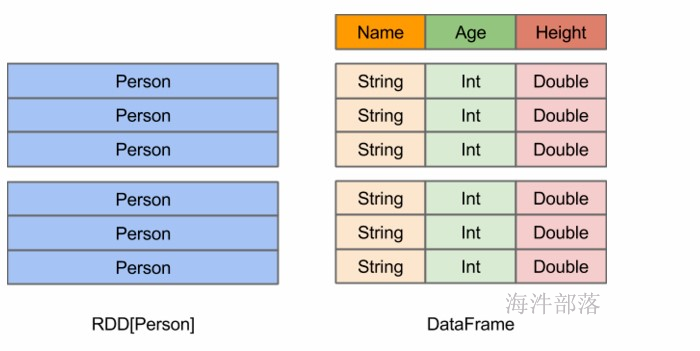

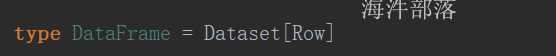

8 .RDD

8.1 RDD设计背景

在实际应用中,存在许多迭代式计算,这些应用场景的共同之处是,不同计算阶段之间会重用中间结果,即一个阶段的输出结果会作为下一个阶段的输入。但是,目前的MapReduce框架都是把中间结果写入到HDFS中,带来了大量的数据复制、磁盘IO和序列化开销。显然,如果能将结果保存在内存当中,就可以大量减少IO。RDD就是为了满足这种需求而出现的,它提供了一个抽象的数据架构,我们不必担心底层数据的分布式特性,只需将具体的应用逻辑表达为一系列转换处理,不同RDD之间的转换操作形成依赖关系,可以实现管道化,从而避免了中间结果的落地存储,大大降低了数据复制、磁盘IO和序列化开销。

8.2 RDD概念

RDD(Resilient Distributed Datasets,弹性分布式数据集)代表可并行操作元素的不可变分区集合。

一个RDD就是一个分布式对象集合,本质上是一个只读的分区记录集合,每个RDD可以分成多个分区,每个分区就是一个数据集片段(HDFS上的块),并且一个RDD的不同分区可以被保存到集群中不同的节点上,从而可以在集群中的不同节点上进行并行计算。

RDD提供了一种高度受限的共享内存模型,即RDD是只读的记录分区的集合,不能直接修改,只能基于稳定的物理存储中的数据集来创建RDD,或者通过在其他RDD上执行确定的转换操作(如map、join和groupBy)而创建得到新的RDD。

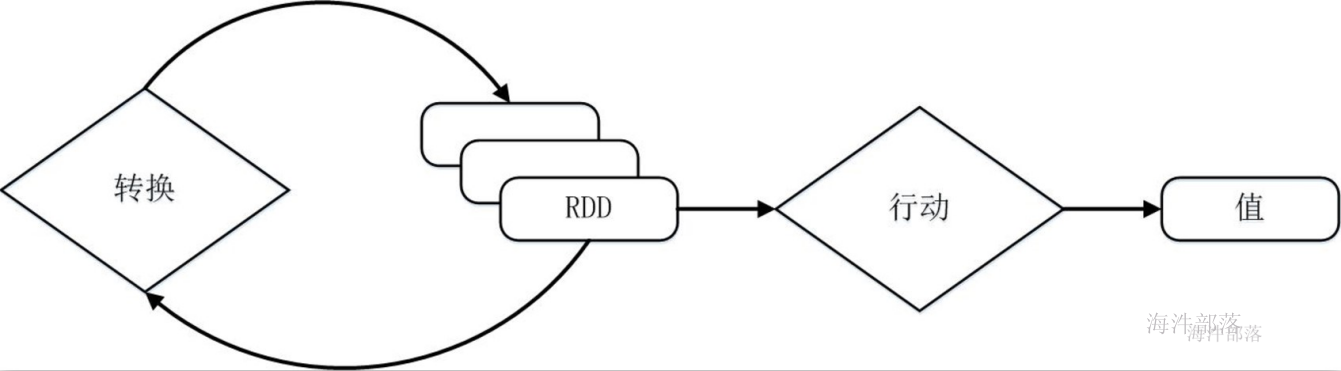

RDD提供了一组丰富的操作以支持常见的数据运算,分为“行动”(Action)和“转换”(Transformation)两种类型,前者用于执行计算并指定输出的形式,后者指定RDD之间的相互依赖关系。两类操作的主要区别是,转换操作(比如map、filter、groupBy、join等)接受RDD并返回RDD,而行动操作(比如count、collect等)接受RDD但是返回非RDD(即输出一个值或结果)。

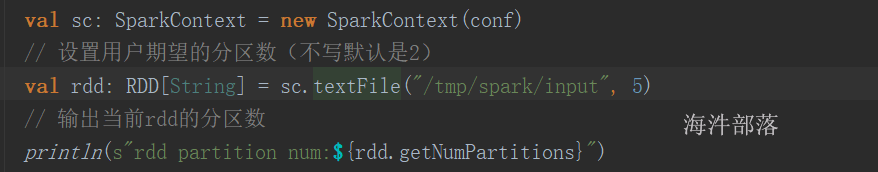

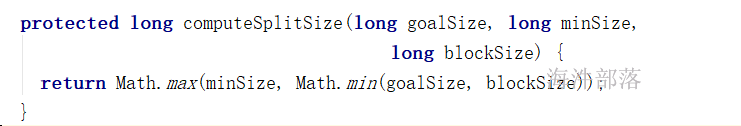

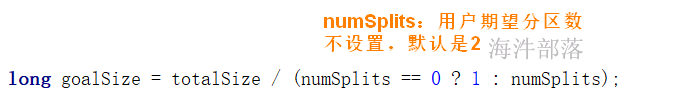

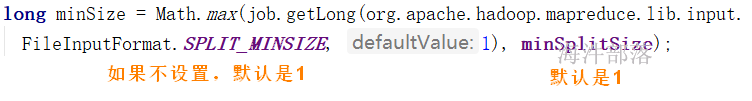

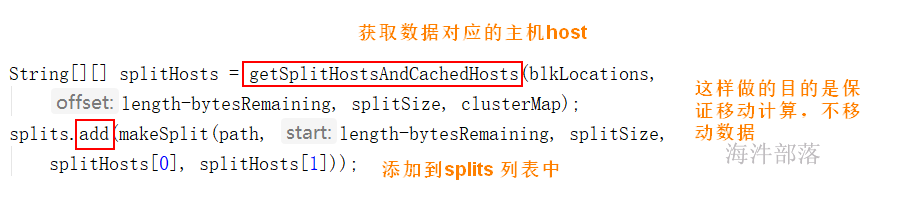

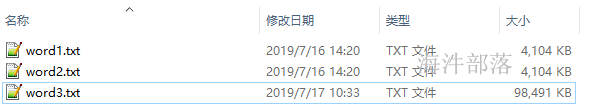

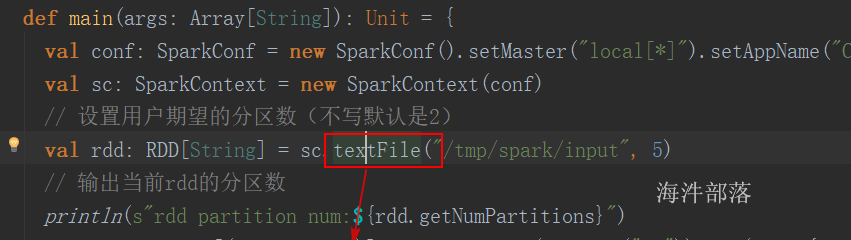

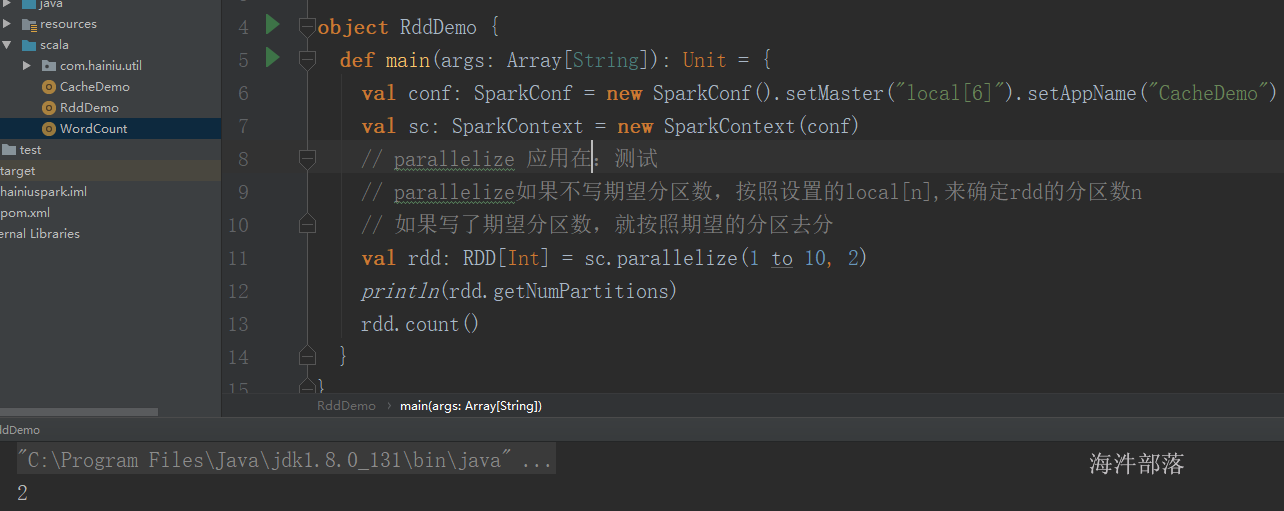

设置期望最小split分区数 和 打印实际split的分区数:

每个分片的大小计算方法如下:

goalSize:是根据用户期望的分区数算出来的,每个分区的大小,总文件大小/用户期望分区数;

minSize :InputSplit的最小值,由配置参数mapred.min.split.size(在/conf/mapred-site.xml文件中配置)确定,默认是1(字节);

blockSize :文件在HDFS中存储的block大小(在/conf/hdfs-site.xml文件中配置),不同文件可能不同,默认是64MB或者128MB。

在windows系统中,一个块是32MB。

每个分片数据的划分过程会考虑机架、host等因素。

有这么个输入数据

如果不设置期望分区数,就是默认的 2

globalSize = (4.104 + 4.104 + 98.491) / 2 = 53.3495MB

blockSize = 32MB

globalSize > blockSize , 按照blockSize来分

word1.txt ——> 1

wrod2.txt ——> 1

word3.txt ——> 3 (2块64M, 剩余的 / 32 \< 1.1,分1个块)

共分5个split。

如果设置期望分区数5

globalSize = (4.104 + 4.104 + 98.491) / 5 = 21.3398

blockSize = 32MB

globalSize \< blockSize , 按照 globalSize 来分

word1.txt ——> 1

wrod2.txt ——> 1

word3.txt ——> 5 (98.491 / 21.3398 = 4.6 —》 5)

共分7个split。

源码:

Spark用Scala语言实现了RDD的API,程序员可以通过调用API实现对RDD的各种操作。RDD典型的执行过程如下:

1)RDD读入外部数据源(或者内存中的集合)进行创建;

2)RDD经过一系列的“转换”操作,每一次都会产生不同的RDD,供给下一个“转换”使用;

3)最后一个RDD经“行动”操作进行处理,并输出到外部数据源(或者变成Scala/JAVA集合或变量)。

需要说明的是,RDD采用了惰性调用,即在RDD的执行过程中,真正的计算发生在RDD的“行动”操作,对于“行动”之前的所有“转换”操作,Spark只是记录下“转换”操作应用的一些基础数据集以及RDD生成的轨迹,即相互之间的依赖关系,而不会触发真正的计算。

java程序示例

JavaSparkContext sc = new JavaSparkContext(conf);

JavaRDD<String> lines = sc.textFile(logFile);

JavaRDD<String> filter = lines.filter(new Function<String, Boolean>() {

@Override

public Boolean call(String v1) throws Exception {

return v1.contains("helle world");

}

});

cache = filter.cache();

long count = cache.count();

System.out.println(count);scala:

val conf = new SparkConf

val sparkContext = new SparkContext(conf)

val lines :RDD = sparkContext.textFile(logFile)

//lines.filter((a:String) => a.contains("hello world"))

val count = lines.filter(_.contains("hello world")).cache().count()

println(count)可以看出,一个Spark应用程序,基本是基于RDD的一系列计算操作。

第1行代码用于创建JavaSparkContext对象;

第2行代码从HDFS文件中读取数据创建一个RDD;

第3行代码对fileRDD进行转换操作得到一个新的RDD,即filterRDD;

filter.cache() 表示对 filter 进行持久化,把它保存在内存或磁盘中(这里采用cache接口把数据集保存在内存中),方便后续重复使用,当数据被反复访问时(比如查询一些热点数据,或者运行迭代算法),这是非常有用的,而且通过cache()可以缓存非常大的数据集,支持跨越几十甚至上百个节点; count()是一个行动操作,用于计算一个RDD集合中包含的元素个数。

这个程序的执行过程如下:

1)创建这个Spark程序的执行上下文,即创建SparkContext对象;

2)从外部数据源(即HDFS文件)中读取数据创建fileRDD对象;

3)构建起fileRDD和filterRDD之间的依赖关系,形成DAG图,这时候并没有发生真正的计算,只是记录转换的轨迹;

4)执行action代码时,count()是一个行动类型的操作,触发真正的计算,开始执行从fileRDD到filterRDD的转换操作,并把结果持久化到内存中,最后计算出filterRDD中包含的元素个数。

8.3 RDD特性

总体而言,Spark采用RDD以后能够实现高效计算的主要原因如下:

1)高效的容错性(血缘关系容错)。现有的分布式共享内存、键值存储、内存数据库等,为了实现容错,必须在集群节点之间进行数据复制或者记录日志,也就是在节点之间会发生大量的数据传输,这对于数据密集型应用而言会带来很大的开销。在RDD的设计中,数据只读,不可修改,如果需要修改数据,必须从父RDD转换到子RDD,由此在不同RDD之间建立了血缘关系。所以,RDD是一种天生具有容错机制的特殊集合,不需要通过数据冗余的方式(比如详细的记录操作的日志)实现容错,而只需通过RDD父子依赖(血缘)关系重新计算得到丢失的分区来实现容错,无需回滚整个系统,这样就避免了数据复制的高开销,而且重算过程可以在不同节点之间并行进行,实现了高效的容错。此外,RDD提供的转换操作都是一些粗粒度的操作(比如map、filter和join),RDD依赖关系只需要记录这种粗粒度的转换操作,而不需要记录具体的数据和各种细粒度操作的日志(比如对哪个数据项进行了修改),这就大大降低了数据密集型应用中的容错开销;

2)中间结果持久化到内存(cache)。数据在内存中的多个RDD操作之间进行传递,不需要“落地”到磁盘上,避免了不必要的读写磁盘开销;

3)存放的数据可以是Java对象,避免了不必要的对象序列化和反序列化开销(但占用内存的空间)。

rdd 弹性体现在哪?

1)自动进行内存和磁盘换;

2)基于血缘关系的高效容错;

3)task如果失败会特定次数的重试,默认重试4次;

4)stage如果失败会自动进行特定次数的重试,默认重试4次

5)通过cache容错和通过持久化来对数据进行复用;

6)数据调度弹性,DAG划分、TASK调度和资源管理无关;

7)数据分片的高度弹性(可重新分区);

8.4 RDD之间的依赖关系

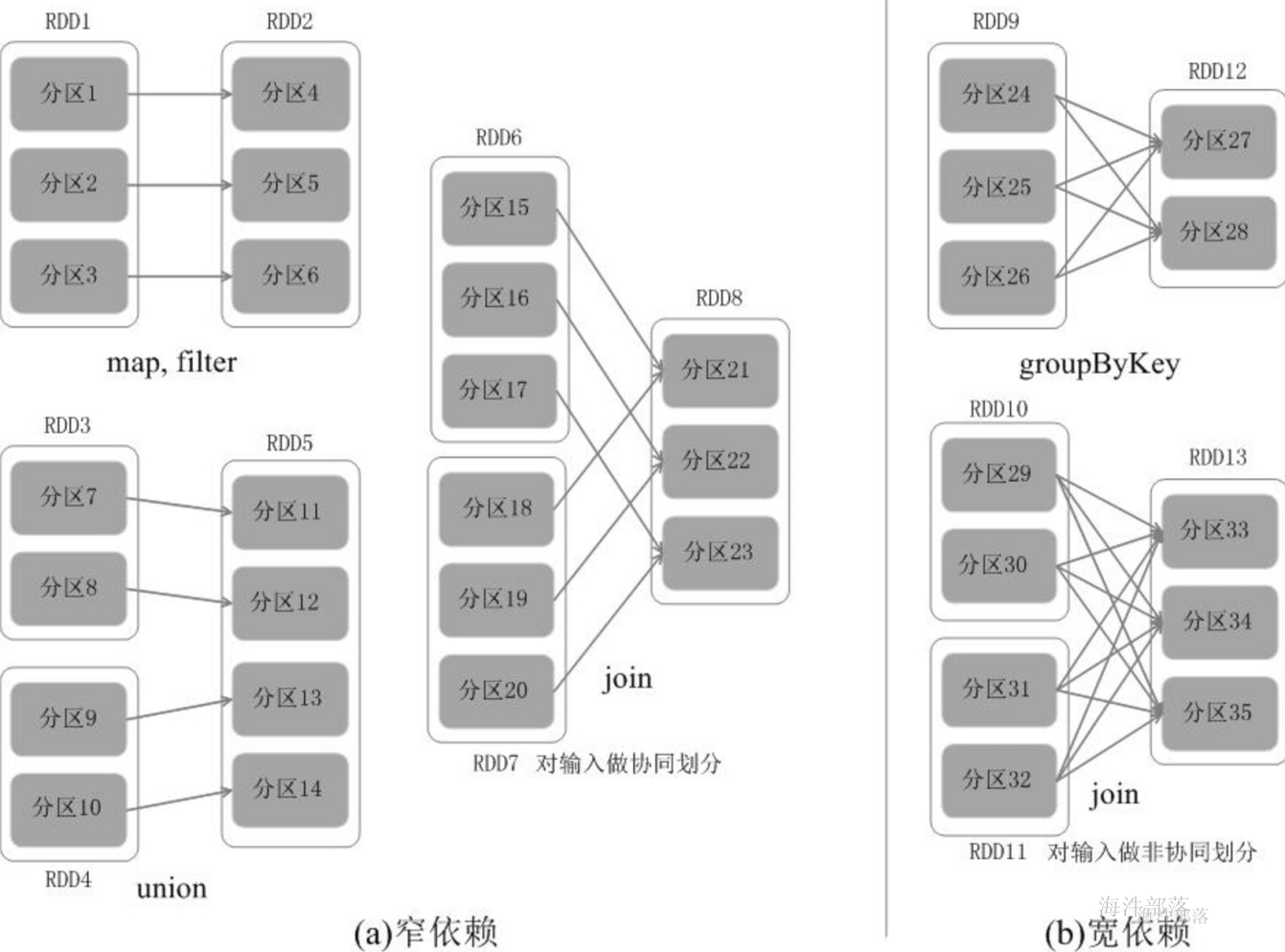

RDD中不同的操作会使得不同RDD中的分区会产生不同的依赖。RDD中的依赖关系分为窄依赖(Narrow Dependency)与宽依赖(Wide Dependency)。

宽依赖与窄依赖

窄依赖表现为一个父RDD的分区对应于一个子RDD的分区,或多个父RDD的分区对应于一个子RDD的分区;

宽依赖则表现为存在一个父RDD的一个分区对应一个子RDD的多个分区;

(1)对输入进行协同划分,属于窄依赖。所谓协同划分(co-partitioned)是指多个父RDD的某一分区的所有“键(key)”,落在子RDD的同一个分区内,不会产生同一个父RDD的某一分区,落在子RDD的两个分区的情况。

(2)对输入做非协同划分,属于宽依赖。

对于窄依赖的RDD,可以以流水线的方式计算所有父分区,不会造成网络之间的数据混合。对于宽依赖的RDD,则通常伴随着Shuffle操作,即首先需要计算好所有父分区数据,然后在节点之间进行Shuffle。

窄依赖与宽依赖的区别

Spark的这种依赖关系设计,使其具有了天生的容错性,大大加快了Spark的执行速度。因为,RDD数据集通过“血缘关系”记住了它是如何从其它RDD中演变过来的,血缘关系记录的是粗颗粒度的转换操作行为,当这个RDD的部分分区数据丢失时,它可以通过血缘关系获取足够的信息来重新运算和恢复丢失的数据分区,由此带来了性能的提升。相对而言,在两种依赖关系中,窄依赖的失败恢复更为高效,它只需要根据父RDD分区重新计算丢失的分区即可(不需要重新计算所有分区),而且可以并行地在不同节点进行重新计算。而对于宽依赖而言,单个节点失效通常意味着重新计算过程会涉及多个父RDD分区,开销较大。此外,Spark还提供了数据检查点,用于持久化中间RDD,从而使得在进行失败恢复时不需要追溯到最开始的阶段。在进行故障恢复时,Spark会对数据检查点开销和重新计算RDD分区的开销进行比较,从而自动选择最优的恢复策略。

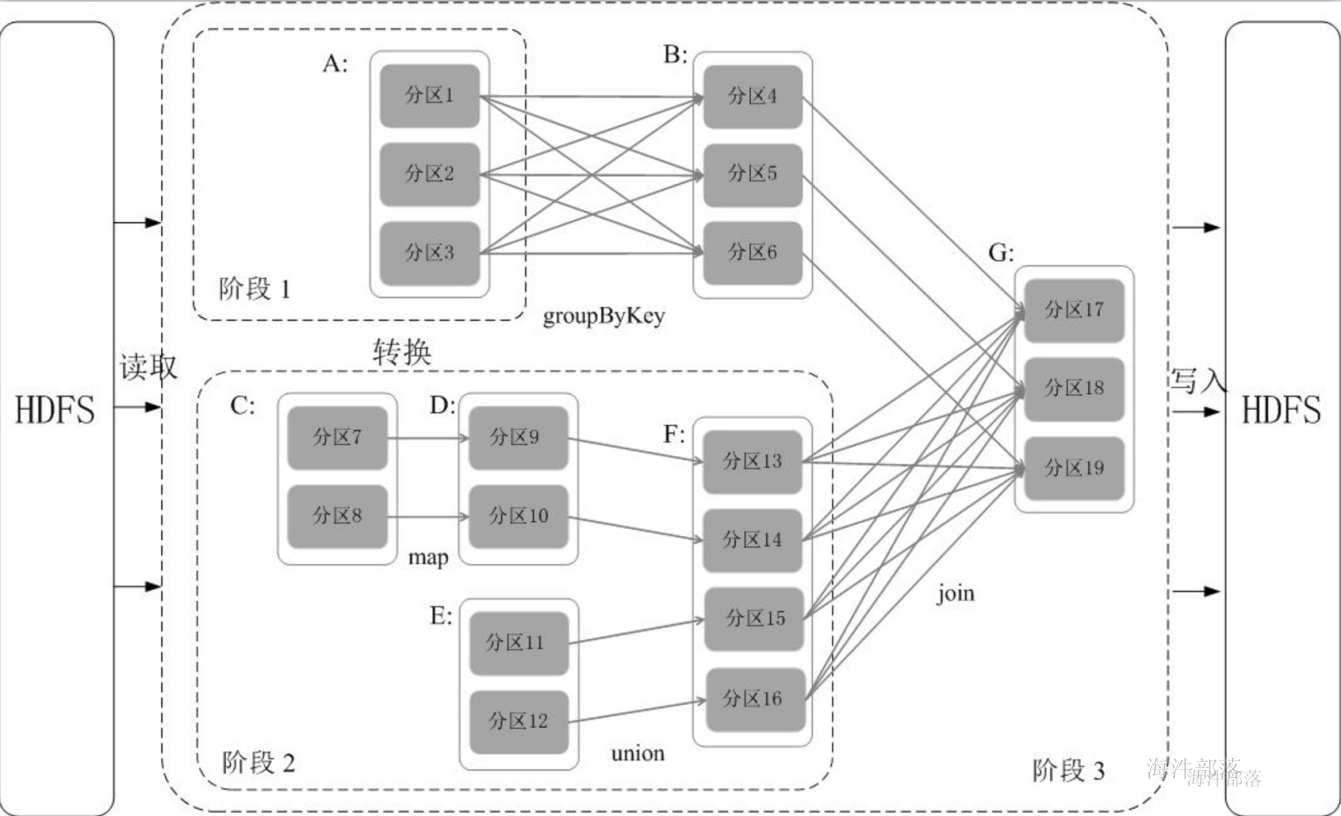

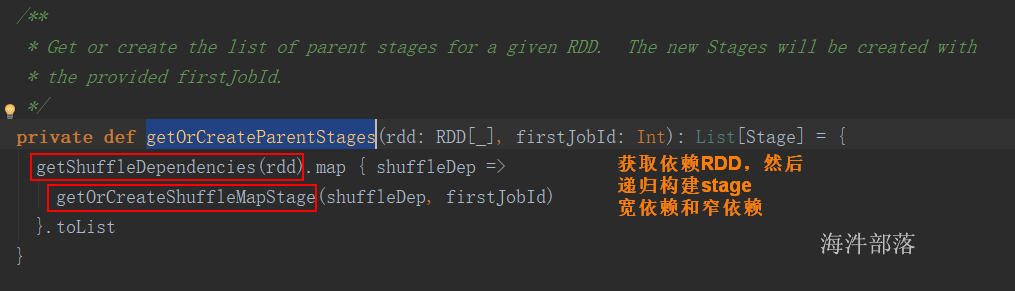

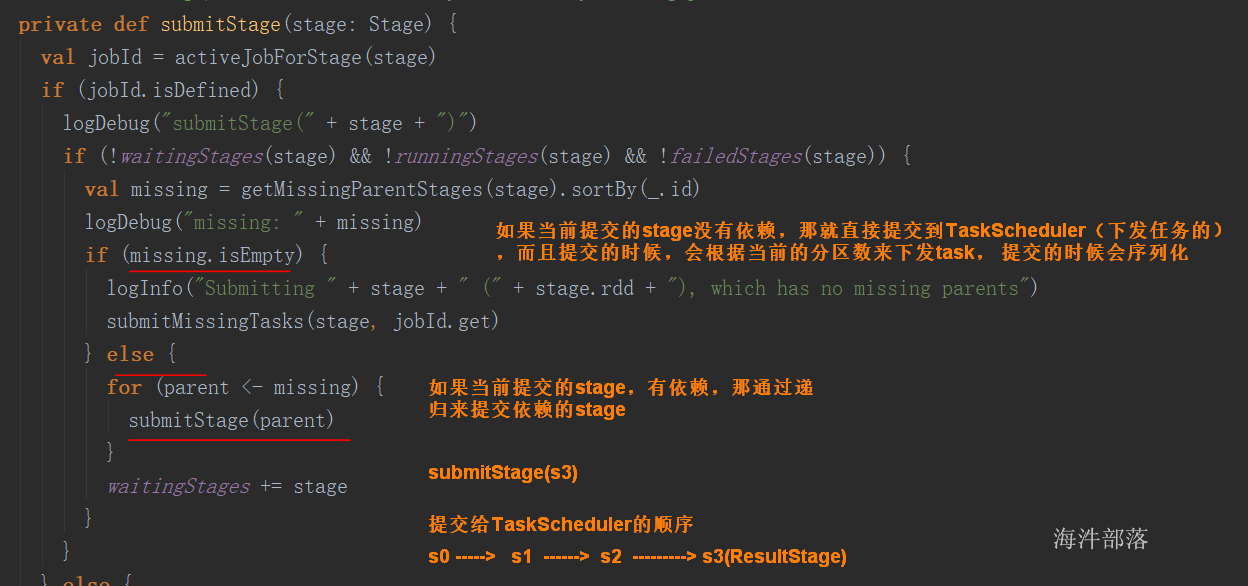

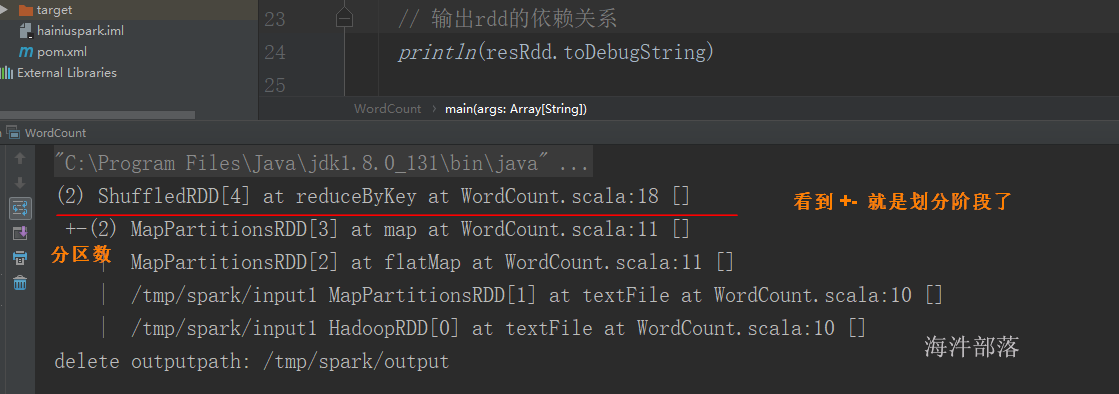

8.5 阶段的划分

Spark通过分析各个RDD的依赖关系生成了DAG,再通过分析各个RDD中的分区之间的依赖关系来决定如何划分阶段,具体划分方法是:在DAG中进行反向解析,遇到宽依赖就断开,遇到窄依赖就把当前的RDD加入到当前的阶段中;将窄依赖尽量划分在同一个阶段中,可以实现流水线计算。例如,假设从HDFS中读入数据生成3个不同的RDD(即A、C和E),通过一系列转换操作后再将计算结果保存回HDFS。对DAG进行解析时,在依赖图中进行反向解析,由于从RDD A到RDD B的转换以及从RDD B和F到RDD G的转换,都属于宽依赖,因此,在宽依赖处断开后可以得到三个阶段,即阶段1、阶段2和阶段3。可以看出,在阶段2中,从map到union都是窄依赖,这两步操作可以形成一个流水线操作,比如,分区7通过map操作生成的分区9,可以不用等待分区8到分区10这个转换操作的计算结束,而是继续进行union操作,转换得到分区13,这样流水线执行大大提高了计算的效率。

当RDD 执行action 动作时,会触发DAG划分阶段。

调用栈如下:

rdd.count

SparkContext.runJob

DAGScheduler.runJob

DAGScheduler.submitJob (向事件监听器提交任务)

DAGSchedulerEventProcessLoop.doOnReceive (监听器接收到任务,执行doOnReceive)

DAGScheduler.handleJobSubmitted

DAGScheduler.createResultStage

DAGScheduler.getOrCreateParentStages (递归构建stage)

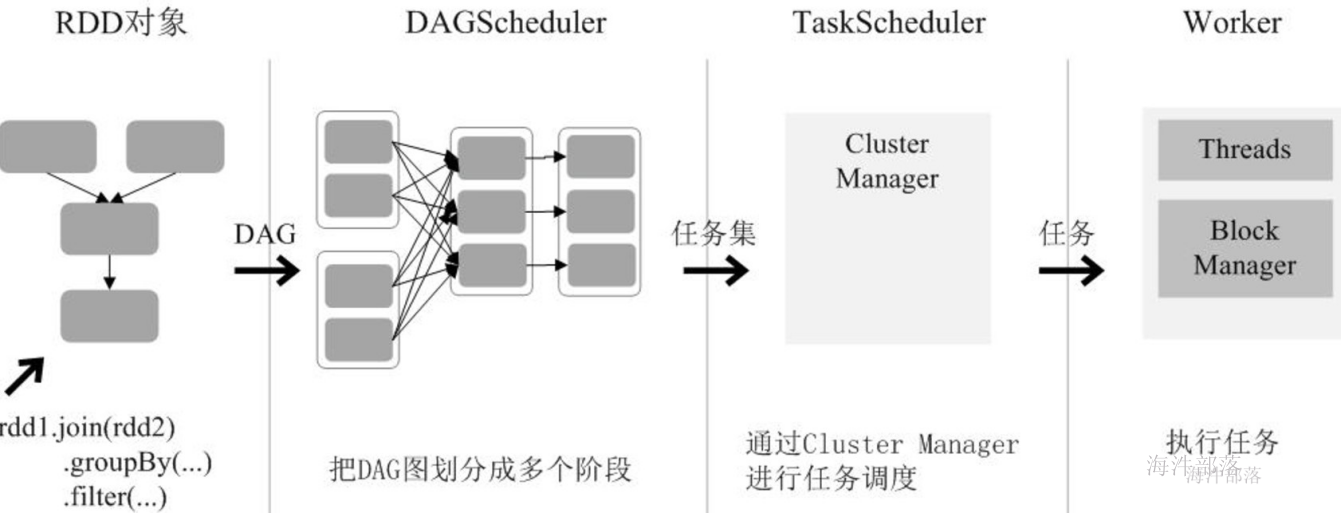

通过上述对RDD概念、依赖关系和阶段划分的介绍,结合之前介绍的Spark运行基本流程,这里再总结一下RDD在Spark架构中的运行过程:

(1)创建RDD对象;

(2)SparkContext负责计算RDD之间的依赖关系,构建DAG;

(3)DAGScheduler负责把DAG图分解成多个阶段,每个阶段中包含了多个算子,每个算子包含多个task,每个task会被任务调度器分发给各个工作节点(Worker Node)上的Executor去执行。

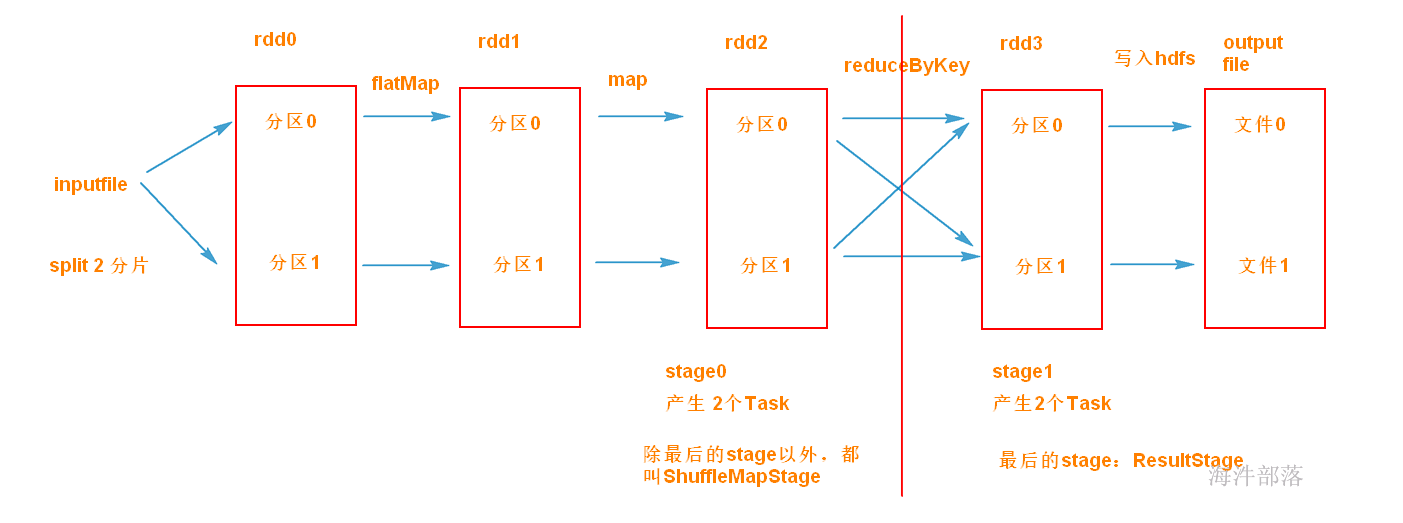

调度阶段(Stage):每个作业会因为RDD之间的依赖关系拆分成多组任务集合,称为调度阶段,也叫任务集(TaskSet)。调度阶段的划分是由DAGScheduler来划分的,调度阶段有ShuffleMapStage 和 ResultStage(最终Stage) 两种。

任务(Task):分发到Executor 上的工作任务,是 Spark 实际执行应用的最小单元。

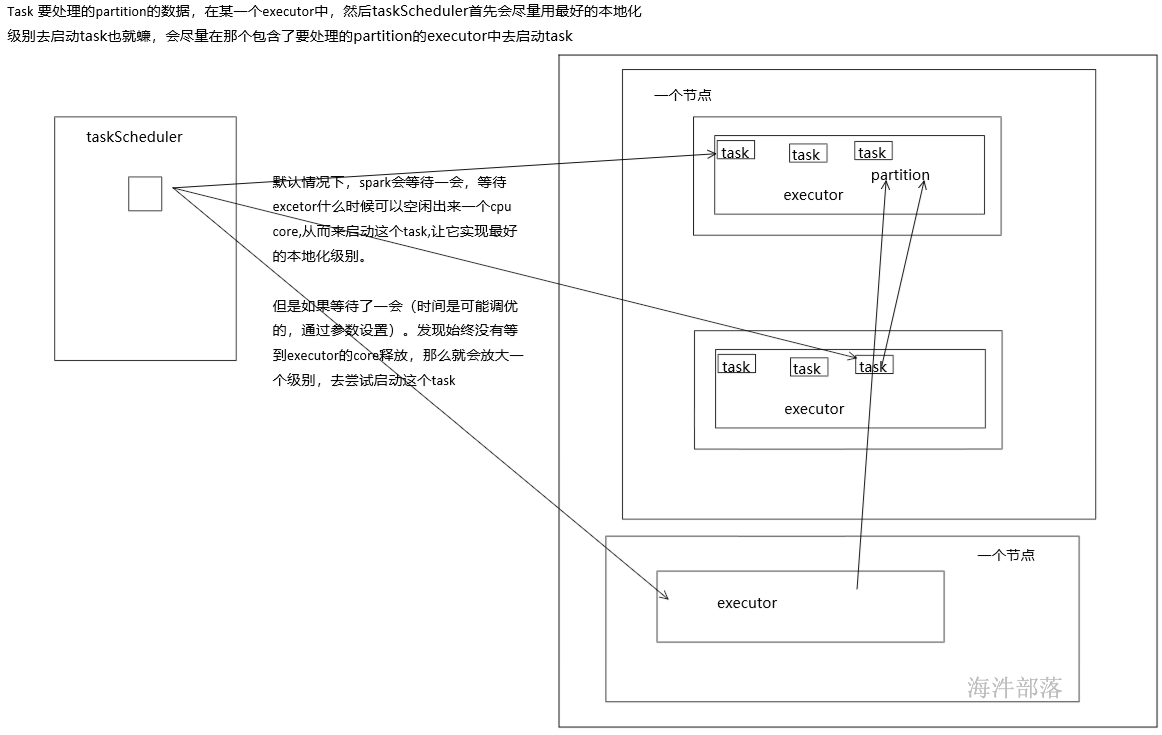

DAGScheduler:是调度阶段的任务调度器,负责接收Spark应用提交的作业,根据RDD的依赖关系划分阶段,并提交给TaskScheduler。

TaskScheduler:它接受DAGScheduler提交过来的Stage,然后把任务分发到指定的Worker节点的Executor来运行该任务。

2)初始化TaskScheduler时,会向master申请资源;

3)master用资源在worker端开启executor;

4)executor 与 TaskScheduler通信;于此同时DAGscheduler划分DAG,提交给TaskScheduler;

5)TaskScheduler接收到提交的任务,下发并管理任务;

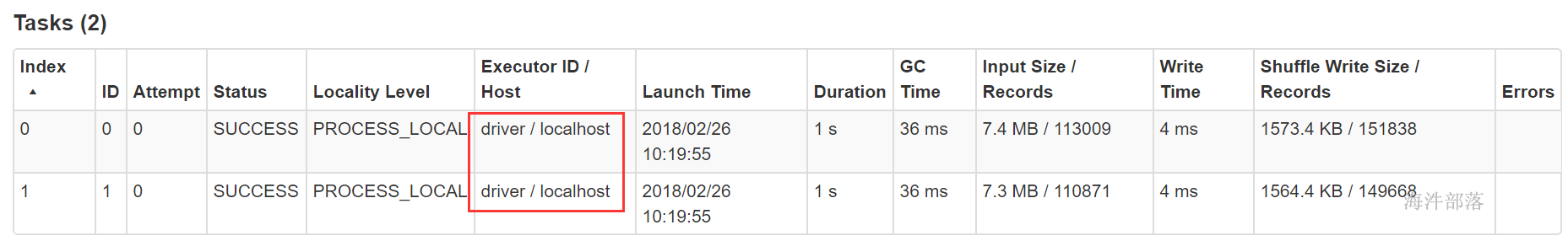

Task被执行的并发度 = Executor数目 * 每个Executor核数(=core总个数)

就是一次能同时执行多少个task。

官方给的建议:1个CPU核数对应2–3个task。

当 executor数=2, 每个executor核数=1, task被执行的并行度= 2 * 1 = 2, 8个task就需要迭代4次。

当 executor数=2, 每个executor核数=2, task被执行的并行度= 2 * 2 = 4, 8个task就需要迭代2次。

因为一个job会划分很多个阶段,所以没必要把所有阶段的task都占有一个CPU核,这样会极大的浪费资源。

分配资源时,尽量task数能整除开 task被执行的并行度,这样不会有CPU核空转。

比如 6 executor数=2, 每个executor核数=3, task被执行的并行度= 2 * 3 = 6, 那执行一次后,就有4个核空转,浪费资源。

回顾spark-shell中执行的spark任务。会更能体会数据分片、阶段划分。

9 RDD编程

开启spark-shell

本地模式:spark-shell

集群模式:spark-shell –master spark://nn1.hadoop:7077, nn2.hadoop:7077 –executor-memory 1G –total-executor-cores 2

9.1 RDD创建

1)textFile():从文件系统加载数据创建RDD

val conf = new SparkConf().setAppName("rddtest").setMaster("lcoal")

val sc: SparkContext = new SparkContext(conf)

val data: RDD[String] = sc.textFile("E:\\tmp\\spark\\input\\f1.txt")2)parallelize():集合并行化,从一个已经存在的集合上创建RDD

val arr = Array(1,2,3,4,5)

val data: RDD[Int] = sc.parallelize(arr)

println(data.count()) // 统计RDD元素个数

9.2 RDD操作

RDD操作包括两种类型,即转换(Transformation)操作和行动(Action)操作。

9.2.1 转换操作

对于RDD而言,每一次转换操作都会产生不同的RDD,供给下一个操作使用。RDD的转换过程是惰性求值的,也就是说,整个转换过程只是记录了转换的轨迹,并不会发生真正的计算,值遇到行动操作时,才会触发“从头到尾”的真正的计算。

9.2.1.1 常用转换操作

| 函数 | 说明 | 示例 |

|---|---|---|

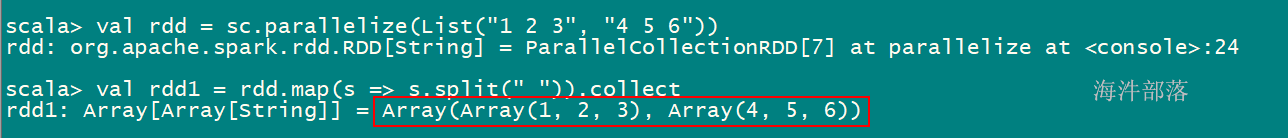

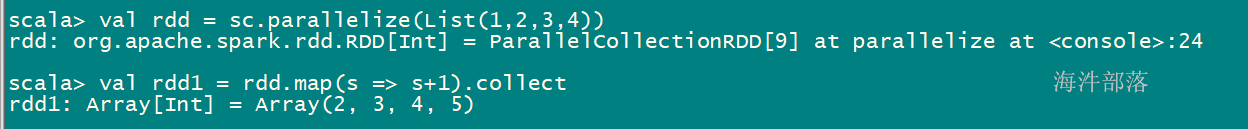

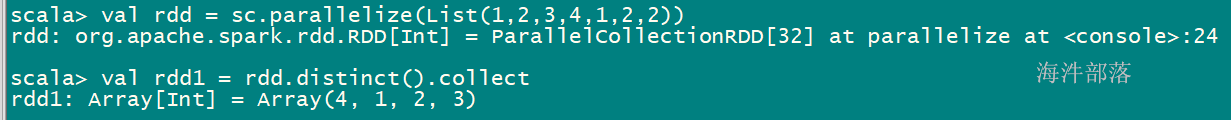

| map(func) | 将函数应用于RDD中的每个元素,将返回值构成新的RDD | 假设RDD的元素是{“1 2 3”,“4 5 6”} val rdd1 = rdd.map(s => s.split("“)) rdd1的元素是 {Array(”1“,”2“,”3“),Array(”4“,”5“,”6")} |

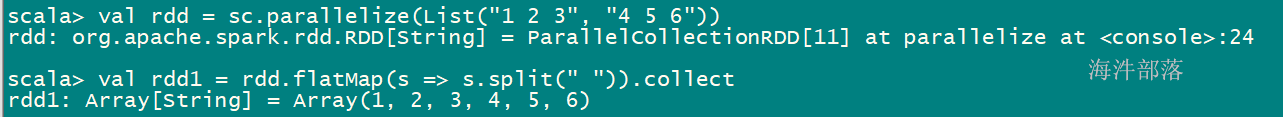

| flatMap(func) | 将函数应用于RDD中的每个元素,将返回的迭代器的所有内容构成新的RDD 执行过程:map—> flat(拍扁) | 假设RDD的元素是{“1 2 3”,“4 5 6”} val rdd1 = rdd.flatMap(s => s.split("“)) rdd1的元素是 {”1“,”2“,”3“,”4“,”5“,”6"} |

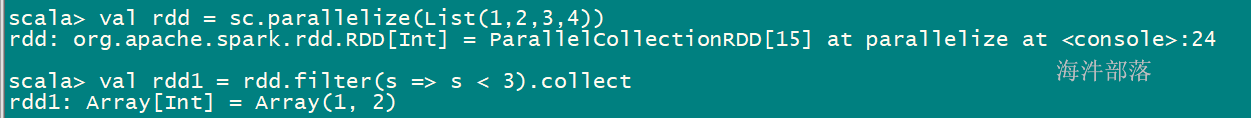

| filter(func) | 返回一个由通过func函数测试(返回true)的元素组成的RDD | 假设RDD的元素是 {1,2,3,4} val rdd1 = rdd.filter(s => s\<3) rdd1的元素是 {1,2} |

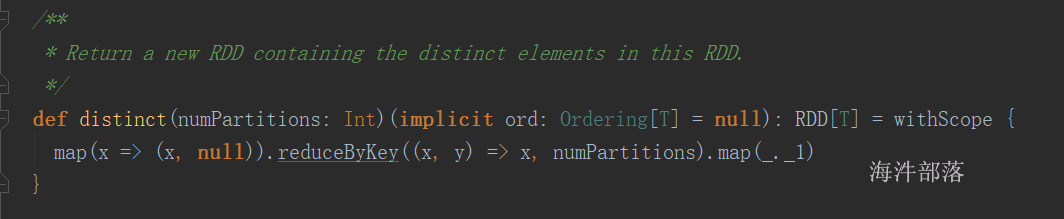

| distinct() | 排重 | |

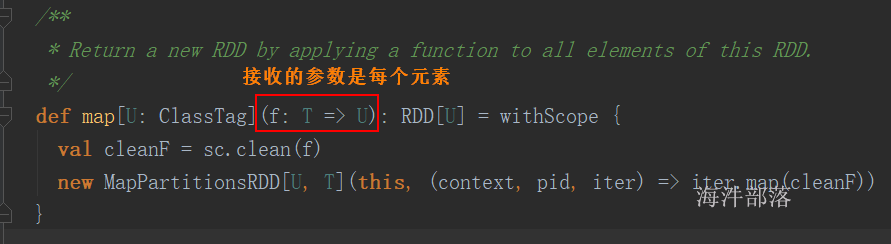

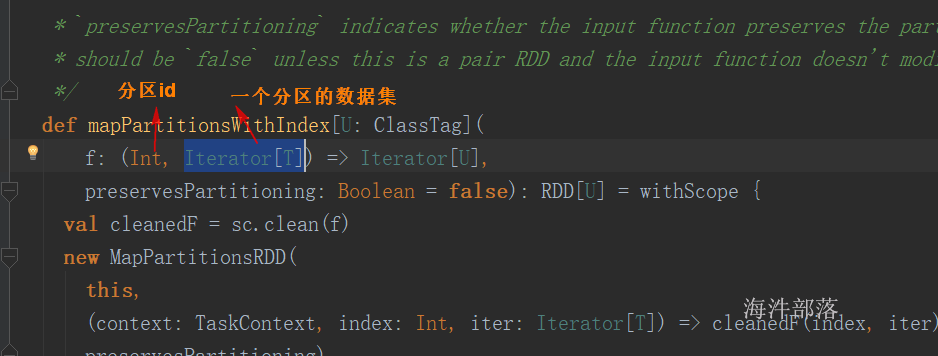

| mapPartitions() | 先partition,再把每个partition进行map函数 | |

| mapPartitionsWithIndex() | 先partition,再把每个partition进行map函数,并传入partitionid |

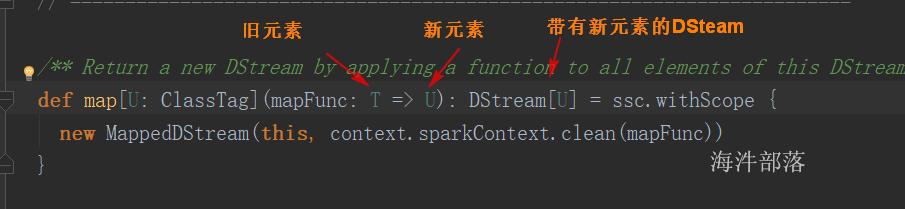

map(func)

val rdd = sc.parallelize(List(“1 2 3”, “4 5 6”))

val rdd1 = rdd.map(s => s.split(" ")).collect

val rdd1 = rdd.map(s => s+1).collect

val rdd = sc.parallelize(List(“1 2 3”, “4 5 6”))

val rdd1 = rdd.flatMap(s => s.split(" ")).collect

val rdd = sc.parallelize(List(1,2,3,4))

val rdd1 = rdd.filter(s => s \< 3).collect

val rdd = sc.parallelize(List(1,2,3,4,1,2,2))

val rdd1 = rdd.distinct().collect

map

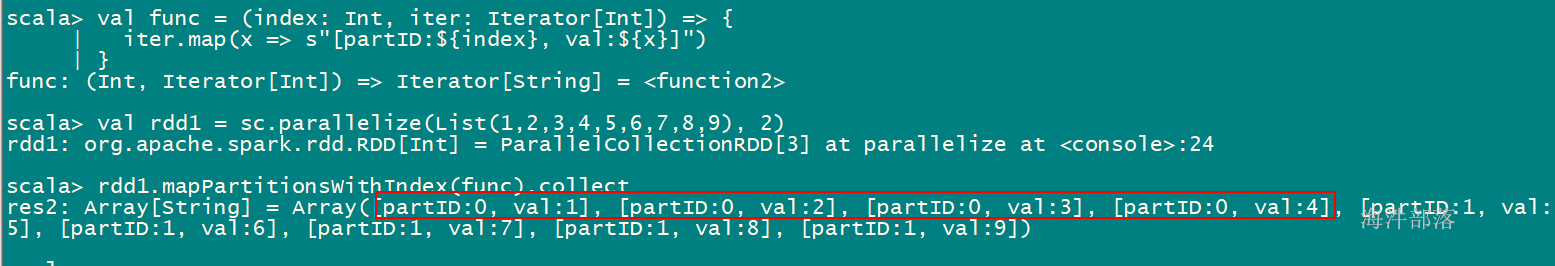

mapPartitionsWithIndex

先partition,再把每个partition进行map函数,并传入partitionid

import org.apache.spark.rdd.RDD

import org.apache.spark.{SparkConf, SparkContext}

object RddDemo2 {

def main(args: Array[String]): Unit = {

val conf: SparkConf = new SparkConf().setMaster("local[6]").setAppName("CacheDemo")

val sc: SparkContext = new SparkContext(conf)

val rdd: RDD[Int] = sc.parallelize(1 to 4, 2)

// 对rdd的每个元素进行转换

// val rdd2: RDD[Int] = rdd.map(f => {

// println(s"f:${f}")

// f + 1

// })

// val arr: Array[Int] = rdd2.collect()

// println(arr.toBuffer)

// 先按照分区得到每个分区的数据集合(it)

// 然后通过转换得到新的数据集合(it2)

// index: 代表当前分区id

val rdd2: RDD[Int] = rdd.mapPartitionsWithIndex((index, it) => {

val list: List[Int] = it.toList

println(s"index:${index}, it:${list}")

val list2: List[Int] = list.map(_ + 1)

list2.iterator

})

val arr: Array[Int] = rdd2.collect()

println(arr.toBuffer)

}

}应用场景:

1)mapPartitionsWithIndex:比如当需要一个分区创建一个连接,写入一个分区的数据时,可以使用,这样可以减少创建不必要的连接对象。

import org.apache.spark.rdd.RDD

import org.apache.spark.{SparkConf, SparkContext}

object RddDemo2 {

def main(args: Array[String]): Unit = {

val conf: SparkConf = new SparkConf().setMaster("local[6]").setAppName("CacheDemo")

val sc: SparkContext = new SparkContext(conf)

val rdd: RDD[Int] = sc.parallelize(1 to 10, 2)

// 一个元素创建一个连接,写入元素,效率低

// rdd.map(f =>{

// println(s"创建连接, 写入:${f}")

//

// }).count()

// 一个分区创建一个连接,写入一个分区的元素,效率高

rdd.mapPartitionsWithIndex((index, it) =>{

println(s"创建连接:${index}")

val list: List[Int] = it.toList

for(i <- list){

println(s"连接${index}, 写入:${i}")

}

println(s"关闭连接${index}")

list.iterator

}).count()

}

}9.2.1.2 键值对RDD操作

键值对RDD(pair RDD)是指每个RDD元素都是(key, value)键值对类型;

| 函数 | 目的 |

|---|---|

| reduceByKey(func) | 合并具有相同键的值,RDD[(K,V)] => RDD[(K,V)]按照key进行分组,并通过func 进行合并计算 |

| groupByKey() | 对具有相同键的值进行分组,RDD[(K,V)] => RDD[(K, Iterable)]只按照key进行分组,不对value合并计算 |

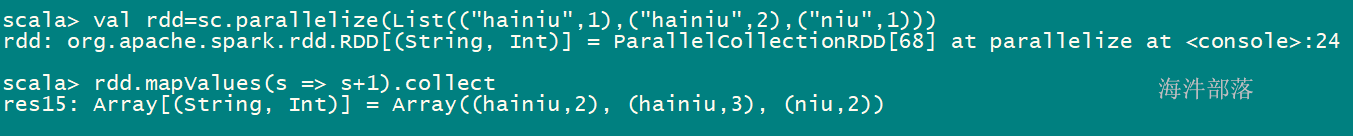

| mapValues(func) | 对 PairRDD中的每个值应用一个函数,但不改变键不会对值进行合并计算 |

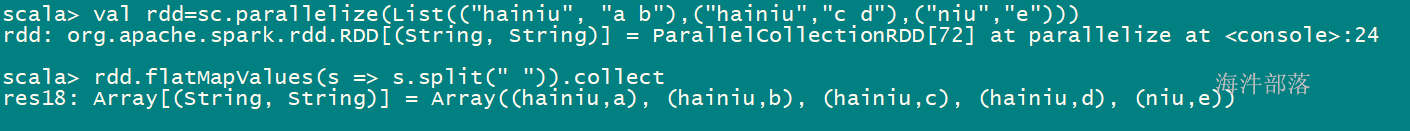

| flatMapValues(func) | 对PairRDD 中的每个值应用一个返回迭代器的函数,然后对返回的每个元素都生成一个对应原键的键值对记录 |

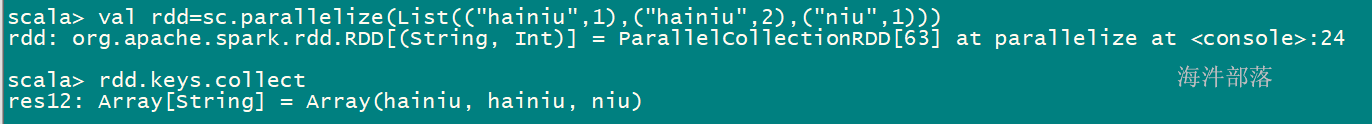

| keys() | 返回一个仅包含键的 RDD,RDD[(K,V)] => RDD[K]返回键不去重 |

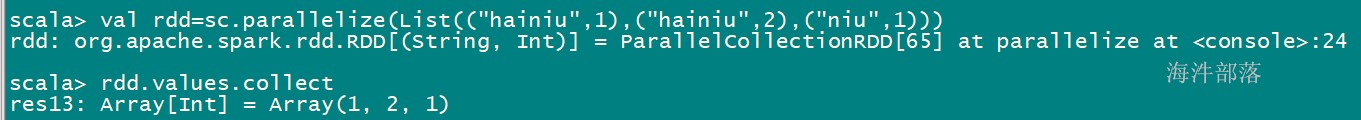

| values() | 返回一个仅包含值的 RDD,RDD[(K,V)] => RDD[V] |

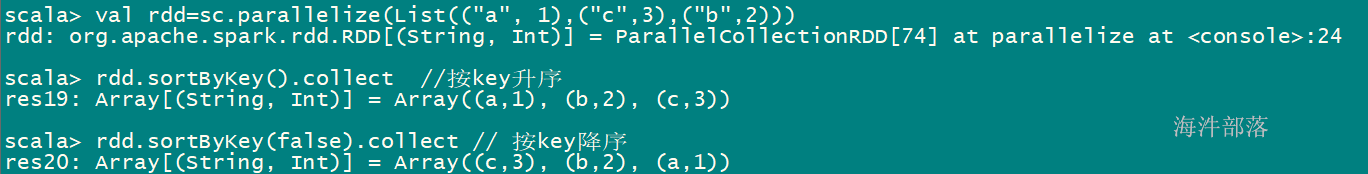

| sortByKey() | 返回一个根据键排序的 RDD,默认是升序false:降序 |

| Intersection union subtract | |

| subtractByKey(other) | 删掉RDD中键与other RDD中的键相同的元素 |

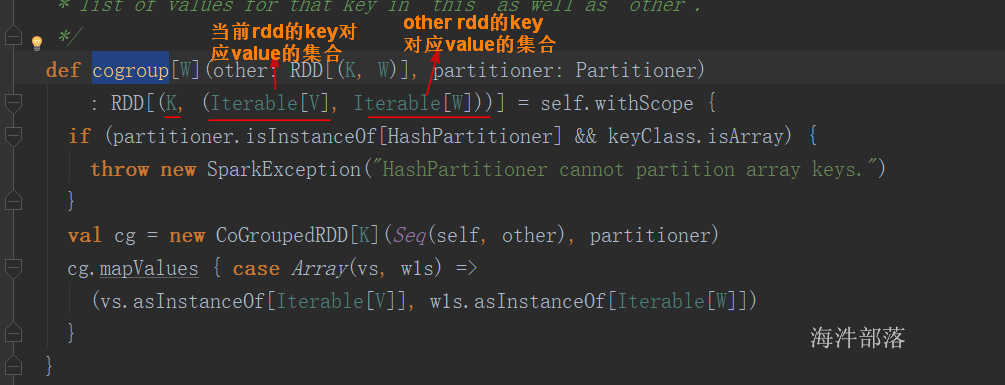

| cogroup | 将两个RDD中拥有相同键的数据分组到一起,RDD[(K,V)],RDD[(K, W)] => RDD[(K, (Iterable,Iterable))] |

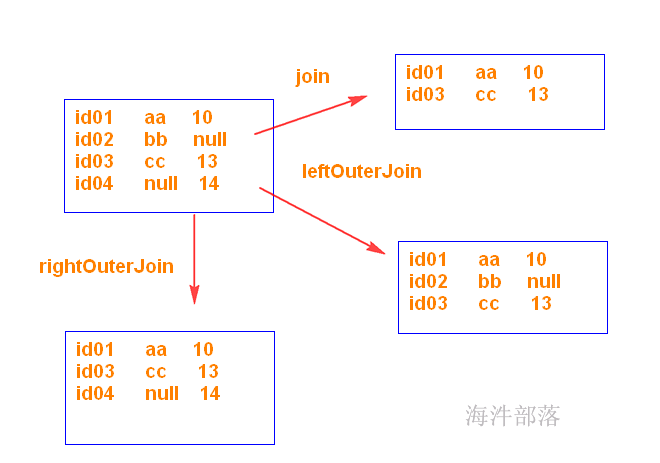

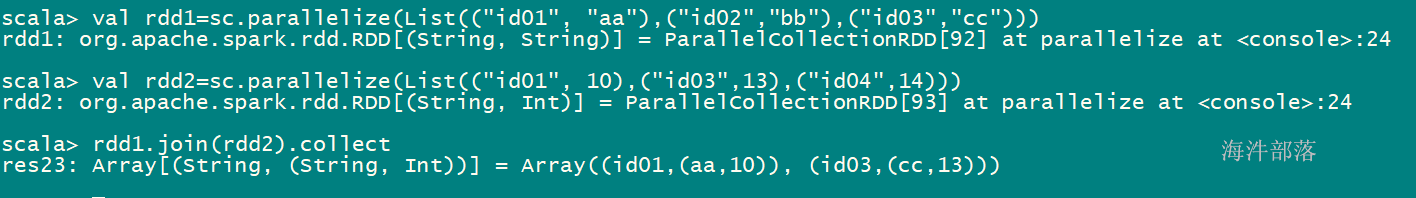

| join(other) | 对两个RDD进行内连接,RDD[(K,V)],RDD[(K, W)] => RDD[(K, (V, W))]相当于MySQL 的 innerjoin |

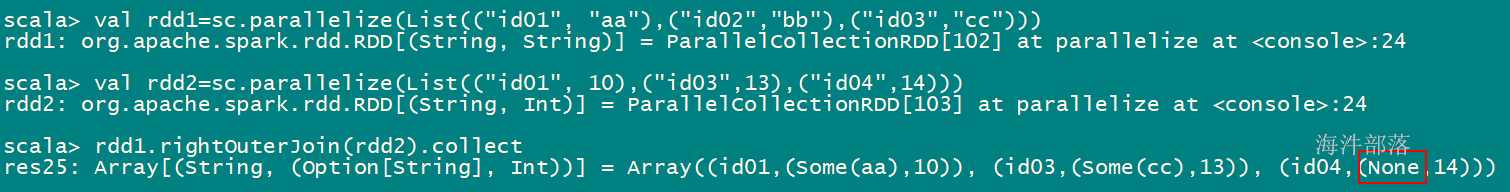

| rightOuterJoin | 对两个RDD进行右连接,RDD[(K,V)],RDD[(K, W)] => RDD[(K, (Option[V], W))]相当于MySQL 的 rightjoin |

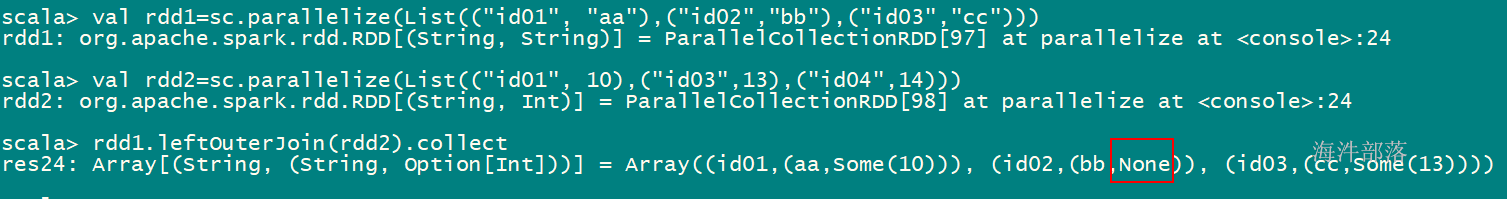

| leftOuterJoin | 对两个RDD进行左连接,RDD[(K,V)],RDD[(K, W)] => RDD[(K, (V, Option[W]))]相当于MySQL 的 leftjoin |

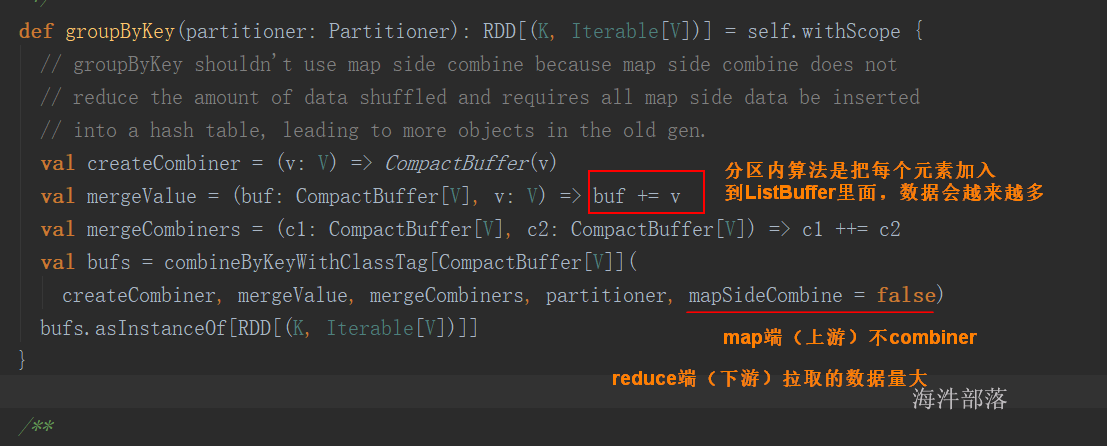

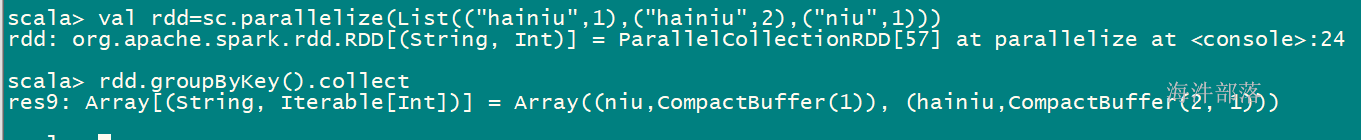

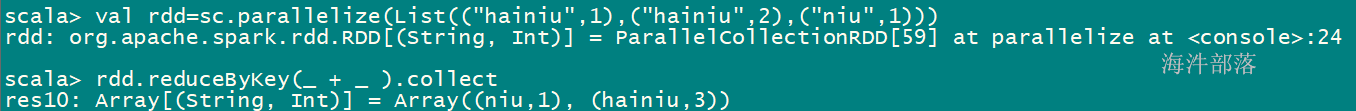

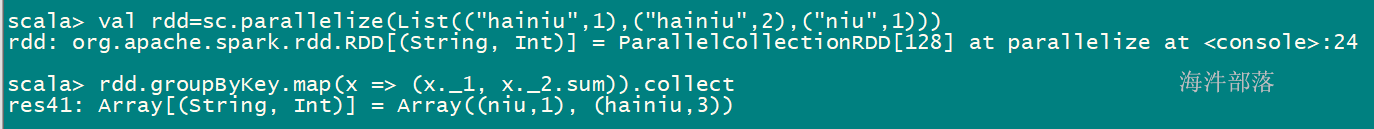

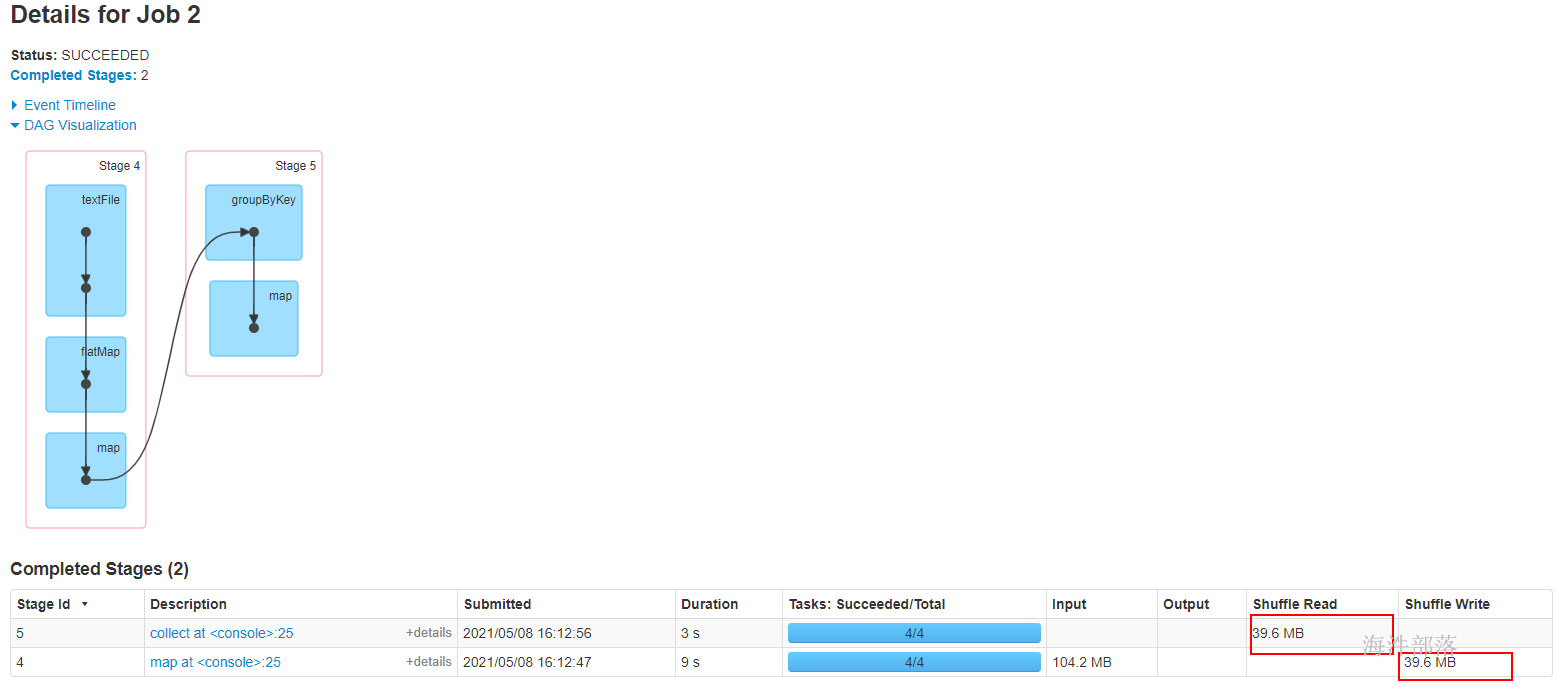

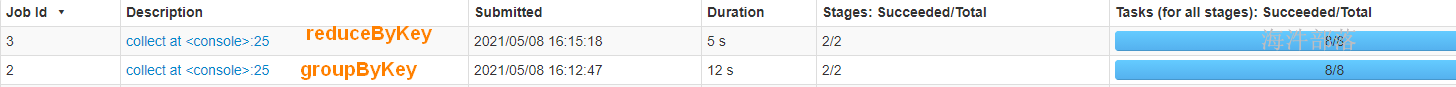

groupByKey() vs reduceByKey()

公共调用的底层方法

groupByKey()

val rdd=sc.parallelize(List((“hainiu”,1),(“hainiu”,2),(“niu”,1)))

rdd.groupByKey().collect

reduceByKey(func)

val rdd=sc.parallelize(List((“hainiu”,1),(“hainiu”,2),(“niu”,1)))

rdd.reduceByKey(_ + _ ).collect // _ + _ 等价于 (a,b) => a+b

val rdd=sc.parallelize(List((“hainiu”,1),(“hainiu”,2),(“niu”,1)))

rdd.groupByKey.map(x => (x._1, x._2.sum)).collect

sc.textFile(“hdfs://ns1/user/panniu/spark/input”).flatMap(.split(")).map((,1)).groupByKey.map(kv=>(kv._1,kv._2.sum)).collect

val rdd=sc.parallelize(List((“hainiu”,1),(“hainiu”,2),(“niu”,1)))

rdd.keys.collect

val rdd=sc.parallelize(List((“hainiu”,1),(“hainiu”,2),(“niu”,1)))

rdd.values.collect

val rdd=sc.parallelize(List((“hainiu”,1),(“hainiu”,2),(“niu”,1)))

rdd.mapValues(s => s +1).collect

val rdd=sc.parallelize(List((“hainiu”, “a b”),(“hainiu”,“c d”),(“niu”,“e”)))

rdd.flatMapValues(s => s.split(" ")).collect

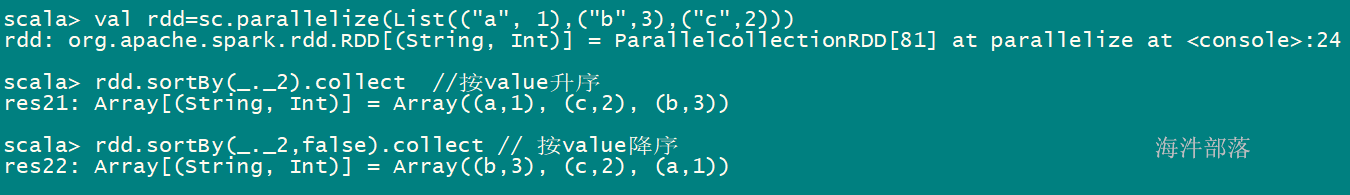

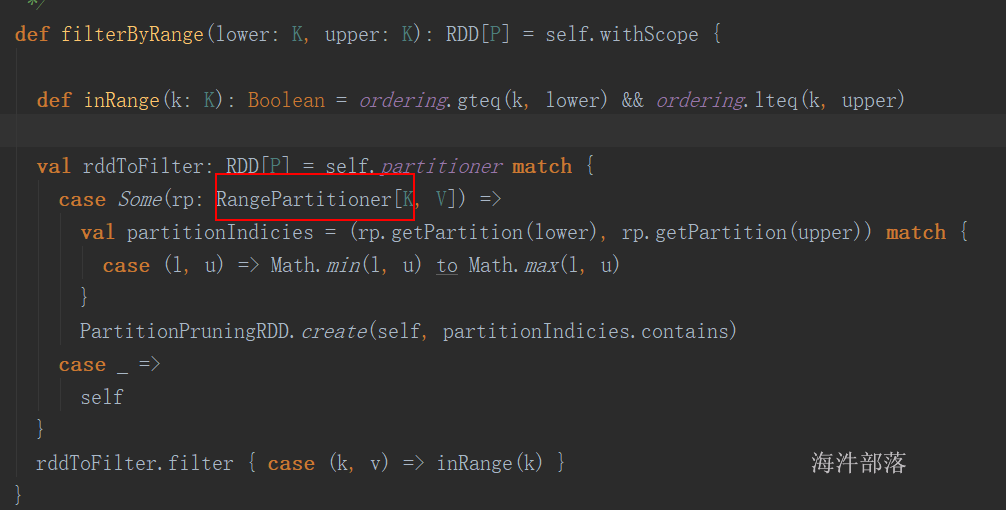

sortByKey()

val rdd=sc.parallelize(List((“a”, 1),(“c”,3),(“b”,2)))

rdd.sortByKey().collect //按key升序

rdd.sortByKey(false).collect // 按key降序

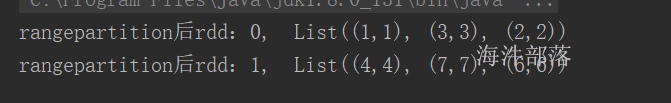

根据抽样水塘算法,可以将大的数据集,按照要分区的数量,将数据分到对应的分区里。分区间的数据是有序的,分区内是无序的。

val conf: SparkConf = new SparkConf().setMaster("local[5]").setAppName("SparkDemo2")

val sc = new SparkContext(conf)

val rdd: RDD[(Int,Int)] = sc.parallelize(List((1,1),(4,4),(3,3),(7,7),(6,6),(2,2)),2)

// 通过RangePartitioner实现,分区间有序,分区内无序

val partitioner = new RangePartitioner(2,rdd)

val rdd2: RDD[(Int, Int)] = rdd.partitionBy(partitioner)

rdd2.mapPartitionsWithIndex((index,it) =>{

println(s"rangepartition后rdd:${index}, ${it.toList}")

it

}).count()

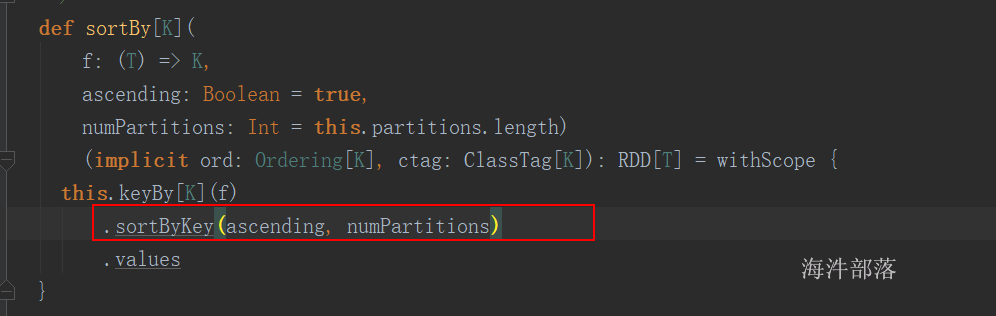

sortBy()

val rdd=sc.parallelize(List((“a”, 1),(“b”,3),(“c”,2)))

rdd.sortBy(_._2).collect //按value升序

rdd.sortBy(_._2,false).collect // 按value降序

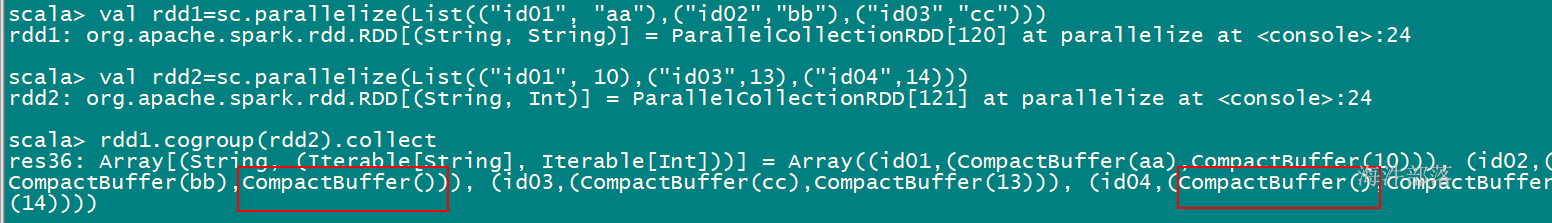

cogroup()

val rdd1=sc.parallelize(List((“id01”, “aa”),(“id02”,“bb”),(“id03”,“cc”)))

val rdd2=sc.parallelize(List((“id01”, 10),(“id03”,13),(“id04”,14)))

rdd1.cogroup(rdd2).collect

join()——innerjoin

val rdd1=sc.parallelize(List((“id01”, “aa”),(“id02”,“bb”),(“id03”,“cc”)))

val rdd2=sc.parallelize(List((“id01”, 10),(“id03”,13),(“id04”,14)))

rdd1.join(rdd2).collect

val rdd1=sc.parallelize(List((“id01”, “aa”),(“id02”,“bb”),(“id03”,“cc”)))

val rdd2=sc.parallelize(List((“id01”, 10),(“id03”,13),(“id04”,14)))

rdd1.leftOuterJoin(rdd2).collect

val rdd1=sc.parallelize(List((“id01”, “aa”),(“id02”,“bb”),(“id03”,“cc”)))

val rdd2=sc.parallelize(List((“id01”, 10),(“id03”,13),(“id04”,14)))

rdd1.rightOuterJoin(rdd2).collect

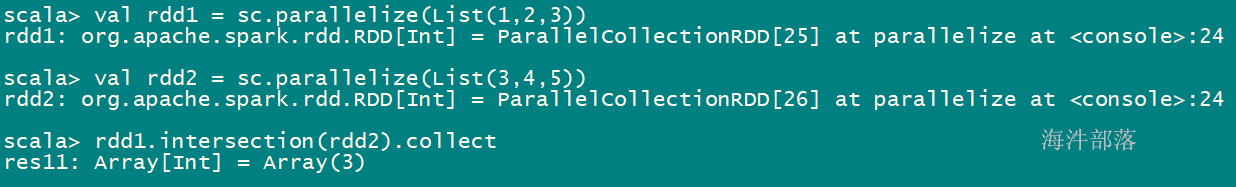

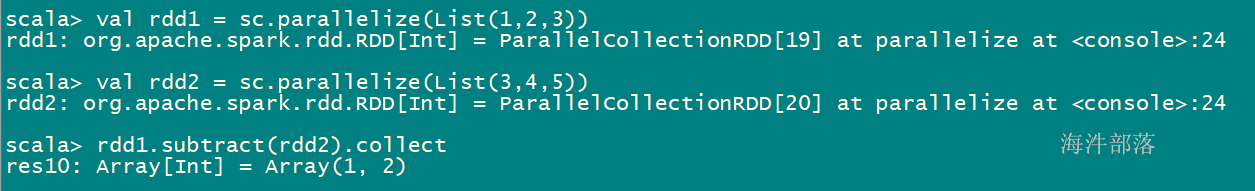

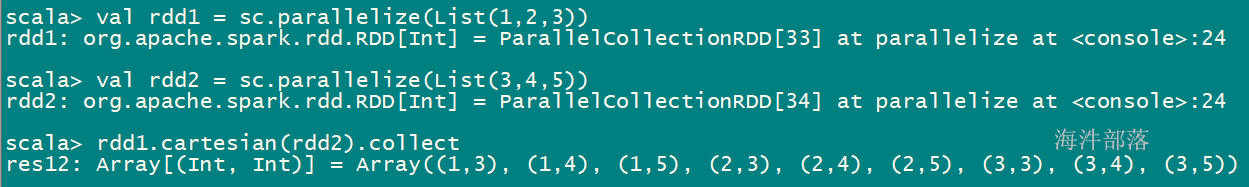

9.2.1.3 RDD 间操作

假设rdd的元素是:{1, 2, 3},other元素是:{3, 4, 5}

| 函数 | 目的 | 示例 | 结果 |

|---|---|---|---|

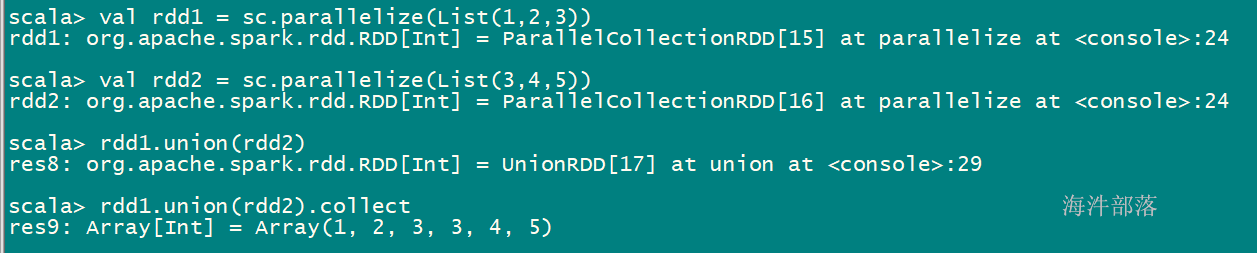

| union(other) | 生成一个包含两个RDD中所有元素的RDD | rdd.union(other) | {1,2,3,3,4,5} |

| intersection(other) | 求两个RDD交集的RDD | rdd.intersection(other) | {3} |

| subtract(other) | 移除一个RDD中的内容,差集 | rdd.subtract(other) | {1,2} |

| cartesian(other) | 与另一个RDD的笛卡儿积 | rdd.cartesian(other) | {(1,3),(1,4)….} |

注意:类型要一致

union(other) 并集

val rdd1 = sc.parallelize(List(1,2,3))

val rdd2 = sc.parallelize(List(3,4,5))

rdd1.union(rdd2).collect

val rdd1 = sc.parallelize(List(1,2,3))

val rdd2 = sc.parallelize(List(3,4,5))

rdd1.intersection(rdd2).collect

val rdd1 = sc.parallelize(List(1,2,3))

val rdd2 = sc.parallelize(List(3,4,5))

rdd1.subtract(rdd2).collect

val rdd1 = sc.parallelize(List(1,2,3))

val rdd2 = sc.parallelize(List(3,4,5))

rdd1.cartesian(rdd2).collect

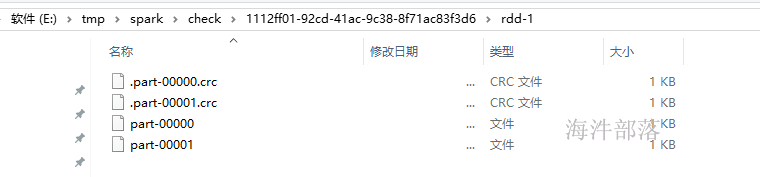

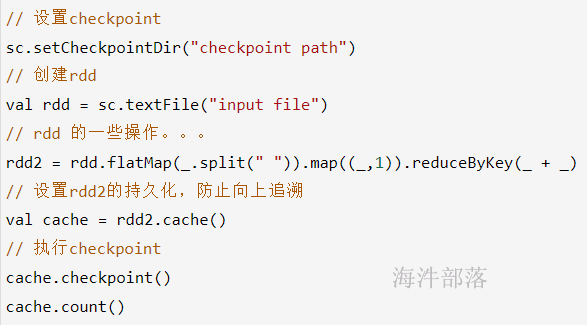

9.2.1.4 checkpoint

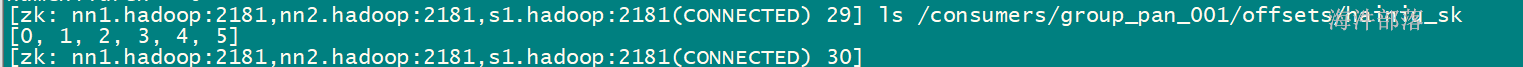

执行在action之后,checkpoint 会忘记血缘关系。并且把数据放到hdfs上。 cache 不会忘记血缘关系,把数据放到内存。sc.setCheckpointDir.png)

import org.apache.spark.rdd.RDD

import org.apache.spark.{SparkConf, SparkContext}

object CheckPointDemo {

def main(args: Array[String]): Unit = {

val conf: SparkConf = new SparkConf().setMaster("local[*]").setAppName("CacheDemo")

val sc: SparkContext = new SparkContext(conf)

// 设置checkpoint目录

sc.setCheckpointDir("/tmp/spark/check")

val rdd: RDD[Int] = sc.parallelize(1 to 6, 2)

val rdd2: RDD[Int] = rdd.map(f => {

println(s"f:${f}")

f * 10

})

val cache: RDD[Int] = rdd2.cache()

// 设置checkpoint

// 当action执行触发checkpoint操作,它会向上追溯,如果是像map, flatMap这类的窄依赖,它会一直向上追溯

// 这就导致重复运算,所以需要在checkpoint前面加个cache,不让重复运算

// 当执行完checkpoint后,之前的血缘关系都会忘记

cache.checkpoint()

cache.count()

println(cache.getCheckpointFile)

}

}

Cache和chkpt的比对

- cache一次性 容易丢失数据 不能数据共享

- Ckpt将数据保存到hdfs中稳定,永久,共享,但是需要触发两次运算,cache和ckpt连用,cache不需要进行计算,但是DAG依旧存在,ckpt需要截断DAG

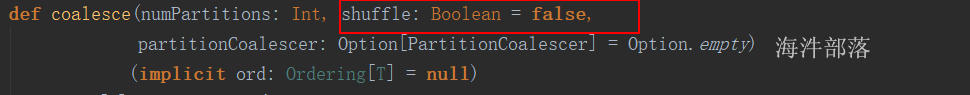

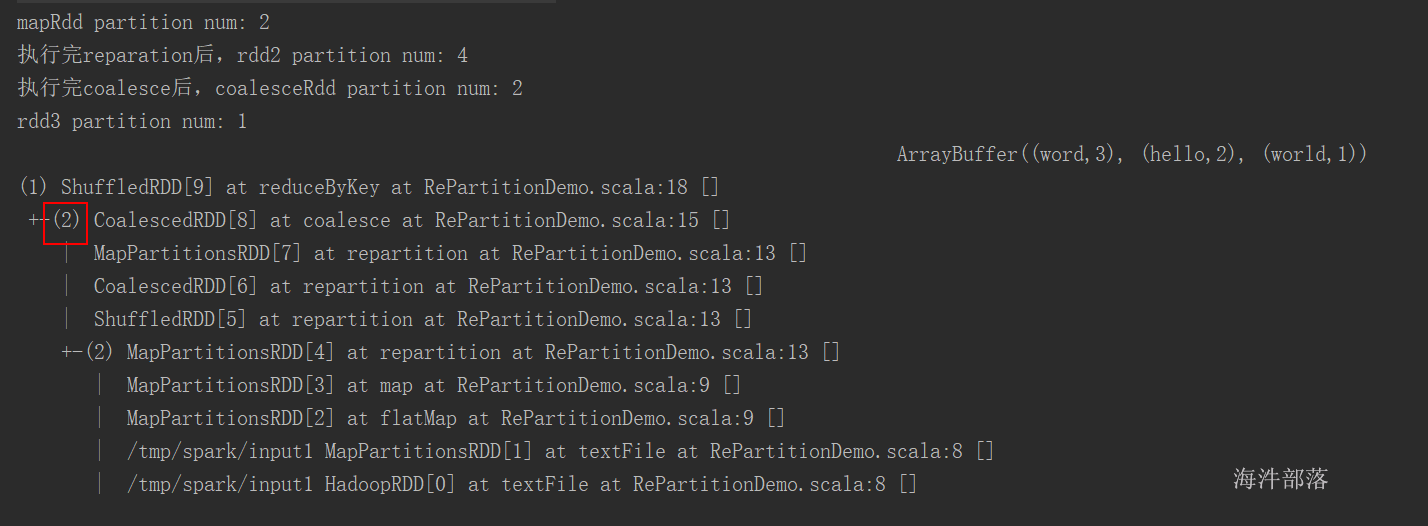

9.2.1.5 coalesce 与 repartition

当分区由多变少时,不需要shuffle,也就是父RDD与子RDD之间是窄依赖。 但极端情况下(1000个分区变成1个分区),这时如果将shuffle设置为false,父子RDD是窄依赖关系,他们同处在一个Stage中,就可能造成spark程序的并行度不够,从而影响性能,如果1000个分区变成1个分区,为了使coalesce之前的操作有更好的并行度,可以将shuffle设置为true。

import org.apache.spark.{SparkConf, SparkContext}

import org.apache.spark.rdd.RDD

object RePartitionDemo {

def main(args: Array[String]): Unit = {

val conf: SparkConf = new SparkConf().setMaster("local[*]").setAppName("wordcount")

val sc: SparkContext = new SparkContext(conf)

val rdd: RDD[String] = sc.textFile("/tmp/spark/input1")

val mapRdd: RDD[(String, Int)] = rdd.flatMap(_.split("\t")).map((_,1))

println(s"mapRdd partition num: ${mapRdd.getNumPartitions}")

// 先执行 reparation

// reparation会产生shuffle,宽依赖

val rdd2: RDD[(String, Int)] = mapRdd.repartition(4)

println(s"执行完reparation后,rdd2 partition num: ${rdd2.getNumPartitions}")

// coalesce产生shuffle,是窄依赖

// 当一个阶段内有多个rdd,每个rdd可能分区数不同,那提交这个阶段的task时,

// task数是按照最后的rdd分区数

val coalesceRdd: RDD[(String, Int)] = rdd2.coalesce(2)

println(s"执行完coalesce后,coalesceRdd partition num: ${coalesceRdd.getNumPartitions}")

// 执行reduceByKey

// 算子本身带着 重新分区的个数

val rdd3: RDD[(String, Int)] = coalesceRdd.reduceByKey(_ + _, 1)

println(s"rdd3 partition num: ${rdd3.getNumPartitions}")

val arr: Array[(String, Int)] = rdd3.collect()

println(arr.toBuffer)

println(rdd3.toDebugString)

}

}

9.2.1.6 其他转换操作

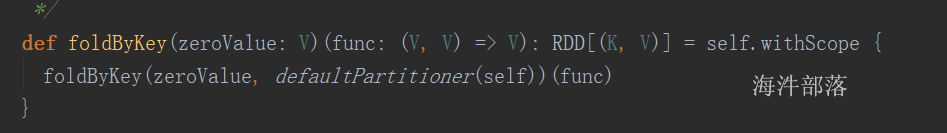

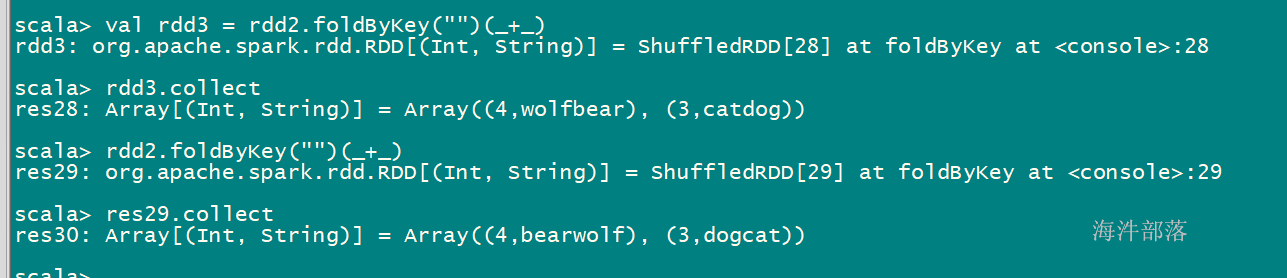

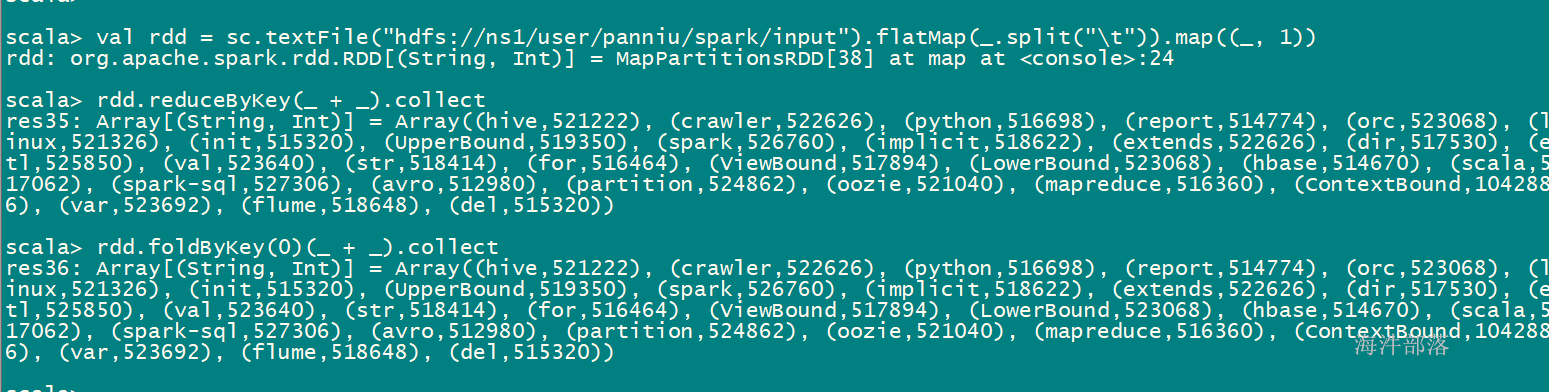

foldByKey

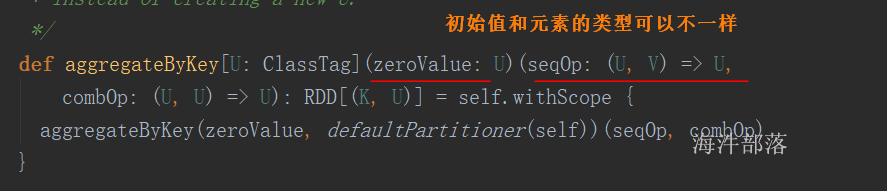

aggregateByKey

带有初始值的reduceByKey,

分区内的算法和分区间的算法可以不一样

对PairRDD中相同的Key值进行聚合操作,在聚合过程中同样使用了一个中立的初始值。和aggregate函数类似,aggregateByKey返回值的类型不需要和

RDD中value的类型一致。因为aggregateByKey是对相同Key中的值进行聚合操作,所以aggregateByKey函数最终返回的类型还是PairRDD,对应的结果

是Key和聚合后的值。

执行大概逻辑是:

(zeroValue+分区1的value数据) 得到分区1中间结果

(zeroValue+分区2的value数据) 得到分区2中间结果

(zeroValue+分区1的value数据)+ (zeroValue+分区2的value数据)

对PairRDD进行运算,在运算过程中如果分区中没有该key,就不计算该分区的key的值。

跟aggregate 不同的是,在combiner计算时,不再加初始值。

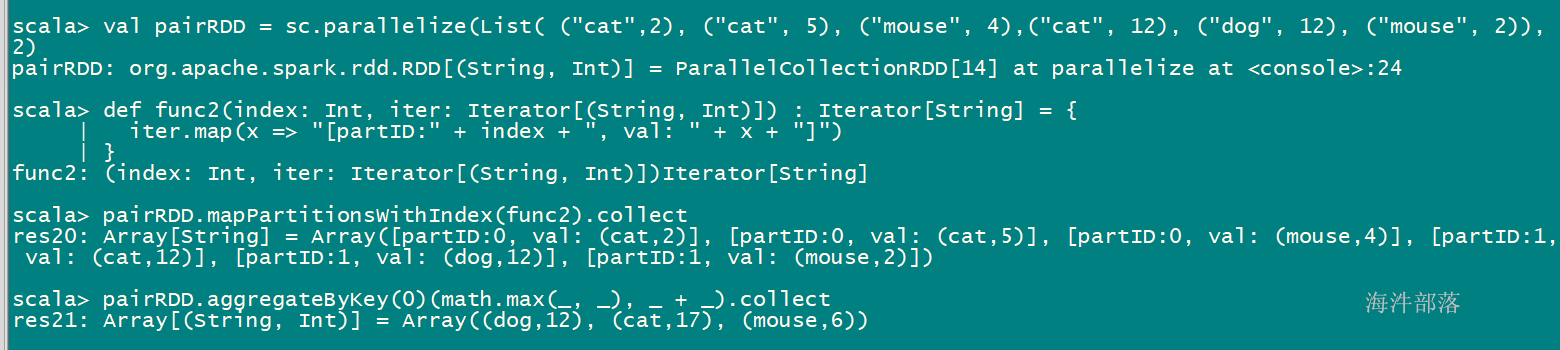

val pairRDD = sc.parallelize(List( (“cat”,2), (“cat”, 5), (“mouse”, 4),(“cat”, 12), (“dog”, 12), (“mouse”, 2)), 2)

def func2(index: Int, iter: Iterator[(String, Int)]) : Iterator[String] = {

iter.map(x => “[partID:" + index + ", val: " + x + "]”)

}

pairRDD.mapPartitionsWithIndex(func2).collect

pairRDD.aggregateByKey(0)(math.max(, ), _ + _).collect

分区0:

cat: 5

mouse: 4

分区1:

cat: 12

dog: 12

mouse: 2

分区间汇总:

cat: 5+12=17

dog: 0 + 12 =12

mouse: 4 + 2 = 6

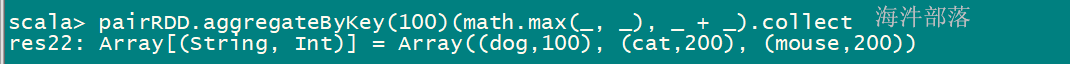

pairRDD.aggregateByKey(100)(math.max(, ), _ + _).collect

分区0:

cat: 100

mouse: 100

分区1:

cat: 100

dog: 100

mouse: 100

分区间汇总:

cat: 100+100=200

dog: 0 + 100 =100

mouse: 100 + 100 = 200

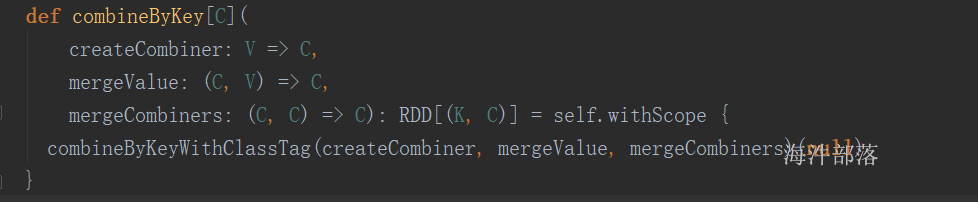

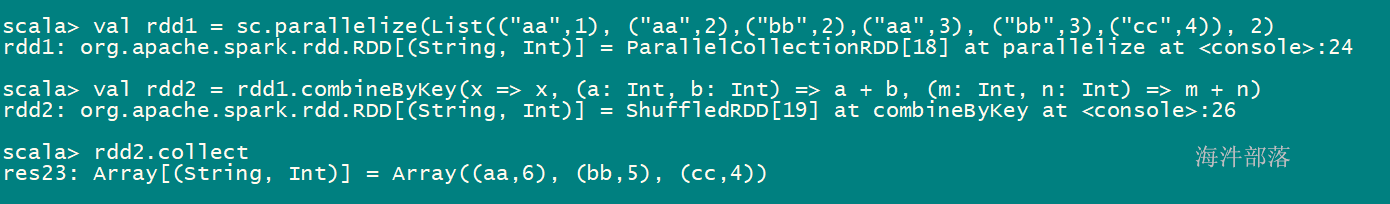

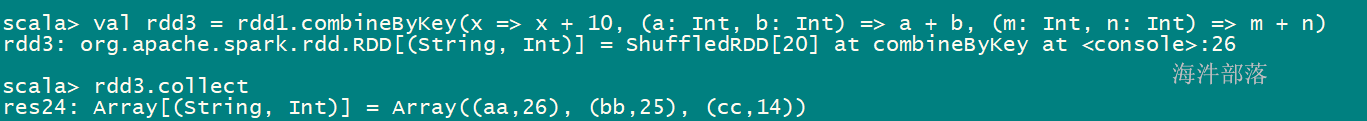

combineByKey

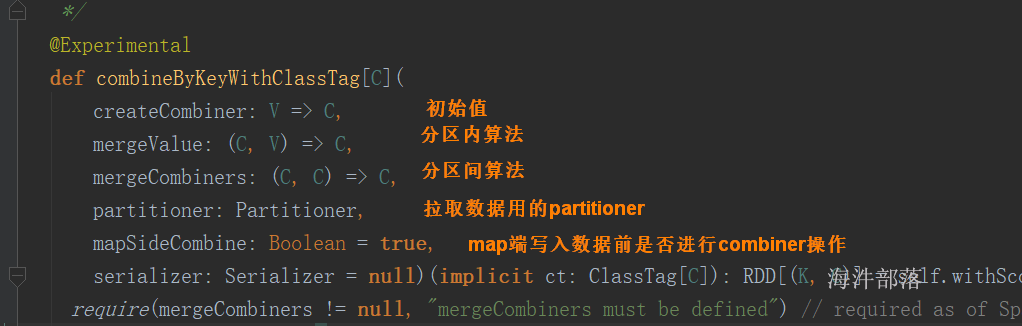

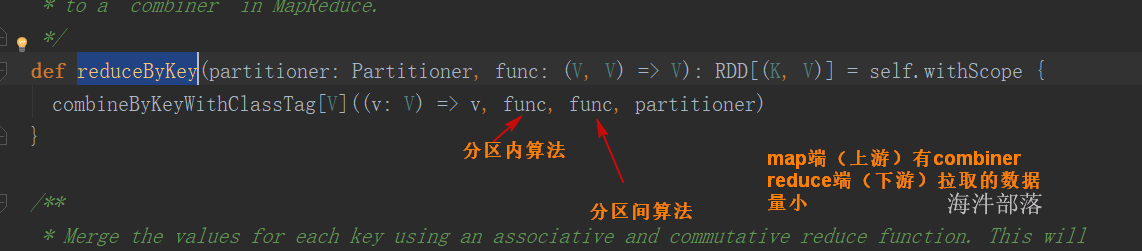

spark的reduceByKey、aggregateByKey、foldByKey函数底层调用的都是 combinerByKey(现在换成了 combineByKeyWithClassTag);他们都可以实现局部聚合再全局聚合;语法:

mergeValue: (C, V) => C,该函数把元素V合并到之前的元素C(createCombiner)上 (这个操作在每个分区内进行)

mergeCombiners: (C, C) => C,该函数把2个元素C合并 (这个操作在不同分区间进行)

val rdd1 = sc.parallelize(List((“aa”,1), (“aa”,2),(“bb”,2),(“aa”,3), (“bb”,3),(“cc”,4)), 2)

val rdd2 = rdd1.combineByKey(x => x, (a: Int, b: Int) => a + b, (m: Int, n: Int) => m + n)

rdd2.collect

rdd3.collect

reduceByKey:无初始值、接收的函数的输入和输出类型一致、分区内和分区间的算法是一样的; foldByKey:有初始值、接收的初始值与函数的输入和输出类型一致、分区内和分区间的算法是一样的; aggregateByKey:分区内和分区间的算法可以不一样、初始值类型可以和rdd元素类型不一致; combineByKey :完全定制,想怎么完怎么玩。

val rdd1 = sc.parallelize(List((“e”, 5), (“c”, 3), (“d”, 4), (“c”, 2), (“a”, 1)))

9.2.2 行动操作

假设rdd 的元素是:{1, 2, 3, 3}

假设rdd2 的元素是:{(“a”, 1), (“b”, 2)}

| 函数 | 目的 | 示例 | 结果 |

|---|---|---|---|

| collect() | 以数组的形式返回RDD中的所有元素 | rdd.collect() | {1, 2, 3, 3} |

| collectAsMap() | 该函数用于Pair RDD 最终返回Map类型的结果 | rdd2.collectAsMap() | Map(“a”->1,“b”->2) |

| count() | RDD中的元素个数 | rdd.count() | 4 |

| countByValue() | 各元素在RDD中出现的次数 | rdd.countByValue() | {(1, 1), (2, 1), (3, 2)} |

| take(n) 在scala中是截取集合take slice 在spark中也是截取rdd变成本地集合,在截取数据的时候是按照分区截取的,存在的数据在几个分区中就会存在几个job任务 | 从RDD中返回 n 个元素 | rdd.take(1) | {1} |

| first() | 从RDD中返回第一个元素 | rdd.first() | 1 |

| top(num) | 返回最大的 num 个元素 | rdd.top(2) | {3,3} |

| takeOrdered(num)(ordering) | 按照指定顺序返回前面num个元素 | rdd.takeOrdered(2) | {1,2} |

| reduce(func) | 通过函数func(输入两个参数并返回一个值)聚合数据集中的元素,比如求和 | rdd.reduce((a,b)=>a+b) | ((1+2) + 3) + 3) = 9 |

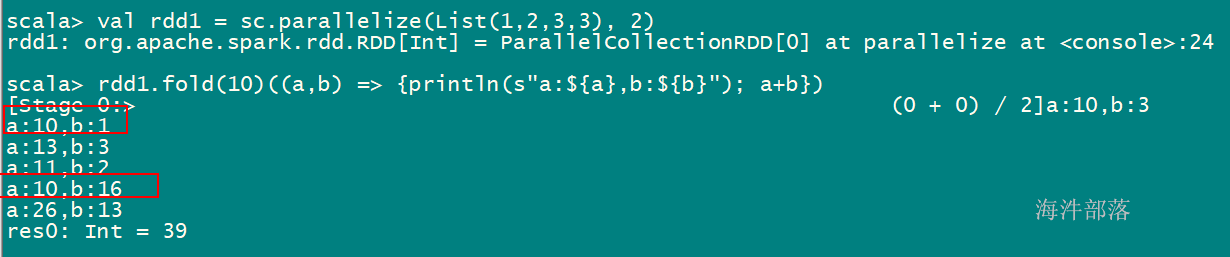

| fold(zero)(func) | 和reduce一样,给定初值,每个分区计算时都会使用此初值 | rdd.fold(1)((a,b)=>a+b) | 2个分区时结果:1+ ((1+1) + 2) + ((1 +3) +3) |

| aggregate(zeroValue)(seqOp,combOp) | 和reduce类似,但可以返回类型不同的结果 | rdd.aggregate(0)((x,y) => x + y, (x,y) => x + y) | 9 |

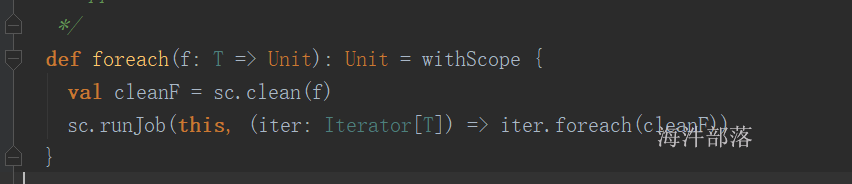

| foreach(func) | 对每个元素使用func函数 | rdd.foreach(println(_)) | 在executor端打印输出所有元素 |

| ForeachPartition |

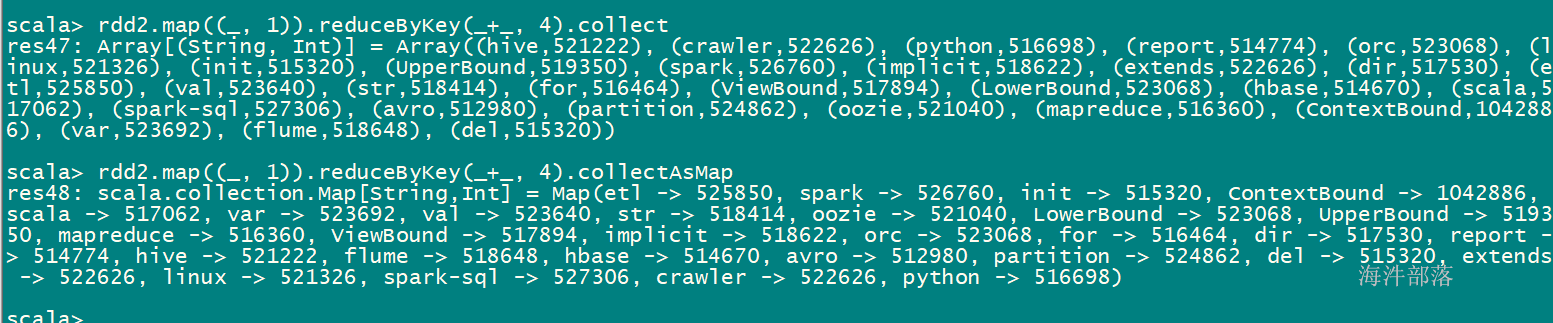

collect vs collectAsMap

collect: 以数组的形式返回RDD中的所有元素

collectAsMap: 以map方式返回,作用在键值对rdd上,如果你想的返回的数据是排序好的,那就用collect

foreach vs foreachPartition

import org.apache.spark.{SparkConf, SparkContext}

import org.apache.spark.rdd.RDD

object ForeachDemo {

def main(args: Array[String]): Unit = {

val conf: SparkConf = new SparkConf().setMaster("local[*]").setAppName("CacheDemo")

val sc: SparkContext = new SparkContext(conf)

val rdd: RDD[Int] = sc.parallelize(1 to 6, 2)

// foreach 和 foreachPartition 内的函数都是在executor端运行

// windows 是利用多线程运行,所以能看见,但如果在集群运行,看不见输出结果

// 是分区内的每个元素一个一个的迭代。

// rdd.foreach(f =>{

// println(s"f:${f}")

// })

// 先分区,分区里的数据组成的迭代器,拿着迭代器去迭代每个元素

rdd.foreachPartition(it =>{

// scala的foreach

it.foreach(f =>{

println(s"f:${f}")

})

})

}

}foreach是每个partition的数据,该函数内需要传入一个函数。

val rdd1 = sc.parallelize(List(1, 2, 3, 4, 5, 6, 7, 8, 9), 3)

fold val rdd1 = sc.parallelize(List(1,2,3,3), 2)

rdd1.fold(10)((a,b) => {println(s“a:{b}”); a+b})

10 + (10+1+2) + (10 + 3 + 3)

val func = (index: Int, iter: Iterator[Int]) => {

iter.map(x => s“[partID:{x}]”)

}

val rdd1 = sc.parallelize(List(1,2,3,4,5,6,7,8,9), 2)

rdd1.mapPartitionsWithIndex(func).collect

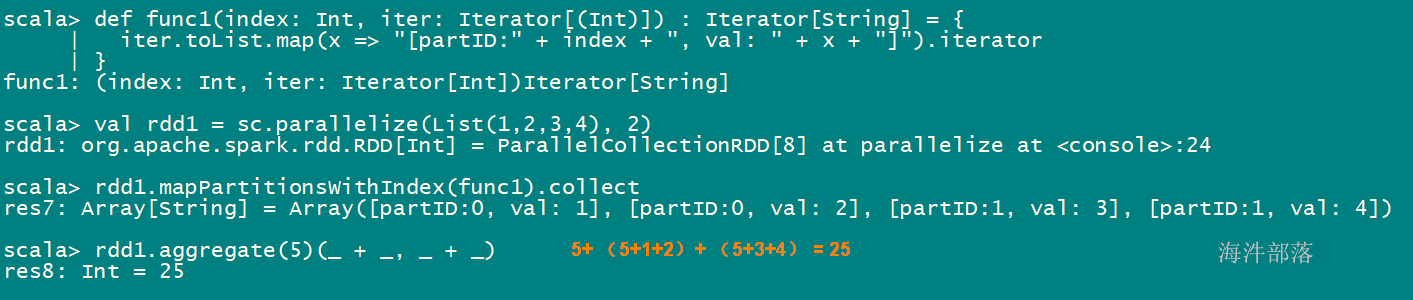

aggregate(zeroValue)(seqOp,combOp)

执行aggregate,大概逻辑是:

(zeroValue+分区1的数据) 得到分区1中间结果

(zeroValue+分区2的数据) 得到分区2中间结果

zeroValue + (zeroValue+分区1的数据)+ (zeroValue+分区2的数据)

def func1(index: Int, iter: Iterator[(Int)]) : Iterator[String] = {

iter.toList.map(x => “[partID:" + index + ", val: " + x + "]”).iterator

}

val rdd1 = sc.parallelize(List(1,2,3,4), 2)

rdd1.mapPartitionsWithIndex(func1).collect

rdd1.aggregate(5)(_ + , + _)

5+(5+1+2) + (4+3+4)

iter.toList.map(x => “[partID:" + index + ", val: " + x + "]”).iterator

}

val rdd1 = sc.parallelize(List(1,2,3,4,5,6,7,8,9), 2)

rdd1.mapPartitionsWithIndex(func1).collect

rdd1.aggregate(0)(math.max(, ), _ + _)

0 +4 + 9 = 13

rdd1.aggregate(5)(math.max(, ), _ + _)

5 + 5 + 9 = 19

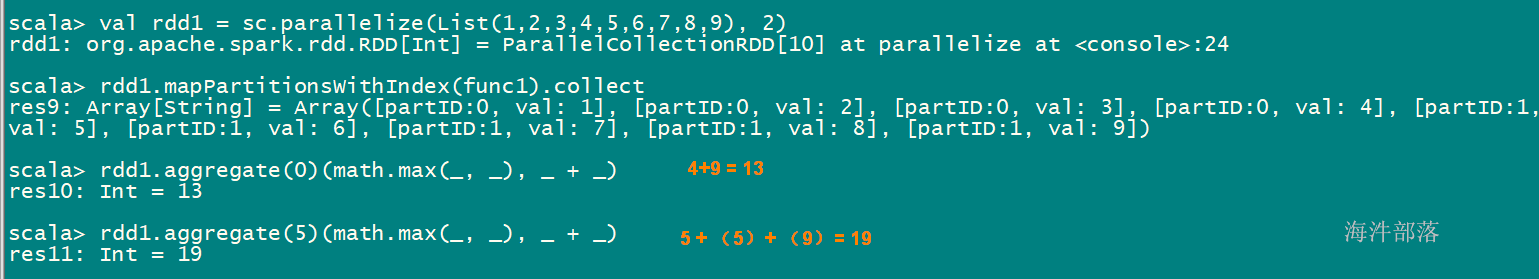

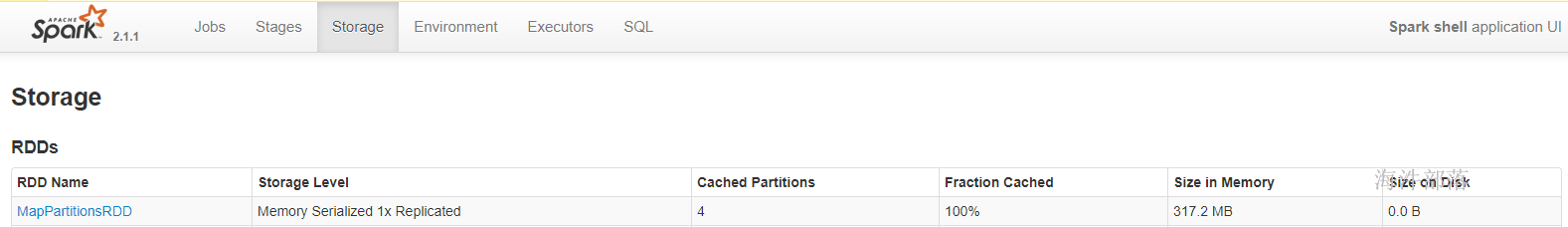

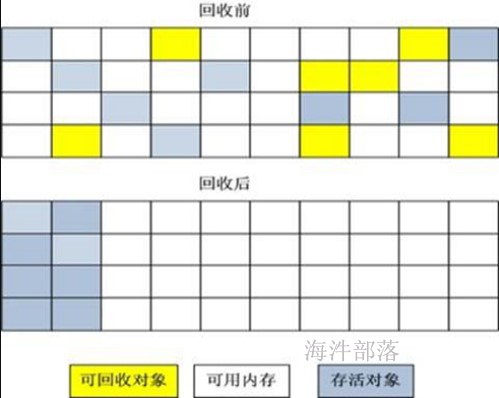

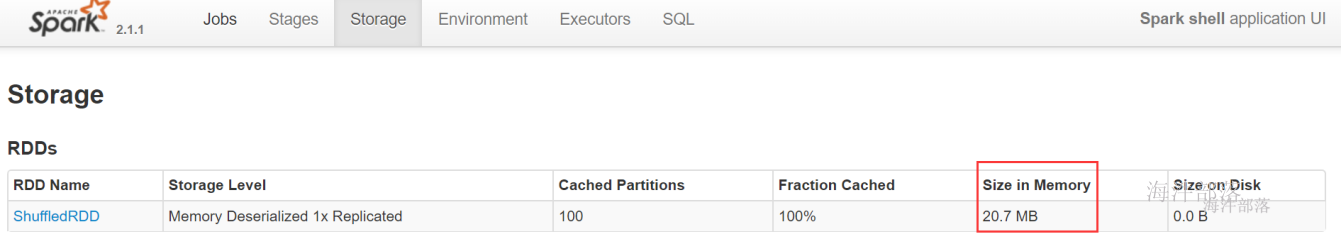

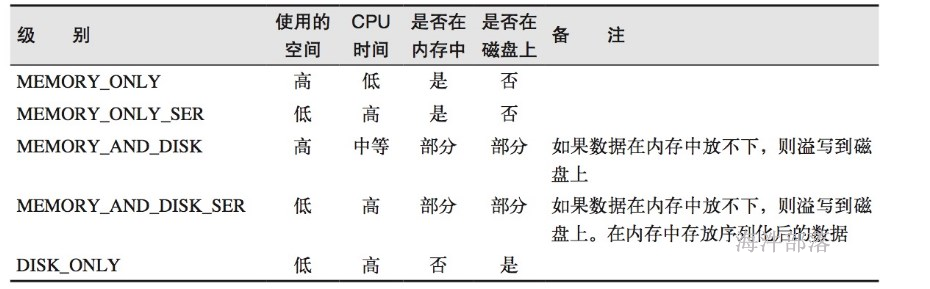

10 rdd的存储级别

cache() 调用 persist(),且默认存储级别是 MEMORY_ONLY。

persist() 用来设置RDD的存储级别

| 存储级别 | 意义 |

|---|---|

| MEMORY_ONLY | 使用未序列化的Java对象格式,将数据保存在内存中。如果内存不够存放所有的数据,则数据可能就不会进行持久化。那么下次对这个RDD执行算子操作时,那些没有被持久化的数据,需要从源头处重新计算一遍。这是默认的持久化策略,使用cache()方法时,实际就是使用的这种持久化策略 |

| MEMORY_AND_DISK | 使用未序列化的Java对象格式,优先尝试将数据保存在内存中。如果内存不够存放所有的数据,会将数据写入磁盘文件中,下次对这个RDD执行算子时,持久化在磁盘文件中的数据会被读取出来使用 |

| MEMORY_ONLY_SER | 基本含义同MEMORY_ONLY。唯一的区别是,会将RDD中的数据进行序列化,RDD的每个partition会被序列化成一个字节数组。这种方式更加节省内存,从而可以避免持久化的数据占用过多内存导致频繁GC |

| MEMORY_AND_DISK_SER | 基本含义同MEMORY_AND_DISK。唯一的区别是,会将RDD中的数据进行序列化,RDD的每个partition会被序列化成一个字节数组。这种方式更加节省内存,从而可以避免持久化的数据占用过多内存导致频繁GC |

| DISK_ONLY | 使用未序列化的Java对象格式,将数据全部写入磁盘文件中 |

| MEMORY_ONLY_2, MEMORY_AND_DISK_2, etc. | 对于上述任意一种持久化策略,如果加上后缀_2,代表的是将每个持久化的数据,都复制一份副本,并将副本保存到其他节点上。这种基于副本的持久化机制主要用于进行容错 |

JAVA对象 = 对象头 + 实例数据 + 对象填充(补余用的,用于保证对象所占空间是8个字节的整数倍)

// MEMORY_ONLY 存储

import org.apache.spark.storage.StorageLevel

val rdd1 = sc.textFile(“hdfs://ns1/user/panniu/spark/input”).flatMap(.split(")).map((,1))

val rdd2 = rdd1.persist(StorageLevel.MEMORY_ONLY)

rdd2.count()

import org.apache.spark.storage.StorageLevel

val rdd1 = sc.textFile(“hdfs://ns1/user/panniu/spark/input”).flatMap(.split(")).map((,1))

val rdd2 = rdd1.persist(StorageLevel.MEMORY_ONLY_SER)

rdd2.count()

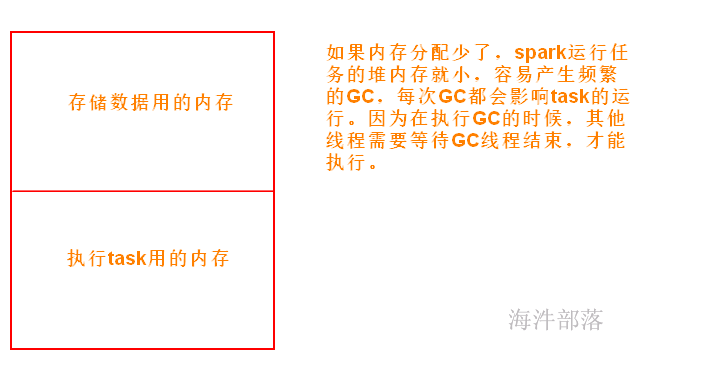

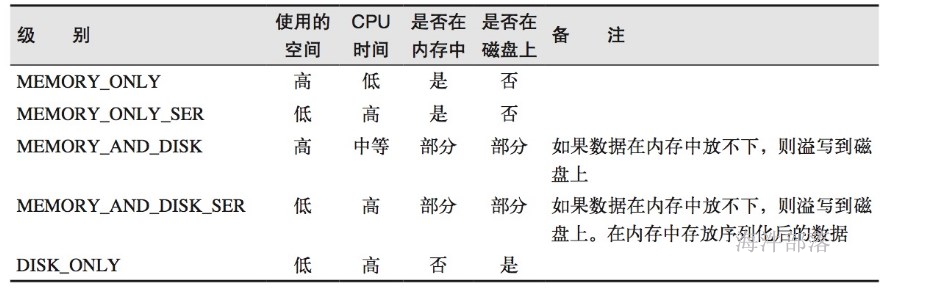

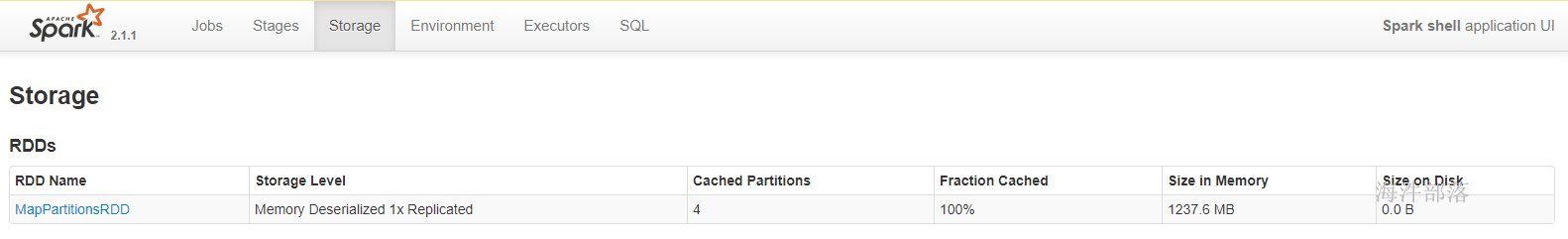

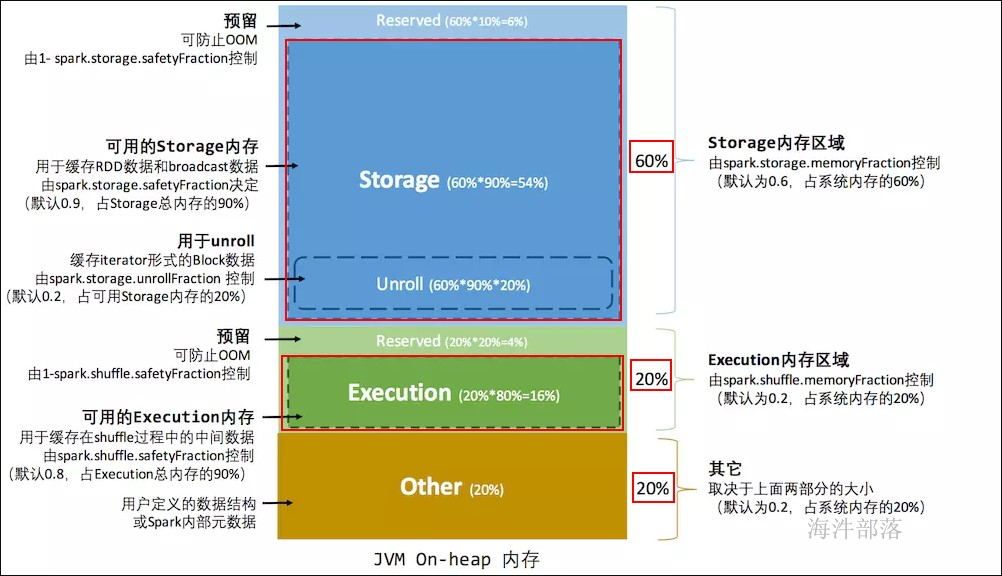

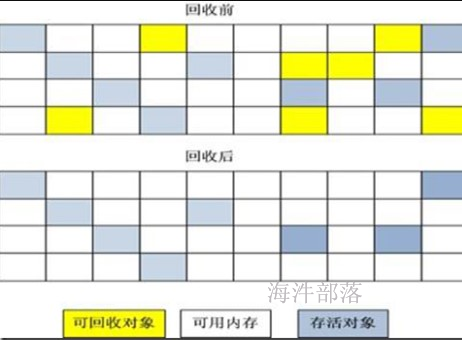

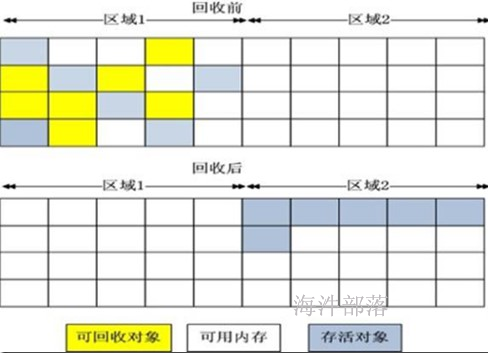

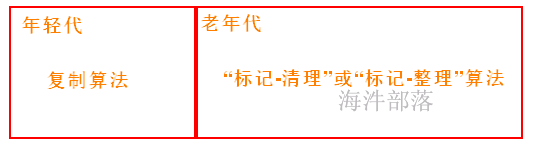

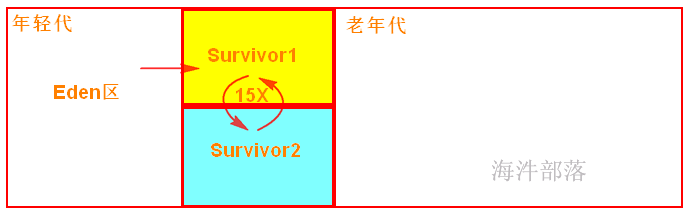

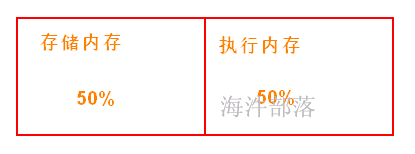

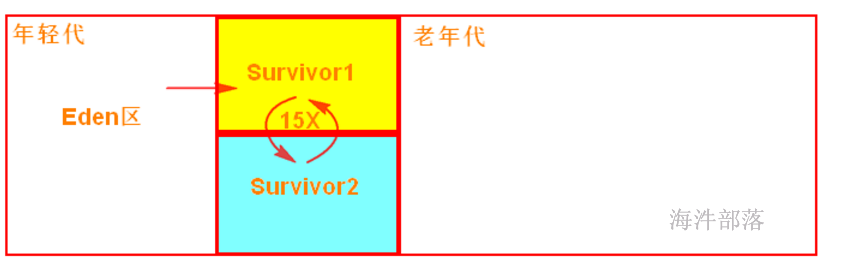

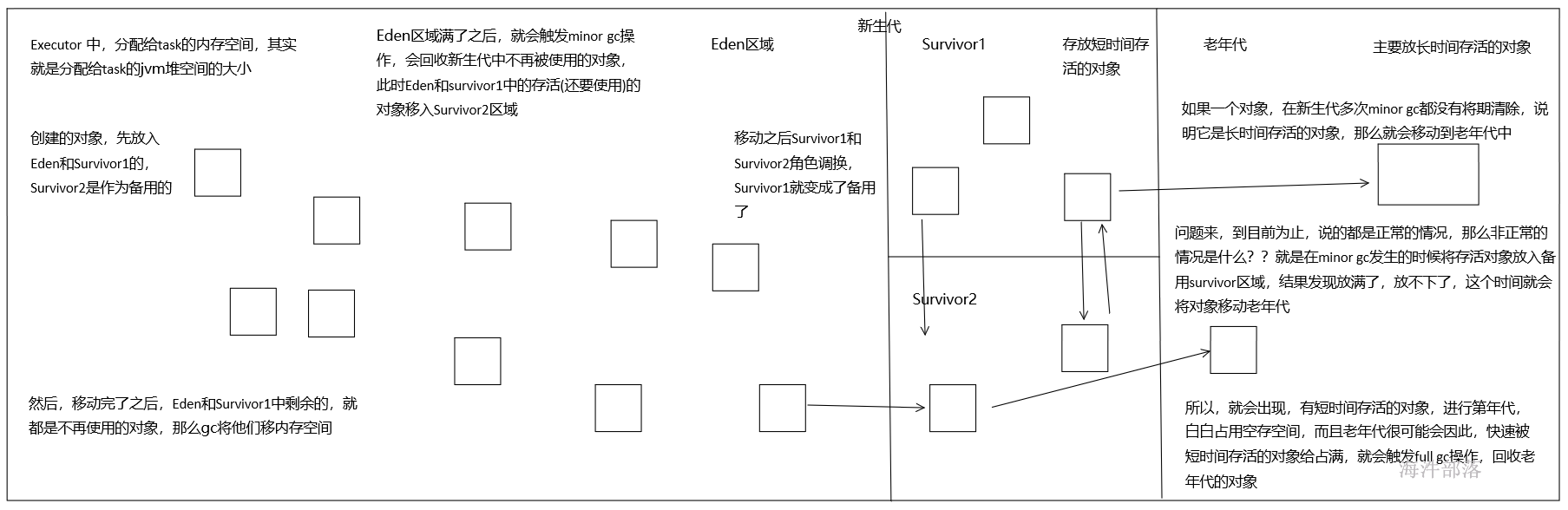

Spark 作为一个以擅长内存计算为优势的计算引擎,内存管理方案是其非常重要的模块; Spark的内存可以大体归为两类:execution(运行内存)和storage(存储内存),前者包括shuffles、joins、sorts和aggregations所需内存,后者包括cache和节点间数据传输所需内存;

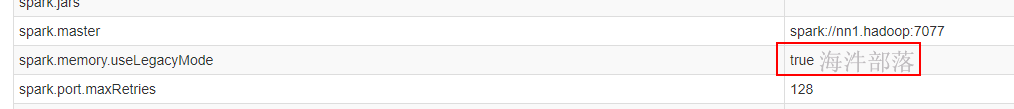

在Spark 1.5和之前版本里,运行内存和存储内存是静态配置的,不支持借用;Spark 1.6之后引入的统一内存管理机制,与静态内存管理的区别在于存储内存和执行内存共享同一块空间,可以动态占用对方的空闲区域,提供更好的性能。

11.1 静态内存管理——spark1.5

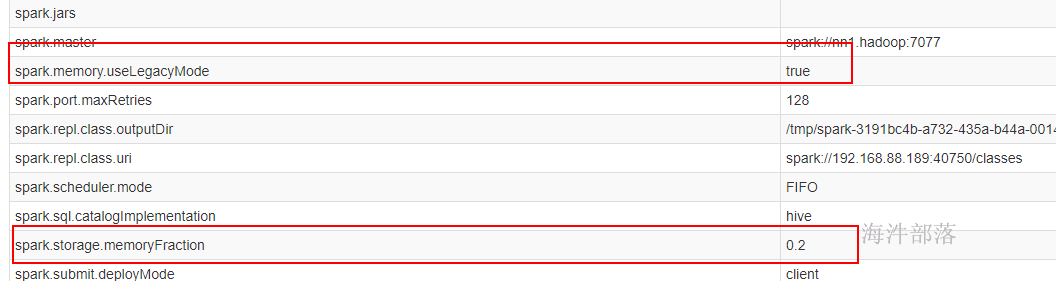

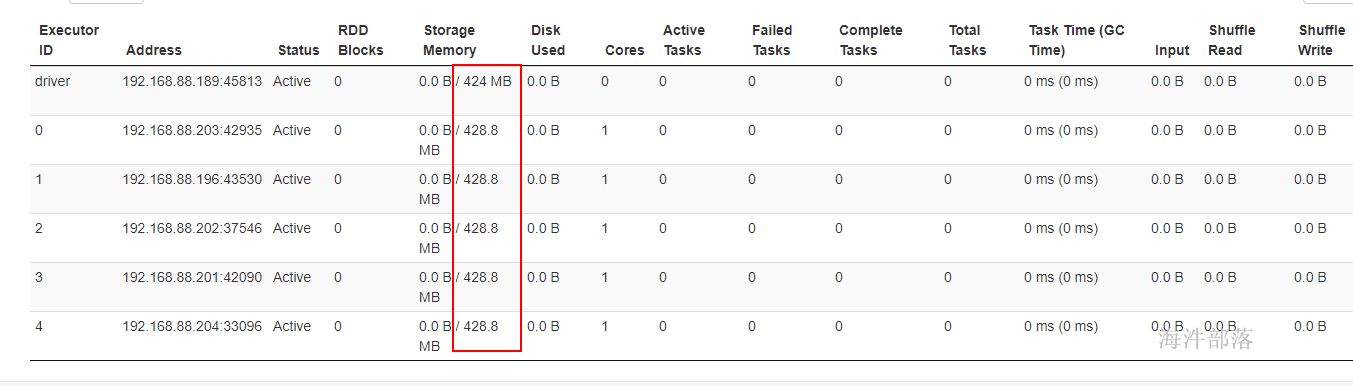

spark1.6 及以后兼容了 spark1.5 的内存管理。当配置 spark.memory.useLegacyMode=true 时,采用spark1.5的内存管理;当spark.memory.useLegacyMode=false时,采用spark1.6 及以后的内存管理。

spark1.5 的内存管理实现类: StaticMemoryManager

spark.storage.memoryFraction:

spark 存储总内存占 系统内存的百分比,默认是 0.6。

spark.shuffle.memoryFraction:

spark shuffle 执行用到的内存 占系统内存的百分比,默认是0.2。

spark.storage.safetyFraction:

可用的存储内存占总存储内存的百分比,默认是 0.9。

spark.shuffle.safetyFraction:

可用的shuffle操作执行内存占总执行内存的百分比, 默认是 0.8。

private def getMaxExecutionMemory(conf: SparkConf): Long = {

val systemMaxMemory = conf.getLong("spark.testing.memory", Runtime.getRuntime.maxMemory)

// 如果拿到的最大内存 < 32M

if (systemMaxMemory < MIN_MEMORY_BYTES) {

throw new IllegalArgumentException(s"System memory $systemMaxMemory must " +

s"be at least $MIN_MEMORY_BYTES. Please increase heap size using the --driver-memory " +

s"option or spark.driver.memory in Spark configuration.")

}

if (conf.contains("spark.executor.memory")) {

val executorMemory = conf.getSizeAsBytes("spark.executor.memory")

if (executorMemory < MIN_MEMORY_BYTES) {

throw new IllegalArgumentException(s"Executor memory $executorMemory must be at least " +

s"$MIN_MEMORY_BYTES. Please increase executor memory using the " +

s"--executor-memory option or spark.executor.memory in Spark configuration.")

}

}

val memoryFraction = conf.getDouble("spark.shuffle.memoryFraction", 0.2)

val safetyFraction = conf.getDouble("spark.shuffle.safetyFraction", 0.8)

(systemMaxMemory * memoryFraction * safetyFraction).toLong

}

private def getMaxStorageMemory(conf: SparkConf): Long = {

val systemMaxMemory = conf.getLong("spark.testing.memory", Runtime.getRuntime.maxMemory)

val memoryFraction = conf.getDouble("spark.storage.memoryFraction", 0.6)

val safetyFraction = conf.getDouble("spark.storage.safetyFraction", 0.9)

(systemMaxMemory * memoryFraction * safetyFraction).toLong

}举例:executor 的最大可用内存1000M

存储总内存 = 1000M * 0.6 = 600M

运行总内存 = 1000M * 0.2 = 200M

other = 1000M - 600M - 200M = 200M

存储总内存 = 安全存储内存 + 预留内存(防止OOM)

安全存储内存 = 存储总内存 * 0.9 = 600 * 0.9 = 540M

预留内存 = 存储总内存 * (1-0.9) = 60M

运行总内存 = 安全运行内存 + 预留内存(防止OOM)

安全运行内存 = 运行总内存 * 0.8 = 200M * 0.8 = 160M

预留内存 = 运行总内存 * (1-0.8) = 40M

缺点:

这种内存管理方式的缺陷,即 execution 和 storage 内存分配,即使在一方内存不够用而另一方内存空闲的情况下也不能共享,造成内存浪费。

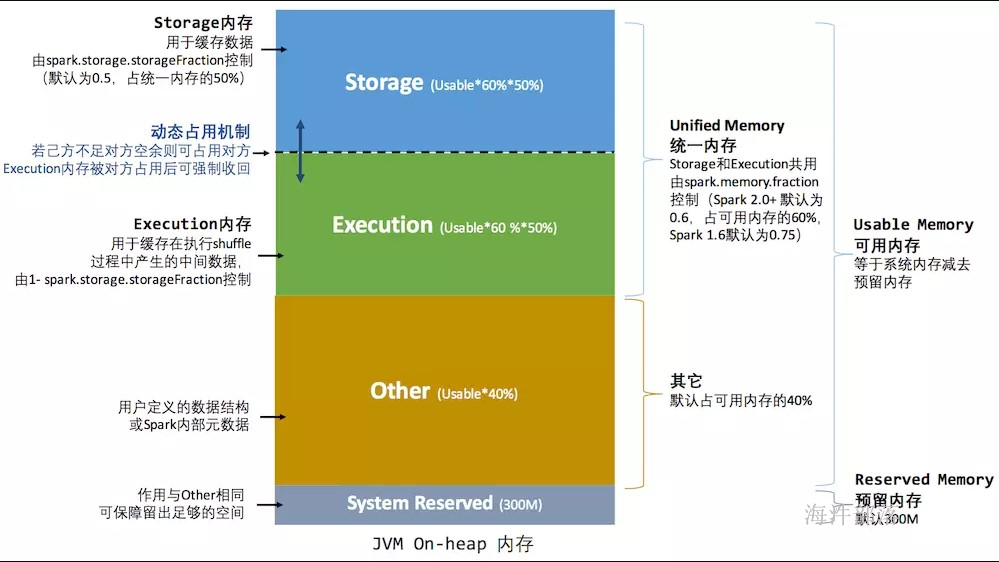

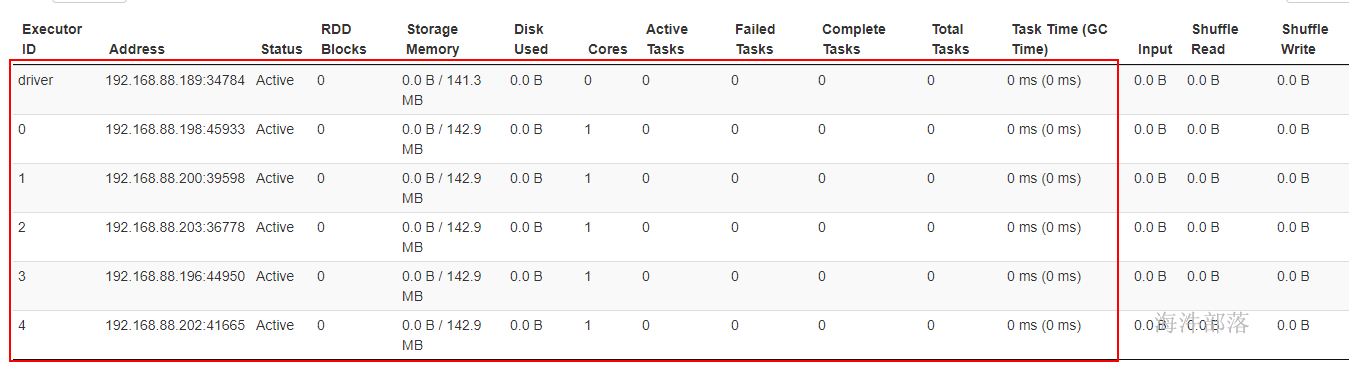

11.2 统一内存管理——spark1.6以后

当spark.memory.useLegacyMode=false时,采用spark1.6 及以后的内存管理。

spark1.6及以后 的内存管理实现类: UnifiedMemoryManager

当前spark版本是 spark2.1.1 ,参数配置部分与spark1.6 不同,下面讲解按照spark2.1.1 版本进行参数讲解。

spark.memory.fraction:

spark内存占可用内存(系统内存 - 300)的百分比,默认是0.6。

spark.memory.storageFraction:

spark的存储内存占spark内存的百分比,默认是0.5。

spark的统一内存管理,可以通过配置 spark.memory.storageFraction ,来调整 存储内存和执行内存的比例,进而实现内存共享。

private def getMaxMemory(conf: SparkConf): Long = {

val systemMemory = conf.getLong("spark.testing.memory", Runtime.getRuntime.maxMemory)

val reservedMemory = conf.getLong("spark.testing.reservedMemory",

// 300M

if (conf.contains("spark.testing")) 0 else RESERVED_SYSTEM_MEMORY_BYTES)

// 最小内存大小:450M

val minSystemMemory = (reservedMemory * 1.5).ceil.toLong

if (systemMemory < minSystemMemory) {

throw new IllegalArgumentException(s"System memory $systemMemory must " +

s"be at least $minSystemMemory. Please increase heap size using the --driver-memory " +

s"option or spark.driver.memory in Spark configuration.")

}

// SPARK-12759 Check executor memory to fail fast if memory is insufficient

if (conf.contains("spark.executor.memory")) {

val executorMemory = conf.getSizeAsBytes("spark.executor.memory")

if (executorMemory < minSystemMemory) {

throw new IllegalArgumentException(s"Executor memory $executorMemory must be at least " +

s"$minSystemMemory. Please increase executor memory using the " +

s"--executor-memory option or spark.executor.memory in Spark configuration.")

}

}

val usableMemory = systemMemory - reservedMemory

val memoryFraction = conf.getDouble("spark.memory.fraction", 0.6)

(usableMemory * memoryFraction).toLong

}

def apply(conf: SparkConf, numCores: Int): UnifiedMemoryManager = {

// 获取最大可用内存

val maxMemory = getMaxMemory(conf)

new UnifiedMemoryManager(

conf,

maxHeapMemory = maxMemory,

// 存储内存 = 获取最大可用内存 * 0.5

onHeapStorageRegionSize =

(maxMemory * conf.getDouble("spark.memory.storageFraction", 0.5)).toLong,

numCores = numCores)

}举例:系统内存1000M

系统预留内存 = 300M

可用内存 = 系统内存 - 系统预留内存 = 1000 - 300 = 700M

spark内存 = 可用内存 * 0.6 = 700 * 0.6 = 420M

存储内存 和 执行内存 均占一半, 210M

为了提高内存利用率,spark针对Storage Memory 和 Execution Memory有如下策略:

1)一方空闲,一方内存不足情况下,内存不足一方可以向空闲一方借用内存;

2)只有Execution Memory可以强制拿回Storage Memory在Execution Memory空闲时,借用的Execution Memory的部分内存(如果因强制取回,而Storage Memory数据丢失,重新计算即可);

3)Storage Memory只能等待Execution Memory主动释放占用的Storage Memory空闲时的内存。(这里不强制取回,因为如果task执行,数据丢失就会导致task 失败);

用spark1.5的方式提交,

spark-shell –master spark://nn1.hadoop:7077 –executor-memory 1G –total-executor-cores 5 –conf spark.memory.useLegacyMode=true

spark-shell –master spark://nn1.hadoop:7077 –executor-memory 1G –total-executor-cores 5

存储内存是可用内存的一半。可用内存分配比:60%

存储内存是可用内存的一半。可用内存分配比:20%

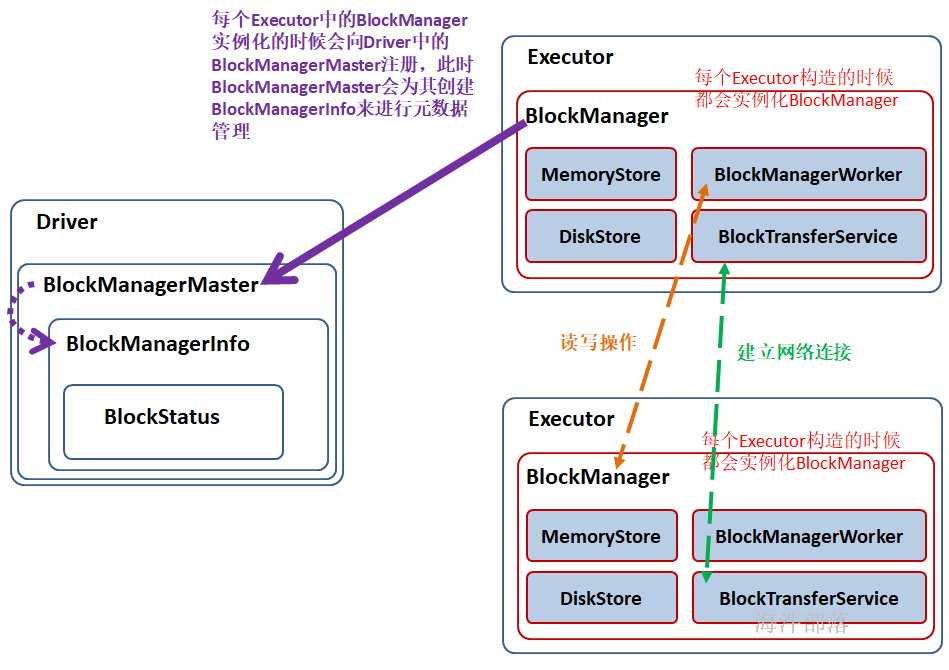

BlockManager是Spark的分布式存储系统,与我们平常说的分布式存储系统是有区别的,区别就是这个分布式存储系统只会管理Block块数据,它运行在所有节点上。

BlockManager的结构是Maser-Slave架构,Master就是Driver上的BlockManagerMaster,Slave就是每个Executor上的BlockManager。BlockManagerMaster负责接受Executor上的BlockManager的注册以及管理BlockManager的元数据信息。

运行图:

1)在 Application 启动的时候会在 SparkEnv 中注册 BlockMangerMaster。

BlockManagerMaster:对整个集群的 Block 数据进行管理;

2)每个启动一个 Executor 都会实例化 BlockManagerSlave 并通过远程通信的方式注册给 BlockMangerMaster;

3)BlockManagerSlave由 4部分组成:

MemoryStore:负责对内存上的数据进行存储和读写;

DiskStore:负责对磁盘上的数据进行存储和读写;

BlockTransferService:负责与远程其他Executor 的BlockManager建立网络连接;

BlockManagerWorker:负责对远程其他Executor的BlockManager的数据进行读写;

4)当Executor 的BlockManager 执行了增删改操作,那就必须将 block 的 blockStatus 上报给Driver端的BlockManagerMaster,BlockManagerMaster 内部的BlockManagerMasterEndPoint 内维护了 元数据信息的映射。通过Map、Set结构,很容易维护 增加、更新、删除元数据,进而达到维护元数据的功能。

// 维护 BlockManagerId 与 BlockManagerInfo 的关系

// 而BlockManagerInfo内部维护 JHashMap[BlockId, BlockStatus] 的映射关系

private val blockManagerInfo = new mutable.HashMap[BlockManagerId, BlockManagerInfo]

// 维护 executorID 与 BlockManagerId 的关系

private val blockManagerIdByExecutor = new mutable.HashMap[String, BlockManagerId]

// 维护 BlockId 与 HashSet[BlockManagerId] 的关系, 因为数据块可能有副本

private val blockLocations = new JHashMap[BlockId, mutable.HashSet[BlockManagerId]]JHashMap[BlockId, mutable.HashSet[BlockManagerId]]

HashMap[executorID, BlockManagerId]

HashMap[BlockManagerId, BlockManagerInfo]

JHashMap[BlockId, BlockStatus]

13 共享变量

Spark两种共享变量:广播变量(broadcast variable)与累加器(accumulator)。

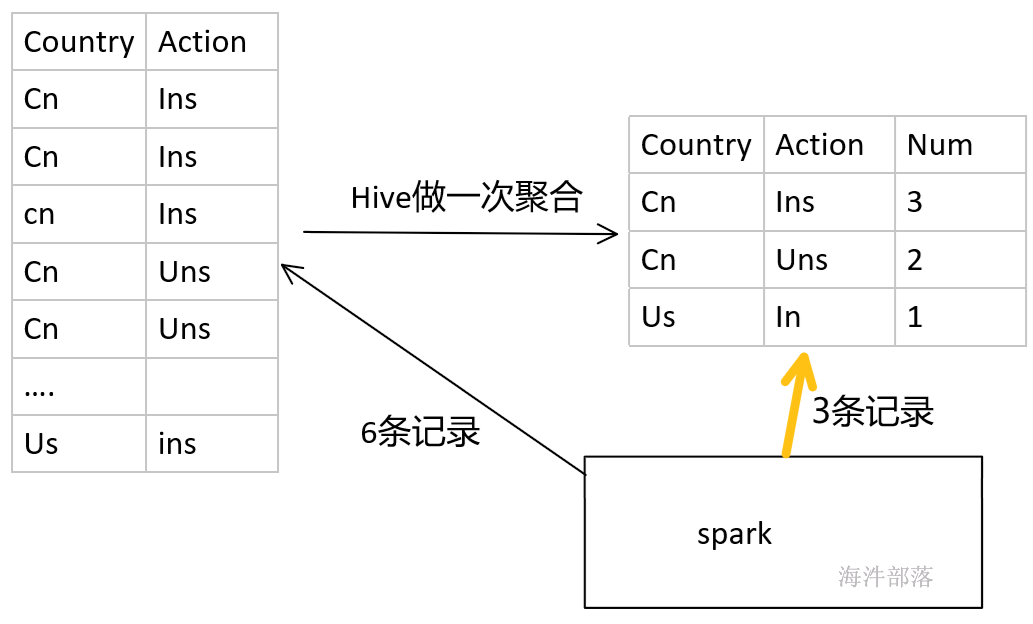

累加器用来对信息进行聚合,相当于mapreduce中的counter;而广播变量用来高效分发较大的对象,相当于semijoin中的DistributedCache 。

共享变量出现的原因:

我们传递给Spark的函数,如map(),或者filter()的判断条件函数,能够利用定义在函数之外的变量,但是集群中的每一个task都会得到变量的一个副本,并且task在对变量进行的更新不会被返回给driver。

object SharedVarTest {

def main(args: Array[String]): Unit = {

val conf: SparkConf = new SparkConf().setMaster("local[*]").setAppName("sharedvartest")

val sc = new SparkContext(conf)

//driver端定义外部变量list

val list = List(1,5,8)

// driver端定义外部变量count用于计数

var count:Int = 0

val rdd: RDD[Int] = sc.parallelize(List(1,2,3,4,5,6,7,8), 2)

val filter: RDD[Int] = rdd.filter( x => {

// executor 端用于计算和统计

if(list.contains(x)) {

count = count + 1

println(s"-->count:${count}")

true

}else{

false

}

})

val rs: Array[Int] = filter.collect()

// 发现executor端修改了,但driver端并没有修改

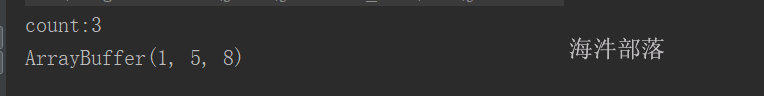

println(s"count:${count}")

println(rs.toBuffer)

}

}原因总结:

对于executor端,driver端的变量是外部变量。

excutor端修改了变量count,根本不会让driver端跟着修改。如果想在driver端得到executor端修改的变量,需要用累加器实现。

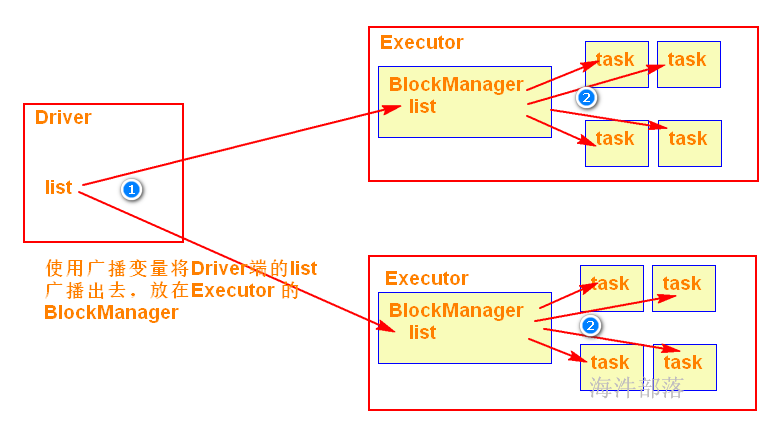

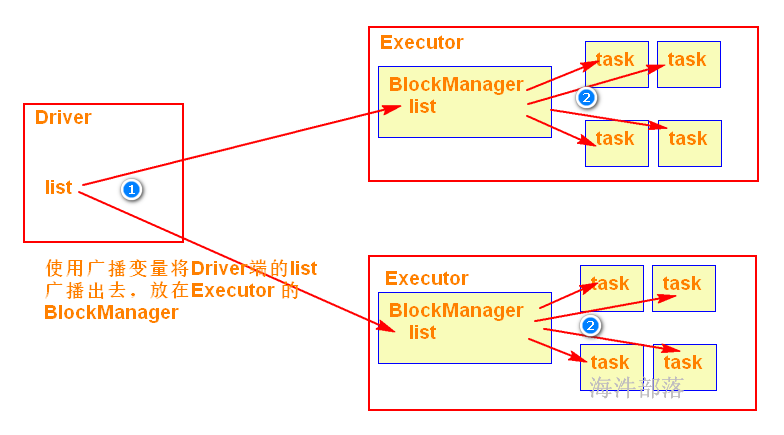

当在Executor端用到了Driver变量,不使用广播变量,在每个Executor中有多少个task就有多少个Driver端变量副本。如果这个变量中的数据很大的话,会产生很高的传输负载,导致执行效率降低,也可能会造成内存溢出。需要广播变量提高运行效率。

累加器

累加器可以很简便地对各个worker返回给driver的值进行聚合。累加器最常见的用途之一就是对一个job执行期间发生的事件进行计数。

用法:

var acc: LongAccumulator = sc.longAccumulator // 创建累加器

acc.add(1) // 累加器累加

acc.value // 获取累加器的值

广播变量

使用广播变量可以使程序高效地将一个很大的只读数据发送到executor节点,会将广播变量放到executor的BlockManager中,而且对每个executor节点只需要传输一次,该executor节点的多个task可以共用这一个。

用法:

val broad: Broadcast[List[Int]] = sc.broadcast(list) // 把driver端的变量用广播变量包装

broad.value // 从广播变量获取包装的数据,用于计算

import org.apache.spark.broadcast.Broadcast

import org.apache.spark.rdd.RDD

import org.apache.spark.util.LongAccumulator

import org.apache.spark.{SparkConf, SparkContext}

object SharedVarTest {

def main(args: Array[String]): Unit = {

val conf: SparkConf = new SparkConf().setMaster("local[*]").setAppName("sharedvartest")

val sc = new SparkContext(conf)

// 定义list

val list = List(1,5,8)

// driver端用广播变量包装

val broad: Broadcast[List[Int]] = sc.broadcast(list)

// driver端定义累加器

val countAcc: LongAccumulator = sc.longAccumulator

val rdd: RDD[Int] = sc.parallelize(List(1,2,3,4,5,6,7,8), 2)

val filter: RDD[Int] = rdd.filter( x => {

// 在executor提取广播变量里的数据,用提起的数据计算即可

val list2: List[Int] = broad.value

if(list2.contains(x)) {

// executor 使用累加器汇总

countAcc.add(1L)

true

}else{

false

}

})

val cache: RDD[Int] = filter.cache()

// action1

val rs: Array[Int] = cache.collect()

// action2

cache.count()

// 执行完成后,获取累加器的结果

// 累加器在累积的时候,不会管是否重复累积,这个由程序员自己控制

println(s"count:${countAcc.value}")

println(rs.toBuffer)

}

}

14 spark 的 sort 和 shuffle

14.2 shuffle

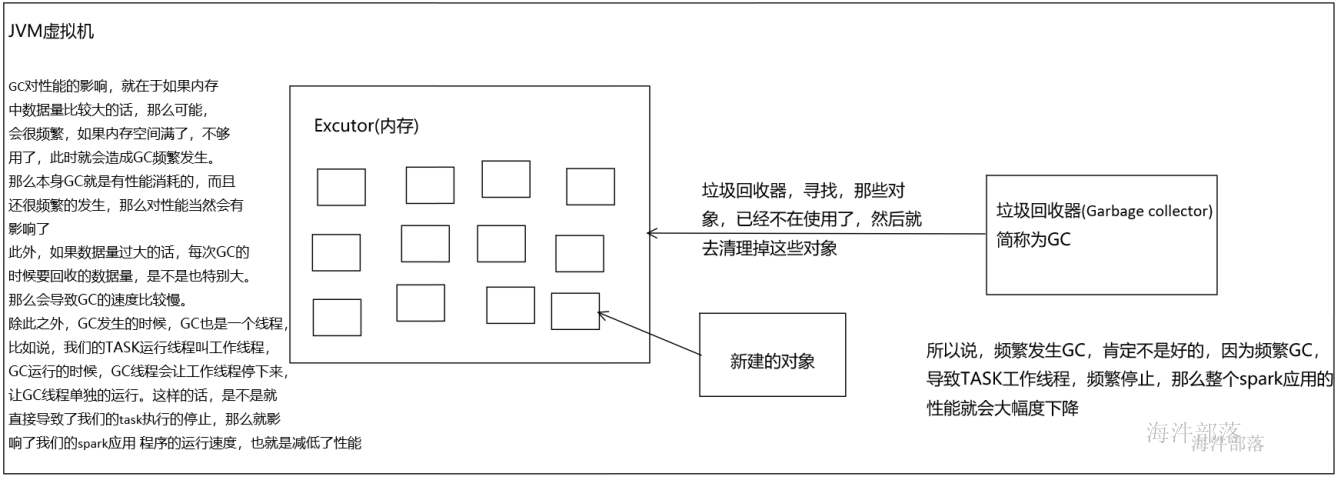

对spark任务划分阶段,遇到宽依赖会断开,所以在stage 与 stage 之间会产生shuffle,大多数Spark作业的性能主要就是消耗在了shuffle环节,因为该环节包含了大量的磁盘IO、序列化、网络数据传输等操作。

负责shuffle过程的执行、计算和处理的组件主要就是ShuffleManager,也即shuffle管理器。而随着Spark的版本的发展,ShuffleManager也在不断迭代。

ShuffleManager 大概有两个: HashShuffleManager 和 SortShuffleManager。

历史:

在spark 1.2以前,默认的shuffle计算引擎是HashShuffleManager;

在spark 1.2以后的版本中,默认的ShuffleManager改成了SortShuffleManager;

在spark 2.0以后,抛弃了 HashShuffleManager。

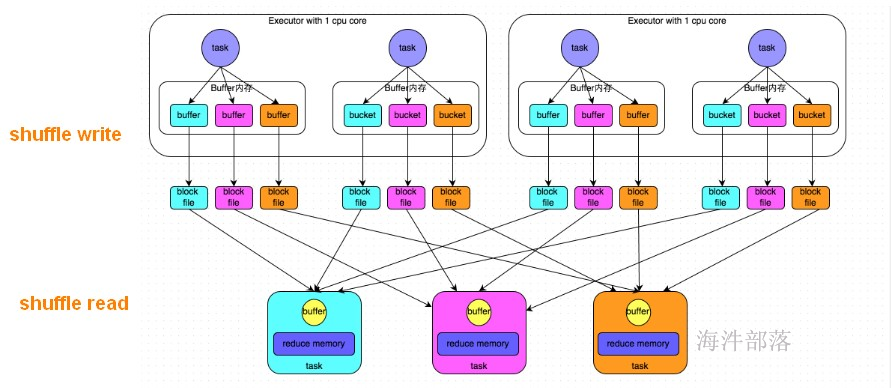

14.2.1 HashShuffleManager

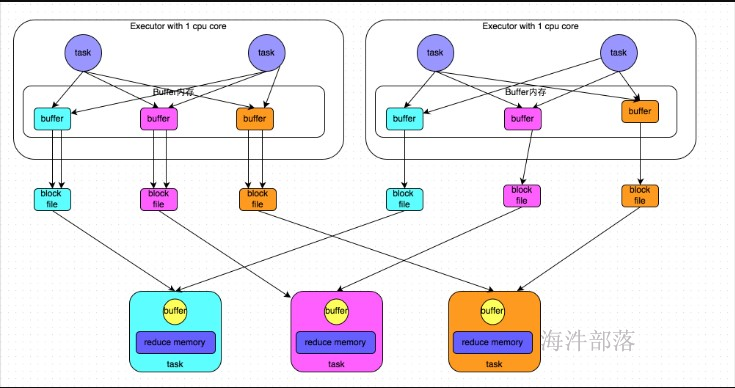

上游 stage 有 2个 Executor,每个Executor 有 2 个 task。

下游 stage 有 3个task。

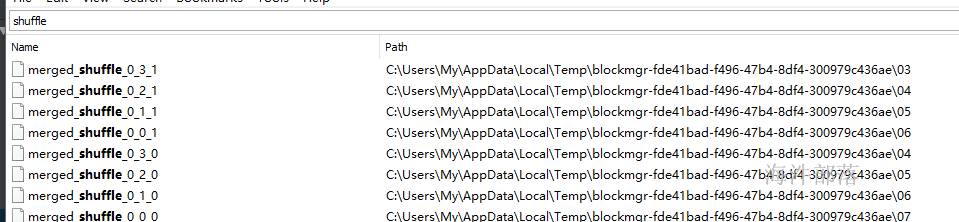

shuffle write阶段:

将相当于mapreduce的shuffle write,按照key的hash 分桶,写出中间文件。上游的每个task写自己的文件。

写出中间文件个数 = maptask的个数 * reducetask的个数

上图写出的中间文件个数 = 4 * 3 = 12

假设上游 stage 有 10 个Executor,每个 Executor有 5 个task,下游stage 有 4 个task,写出的中间文件数 = (10 * 5) * 4 = 200 个,由此可见,shuffle write操作所产生的磁盘文件的数量是极其惊人的。

shuffle read 阶段:

就相当于mapreduce 的 shuffle read, 每个reducetask 拉取自己的数据。

由于shuffle write的过程中,task给下游stage的每个task都创建了一个磁盘文件,因此shuffle read的过程中,每个task只要从上游stage的所有task所在节点上,拉取属于自己的那一个磁盘文件即可。

弊端:

shuffle write阶段占用大量的内存空间,会导致频繁的GC,容易导致OOM;也会产生大量的小文件,写入过程中会产生大量的磁盘IO,性能受到影响。适合小数据集的处理。

14.2.2 HashShuffleManager 优化

开启consolidate机制。

设置参数:spark.shuffle.consolidateFiles。该参数默认值为false,将其设置为true即可开启优化机制。

假设:每个Executor只有1个CPU core,也就是说,无论这个Executor上分配多少个task线程,同一时间都只能执行一个task线程。

上游 stage 有 2个 Executor,每个Executor 有 2 个 task,每个Executor只有1个CPU core。

下游 stage 有 3个task。

shuffle write阶段:

开启consolidate机制后,允许上游的多个task写入同一个文件,这样就可以有效将多个task的磁盘文件进行一定程度上的合并,从而大幅度减少磁盘文件的数量,进而提升shuffle write的性能。

写出中间文件个数 = 上游的CPU核数 * 下游task的个数

上图写出的中间文件个数 = 2 * 3 = 6

假设上游 stage 有 10 个Executor,每个Executor只有1个CPU core,每个 Executor有 5 个task,下游stage 有 4 个task,写出的中间文件数 = 10 * 4 = 40个

shuffle read 阶段:

就相当于mapreduce 的 shuffle read, 每个reducetask 拉取自己的数据。

由每个reducetask只要从上游stage的所在节点上,拉取属于自己的那一个磁盘文件即可。

弊端:

优化后的HashShuffleManager,虽然比优化前减少了很多小文件,但在处理大量数据时,还是会产生很多的小文件。

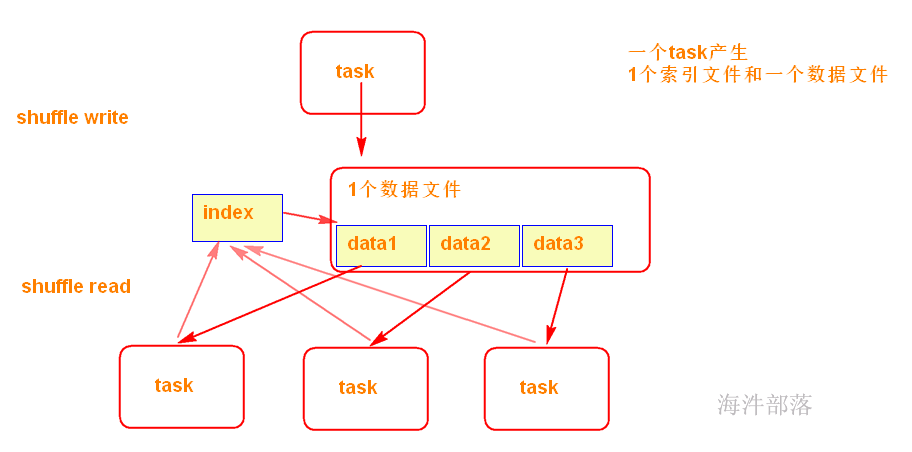

14.2.3 SortShuffleManager

Spark在引入Sort-Based Shuffle以前,比较适用于中小规模的大数据处理。为了让Spark在更大规模的集群上更高性能处理更大规模的数据,于是就引入了SortShuffleManager。

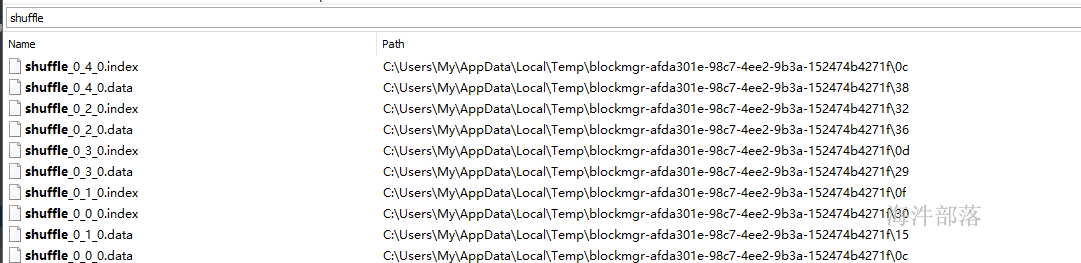

SortShuffleManager不会为每个Reducer中的Task生成一个单独的文件,相反,会把上游中每个mapTask所有的输出数据Data只写到一个文件中。并使用了Index文件存储具体 mapTask 输出数据在该文件的位置。

因此 上游 中的每一个mapTask中产生两个文件:Data文件 和 Index 文件,其中Data文件是存储当前Task的Shuffle输出的,而Index文件中存储了data文件中的数据通过partitioner的分类索引。

写出文件数 = maptask的个数 * 2 (index 和 data )

可见,SortShuffle 的产生的中间文件的多少与 上个stage 的 maptask 数量有关。

shuffle read 阶段:

下游的Stage中的Task就是根据这个Index文件获取自己所要抓取的上游Stage中的mapShuffleMapTask产生的数据的;

14.2.5 shuffle 总结

回顾整个Shuffle的历史,Shuffle产生的临时文件的数量的变化以此为:

Hash Shuffle:M*R;

Consolidate 方式的Hash Shuffle:C*R;

Sort Shuffle:2*M;

其中:M:上游stage的task数量,R:下游stage的task数量,C:上游stage运行task的CPU核数

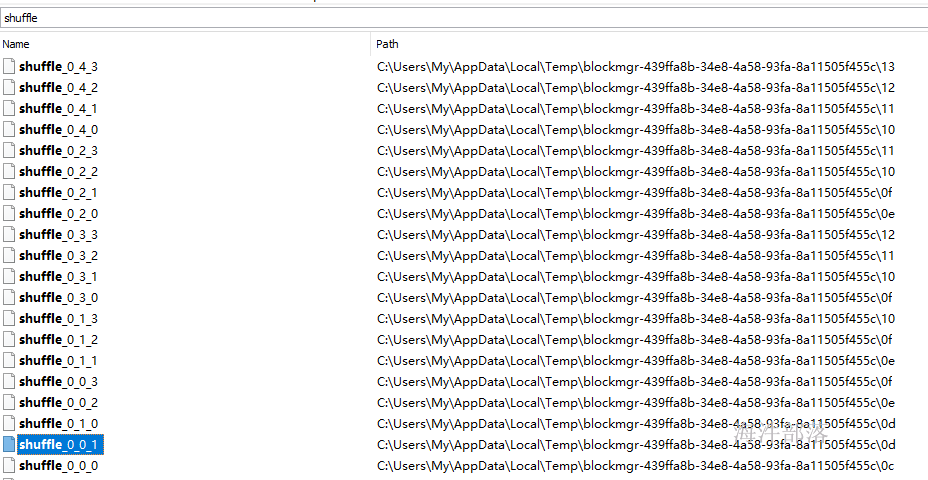

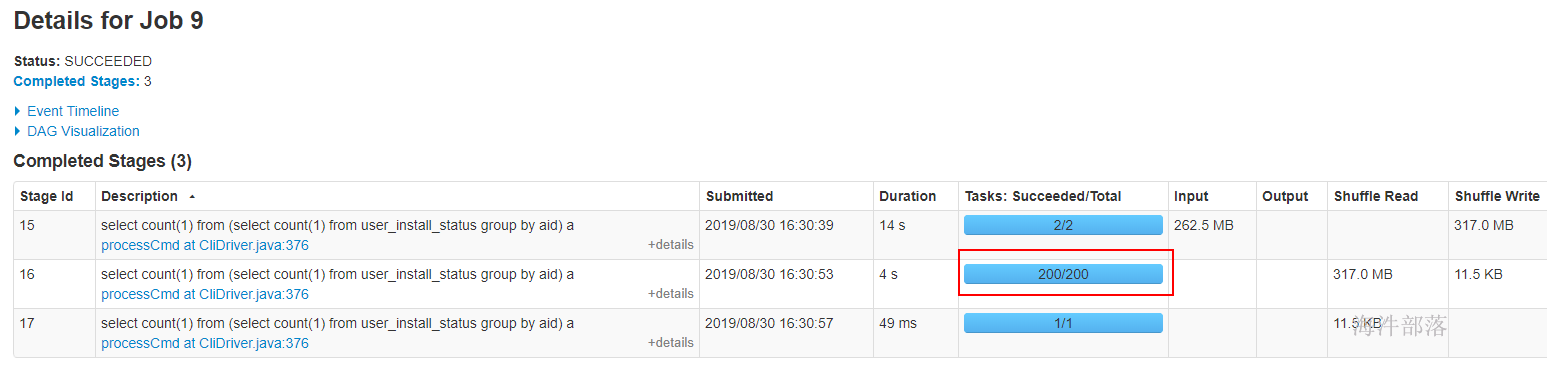

14.2.6 验证理论

由于spark2.0以后 HashShuffle已经不存在,要验证HashShuffle 需要spark1.5的 环境。

<dependencies>

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-core_2.11</artifactId>

<version>1.5.2</version>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>2.7.3</version>

</dependency>

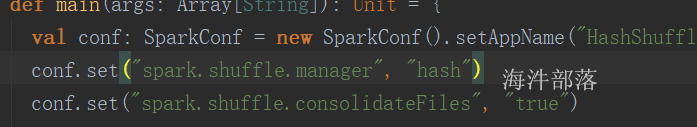

</dependencies>在spark1.5环境下,运行HashShuffle 需要在代码中设置SparkConf 的参数

spark.shuffle.manager ,值设置成hash。

import org.apache.hadoop.conf.Configuration

import org.apache.hadoop.fs.{FileSystem, Path}

import org.apache.spark.rdd.RDD

import org.apache.spark.{SparkConf, SparkContext}

object HashShuffleTest {

def main(args: Array[String]): Unit = {

val conf: SparkConf = new SparkConf().setAppName("HashShuffleTest").setMaster("local[2]")

conf.set("spark.shuffle.manager", "hash")

conf.set("spark.shuffle.consolidateFiles", "true")

val sc = new SparkContext(conf)

// sc.setLogLevel("DEBUG")

val outPath = "/tmp/spark/output/wordcount"

val hadoopConf = new Configuration()

val fs: FileSystem = FileSystem.get(hadoopConf)

val path = new Path(outPath)

if (fs.exists(path)) {

fs.delete(path, true)

}

val line: RDD[String] = sc.textFile("/tmp/spark/input",2)

println(line.partitions.length)

val sort: RDD[(String, Int)] = line.flatMap(_.split(" ")).map((_,1)).reduceByKey((a,b) => a+b,4)

sort.saveAsTextFile(outPath)

//打印rdd的debug信息可以方便的查看rdd的依赖,从而可以看到那一步产生shuffle

println(sort.toDebugString)

}

}CPU核数 = 2

上游task数 = 5

下游task数 = 4

产生中间文件数 = 5 * 4 = 20

增加Consolidate后的HashShuffle,需要增加参数

spark.shuffle.consolidateFiles,设置成true

上游task数 = 5

下游task数 = 4

产生中间文件数 = 2 * 4 = 8

SortShuffle 测试,在spark1.5环境下,默认用SortShuffle

只需要把之前的两个参数注释掉即可

CPU核数 = 2

上游task数 = 5

下游task数 = 4

产生中间文件数 = 2 * 5 = 10

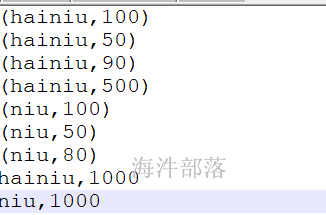

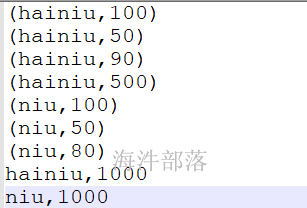

筛选带有()的数据,实现先按照单词降序排序,单词相同再按照数值升序排序

import org.apache.spark.rdd.RDD

import org.apache.spark.{SparkConf, SparkContext}

// 定义二次排序比较key,在内部实现二次排序比较逻辑 同时要实现序列化接口

// spark 序列化支持java的序列化框架,默认使用java序列化框架

class SecondarySortKey(val word:String, val num:Int) extends Ordered[SecondarySortKey] with Serializable{

override def compare(that: SecondarySortKey): Int = {

// 实现先按照单词降序排序,单词相同再按照数值升序排序

if(this.word.compareTo(that.word) == 0){

// 按照数值升序排序

this.num - that.num

}else{

// 按照单词降序排序

that.word.compareTo(this.word)

}

}

}

object ScondarySort {

def main(args: Array[String]): Unit = {

val conf: SparkConf = new SparkConf().setMaster("local[*]").setAppName("ScondarySort")

val sc: SparkContext = new SparkContext(conf)

val rdd: RDD[String] = sc.textFile("/tmp/spark/secondary_sort/input")

val rdd2: RDD[(SecondarySortKey, String)] = rdd.filter(f => {

if (f.contains("(") && f.contains(")")) {

true

} else {

false

}

}).map(f => {

// "(hainiu,100)" --> "hainiu,100"

val str: String = f.substring(1, f.length - 1)

val arr: Array[String] = str.split(",")

(new SecondarySortKey(arr(0), arr(1).toInt), str)

})

// val arr: Array[(SecondarySortKey, String)] = rdd2.sortByKey().collect()

// sortBy 、 sortByKey 都有shuffle,SecondarySortKey 必须实现序列化

val arr: Array[(SecondarySortKey, String)] = rdd2.sortBy(_._1).collect()

for(t <- arr){

println(t._2)

}

}

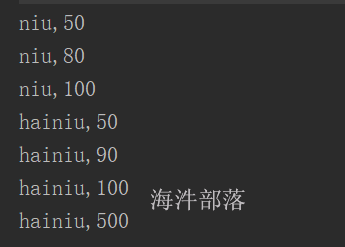

}输入数据

eq、equals、sameElements的使用

eq:是比较内存地址。

比较样例类的数据用 equals。

比较集合内的数据用 sameElements

scala> case class Hainiu(val id:Int, val name:String)

defined class Hainiu

scala> val h1 = Hainiu(1, "hehe")

h1: Hainiu = Hainiu(1,hehe)

scala> val h2 = Hainiu(1, "hehe")

h2: Hainiu = Hainiu(1,hehe)

// 比较内存地址

scala> h1.eq(h2)

res0: Boolean = false

// 比较样例类对象数据

scala> h1.equals(h2)

res1: Boolean = true

scala> val list1 = List(1,2,3)

list1: List[Int] = List(1, 2, 3)

scala> val list2 = List(1,2,3)

list2: List[Int] = List(1, 2, 3)

// 比较list内存地址

scala> list1.eq(list2)

res2: Boolean = false

// 比较 list数据

scala> list1.sameElements(list2)

res3: Boolean = true16 spark mapjoin

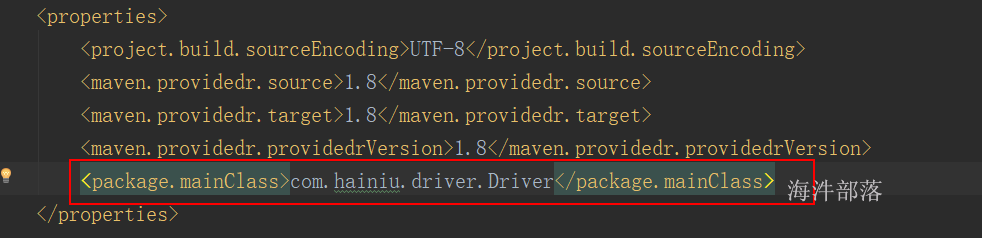

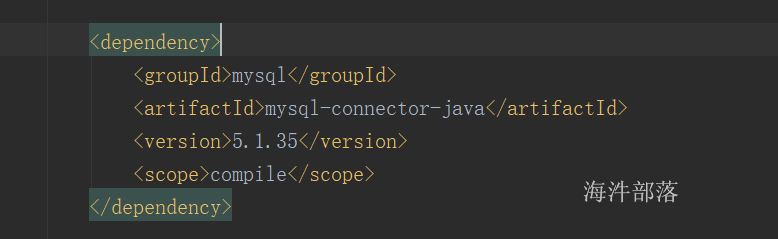

16.1 spark使用的pom

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>com.hainiu</groupId>

<artifactId>hainiuspark</artifactId>

<version>1.0</version>

<properties>

<project.build.sourceEncoding>UTF-8</project.build.sourceEncoding>

<maven.compiler.source>8</maven.compiler.source>

<maven.compiler.target>8</maven.compiler.target>

<project.build.scope>compile</project.build.scope>

<!-- <project.build.scope>provided</project.build.scope>-->

</properties>

<dependencies>

<dependency>

<groupId>org.scala-lang</groupId>

<artifactId>scala-library</artifactId>

<version>2.12.12</version>

<scope>${project.build.scope}</scope>

</dependency>

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-core_2.12</artifactId>

<version>3.1.2</version>

<scope>${project.build.scope}</scope>

</dependency>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>2.7.3</version>

<scope>${project.build.scope}</scope>

</dependency>

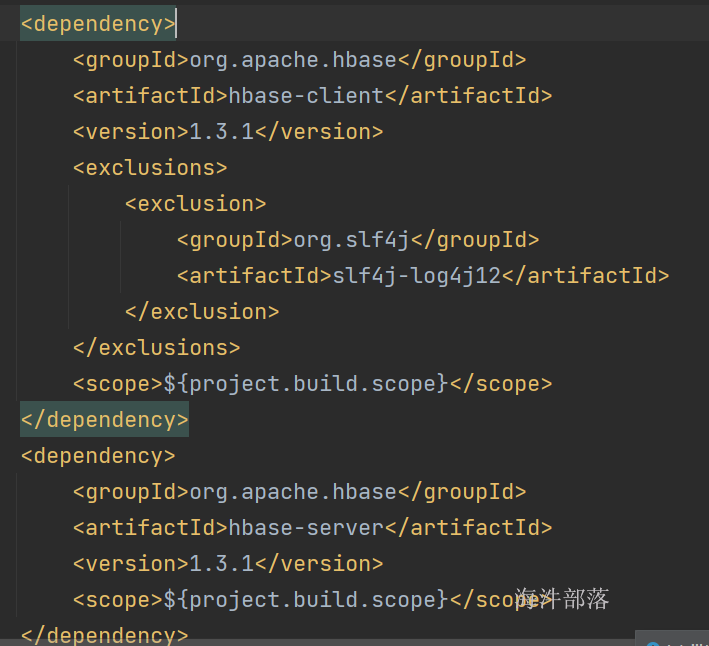

<!-- spark 操作 hbase用到的-->

<dependency>

<groupId>org.apache.hbase</groupId>

<artifactId>hbase-client</artifactId>

<version>1.3.1</version>

<exclusions>

<exclusion>

<groupId>org.slf4j</groupId>

<artifactId>slf4j-log4j12</artifactId>

</exclusion>

</exclusions>

<scope>${project.build.scope}</scope>

</dependency>

<dependency>

<groupId>org.apache.hbase</groupId>

<artifactId>hbase-server</artifactId>

<version>1.3.1</version>

<scope>${project.build.scope}</scope>

</dependency>

<dependency>

<groupId>org.apache.hive</groupId>

<artifactId>hive-cli</artifactId>

<version>3.1.2</version>

<scope>${project.build.scope}</scope>

</dependency>

<!-- sparkSQL编程-->

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-sql_2.12</artifactId>

<version>3.1.2</version>

<scope>${project.build.scope}</scope>

</dependency>

<!-- sparkSQL-hive -->

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-hive_2.12</artifactId>

<version>3.1.2</version>

<scope>${project.build.scope}</scope>

</dependency>

<dependency>

<groupId>mysql</groupId>

<artifactId>mysql-connector-java</artifactId>

<version>5.1.35</version>

<scope>${project.build.scope}</scope>

</dependency>

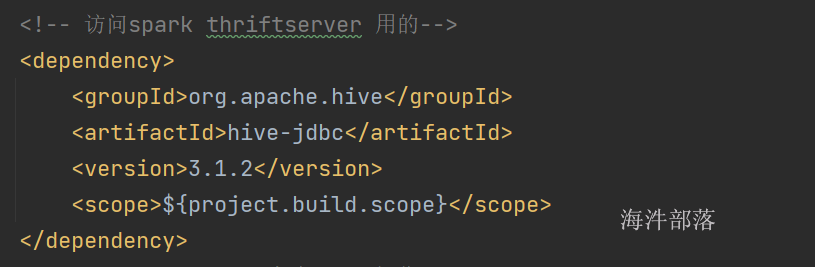

<!-- 访问spark thriftserver 用的-->

<dependency>

<groupId>org.apache.hive</groupId>

<artifactId>hive-jdbc</artifactId>

<version>3.1.2</version>

<scope>${project.build.scope}</scope>

</dependency>

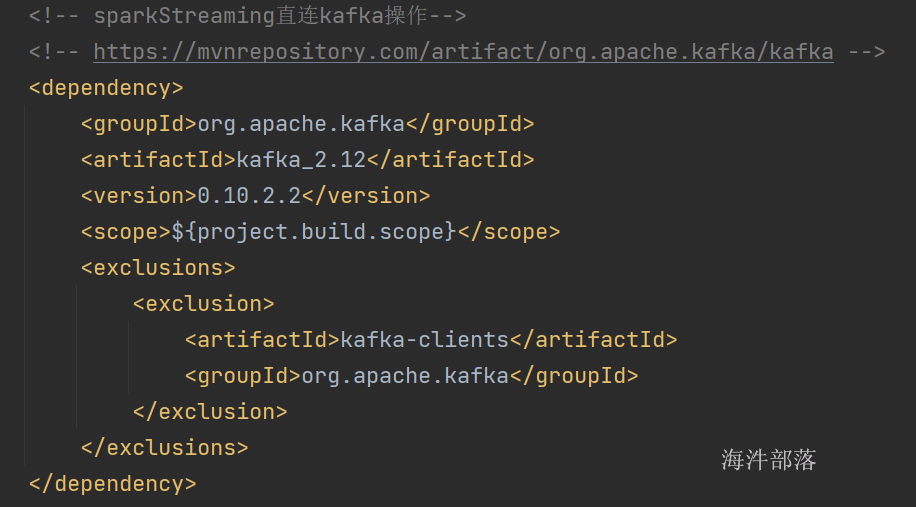

<!-- sparkStreaming直连kafka操作-->

<!-- https://mvnrepository.com/artifact/org.apache.kafka/kafka -->

<dependency>

<groupId>org.apache.kafka</groupId>

<artifactId>kafka_2.12</artifactId>

<version>0.10.2.2</version>

<scope>${project.build.scope}</scope>

<exclusions>

<exclusion>

<artifactId>kafka-clients</artifactId>

<groupId>org.apache.kafka</groupId>

</exclusion>

</exclusions>

</dependency>

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-streaming-kafka-0-10_2.12</artifactId>

<version>3.1.2</version>

<scope>${project.build.scope}</scope>

</dependency>

<!-- sparkStreaming操作-->

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-streaming_2.12</artifactId>

<version>3.1.2</version>

<scope>${project.build.scope}</scope>

</dependency>

<!-- spark3 读写 es -->

<dependency>

<groupId>org.elasticsearch</groupId>

<artifactId>elasticsearch-spark-30_2.12</artifactId>

<version>7.12.1</version>

<scope>${project.build.scope}</scope>

</dependency>

</dependencies>

<build>

<resources>

<resource>

<directory>src/resources</directory>

</resource>

</resources>

<plugins>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-assembly-plugin</artifactId>

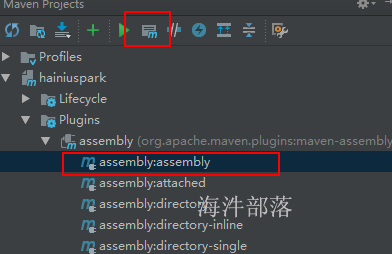

<configuration>

<descriptors>

<descriptor>src/resources/assembly.xml</descriptor>

</descriptors>

<!-- <archive>

<manifest>

<mainClass>${package.mainClass}</mainClass>

</manifest>

</archive>-->

</configuration>

<executions>

<execution>

<id>make-assembly</id>

<phase>package</phase>

<goals>

<goal>single</goal>

</goals>

</execution>

</executions>

</plugin>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-surefire-plugin</artifactId>

<version>2.12</version>

<configuration>

<skip>true</skip>

<forkMode>once</forkMode>

<excludes>

<exclude>**/**</exclude>

</excludes>

</configuration>

</plugin>

</plugins>

</build>

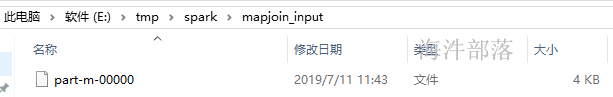

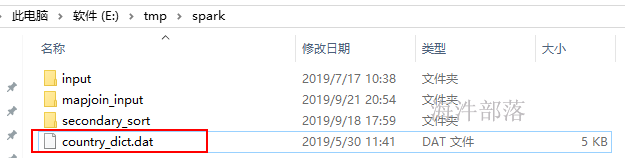

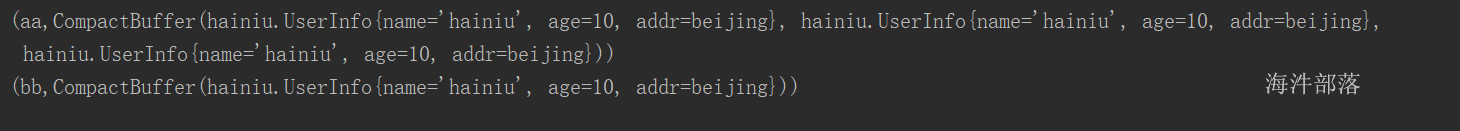

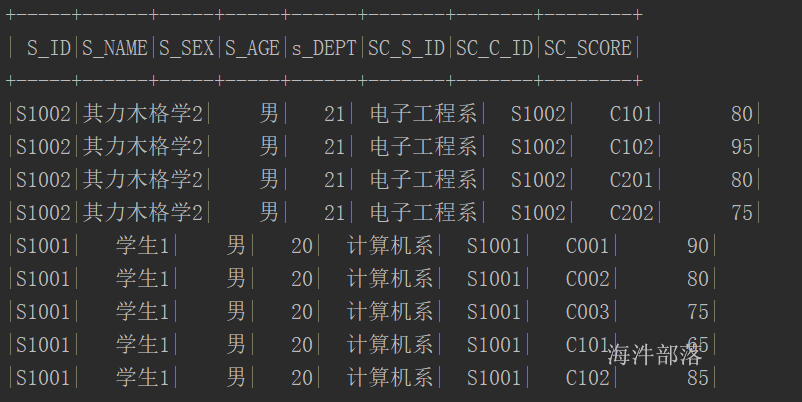

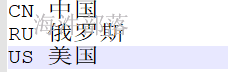

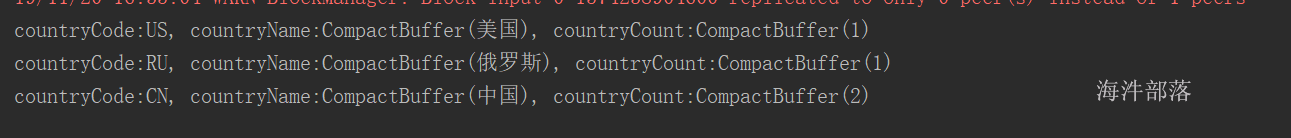

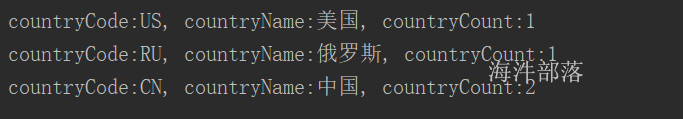

</project>16.2 mapjoin所用工具及数据

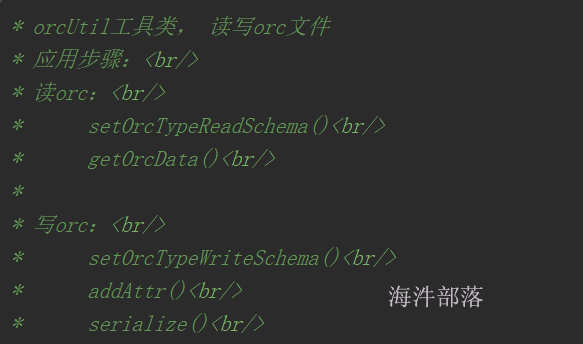

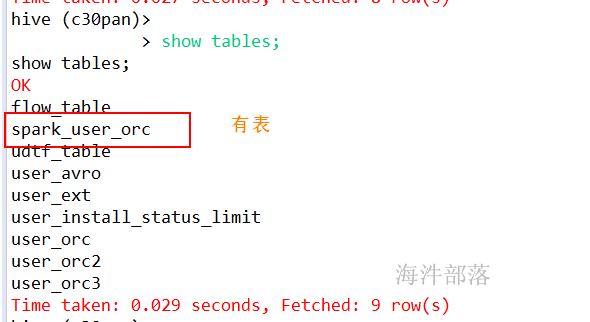

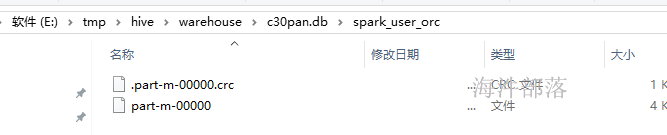

使用之前封装的orc工具读取hive的orc格式文件;

读取 user_install_status_orc 表的部分数据(orc格式)

使用广播变量向各RDD分发字典数据集;

使用累加类统计数据的join情况

输出10条join之后的数据结果,并将数据输出到ORC文件中

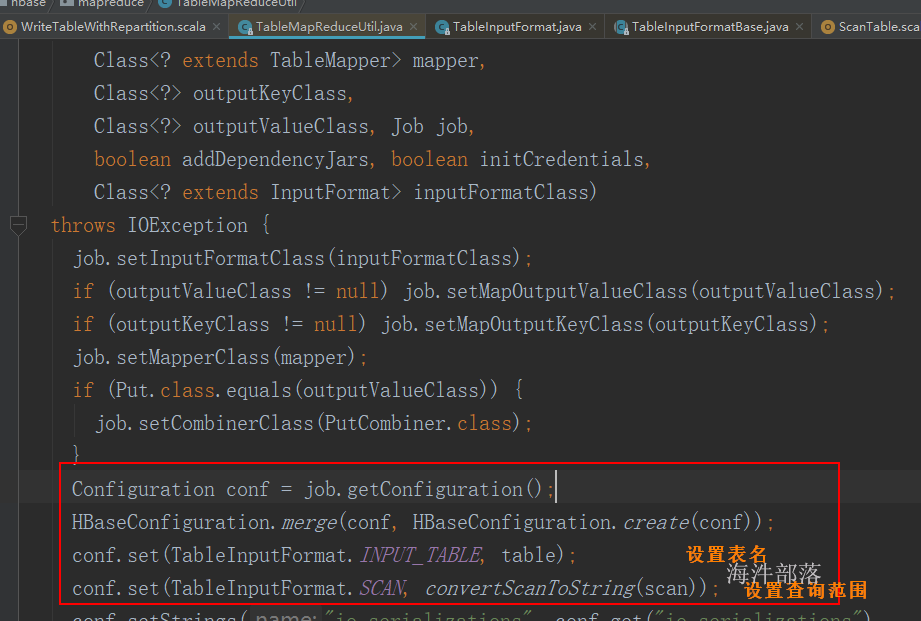

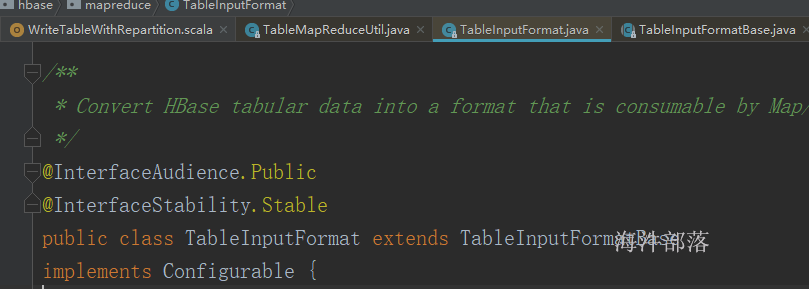

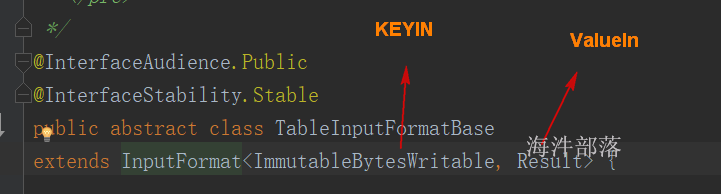

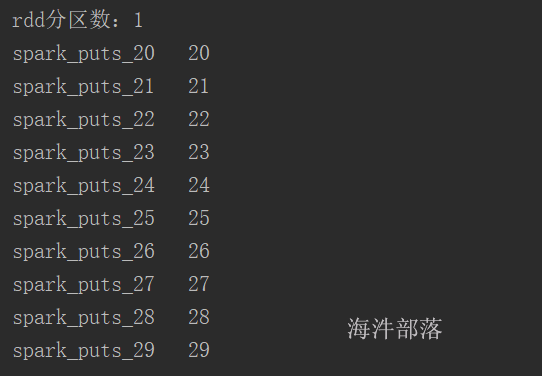

16.3 用spark读取orc文件,并与字典文件join,输出10条的join结果

package java;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.hive.ql.io.orc.OrcNewInputFormat;

import org.apache.hadoop.hive.ql.io.orc.OrcStruct;

import org.apache.hadoop.io.NullWritable;

import org.apache.spark.Accumulator;

import org.apache.spark.SparkConf;

import org.apache.spark.api.java.JavaPairRDD;

import org.apache.spark.api.java.JavaRDD;

import org.apache.spark.api.java.JavaSparkContext;

import org.apache.spark.api.java.function.Function;

import org.apache.spark.broadcast.Broadcast;

import scala.Tuple2;

import util.OrcFormat;

import util.OrcUtil;

import util.Utils;

import java.io.*;

import java.util.HashMap;

import java.util.Map;

public class MapJoin {

public static void main(String[] args) throws IOException {

SparkConf sparkConf = new SparkConf();

sparkConf.setMaster("local[*]");

sparkConf.setAppName("mapjoin");

JavaSparkContext sc = new JavaSparkContext(sparkConf);

Configuration conf = new Configuration();

String path = "/tmp/spark/mapjoin_input";

// 读取hdfs上的orc文件,并转换成相应的pairRDD

JavaPairRDD<NullWritable, OrcStruct> orcPairRdd = sc.newAPIHadoopFile(path,

OrcNewInputFormat.class, NullWritable.class, OrcStruct.class, conf);

// 加载字典文件到内存

String dictPath = "/tmp/spark/country_dict.dat";

Map<String,String> countryMap = new HashMap<String,String>();

BufferedReader reader = new BufferedReader(new InputStreamReader(new FileInputStream(dictPath), "utf-8"));

String line = null;

while((line = reader.readLine()) != null){

String tmp[] = line.split("\t");

String code = tmp[0];

String countryName = tmp[1];

countryMap.put(code, countryName);

}

// 定义广播变量

final Broadcast<Map<String,String>> broadcast = sc.broadcast(countryMap);

// 定义累加器

final Accumulator<Integer> hasCountryAcc = sc.accumulator(0);

final Accumulator<Integer> notHasCountryAcc = sc.accumulator(0);

// 读取PairRDD的每个数据,并与字典map进行join

JavaRDD<String> stringRdd = orcPairRdd.map(new Function<Tuple2<NullWritable, OrcStruct>, String>() {

public String call(Tuple2<NullWritable, OrcStruct> v1) throws Exception {

// 创建orcUtil对象

OrcUtil orcUtil = new OrcUtil();

// 设置读取orc文件, 传入指定的schema

orcUtil.setOrcTypeReadSchema(OrcFormat.SCHEMA);

// 读取country简称

String countryCode = orcUtil.getOrcData(v1._2, "country");

Map<String, String> map = broadcast.getValue();

String countryName = map.get(countryCode);

if (!Utils.isEmpty(countryName)) {

// 统计匹配上的个数

hasCountryAcc.add(1);

} else {

// 统计没匹配上的个数

notHasCountryAcc.add(1);

}

return countryCode + "\t" + countryName;

}

});

// 从计算节点拉取10条数据,并打印

for(String s: stringRdd.take(10)){

System.out.println(s);

}

System.out.println(notHasCountryAcc.value());

System.out.println(hasCountryAcc.value());

}

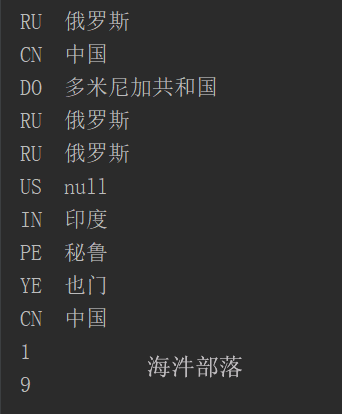

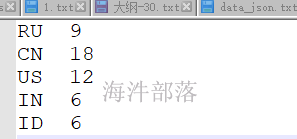

}程序运行结果:

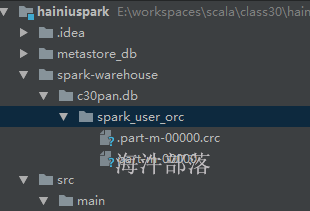

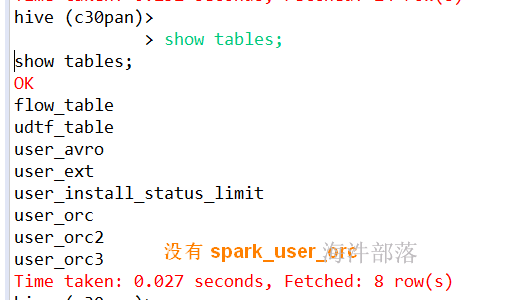

16.4 利用 OrcUtil 将 join 的结果 以 ORC 文件格式保存到hdfs上

注意输出hadoop格式时要将rdd转成 pairrdd

package java;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.hive.ql.io.orc.OrcNewInputFormat;

import org.apache.hadoop.hive.ql.io.orc.OrcNewOutputFormat;

import org.apache.hadoop.hive.ql.io.orc.OrcStruct;

import org.apache.hadoop.io.NullWritable;

import org.apache.hadoop.io.Writable;

import org.apache.hadoop.io.compress.SnappyCodec;

import org.apache.spark.Accumulator;

import org.apache.spark.SparkConf;

import org.apache.spark.api.java.JavaPairRDD;

import org.apache.spark.api.java.JavaRDD;

import org.apache.spark.api.java.JavaSparkContext;

import org.apache.spark.api.java.function.Function;

import org.apache.spark.api.java.function.PairFunction;

import org.apache.spark.broadcast.Broadcast;

import scala.Tuple2;

import util.OrcFormat;

import util.OrcUtil;

import util.Utils;

import java.io.BufferedReader;

import java.io.FileInputStream;

import java.io.IOException;

import java.io.InputStreamReader;

import java.util.HashMap;

import java.util.Map;

public class MapJoinSaveFile {

public static void main(String[] args) throws IOException {

SparkConf sparkConf = new SparkConf();

sparkConf.setMaster("local[*]");

sparkConf.setAppName("mapjoin");

JavaSparkContext sc = new JavaSparkContext(sparkConf);

Configuration conf = new Configuration();

String path = "/tmp/spark/mapjoin_input";

// 读取hdfs上的orc文件,并转换成相应的pairRDD

JavaPairRDD<NullWritable, OrcStruct> orcPairRdd = sc.newAPIHadoopFile(path,

OrcNewInputFormat.class, NullWritable.class, OrcStruct.class, conf);

// 加载字典文件到内存

String dictPath = "/tmp/spark/country_dict.dat";

Map<String,String> countryMap = new HashMap<String,String>();

BufferedReader reader = new BufferedReader(new InputStreamReader(new FileInputStream(dictPath), "utf-8"));

String line = null;

while((line = reader.readLine()) != null){

String tmp[] = line.split("\t");

String code = tmp[0];

String countryName = tmp[1];

countryMap.put(code, countryName);

}

// 定义广播变量

final Broadcast<Map<String,String>> broadcast = sc.broadcast(countryMap);

// 定义累加器

final Accumulator<Integer> hasCountryAcc = sc.accumulator(0);

final Accumulator<Integer> notHasCountryAcc = sc.accumulator(0);

// 读取PairRDD的每个数据,并与字典map进行join,返回序列化的对象

JavaPairRDD<NullWritable, Writable> orcPairRddW = orcPairRdd.mapToPair(new PairFunction<Tuple2<NullWritable, OrcStruct>, NullWritable, Writable>() {

@Override

public Tuple2<NullWritable, Writable> call(Tuple2<NullWritable, OrcStruct> v1) throws Exception {

// 创建orcUtil对象

OrcUtil orcUtil = new OrcUtil();

// 设置读取orc文件, 传入指定的schema

orcUtil.setOrcTypeReadSchema(OrcFormat.SCHEMA);

// 读取country简称

String countryCode = orcUtil.getOrcData(v1._2, "country");

Map<String, String> map = broadcast.getValue();

String countryName = map.get(countryCode);

if (!Utils.isEmpty(countryName)) {

// 统计匹配上的个数

hasCountryAcc.add(1);

} else {

// 统计没匹配上的个数

notHasCountryAcc.add(1);

}

// 将数据序列化成orc格式

orcUtil.setOrcTypeWriteSchema("struct<code:string,name:string>");

orcUtil.addAttr(countryCode, countryName);

Writable w = orcUtil.serialize();

return new Tuple2<NullWritable, Writable>(v1._1, w);

}

});

// 设置输出orc文件采用snappy压缩

conf.set("orc.compress", SnappyCodec.class.getName());

String outPath = "/tmp/spark/mapjoin_output";

// 将序列化对象写入hdfs

orcPairRddW.saveAsNewAPIHadoopFile(outPath,NullWritable.class, Writable.class, OrcNewOutputFormat.class,conf);

System.out.println(hasCountryAcc.value());

System.out.println(notHasCountryAcc.value());

}

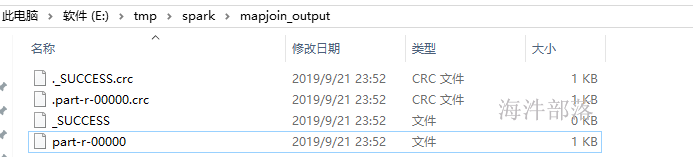

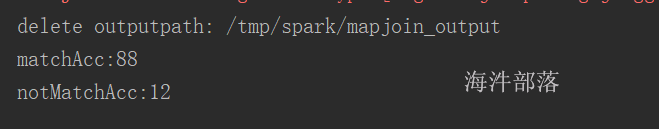

}程序运行结果

16.5 scala 版本实现上面的功能

package com.hainiu.sparkcore

import com.hainiu.util.{OrcFormat, OrcUtil}

import org.apache.hadoop.conf.Configuration

import org.apache.hadoop.hive.ql.io.orc.{CompressionKind, OrcNewInputFormat, OrcNewOutputFormat, OrcStruct}

import org.apache.hadoop.io.compress.SnappyCodec

import org.apache.hadoop.io.{NullWritable, Writable}

import org.apache.spark.broadcast.Broadcast

import org.apache.spark.rdd.RDD

import org.apache.spark.util.LongAccumulator

import org.apache.spark.{SparkConf, SparkContext}

import scala.collection.mutable.ListBuffer

import scala.io.Source

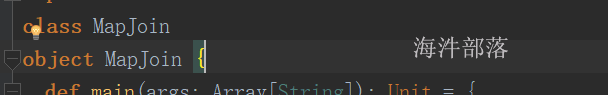

object MapJoin {

def main(args: Array[String]): Unit = {

val conf: SparkConf = new SparkConf().setMaster("local[*]").setAppName("mapjoin")

val sc: SparkContext = new SparkContext(conf)

// 读取hdfs上的orc文件,并转换成相应的pairRDD

val inputPath:String = "/tmp/spark/mapjoin_input"

// path: String,

// fClass: Class[F],

// kClass: Class[K],

// vClass: Class[V],

// conf: Configuration = hadoopConfiguration

val orcPairRdd: RDD[(NullWritable, OrcStruct)] = sc.newAPIHadoopFile(inputPath,

classOf[OrcNewInputFormat],

classOf[NullWritable],

classOf[OrcStruct])

// 加载字典文件到内存,并加载到广播变量里

val dictPath:String = "/tmp/spark/country_dict.dat"

// "CN\t中国"

val list: List[String] = Source.fromFile(dictPath).getLines().toList

val tuples: List[(String, String)] = list.map(f => {

val arr: Array[String] = f.split("\t")

(arr(0), arr(1))

})

val map: Map[String, String] = tuples.toMap

val broad: Broadcast[Map[String, String]] = sc.broadcast(map)

// 定义累加器统计join上的

val matchAcc: LongAccumulator = sc.longAccumulator

// 定义累加器统计join不上的

val notMatchAcc: LongAccumulator = sc.longAccumulator

// (NullWritable, OrcStruct) --> (NullWritable, Writable)

val orcWriteRdd: RDD[(NullWritable, Writable)] = orcPairRdd.mapPartitionsWithIndex((index, it) => {

// 创建 OrcUtil对象

val orcUtil: OrcUtil = new OrcUtil

// 根据schema获取读的inspector

orcUtil.setOrcTypeReadSchema(OrcFormat.SCHEMA)

// 根据schema获取写的inspector

orcUtil.setOrcTypeWriteSchema("struct<code:string,name:string>")

// 提取广播变量里的数据

val map2: Map[String, String] = broad.value

val orcList = new ListBuffer[(NullWritable, Writable)]

it.foreach(f => {

val countryCode: String = orcUtil.getOrcData(f._2, "country")

val option: Option[String] = map2.get(countryCode)

if (option == None) {

notMatchAcc.add(1L)

} else {

matchAcc.add(1L)

// 获取join的国家名称

val countryName: String = option.get

// 将国家码和国家名称添加到 orcList

orcUtil.addAttr(countryCode, countryName)

val w: Writable = orcUtil.serialize()

orcList += ((NullWritable.get(), w))

}

})

orcList.iterator

})

// 写入orc文件

val outputPath:String = "/tmp/spark/mapjoin_output"

import com.hainiu.util.MyPredef.string2HdfsUtil

outputPath.deleteHdfs

val hadoopConf: Configuration = new Configuration()

hadoopConf.set(CompressionKind.SNAPPY.name(), classOf[SnappyCodec].getName);

// 执行 saveAsNewAPIHadoopFile的rdd必须符合能写入该文件类型的rdd

// path: String,

// keyClass: Class[_],

// valueClass: Class[_],

// outputFormatClass: Class[_ <: NewOutputFormat[_, _]],

// conf: Configuration = self.context.hadoopConfiguration

orcWriteRdd.saveAsNewAPIHadoopFile(outputPath,

classOf[NullWritable],

classOf[Writable],

classOf[OrcNewOutputFormat])

println(s"matchAcc:${matchAcc.value}")

println(s"notMatchAcc:${notMatchAcc.value}")

}

}

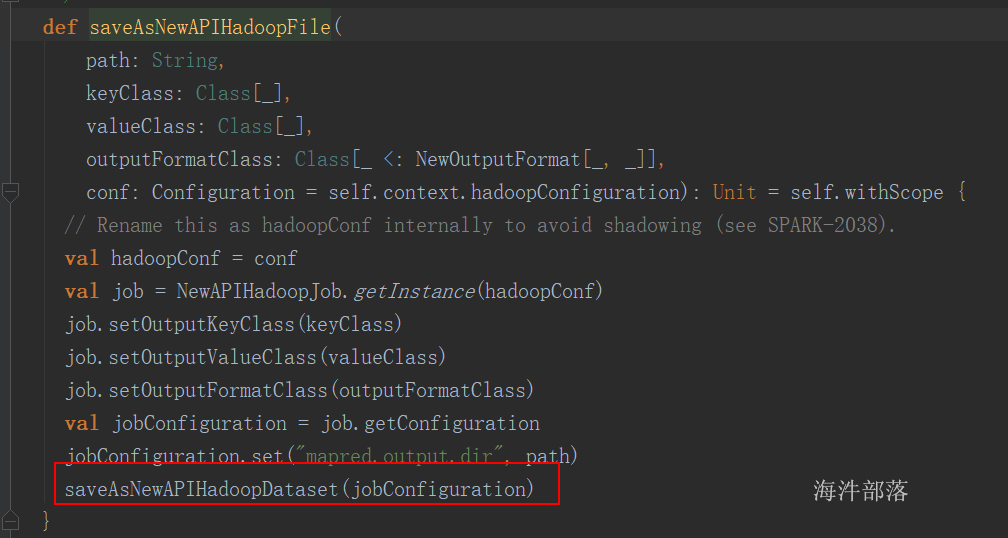

源码:

def saveAsNewAPIHadoopDataset(conf: Configuration): Unit = self.withScope {

// Rename this as hadoopConf internally to avoid shadowing (see SPARK-2038).

val hadoopConf = conf

val job = NewAPIHadoopJob.getInstance(hadoopConf)

val formatter = new SimpleDateFormat("yyyyMMddHHmmss", Locale.US)

val jobtrackerID = formatter.format(new Date())

val stageId = self.id

val jobConfiguration = job.getConfiguration

val wrappedConf = new SerializableConfiguration(jobConfiguration)

// OutputFOrmatClass

val outfmt = job.getOutputFormatClass

val jobFormat = outfmt.newInstance

if (isOutputSpecValidationEnabled) {

// FileOutputFormat ignores the filesystem parameter

jobFormat.checkOutputSpecs(job)

}

val writeShard = (context: TaskContext, iter: Iterator[(K, V)]) => {

// iter: 一个分区的数据

val config = wrappedConf.value

/* "reduce task" <split #> <attempt # = spark task #> */

val attemptId = new TaskAttemptID(jobtrackerID, stageId, TaskType.REDUCE, context.partitionId,

context.attemptNumber)

val hadoopContext = new TaskAttemptContextImpl(config, attemptId)

// 创建outputFormat实例,本次具体实例就是OrcNewOutputFormat对象

val format = outfmt.newInstance

format match {

case c: Configurable => c.setConf(config)

case _ => ()

}

val committer = format.getOutputCommitter(hadoopContext)

committer.setupTask(hadoopContext)

val outputMetricsAndBytesWrittenCallback: Option[(OutputMetrics, () => Long)] =

initHadoopOutputMetrics(context)

// 获取到能写入orc文件的具体RecordWriter, 本例是 OrcRecordWriter

// 一个分区创建一个RecordWriter对象

val writer = format.getRecordWriter(hadoopContext).asInstanceOf[NewRecordWriter[K, V]]

require(writer != null, "Unable to obtain RecordWriter")

var recordsWritten = 0L

Utils.tryWithSafeFinallyAndFailureCallbacks {

while (iter.hasNext) {

val pair = iter.next()

// 写入式一行一行写入

// 调用对应RecordWriter对象的write方法

writer.write(pair._1, pair._2)

// Update bytes written metric every few records

maybeUpdateOutputMetrics(outputMetricsAndBytesWrittenCallback, recordsWritten)

recordsWritten += 1

}

}(finallyBlock = writer.close(hadoopContext))

committer.commitTask(hadoopContext)

outputMetricsAndBytesWrittenCallback.foreach { case (om, callback) =>

om.setBytesWritten(callback())

om.setRecordsWritten(recordsWritten)

}

1

} : Int

val jobAttemptId = new TaskAttemptID(jobtrackerID, stageId, TaskType.MAP, 0, 0)

val jobTaskContext = new TaskAttemptContextImpl(wrappedConf.value, jobAttemptId)

val jobCommitter = jobFormat.getOutputCommitter(jobTaskContext)

// When speculation is on and output committer class name contains "Direct", we should warn

// users that they may loss data if they are using a direct output committer.

val speculationEnabled = self.conf.getBoolean("spark.speculation", false)

val outputCommitterClass = jobCommitter.getClass.getSimpleName

if (speculationEnabled && outputCommitterClass.contains("Direct")) {

val warningMessage =

s"$outputCommitterClass may be an output committer that writes data directly to " +

"the final location. Because speculation is enabled, this output committer may " +

"cause data loss (see the case in SPARK-10063). If possible, please use an output " +

"committer that does not have this behavior (e.g. FileOutputCommitter)."

logWarning(warningMessage)

}

jobCommitter.setupJob(jobTaskContext)

// runJob 提交action操作,执行 writeShard 函数写入数据

self.context.runJob(self, writeShard)

jobCommitter.commitJob(jobTaskContext)

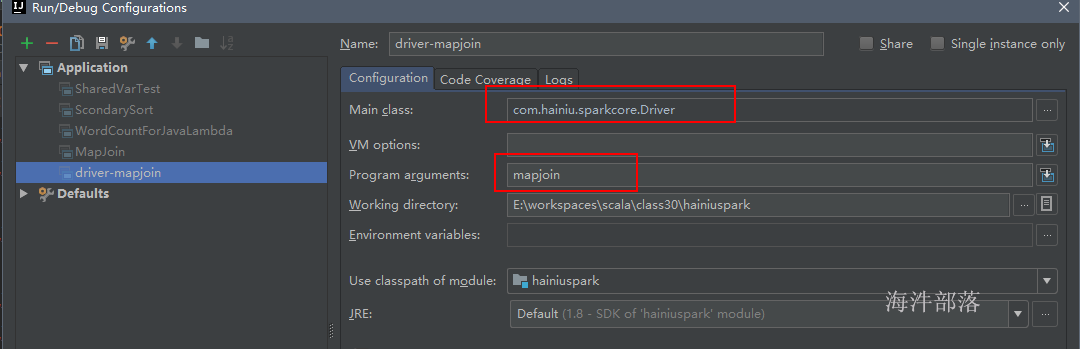

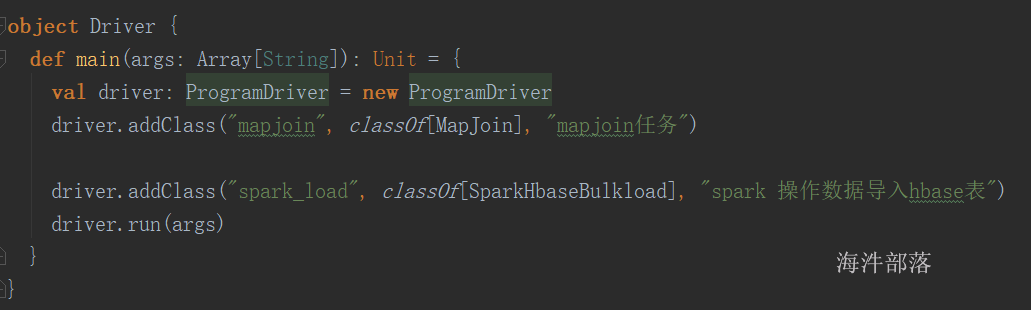

}16.6 定义Driver并运行mapjoin

可以像mapreduce那样 封装个 Driver,在启动参数中配置

package util

import rdd.MapJoin

import org.apache.hadoop.util.ProgramDriver

object Driver {

def main(args: Array[String]): Unit = {

val driver = new ProgramDriver

// MapJoin 需要有伴生类,classOf找的是伴生类

driver.addClass("mapjoin", classOf[MapJoin], "mapJoin任务")

driver.run(args)

}

}

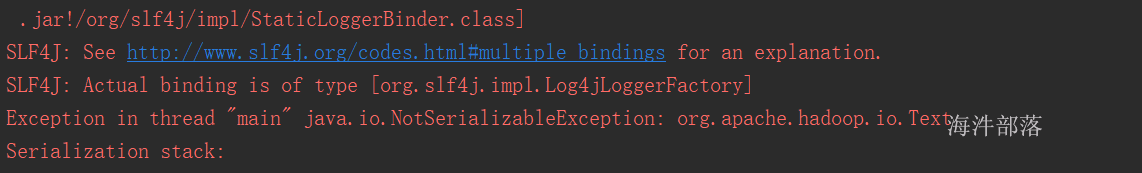

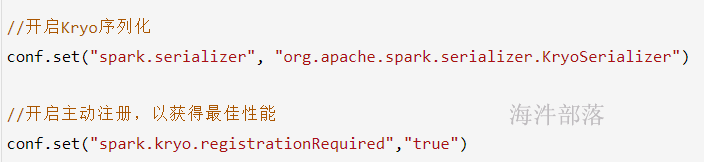

17 spark序列化使用

由于大多数Spark计算的内存性质,Spark程序可能会受到集群中任何资源(CPU,网络带宽或内存)的瓶颈。通常,如果内存资源足够,则瓶颈是网络带宽。

数据序列化,这对于良好的网络性能至关重要。

在Spark的架构中,在网络中传递的或者缓存在内存、硬盘中的对象需要进行序列化操作。比如:

1)分发给Executor上的Task

2)广播变量

3)Shuffle过程中的数据缓存

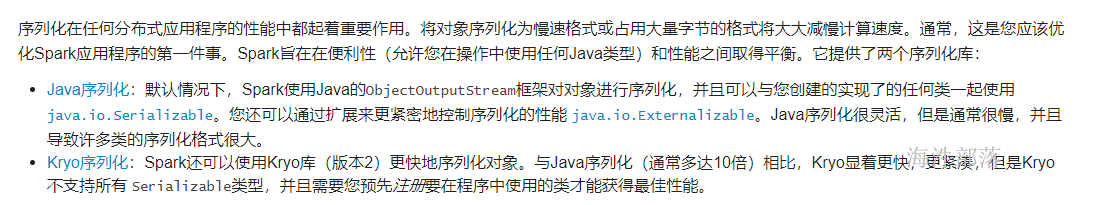

等操作,序列化起到了重要的作用,将对象序列化为慢速格式或占用大量字节的格式将大大减慢计算速度。通常,这是优化Spark应用程序的第一件事。

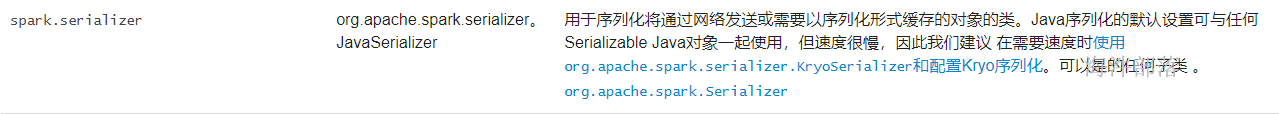

spark 序列化分两种:一种是Java 序列化; 另一种是 Kryo 序列化。

17.1 Java序列化

定义UserInfo类

public class UserInfo{

private String name = "hainiu"; // java实现了序列化

private int age = 10; // java实现了序列化

private Text addr = new Text("beijing"); // 没有实现java的 Serializable接口

public UserInfo() {

}

@Override

public String toString() {

return "UserInfo{" +

"name='" + name + '\'' +

", age=" + age +

", addr=" + addr +

'}';

}

}java实现序列化的一般方法:

1)让类实现Serializable接口

当使用Serializable方案的时候,你的对象必须继承Serializable接口,类中的属性如果有实例那也必须是继承Serializable 可序列化的;

package com.hainiu.sparkcore

import org.apache.spark.broadcast.Broadcast

import org.apache.spark.rdd.RDD

import org.apache.spark.{SparkConf, SparkContext}

object SerDemo {

def main(args: Array[String]): Unit = {

val conf: SparkConf = new SparkConf().setMaster("local[*]").setAppName("SerDemo")

val sc = new SparkContext(conf)

val rdd: RDD[String] = sc.parallelize(List("aa","aa","bb","aa"),2)

val broad: Broadcast[UserInfo] = sc.broadcast(new UserInfo)

val pairRdd: RDD[(String, UserInfo)] = rdd.map(f => {

val userInfo: UserInfo = broad.value

(f, userInfo)

})

// 因为groupByKey有shuffle,需要序列化

val groupRdd: RDD[(String, Iterable[UserInfo])] = pairRdd.groupByKey()

val arr: Array[(String, Iterable[UserInfo])] = groupRdd.collect()

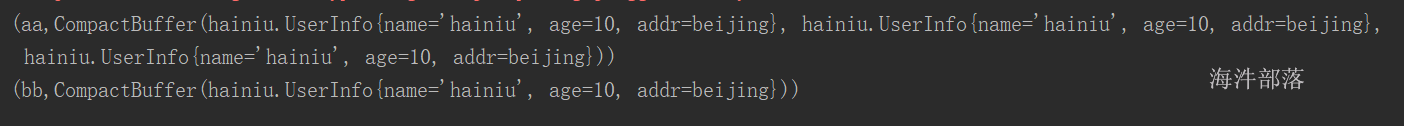

for(t <- arr){

println(t)

}

}

}

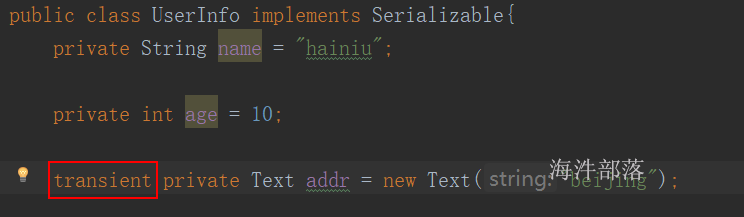

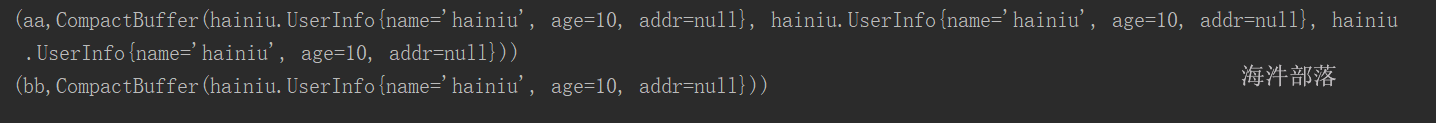

2)static和transient修饰的属性不会被序列化,可以通过在属性上加 static 或 transient 修饰来解决序列化问题。

static修饰的是类的状态,而不是对象状态,所以不存在序列化问题;

这样导致数据丢失。

给addr 属性用 transient 修饰,导致反序列化后数据丢失

java 序列化弊端:

1)如果引入第三方类对象作为属性,如果对象没有实现序列化,那这个类也不能序列化;

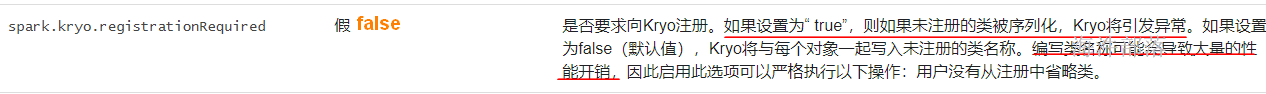

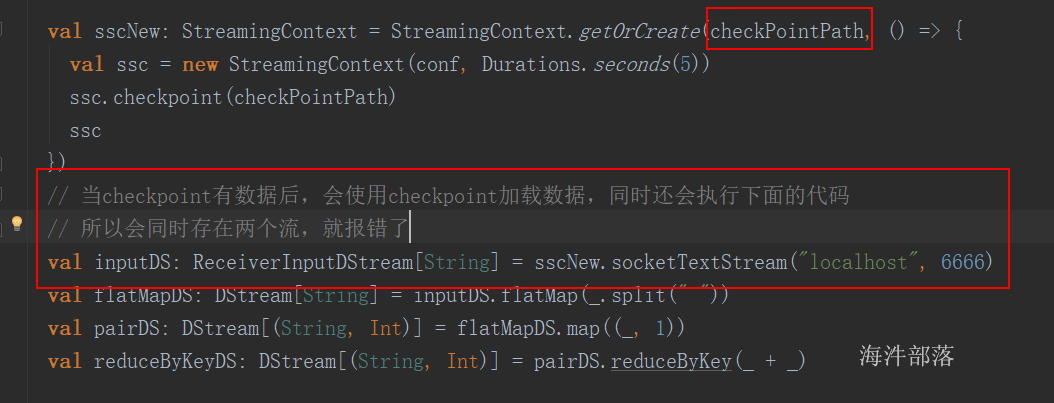

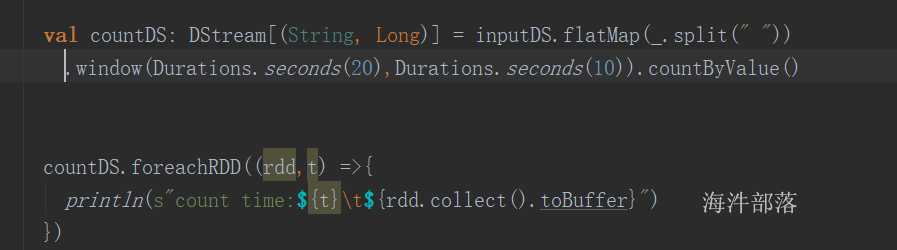

2)用 transient 修饰 的属性,反序列化后数据丢失;