镜像详情地址:https://cloud.hainiubl.com/#/excellentImageDetail?id=25861&imageType=excellent

点击镜像详情页面最下方的“添加到实验配置”按钮可直接运行该实战镜像

一、需求说明

为什么现在都在做大模型本地化部署?

- 数据敏感性:许多企业和组织处理的数据具有高度敏感性(如用户隐私、商业机密等)。将数据存储在本地服务器上,可以避免数据泄露风险。

- 合规性要求:一些行业(如医疗、金融等)受到严格的法规约束,要求数据必须存储在本地或特定区域。

- 低延迟:本地化部署可以减少网络延迟,提高搜索响应速度,尤其是在处理大规模数据时。

- 功能定制:企业可能需要根据自身需求对 DeepSeek 进行定制化开发,例如添加特定的搜索功能、优化算法等。本地化部署便于进行二次开发和定制。

- 无网络环境:在某些场景下(如军事、科研等),网络连接可能不可靠或不存在。本地化部署可以确保系统在离线状态下正常运行

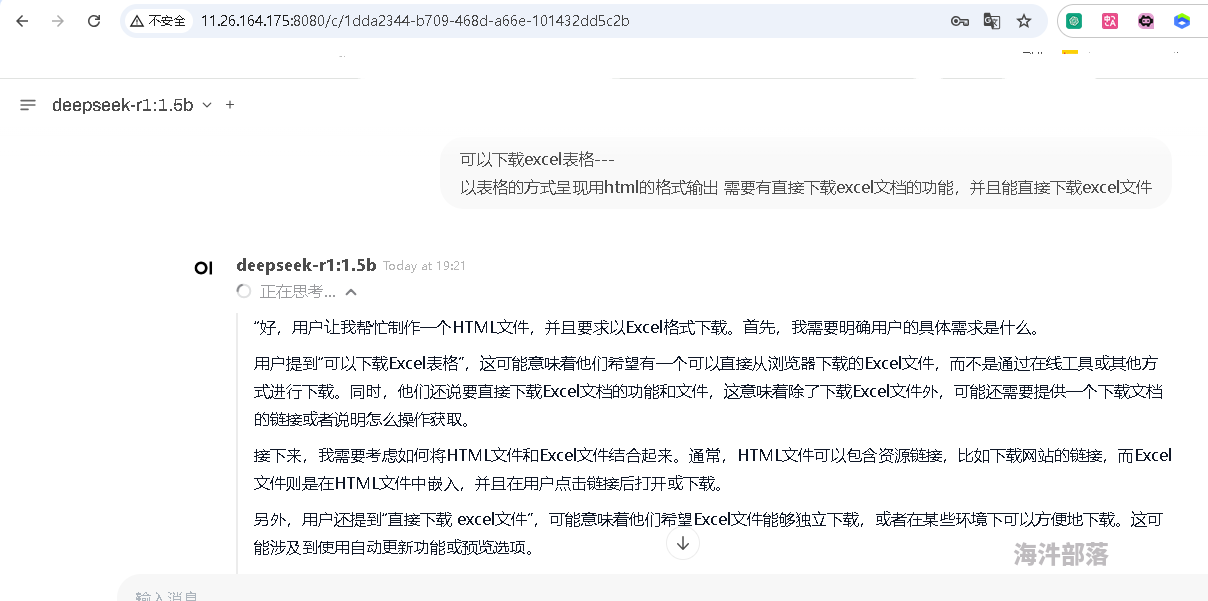

本实验采用通过 Ollama + Deepseek+Open WebUI 的组合,来进行大模型的部署。部署时间不到20S,即可安装成功。用户既能享受本地化部署的数据安全性和性能优势,又能以低成本获得接近云端服务的易用性和功能扩展性。

二、环境介绍

机器介绍

- 一台linux机器

- 一个远程桌面机器

流程介绍

- 安装ollama

- 安装Deepseek

- 安装openssl

- 安装python

- 安装open-webui

您没有该镜像的运行权限,所以无权查看该笔记

版权声明:原创作品,允许转载,转载时务必以超链接的形式表明出处和作者信息。否则将追究法律责任。来自海汼部落-海牛博士,http://hainiubl.com/topics/76624

本帖已被设为精华帖!

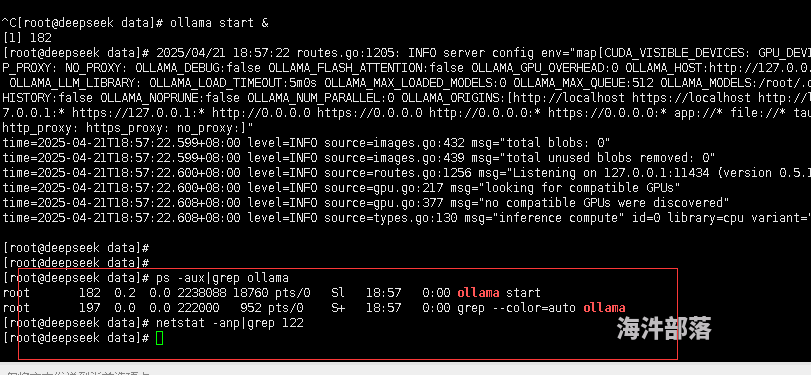

,安装成功咯, 有一点和官方笔记不一致的地方,是netstat -anp|grep 122没查到端口号,不清楚哪个地方用这个端口。

,安装成功咯, 有一点和官方笔记不一致的地方,是netstat -anp|grep 122没查到端口号,不清楚哪个地方用这个端口。