@ling775000 这个看你map输出的数据量了,拉取这个map的数据的reducer需要多长时间从map端把数据读过来。一般reducer的前33%进度都是在shuffle数据。少就快多就慢呗。再少就算是1条也至少有几秒种的时间为reducer做准备吧,比如这个reducer任务被创建起来也要时间吧。

- 请问 1T 左右的数量 用 MapReduce 跑 job 数设置为多少合适呢?

-

信息被删除或无权限查看

- 请问 1T 左右的数量 用 MapReduce 跑 job 数设置为多少合适呢?

- wordcount 之 stage 划分?

- 请问 1T 左右的数量 用 MapReduce 跑 job 数设置为多少合适呢?

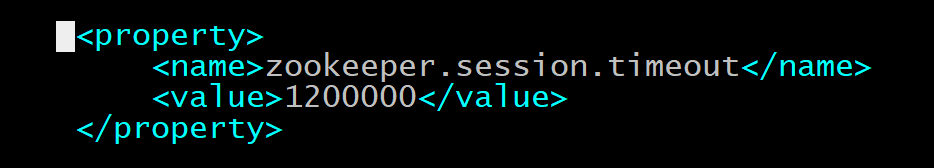

- hbase 插入数据一直卡住的问题?

- hbase 数据插入 阻塞 入库数据入不进去?

- 请问 1T 左右的数量 用 MapReduce 跑 job 数设置为多少合适呢?

- hbase 插入数据一直卡住的问题?

- 用 sparkstreaming 消费kafka的数据,怎么将数据写入到hdfs的输入流,采用追加的方式写入?

- kafka 启动消费者, 一直报这个,请问是个怎么情况,怎么解决?如图

- spark 通过 Phoenix 读取 hbase 数据的问题?

- 请问 1T 左右的数量 用 MapReduce 跑 job 数设置为多少合适呢?

- shell 脚本?

- oraceln 能在数据库里面查到数据但是无法获取元数据?