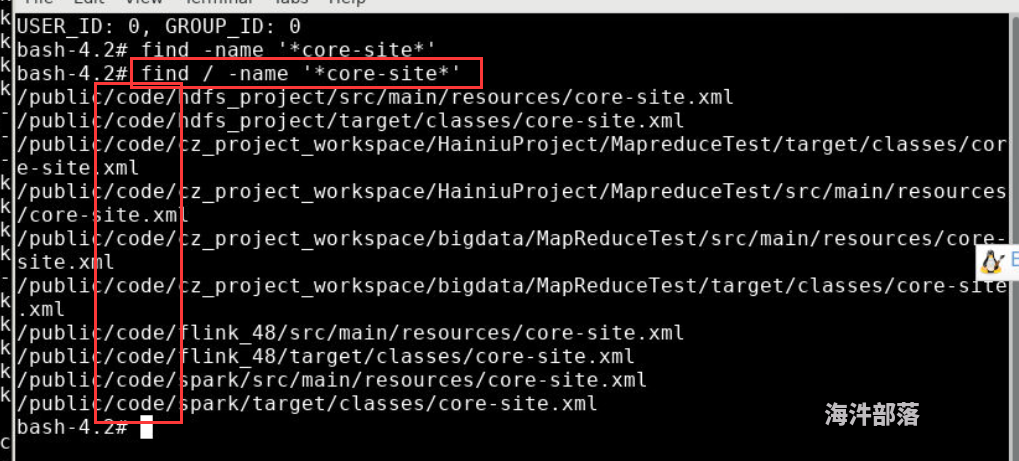

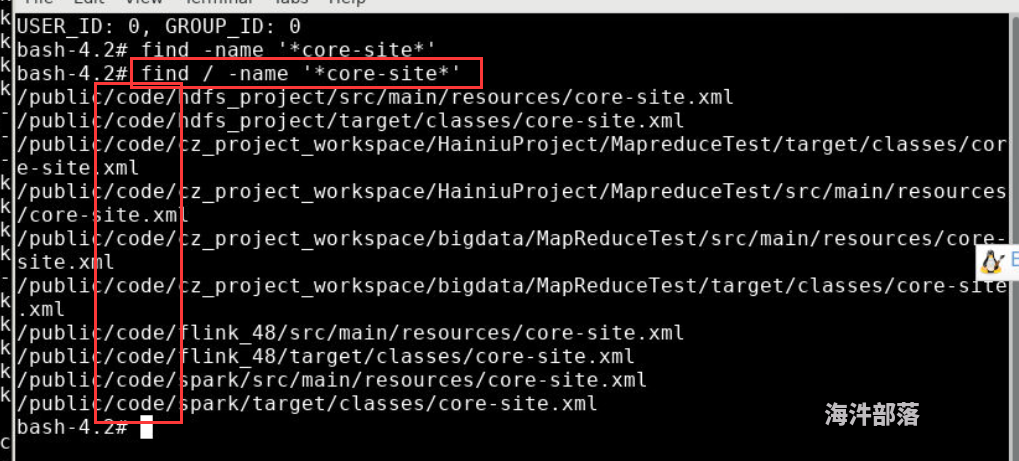

如图所示,查找不到

请问 XFCE 桌面环境的 Hadoop 安装在哪个目录下?

成为第一个点赞的人吧

回复数量: 5

-

software/bigdata下面有hadoop的压缩包,自己解压到自己的指定目录,不要解压到public的任意目录下,因为都是只读目录

如图所示,查找不到

software/bigdata下面有hadoop的压缩包,自己解压到自己的指定目录,不要解压到public的任意目录下,因为都是只读目录